自動駕駛汽車的問題:它們不會哭 - 彭博社

Kyle Stock

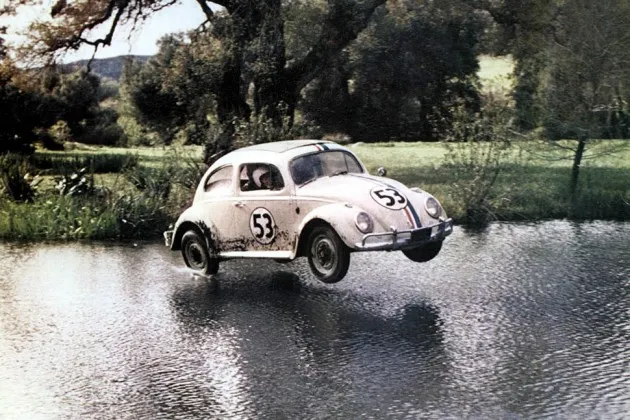

愛情蟲攝影:瑪麗·埃文斯/華特·迪士尼影業/羅納德·格蘭特通過埃弗雷特收藏當然我們可以製造一輛自動駕駛汽車,但我們能否製造一輛有情感的自動駕駛汽車呢?

愛情蟲攝影:瑪麗·埃文斯/華特·迪士尼影業/羅納德·格蘭特通過埃弗雷特收藏當然我們可以製造一輛自動駕駛汽車,但我們能否製造一輛有情感的自動駕駛汽車呢?

弗吉尼亞大學的科學家諾亞·古達爾提出了這個問題,在一項新的研究中探討自動駕駛。古達爾(無疑是《終結者》電影的忠實粉絲)並不太擔心駕駛,而是擔心碰撞——機器人汽車能否在事故即將發生且不可避免時被教導做出富有同情心的道德決策?

這是一個深刻但有效的問題。考慮一下,一輛公交車突然駛入迎面而來的交通。如果她注意到車輛裏滿是學生,人的司機可能會做出不同的反應。另一個人可能會與機器人司機採取不同的轉向,以優先考慮坐在副駕駛座的配偶的安全。

這些事情遠比校準安全跟車距離或甚至為一個鬆散的足球剎車複雜得多。古達爾寫道:“沒有明顯的方法可以有效地將複雜的人類道德編碼到軟件中。”

根據古達爾的説法,汽車製造商的最佳選擇是“義務論”,一種道德方法,其中汽車被編程遵循一套固定的規則,或“結果主義”,在這種情況下,它被設置為最大化某種利益——比如,優先考慮駕駛員安全而不是車輛損壞。但這些方法也存在問題。在這些框架下運行的汽車可能會根據周圍車輛的價值或安全評級的高低選擇碰撞路徑——這似乎並不公平。而且,汽車是否應該被編程以犧牲其他車輛中人們的安全來拯救自己的乘客呢?

在碰撞情況下,人類駕駛員在幾分之一秒內處理着驚人的信息量。計算機也在做同樣的事情,但速度更快,其決策實際上已經在幾個月或幾年前編程時做出。它只需處理;不需要思考。

顯然的中間道路是一種混合模型,在這種模型中,汽車進行駕駛,而人類可以在棘手的情況下進行干預並覆蓋自主性。然而,古道爾指出,自動駕駛的司機可能沒有他們應該保持的警覺性——特別是即將到來的幾代人,他們可能會在有意識的汽車中學習駕駛。

古道爾的主要觀點是,工程師們最好開始考慮這些問題,因為即使有完美運作的機器人司機,碰撞也是不可避免的。除了微調雷達系統和轉向外,像 谷歌 這樣的自動駕駛專家應該致力於“倫理碰撞算法”和人工智能軟件,使自動駕駛汽車能夠從人類反饋中學習。

他還建議工程師和律師共同努力,制定某種標準。來自國家公路交通安全管理局的 當前政策 完全沒有涉及倫理問題。

至於汽車製造商,很容易想象古道爾的想法會影響一整套可編程駕駛模式:“D+”用於不惜一切保護駕駛員,“P”用於保護孕婦乘客,以及“S”用於無私決策。