黑格爾“邏輯學”對人工智能的啓示(二)_風聞

徐英瑾-复旦大学哲学学院教授2018-12-11 09:04

讓人討厭的“框架問題”

眾所周知,美國哲學家塞爾( John Searle) 在經典論文《心智、語言和機器》中區分了“強 AI”與“弱 AI”這兩個概念:前者指的是一個真正具有人類心智 能力的計算機器,而後者指涉的僅僅是能夠模擬人類 心智能力的計算機器。

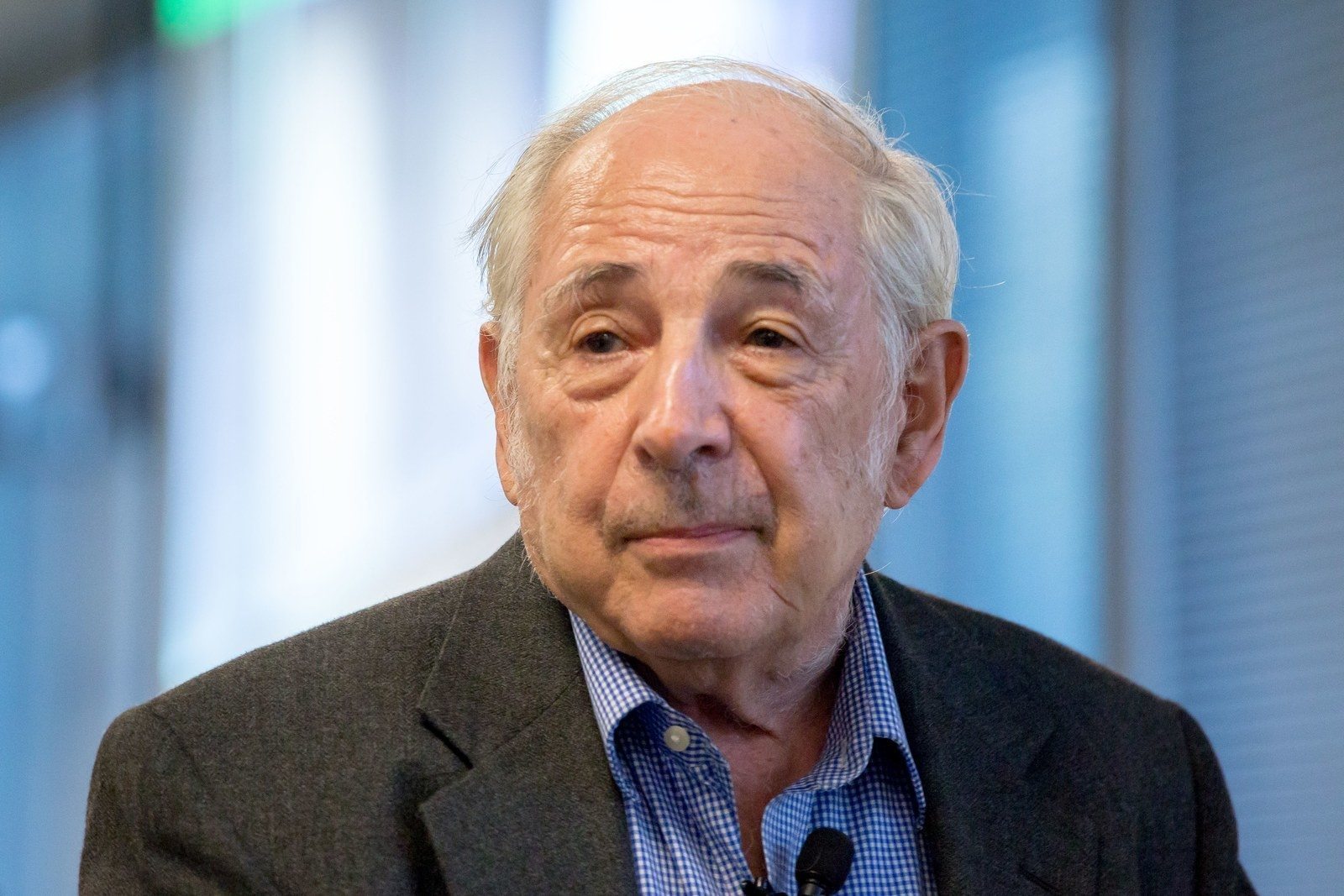

塞爾

塞爾進一步認為“強 AI”是不 可能實現的,因為任何一台計算機器都只能夠在“句法層次次”(syntactic level)上規定機器的運作,而無法 由此達到智能活動所必然會牽涉到的“語義層次” ( semantic level))( 在塞爾的語境中,形容詞“句法的” 幾乎同義於“機械的”,而不僅僅取其在語言學領域內 的意義) 。 筆者認為塞爾的觀點具有部分的真理,也具有部 分的謬誤。具體而言,誠如塞爾所言,“語義落地”問 題的確是人工智能研究的一個核心問題,而目下 AI 學界對於該問題的主流處理方案的確不算高明( 詳後) 。

但筆者卻無法贊同塞爾所給出的如下終極審 判———“未來的 AI 將永遠無法具有一個能夠理解語 義內容的人類心智系統”,因為塞爾賴以支持該終極 審判意見的論據( 即所謂的“漢字屋思想實驗”) 本身 是站不住腳的。

而且,塞爾對於 AI 的這種悲觀態度,在相當程度上也會使得人類智能在演化歷程中的 出現成為了一件難解之事。換言之,如果“隨附式物 理主義”是對的話,那麼我們就難以按照塞爾的理路 來解釋,為何人類神經元的機械運作能夠在高層面催 生語義智能呢?

那麼,我們又該如何在迴避塞爾的“漢字屋論證” 的情況下,更為恰當地表達出對於所謂“語義落地問 題”的理論憂慮呢? 一種更為合適的表達路徑是“框架問題”( frame problem) 。對於該問題的一種非技術化的表達便 是: 一個 AI 系統在給出某個操作的時候,它又該如何自動確定其中的某些操作( 如住在上海的張三按下傳 真機的按鈕這一操作) 不會導致某些後果( 如住在墨爾本的瓊斯的小狗的心律之波動)的發生呢?

這個問題在實踐上之所以具有重要意義,乃是因為如下張力 的存在: 一方面,任何一個智能體都應當能夠對其做出的任何行為的後果進行預估,由此進行“趨利避害” ( 否則其表現就不足以體現真正的智能); 另一方面, 它又必須能夠將那些明顯不相關於當下決策或行為的“非後果”( non-effects) 明確排斥出當下的考慮行為,以加強決策的效率(否則其行為依然不足以表現出足夠的智能)。而依據此方式被理解的“框架問題”,則可以被抽象為如下形式: 編程者該如何設計智能體,才能夠使其在進行趨利避害的考量中,儘量避免過多地考慮不相關的事項,以此提高其整體行為效率呢? 而對於“框架問題”的上述抽象形式,顯然已經涉及了“語義相關性”這個奠基於“語義內容”之上的複合概念。

這也就是説,框架問題恰恰是以它自己的方式,切中了塞爾所提出的那個原初的哲學問題:計算機在句法層面上的機械操作是如何規定出那種超越於機械運作的語義內容的呢?

很顯然,如果塞爾對於整個“句法—語義”關係的消極判斷是正確的,那麼從原則上説,框架問題本身也應當是無解的,而這一點本身似乎就足以宣判強 AI 的死刑。

不過,正如筆者不相信“漢字屋思想實驗”足以宣判強 AI 的死刑一樣,筆者也不相信“框架問題”足以 宣判強 AI 的死刑———儘管從經驗角度看,該問題對於目下主流 AI 研究的挑戰的確是足夠強大的。非常粗略地説,框架問題對於符號 AI 進路的挑戰就在於:除非編程者事先以“框架公理”的方式,手動輸入關於 “何事與何事不相關”的信息,否則系統本身是無法自 行判斷“何事與何事不相關”的。

而即使手動輸入“框架公理”的做法勉強可行,這一做法又會帶來如下深層次困難:能夠與“何事與何事不相關”的信息所對應的可能的框架公理數量乃是無窮多的(譬如,既然 你能想到喝豆漿與讀黑格爾不那麼相關,那麼你就能 再想到吃羊腰子與讀海德格爾也不那麼相關,由此, 你也就能再聯想到無數個“非相關項”) 。在這種情況下,要麼編程者自己會因羅列這些無窮無盡的框架公理而苦不堪言,要麼系統本身也會因為逐一檢索這些框架公理而變得不堪重負。

甚至對於貌似比符號 AI 更為“先進”的人工神經元網絡技術( 以及作為其 “進化版”的深度學習技術)來説,“框架問題”也是一 個難解的問題。

其背後的道理乃是: 即使一個深度學 習系統能夠通過海量的語料學習建立起了一個所謂 的“向量空間模型”( Vector Space Model) ,並通過這 個模型來使兩個語詞之間的“語義距離”的度量成為 可能,如下問題也會阻撓這樣的模型成為一種對於 “框架問題”的有效解決方案: 由於我們人類具有從簡 單詞項構造出無數個複合詞項的能力( 比如從“糕” 出發構造出“一塊熱騰騰的粢飯糕”的能力) ,一個針 對所有的詞項( 包含複合詞項)的“語義向量空間模型”在原則上便是無法被構建出來的。

而一種被勉強構建出來的語義空間模型,則也會因為忽略了複合詞項的存在,而無法計算出兩個新出現的複合詞項之間的語義距離。

而出現這種情況的深層次原因則是: 深度學習機制在骨子裏就是一個統計學系統,而所有的 統計學系統( 無論是貝葉斯網絡還是神經網絡) 其實都只能“由舊揣新”而無法“推陳出新”———因此,如果系統所面臨的新的複合詞項在學習語料庫中未曾出現過的話,系統肯定就會變得手足無措。

反過來説,如果這樣的系統要學會人類“推陳出新”的語言構造能力,它就必須理解語言中基本範疇的使用規 則———而這種能力卻又恰恰是基於統計學的整個運作機制所無法涵蓋的( 因為規則自身的權威性並不能被還原為相關表達式出現的統計學頻度) 。

但以上説的這些,與黑格爾又有什麼關係呢? 從表面上看來,“框架問題”的存在,似乎並不能 夠證明在 AI 研究中引入黑格爾哲學思想資源的必要性,反而能證明黑格爾哲學的無力性。

相關理由如下: 正如前文所指出的,解決框架問題的要害,乃在於如何使得系統在處理當下問題時不涉及知識庫中過多的事項,以便提高系統的運作效率。

因此,這種解決方案肯定包含着某種“做減法”的要求。然而,黑格爾哲學給人的印象卻是“整體主義”,也就是那種從所謂的“感性確定性”中牽扯出整個“絕對知識”的宏大敍述風格。

要向這樣的哲學尋找“框架問題”的解決方案,難道不是在緣木求魚嗎?但這種批評意見其實並不能真正站得住腳。嚴格地説,黑格爾本人説的“絕對知識”並不是像前面所説的“語義向量空間模型”那樣的經驗知識大全,而是 某種純粹思維層面上的高階知識。

這也就是説,黑格爾所真正看重的,乃是使得經驗知識得以被組織起來的某種“元知識”。

不難想見,如果AI也能夠獲取這種元知識的話,那麼這樣的系統或許就能以更為靈活的方式組織經驗知識,以此規避框架問題。

由此,黑格爾哲學與 AI 之間的思想交流管道,也能夠被順利疏通。

但到底是哪些黑格爾式的“元知識”內容才對AI有特別的借鑑意義呢? 要回答這一問題,我們需要以一種新的眼光來複習黑格爾的《邏輯學》體系。

而在下面的討論中,筆者將具體採取這樣的討論策略: 首先,筆者將暫時擱置對於AI 問題的討論,而着力將黑 格爾《邏輯學》的核心理論命意加以“祛魅化”; 然後, 筆者再將 AI 的視角重新切入現場,以便構成黑格爾與AI 之間的積極對話。

參考文獻:

J.Searle,“M inds,Brains,and Programs,”Behavioral and Brain Sciences 3 ( 1980) : 417-424.

限於篇幅,筆者不在此詳細討論這個論證為何不對。請參看拙著《心智、語言和機器———維特根斯坦哲學與人工智能科學的對話》( 人民出版社 2013 年 10 月出版) 第三章。

對於這個問題,塞爾本人在其《心靈導論》( 徐英瑾譯,上海人民出版社 2008 年版) 中提出了一種叫“生物學自然主義”的解釋方案。根據這種解釋方案,人類大腦的特定的生化反應能夠引發智能,而人工編程的硅基體則無力達到這一點。但筆者認為這個觀點的表述有“乞題”( begging the question) 的嫌疑,也就是説,如果沒有來自“漢字屋論證”的外部支援,這個觀點本身只是在表達一種態度而已。

對於框架問題的一個比較技術化的介紹,請參看《斯坦福哲學百科全書》的相關詞條: M Shanahan,“T he Frame Problem,”The StanfordEncyclopedia of Philosophy ( Spring 2016 edition) ,Edward N. Zalta ( ed.) ,( 2016) .URL = <https: / /plato.stanford. edu /archives/spr2016 /entries/frame-problem />.