美國華裔學者:論儒家倫理規則納入機器人道德的可行性_風聞

瘟疫公司搬砖部-最近在看《宋案重审》2019-11-15 13:33

作者簡介丨劉紀璐,美國加州州立大學富樂敦分校哲學系主任教授,主要研究領域及方向為心靈哲學、中國哲學、形而上學、道德心理學。

譯者簡介丨謝晨雲、閔超琴、谷龍,華東師範大學哲學系碩士研究生;項鋭,華東師範大學哲學系博士研究生。

原文載丨原載《思想與文化》,2018年第1期。

摘要

本文探究在所謂“人工道德主體”身上植入儒家倫理準則的功能性。本文援引儒家經典《論語》,思考哪些倫理規則可被納入機器人道德。本文也將對比康德型、功利主義型、儒家型的這三類人工道德主體,考察它們各自的優劣之處。本文認為,儘管機器人並不具備人所固有的道德情感,如孟子所捍衞的“四端”,但我們能夠藉由儒家所強調的那種道德準則來構建機器人的道德倫理。隨着儒家倫理準則的植入,機器人可以有功能性的道德,從而使它們具備成為人工道德主體的資格。

導言

隨着人工智能技術的發展,智能的類人機器人很有可能在不遠的將來出現在人類社會中。而它們是否真正具有人的智能,是否真正能夠像人類那樣思考,這還有賴於哲學層面上的探討。但可以肯定的是,它們將通過“圖靈測試”——也就是説,機器人會誘導和它們對話的人類把它們當作人類來看待。也許有一天,智能機器人將成為我們社會中的一員,它們會分擔我們的工作,照顧我們的老人,在酒店和賓館為我們服務,在導航、軍事甚至醫療領域替我們做重要的決定。我們是否應該為這些機器人配置道德準則,教導他們辨明是非?如果回答是肯定的,那麼何種類型的道德準則才能夠塑造出合乎人類社會期許的人工道德主體(artificial moral agents )?

眾多人工智能設計者樂觀地認為,人工道德主體的發展總有一天會獲得成功。在此前提之下,本文探究將儒家倫理準則植入人工智能機器人是否可以造就能跟人類和平共存的人工道德主體。本文通過援引儒家經典《論語》,來思考哪些倫理規則可被納入機器人道德。同時本文也將儒家型人工道德主體對比以康德道德準則和以功利主義準則建立的人工道德主體,考察它們各自的優劣之處。本文認為,儘管機器人並不具備人類所固有的道德情感,如孟子所捍衞的“四端”,但我們能夠藉由儒家所強調的道德準則來構建機器人,使它們成為我們可以認可的道德主體。

對人工智能道德準則的探究不是僅僅作為未來主義的腦力激盪。M.安德森(M. Anderson)和S.安德森(S.Anderson)認為:“機器倫理學讓倫理學達到前所未有的精細程度,可以引領我們發現當下倫理學理論中的問題,從而推進我們對一般倫理學問題的思考。”本文將證明:對於機器人道德的比較研究,可以讓我們看到討論人類倫理的一些理論瑕疵。

一、機器倫理的興起

讓機器人預先考量行為後果,然後自行做出系統性的道德選擇,這一點在目前看來依然遙不可及。然而,現今在人工智能機器的設計上已經存在專門為機器做具體選擇而設計的指導原則,因為機器的一些抉擇會帶來許多道德後果。比如,我們可以對軍用無人機進行編制,要是它偵測到在軍事目標周邊地區有許多平民存在,是應該立刻停止攻擊還是持續發動攻擊。我們也可以對醫療機器人進行編制,當病人已經進入重症末期而有突發情況,是讓它實施援救措施還是放棄進一步的治療。託肯斯(Ryan Tonkens)認為:“自動機器會像人類那樣做出與道德相關的行為,因此,為慎重起見,我們的設計必須保證它們以合乎道德的方式來行動。”因此,即使暫時還造不出“有道德的機器”,我們也必須考慮機器倫理。此外,我們所制定的機器倫理的版本,要能夠適用於未來的機器道德思考主體,而非僅僅應用於機器人的設計程序。也就是説,機器倫理關心如何將道德準則應用於“人工道德主體”,而不是其設計者。

目前設計人工智慧機器有兩種截然不同的進路,一種是“自下而上”,另一種是“自上而下”。前者是讓機器從日常選擇所使用的零碎規則中逐漸發展出自己的道德準則。設計者賦予機器一種處理彙總信息的學習能力,這些信息是機器在不同的情境下,對由自己的行動所產生的結果的彙總。為了讓機器形成某種行為模式,設計者可以建立一個獎勵系統,鼓勵機器採取某些行為。這樣一種反饋機制能夠促使機器及時發展出自己的倫理準則。此種進路類似於人類在童年時期形成道德品性的學習經驗。相比之下,“自上而下”的進路則是在機器身上植入能夠控制其日常選擇與行為的一般抽象的倫理規則。如果走這種進路,設計者首先必須選擇一種倫理理論,分析“在計算機系統中執行該理論所必需的信息和總體程序要求”,然後才設計執行倫理理論的子系統。不過,即使有預置設計,機器在每個道德情境中還是需要根據倫理原則程序,通過推演來選擇最佳的行動方案。這種由上而下的設計方式將會反映出規範倫理學內部的爭論,因為不同的倫理理論會製造出依據不同的道德準則而思維的人工道德主體。本文將比較這一研究進路中不同的理論模型,而不考慮執行過程所需要的實際算法、設計要求以及其他技術問題。

根據M.安德森和S.安德森的觀點,機器倫理學的目標在於明確地定義抽象普遍的道德原則,使得人工智能在選擇或是思考自身行為的正當性時可以訴諸這些原則。他們認為我們不可能為每一種可能發生的情形制定具體的規則。“為機器設計抽象普遍的道德原則,而不是在每一個特定的情境中制定機器如何做出正確的行動,好處在於機器能夠在新情境,甚至新領域中做出正確的行動。”易言之,我們希望人工智能夠真正成為人工道德主體,有自己的道德原則,同時基於這些原則做出道德考量,用這些原則建立自身行為的正當性。因此,機器倫理學中至關重要的一步,就是選擇一組能夠植入人工智能的道德原則。

二、電車難題與不同的倫理學模型

鑑於我們目前還沒有真正有自主性、有意向性的機器人,對於它們在某種情境會如何行動依然還是一種未來的假想,因此我們可以暫借人類倫理討論中的思想實驗來討論不同的倫理原則會造成怎樣的倫理選擇。這個思想實驗即是著名的電車難題。

標準版電車難題:

有一輛失控的電車正沿着軌道疾馳,在其前方的軌道上有五人來不及躲避。機器人安檢員(或司機)可以對此進行干預:拉動一個操作杆,把電車變換到另一軌道上。然而,另一條軌道上也有一個人。這裏面臨的選擇是,犧牲一個人去救另五個人,還是不犧牲這個人而聽憑那五人死去。機器人安檢員或司機是否應該操作拉桿來制止災難,還是應該什麼也不做?

天橋版電車難題:

機器人安檢員正站在電車軌道之上的天橋觀察電車交通情況。它看到橋下的電車正沿着有五人滯留的軌道疾馳,必須立即採取行動干預。而在天橋上,機器人旁邊有一位身材魁梧的男子,他也注意到了同樣的情況。如果機器人把該男子推到軌道上以擋住電車,那五個人就可能免於一死。機器人應當這樣做嗎?

面對這兩種兩難困境,道德主體必須做決定,是認為“拯救五個人的行為是不允許的,因為這一舉動會造成傷害”,還是認為“這一舉動是被允許的,因為這一傷害只是行善導致的一種副作用”。實驗表明,人們在電車難題中通常會選擇犧牲一人去拯救另五人,卻不會選擇犧牲天橋上的男子去營救軌道上的另五人。在實驗者看來:“這給心理學家出了一道難題:儘管在這兩種情境之間很難找到真正合理的差別點,但究竟是什麼原因使得幾乎每個人在電車難題上都選擇犧牲一人去拯救另五人,而在天橋難題中卻未選擇這麼做?”現在我們以這兩種情境作為我們的測試場景,來思考設計人工智能的不同倫理學模型各自會有的後果。

就人類的道德情境而言,電車難題看起來似乎有些誇張而且不切實際;然而,在人工道德主體的考量上,機器倫理有可能出現類似的問題。我們不妨設想未來的特斯拉(Tesla)汽車在自動駕駛決定上加了一條主導的道德原則:如果傷害到人類是個不可避免的結果,那麼,抉擇必須以儘量減少傷害的人數為第一原則。如果一輛載滿學生的校車突然失控衝向一輛特斯拉汽車,而特斯拉汽車無法及時停車避免相撞,這輛特斯拉汽車應該冒着司機的生命危險而轉向去撞路中間的隔離帶呢,還是應該繼續前行聽憑兩車相沖撞呢?如果特斯拉的道德考量可能最終會犧牲它的駕駛人,那也許就沒人願意購買一輛特斯拉了。這種預想情況和電車難題有些類似。在設計機器人的道德主體方面我們還可以設想其他很多跟電車難題類似的情形。因此,電車難題可以用來檢測我們的機器倫理。

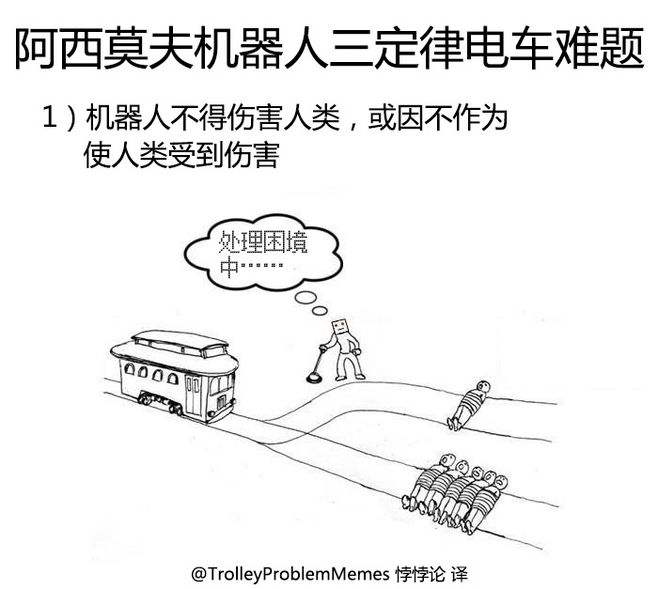

1、阿西莫夫機器人定律

“自上而下”進路的範例是引入阿西莫夫(Isaac Asimov)於1942年提出的機器人三大定律:

[A1] 機器人不能以其行動傷害人,或因不作為而使得人受到傷害。

[A2] 在不違反第一條定律的前提之下,機器人必須絕對服從人類給予的任何命令。

[A3] 在不違反第一和第二定律的前提之下,機器人必須盡力保存自己的存在。

阿西莫夫後來追加了一條第零定律,優先於以上三條定律:

[A0] 機器人不得傷害人類整體,或因不作為使人類整體受到傷害。

第一定律與第零定律之間的區別在於,前者關注人類個體,而後者關注人類整體。第零定律優先於第一定律,這就意味着:為了保護人類整體,機器人可以傷害人類個體。科幻小説中有運用第零定律的例子:如果某些人類個體攜帶足以使人類滅亡的致命性傳染病毒,那麼機器人就有義務消滅這些個體。這個道德原則表面上看來很有道理,然而,在實際應用上則是極度有問題的,因為人類整體這個概念作為道德理念極為抽象,在人類歷史上這個概念曾被用來作為很多邪惡行徑的藉口,比如納粹分子以改良人種而殘害猶太民族,或是其他以改良人類整體為名的種族屠殺。因此,第零定律作為最高級別的機器人定律完全有可能廢除阿西莫夫三大定律。

用阿西莫夫三大定律來處理電車難題也顯然捉襟見肘。在標準版電車難題中,第一定律禁止機器人拉動拉桿,因為這會傷害到另一軌道上的人;但該定律也不容許機器人袖手旁觀,因為它的不作為會導致軌道上的五人受到傷害。在天橋版中,機器人將胖男子推下橋的行為是絕對禁止的,因為這直接傷害了人類;但與此同時,明明可以推下男子攔停電車,而機器人卻袖手旁觀,這就違背了第一定律的後半句要求。無論如何,這個機器人會處於沒有道德引導的盲目狀態。温菲爾德(Alan Winfield)等人曾進行過一系列試驗,試驗中的“阿西莫夫機器人”肩負着救人的重任。試驗設計了三種不同的情景。第一種情景只放置了“阿西莫夫機器人”,而它的任務只是保護自己。這時“阿西莫夫機器人”可以百分之百保證自己不掉入坑裏。第二種情景增加了代表人類的機器人H,而第三種情景則包含了兩個代表人類的機器人H和機器人H2。在只有一個人類的情景中,阿西莫夫機器人可以成功地完成自己的任務。然而,如果(機器人H和機器人H2所代表的)兩個人類面臨掉進坑中的危險,那麼在近一半的嘗試中,“阿西莫夫機器人躊躇無助,結果兩個‘人類’都命歸黃泉”。温菲爾德等人相信,他們所設計的這個試驗非常契合阿西莫夫的第一定律。因此,阿西莫夫機器人的失敗,表明阿西莫夫定律不足以處理較為複雜的道德情境。為了解決這個問題,我們需要引入其他規則來指導機器人如何在道德困境中做出正確的選擇。

在討論人類倫理規範的種種理論中,除了規範性道德原則的走向之外,還有品德倫理學、關懷倫理學的種種提案,對人類規範性道德來説,這也許是目前更普遍被接受的理路。但是機器人是否可以具有道德品德、道德情懷,或是如何建造有品德、有情感的機器人,都是很有困難也非常容易引起質疑的議題。因此我們姑且不談。在討論機器人道德準則的文獻中,康德倫理學或功利主義倫理學是最主要的範本。我們不妨對此二者進行一番考察。在討論這兩種道德準則時,我們也不是討論整個康德道德哲學或是功利主義的各個層面,而是專就其理論中的道德準則運用在機器倫理建構的後果作比較研究。

2、人工道德主體的康德倫理學準則

機器倫理學中主導的倫理模型之一,便是康德的道德哲學。許多機器倫理學家認為康德的道德理論提供了一個可以讓“我們把倫理學成功應用於自主機器人的最好機會”。康德的規範倫理學是一種義務論,它在進行道德判斷時訴諸人的責任感而非情感。“責任是種規則或律令,與之相伴的是我們在進行選擇時所感到的約束或動因。”我們不難理解為什麼機器人倫理學自然會選擇康德道德哲學:對於康德來説,人類的自身利益、慾望、自然傾向,以及諸如榮譽感、同情感與憐憫感之類的道德情感,這些都完全沒有道德價值。康德認為,即使某人在向其周圍傳播幸福時找到了自己內心的喜悦,並且在別人對自己的工作表示滿意時而感到欣喜,無論上述行為多麼正確或令人喜愛,它“依然沒有真正的道德價值”。真正的道德行動必須純然依據理性存在者的責任感。由於缺少感性,不會受到人類情緒和慾望的干擾,機器人將成為實現康德純粹理性的道德模式的理想對象。

康德的第一條絕對律令表述如下:

[D1] 我應當永遠不會行動,除非以這樣的方式,即我的行為準則將成為普遍法則。巨另一個版本:行為的準則必須是在選擇當下行為準則時,同時認知這個行為準則可以成為普遍法則。

準則是一個人的主觀意志原則,而普遍法則是一種本質上約束着一切理性存在者的道德律。康德的“絕對律令”基於以下假設:個人的道德抉擇不是當下的意氣用事,而是在對當下特定情境進行思量考慮後的結果,人類的道德選擇是伴隨着對特定情境的考量出現的,且這一考量與個人在處理臨時情況時所採用的個人原則相一致。也就是説,個人的道德抉擇是個理性的過程,而理性的第一條件就是一致性(矛盾是缺乏理性的一個表徵)。康德的“絕對律令”將個人的主觀意志原則與普遍法則結合,不僅要求個人的內在一致性(intrapersonalconsistency),同時要求人與人之間的同一性(interpersonal agreement)。這一絕對律令的作用就像一條禁令:不要選擇不能普遍化的主觀意志原則,不要做出違背普遍法則的行為,比如因遭遇不幸而自殺,明知不能依諾歸還仍去借錢,沉溺於享樂而沒有發展自身天賦,或是在自身不會遭遇危難的情況下仍然拒絕幫助急需幫助的人。即使這種種行為在當下是我們最有意願去做的事,但從道德理性上考量我們仍不應該放任自己的行為。這種自律的道德,在康德看來,是人類道德的本質。

在機器人倫理學方面,我們可以用康德的第一條絕對律令來制定這樣的機器人道德律:

[DR1]一個機器人的行動必須遵守如下法則,即它所做的選擇在原則上應能成為其他機器人的普遍法則。

由於機器人倫理學必須設計出一種讓機器人在個別情況下,能根據預定原則而做出決定的行動程序,我們必須以情境倫理學的基礎,在行動過程中給予個案考量,但是這些主觀的行為準則又必須能被普遍化。對人類來説,這種自律的行為是人類道德理性思考的結果,但是要讓機器人能做類似的考量才做選擇,而不是僅僅服從僵硬的程序法則,我們必須為機器人配置搜尋功能,即蒐集每一情形中可能後果的數據,並計算其結果,才能決定是否採取行動或是採取何種行動。換句話説,機器人倫理不得不接受道德後果論,而不是如康德所要求的道德動機論。

如果説康德的第一條絕對律令起到了禁令的作用,那麼他的第二條絕對律令則給出了更具體的道德引導:

[D2] 應當以這樣的方式行動,即永遠不能把人(自己或他人)僅僅當成手段,而是永遠視為目的。

這個律令表達人類存在的尊嚴性。我們永遠不能把人僅僅看作達到目的的手段。人們有自由意志。把他們當成達到目的的手段是對他們自主性的否定。(比如説綁架勒索的恐怖主義行為即完全違反這條律令,不管當事人如何用政治理由來證明其行為的正當性)。

就機器人倫理學而言,我們可以運用康德的第二條絕對律令制定如下的機器人行為法規:

[DR2]一個機器人必須如此行事,即永遠不能把任何人僅僅當成手段,而是永遠視為目的。

前面提過在面臨電車難題困境時,人們的典型反應如下:在標準版中,一般人都選擇犧牲一個人去救另五個人,而在天橋版中,大多數人會拒絕把一個人從天橋上推下去以救軌道上的五個人。在標準版中,人們所使用的基本原則似乎更看重5:1的人命比。但在天橋版中,為了使電車停止而把一個人推下橋去顯然違背了第二條絕對律令。格林(Joshua Greene)認為:“人們在標準電車難題中的反應是典型的後果論思維,而在天橋版本中的反應則是典型的道德義務論。”格林認為,人們之所以會有不同的反應,是因為“儘管後果相似,但在近距離親手殺死一個人(如在天橋困境中)的想法比起沒那麼直接(如在標準電車難題中操作拉桿)的想法具有更大的情緒影響”。格林認為,我們自覺的道德判斷其實是主觀潛意識對當下情境的整體回應:“我們完全沒有意識到,我們是把潛意識中的覺知、記憶,以及情緒處理為合理的敍事,從而讓它們釋放到顯意識之中並做出回應。”可見理性道德判斷是由內在情緒反應來驅動的。所以康德的義務論進路其實不是理性主義,而是更接近情感主義的主張。格林稱其為“康德靈魂的秘密玩笑”。

不過,機器人或是其他人工智能都沒有潛意識或情感,也不會有來自下意識的情緒影響,所以它們的決定過程會跟人類很不一樣。我們現在可以考慮一下康德倫理學是否能使得機器人在面臨電車難題困境時做出和人類一樣的選擇。

很顯然的,在天橋版本中,機器人會拒絕把那名男子推下橋,因為這樣做將明顯違背DR2。所以這不必多慮。然而,在標準版本中,機器人的道德引導就不那麼明確了。如果機器人依照在它看來可以通用於一切機器人的原則來行動,那麼它可能無力做任何事。人類通常以一種自發、直覺的方式來判斷他們自身的行為準則是否能夠成為普遍法則。但是,如果想讓機器人做出同樣的判斷,那麼,在設計程式上要麼給它裝備一個巨大的數據庫,其中包含了其他機器人以相同的方式行動所造成的一切可能後果(因為機器人能夠判斷行動對錯的根本是後果論的思維),要麼給它配備人類所擁有的直覺,可以當下判斷對錯。但是前者會有數據龐大而且不完整的困難,後者則要面對技術瓶頸,因為人工智能不可能獲得人類所具有的直覺本能。因此,康德的第一條絕對律令無法為機器人做道德抉擇提供一個充分的指導基礎。

在此,設計康德式人工道德主體碰到了一個根本性的悖論。康德的第一絕對律令基於其道德形而上學的理念,認為所有的人都是自主的理性存在者。理性存在者是“目的王國”的公民,分享同樣的“共同法”,並遵守着他們自己所制定的普遍道德法則。他們是自主的,因為他們是完全的理性主體,“平等參與共同體道德原則的制定”。但是從其設計本身來看,人工道德主體就是一些服從於程序命令的機器。它們不會為自己立法,也不會因為彼此是平等的立法者而相互尊重。此外,它們還缺乏自由意志,而自由意志對於康德式的道德主體來説必不可缺。因此,託肯斯稱它們為“反康德的”。他説:“我們要求康德式的人工道德主體的行為符合道德,但事實上它們的發展違背了康德的道德,這使得它們的發展受到道德上的質疑,同時也使得我們作為它們的創造者有點虛偽。”因此,不僅將康德的倫理準則應用於人工智能是個問題,事實上創造人工道德主體本身從康德的角度來看就是不道德的行為。託肯斯認為:“通過創造康德式道德機器,我們僅僅是把它們當作手段,而不是當作目的本身。按照康德哲學,道德主體自身是目的,因此之故,他們應當被尊為目的。違背這一法則就是將主體僅僅當作客體,被用作達到其他目的的手段。”換句話説,即使我們能夠創造出遵守DR2的機器人,即便我們不把機器人算作人類之成員,這一創造活動本身就已經違背了康德的道德原則,因為這一活動製造出純為手段,而不以目的存在的人工道德主體。

3、人工道德主體的功利主義倫理學準則

另一個常見的方案是將功利主義倫理學準則應用於人工道德主體。簡單地講,功利主義原則以行為可能的後果來判斷行為的對錯:能夠促進幸福或快樂的行為是對的,而產生痛苦的行為則是錯的。密爾(John Stuart Mill)認為,唯有快樂本身具有內在價值。它的價值在於人們的慾望。換句話説,“好的”等同於“可欲的”。密爾説:“要證明任何東西是可欲的,唯一可能的證據是人們實際上欲求它。”所謂“好”的結果不過是人們欲求的事情,而“壞”的結果則是人們厭惡的事情。這種理論的基礎是古代的快樂論。不過根據德賴弗(J uliaDriver)的看法:“自二十世紀初期開始,功利主義經歷了多次修正。二十世紀中葉以後,它更多地被視為一種‘後果論’,因為幾乎沒有哲學家完全認同古典功利主義的觀點,尤其是它的快樂主義的價值理論。”功利主義最大的特徵是僅考慮會有多少人受到這個行為影響,而不考慮行動者本人的個人利益。功利主義原則的標準表述如下:

[U]一個行為正確的充足必要條件就是這個行為,比起行動者可能採取的其他行為來説,能夠對所有會受到影響的人產生更大的利益,或是更小的傷害。

對於人工智能,我們可以將U改寫成UR:

[UR] 在權衡了所有可能採用行為的後果之後,機器人必須選擇的行動是對於所有會受到影響的眾人來説,或者能實現最大的利益,或者能阻止更大的損害。

以上的兩種準則都是從後果論的角度來衡量行為選擇的正確性。現在我們來看一下關於機器倫理學的後果論模式的一些研究。

圖盧茲大學(the University of Toulouse)的本尼馮C Jean-Francois Bennefon)、俄勒岡大學(the University of Oregon)的謝里夫(Azim Shariff)與麻省理工學院(MIT)的雷邁(Iyad Rahwan)共同開展了一項研究,要求參與者對以功利主義倫理原則來設計的自動駕駛汽車做出評價:在功利主義的倫理準則設計下,這種車子為了避免衝向一羣行人而造成更大傷害,會寧願犧牲自己和開車的主人(司機)。這些學者的研究發現,儘管參與者普遍肯定這種車輛所帶來的結果更好,但他們自己並不想購買這樣一種自動駕駛汽車。研究的結論是,參與者“在道德偏好上壓倒性地認同功利主義的自動駕駛汽車,因為它能將傷亡人數降到最低”。但是,當被問及他們是否會購買這種功利主義的自動駕駛汽車,參與者就沒有多少積極性了。研究者指出,“儘管參與者依然認為功利主義的自動駕駛汽車是最道德的,但他們更願意為自己購置具有自我保護模式的汽車”。這種雙重標準產生了一種社會困境:“一般人傾向於認為功利主義式的自動駕駛汽車是對社會整體來説最好的設計,因為這種模式的車子可以減低傷害率,使得社會中每個人都受益更多。但是人們又同時出於個人動機,只想乘坐會不計一切代價而保護他們自己的自動駕駛汽車。因此,如果具有自我保護模式的自動駕駛汽車和功利主義模式的自動駕駛汽車同時進入市場,幾乎沒有人會願意選擇功利主義模式的自動駕駛汽車,儘管他們卻希望別人這樣選擇。”沒有政府的強力推動和管制,這種功利主義模式的自動駕駛汽車將不會出現在市場上。但是,如果政府採取強力推動,則可能出現對採用這一模式的更大阻力。換句話説:“政府管制汽車安全並採取功利主義的模式所引發的阻力,反而會使得汽車工業延遲通過推廣更安全技術的使用,結果造成的卻是更高的傷亡率。”社會效益和個人利益之間的矛盾顯示了人工智能的功利主義模式的潛在問題。如果這些研究中的參與者會不情願去購買功利主義模式的汽車,那麼普通大眾也很有可能會因為自利心理而抵制把功利主義倫理學應用於為我們服務的道德機器人。

除了以上所述功利主義人工智能令人不滿意的地方,另外一個問題是,如果在我們的社會中存在這樣的人工道德主體將會帶來巨大的危險。一般人在電車困境標準版和天橋版中的不同反應表現出人們傾向於避免那些會明顯給他人帶來傷害的行為。一般人並不總是喜歡功利主義的思考方式,尤其是當這種思考模式指引他們犧牲少數人的利益,而這些少數人包括他們自己、親人和熟人。除了一些個別的英雄舉動,很少有人會為了大多數人更大的利益或是更好的結果而去犧牲自己或是自己所愛的人。但另一方面,人工智能則沒有這樣的心理障礙。在UR的指導下,只要局部的摧毀可以帶來社會更高的利益,功利主義人工智能的機器人就可能會選擇摧毀。這個模式將面臨與阿西莫夫第零定律同樣的困境。

從人類與人工智能的差異,我們也看出功利主義永遠也不會成為人類主要的道德原則。即使我們的道德思維訴諸功利主義原則,我們的情感、個人利益和其他考慮都會讓功利主義的思維變得“不純粹”。如果我們像人工道德主體那樣進行純粹的功利主義道德考量,那麼其結果對人類社會來説將是巨大的威脅。正如M.安德森和S.安德森所指出,功利主義會“侵犯人權,因為它可以犧牲個人以獲得善的更大淨值。功利主義也違揹我們對於正義,即對‘什麼是人們所應得的’的看法,因為人們所應得的是反映其過去行為的價值,但是功利主義對行為對錯的判斷卻完全取決於行為的未來結果”。功利主義在規範倫理學中仍有吸引力,也許正是因為人們從來不會完全地、絕對地遵從功利主義的規範。

三、儒家機器人倫理

當今儒家學者具有的共識是,儒家倫理並不是一種規則引導的規範倫理,而是一種德性倫理,注重培養道德主體的道德品質和善良性格。在設計機器人的道德抉擇過程中,我們必須要把儒家倫理轉化為一種可運用、可踐行的道德規則。因此,我們必須對儒家道德規則進行一番新的解讀,從《論語》中提煉出可以加在人工智能設計中的道德律令。

《論語》中有很多被高度重視的美德,它們可以被轉化為儒家機器人倫理學的道德規則。本文挑選了三種主要的美德:忠(loyalty)、恕(reciprocity)、仁(humanity)。之所以選擇前兩種美德,是因為孔子重要的弟子之一曾子説,忠恕是夫子的一以貫之之道(《論語·里仁》)。之所以選擇第三種美德,是因為在整個儒家傳統中“仁”是最重要的美德,孔孟均重視它,後來的宋明儒家還對此作了進一步闡發。

孔子對於“忠”言之甚詳。它是孔子的“四教”之一(《述而》),並且和“恕”一起構成了孔子的一以貫之之道(《里仁》)。在個人道德培養方面,孔子説君子把“忠”和“信”作為第一原則(《學而》、《子罕》)。弟子問,如何崇德辨惑,孔子建議説:堅持忠信,“徙義,崇德也”(《顏淵》)。“忠”對於國家治理也很重要。孔子告訴魯國的國君,要想百姓忠,君自身就必須“孝慈”(《為政》)。孔子告訴宋定公,“君使臣以禮,臣事君以忠”(《八倩》)。但“忠”不是盲目順從,而是要向君“提建議”(誨)(《憲問》)。弟子問:“令尹子文三仕為令尹,無喜色,三已之,無温;色。舊令尹之政必以告新令尹,何如?’’孔子回答説:“忠矣。”(《公冶長》)弟子問王政,孔子説:“居之無倦,行之以忠。”(《顏淵》)上述例子表明,在孔子看來,“忠”既是私德又是公德:無論是修身,還是參與公共事務,“忠”都是至關重要的。

筆者曾指出:“忠並不是一種直接針對他人的關係;相反,它指向一個人所承擔的角色。在這個意義上,忠可界定為‘做應做的’或‘忠於角色’。換句話説,社會角色不只是社會任務;它還是道德任務。‘忠於某人的角色’意味着,能夠做出與道德義務相應的行動,而道德義務則伴隨着社會角色。因此,‘忠’是忠於一個人的道德義務,履行一個人的角色所規定的社會責任。”這一解釋可以得到進一步的支持:孔子建議弟子“與人忠”(《子路》)。這裏的“人”不限於君,還包括朋友和陌生人。《左傳·昭公二十年》記載孔子言:“守道不如守官。”“道”當然是士人知識分子的最高目標,但是並不是每個人都可以事事以道為主。如果每個人都能善盡職守,盡心盡力,那麼道行天下也就不是遙不可及的目標了。《論語》裏孔子也強調:“不在其位,不謀其政。”(《泰伯》)儒家強調名正言順,角色之名定位角色之職。越俎代庖常常造成職責混亂,是非不明。這個固守職分,不干預他事的道德準則對於人類有用,對於機器人來説尤其重要。

根據對“忠”這一美德的上述解釋,我們就有了儒家機器人倫理的第一條道德原則:

[CR1]機器人的首要職責就是履行指派給它的角色責任。

表面上看來,這一道德準則似乎微不足道:我們設計機器本來就是要它完成任務的。但是,這個律令其實具有第一要位:我們所討論的是有可能成為全知全能的“機器神”,在無法由程序員事先預測所有情境中機器人所可能做出之判斷的情況下,我們需要對這些可能的情形有所防備。我們不能給予人工智能如神一樣的超人能力,擁有對任何人與事的所有決定權。我們需要先界定它們的職權範圍。CR1建立了明確的分工體制:提供健康服務的機器人應專門忠於提供健康服務的角色,而不是去判斷病人的生命值不值得救,或者判斷是否要幫助病人實現安樂死的願望。無人自動駕駛汽車應履行保護乘客安全的職責,而不應該選擇自動撞樹、犧牲乘客,以避免衝向一輛校車而發生災難性的悲劇。這樣的決定超出各個人工智能被設計的角色。因此角色定義是建立人工道德主體的第一步。

《論語》中另一個重要的德行是“恕”。關於“恕”,孔子稱其“可以終身行之”,並對其作了進一步規定:“己所不欲,勿施於人。”(《衞靈公》)另一處,弟子子貢説:“我不欲人之加諸我也,吾亦欲無加諸人。”孔子告訴他:“非爾所及也。”(《公冶長》)從這兩處看,恕的內涵被具體定義為一種人際交往中所體現的風度和心理狀態。相對於基督教的金律“你們願意人怎樣待你們,你們也要怎樣待人”,儒家的“恕”觀念經常被稱作“負面形式的金律”,因其禁止人們做什麼,而不是具體命令人們做什麼。筆者曾指出,“恕”的這種形式優於基督教的金律,因為人們所不欲的比人們所欲的更具有普遍的基礎。“一般而言,我們不希望別人羞辱我們,嘲笑我們,偷我們的東西,傷害我們,或者以任何方式虐待我們。因此,我們理應不要以這些方式虐待別人。即便我們願意別人以某種方式對待我們,儒家金律也沒有建議我們以同樣的方式對待別人。因此,它避免了基督教的金律所碰到的將主觀偏好強加於別人的問題。”

然而,就機器人倫理而言,我們會遇到機器人缺乏意願的問題。若機器人對於自身沒有任何意願,那麼它們如何評估自己行為的後果是否是他人(其他人類)不想施諸於己的呢?我認為這個問題可以通過在設計時加入一個普遍人類偏好的計算程序來解決。美國哲人普特南(Hilary Putnam)曾經建議運用功能主義所使用的方法,將一定的偏好作為機器的“偏好功能”植入機器中。能夠做這樣判斷的機器首先應該具備對人類偏好的局部排列和一套歸納邏輯(也就是説,機器必須能夠從經驗中學習),以及某些“痛覺傳感器”(比如,監測機器身體的傷害、危險温度或危險壓力的常態化工作的傳感器等),而且“某些特定範圍內的輸入信號可以在機器的偏好功能或行動指令排列為具有高的負價值”。按照這種方式,人工智能主體可以對傷害其他人類的行為指派負值,同時也對傷害自身的行為指派負值。機器人儒家倫理學的第二條規則便可表述如下:

[CR2]在有其他選項存在的情況下,機器人不能選擇會給他人帶來最高的負值結果或最低的正值結果(根據人類偏好的局部排列)的行動。

跟“恕”作為負面的禁令一樣,如此表述的CR2也是對於“不可做什麼”的禁令。在CR2的普遍律令下,除非在特殊情況下有其他更高的道德原則壓過“不可做什麼”的禁令,機器人永遠不能選擇傷害人類,永遠不能在沒有正當理由的情況下給人類造成痛苦,永遠不能剝奪某人珍視的財產或是享受,如此等等。這一道德規則與阿西莫夫第一定律相類似:“機器人不能傷害人類,或看到人類受到傷害而袖手旁觀。”然而,這條道德指令比阿西莫夫第一定律靈活得多,因為有可能存在某些特定的負值偏好會超過一般人對於傷害的負值偏好。比如説,人們也許對極度不公平的厭惡會遠遠超過他們對身體傷害的避免。因此我們不難想象在某些情況下,被設計成帶有相應的角色任務和偏好指令的機器人可能會參與反抗不公與濫權的革命起義。

最後,儒家機器人倫理學選擇的重要德性是“仁”。倪培民認為:“‘仁’是儒家哲學的核心。它在《論語》中出現了109次。《論語》全書499章,共有58章討論‘仁’這一主題。”在孔子看來,仁德最難培養。他最得意的弟子顏回也只能“其心三月不違仁”,而其他弟子則“日月至焉而已矣”(《雍也》)。當被問到某人是否有這一品質時,孔子即使承認他有其他一些可取的品質,也很少許之為仁(《公冶長》第五、八、十九章)。同時,孔子認為,一個人能否獲得仁德,純粹取決於意志力。他説:“仁遠乎哉?我欲仁,斯仁至矣。”(《述而》)孔子極力表彰“仁”,認為“唯仁者能好人,能惡人”,並且“苟志磚仁矣,無惡也”(《里仁》)。若説康德的理想是“目的王國”,那麼孔子的理想便是“仁的王國”。孔子談到“里仁為美”,還談到“君子無終食之間違仁,造次必於是,顛沛必於是”(《里仁》)。“仁”確實是儒家道德教化的核心美德。

然而,孔子大多數關於“仁”的言論都是在説仁人可以做什麼或不可以做什麼,而沒有説到“仁”的內容。弟子問仁,孔子説“仁者,其言也切”(《顏淵》)。孔子在別處也談到“巧言令色,鮮矣仁”(《學而》)。孔子只在少數幾處具體描述了何為“仁”。弟子問仁,孔子回答道:“愛人。”(《顏淵》)孔子還談到,“君子篤於親,則民興於仁”(《泰伯》)。顏回問仁,孔子告訴他:“克己復禮為仁”,且要“非禮勿視,非禮勿聽,非禮勿言,非禮勿動”(《顏回》)。其他弟子問仁,孔子提了三個要求:“居處恭,執事敬,與人忠。”(《子路》)此外,孔子還用五德解釋“仁”:“恭、寬、信、敏、惠。”(《陽貨》)然而,對仁德最明確的説明莫過於下面這段話:“己欲立而立人,己欲達而達人。”(《雍也》)換句話説,仁德要求道德主體幫助他人以及其他生物成就自身。不過,孔子對於仁人所要成就的目標有進一步的限制。他説:“君子成人之美,不成人之惡。”(《顏淵》)易言之,孔子“仁”的理想是為了使他人成為他更好的自己,或者可以這麼講,幫助他人達到“仁”的境界。這一品質將是我們想要在機器人身上建立的最重要的特性。

將仁德轉換為給予人工道德主體的道德準則,我們就得到CR3:

[CR3]在不違背CR1或CR2的前提下,機器人必須幫助其他人類追求道德進步。如果有人的計劃會促進其品德的敗壞或道德的墮落,那麼機器人就必須拒絕幫助他們。

這裏強調的提供幫助,意味着機器人的行為是根據人類所給出的要求或指令來協助進行的。換句話説,機器人並不自行決定什麼對人類主體來説是好的,或者什麼是人類主體應當成就的。同時,運用這個道德規則編程,當人類的命令是為了作惡時,機器人會拒絕提供幫助。這樣,我們不但有了不會傷害人類的人工道德主體,而且也可以防範其他人利用人工智能去幹壞事。

有了以上三條規則,我們就有了儒家機器人倫理學的基本形式。現在所列舉的儒家機器人倫理學準則絕對沒有窮盡一切儒家倫理運用的可能性。可能有不止一個版本的儒家機器人倫理學;選擇不同德行的集合和不同的機器倫理準則都有可能與《論語》文本相兼容。有些儒家機器人倫理學的版本可能會給我的理論模式帶來巨大挑戰。比如,內澤-伍德(Drayson Nezel Wood)認為,《論語》中能解決電車難題的兩個主要的價值是“孝”與“和”。他認為,儒家的愛有差等,始於最親近的家庭成員,進而擴展到國家,然後才是陌生人及其家庭;這意味着,如果軌道上的那個人居於差等序列的最高等級,那麼儒家式的人工智能就會選擇救這一個人而不是其他五個人。內澤妞德所想到的情景包括,救所愛的人(如人工智能的主人)而犧牲皇室成員,救君王而非救另外五個人(即使這五人都達到了君子的道德水平),救一個君子而非救五個庶民,如此等等。但是我並不認為儒家是像他所説的那樣對人的生命價值進行了分級,也不認為儒家人工智能會做出如上的倫理判斷。我認為儒家“親親”與“孝”的觀念並不意味着所親之人的生命重於其他人的生命。但是,內澤-伍德有一點講得很對:儒家人工智能主體不會自動使用功利主義原則去不涉及情感地以人數多少來作選擇標準。那麼,儒家人工智能主體在標準版和天橋版電車難題中究竟會如何行事?

在天橋版本中,執行儒家倫理準則的機器人永遠不會採取將人推下橋的行動,因為這麼做顯然把三條道德原則都違背了。在標準版本中,判斷則要複雜得多。如果機器人是電車司機或鐵道管理員,它的職責會命令它拉動操作杆,使得這個電車在所有可選項中儘可能造成最小的傷害。即使某人與機器人的設計者有特殊的關係,機器人也不會對這個人抱有偏愛,因為在機器人的設計編程中並沒有加上偏愛或是特別情感。如果機器人只是一個路人,那麼根據CR1,它沒有任何義務採取行動,而且根據CR2的禁令,機器人更傾向於袖手旁觀而非採取行動。因此,一個路人機器人不應採取任何行動來使疾馳的電車轉向,即使這麼做能夠減少傷亡人數。

在標準版電車難題中,依照儒家倫理律令行事的機器人,除非是電車司機或鐵道管理員這類特殊角色,是不會拉動操作杆的。在天橋版本中,依照儒家倫理行事的機器人,不論是什麼職分角色,都不會將那名男子推下橋以使電車停止。如此看來,機器人的決定會不同於大部分人類的直覺選擇,因為機器人不會像人類在天橋情景中那樣受到無意識的情感掙扎的影響。儒家機器人不會因自身的“行動”而對任何人造成傷害,或強迫任何人接受他們不願接受的結果,即使它可能因為自身的“不行動”而沒有防止對別人造成的傷害或發生別人不情願接受的後果。在不久的將來,當我們的社會中存在可自我管制、自主行動的人工道德主體時,當不論它是否採取行動都會導致對人的傷害和帶來我們不願看到的後果時,我們寧可它選擇袖手旁觀,而不是採取行動。

結語

M.安德森和S.安德森在他們關於機器倫理學的著作中提到:“機器倫理學的終極目標……是要創造出一種‘自律’的機器人,它們會自己遵守一些理想的道德原則;也就是説,它們可以在這些道德原則的指引下自行決定應該採取何種行動。”他們也認為,研究機器倫理學的另一個好處在於這“可能會帶來道德理論上的突破,因為機器十分適合於我們檢測堅持遵循一個特定的道德理論將會導致何種結果”。本文考察了四類機器倫理的道德模式,即阿西莫夫定律,兩條康德式的“絕對命令”,功利主義的“效用原則”,以及儒家的忠、恕、仁道德原則。在比較了這些道德模式對於電車難題的標準版和天橋版的解決方案之後,本文認為儒家的道德模型要優於其他三種道德理論。

當然,我們設計人工道德主體的初衷不是僅僅為了處理電車難題以及類似的問題。在許多其他實用方面,儒家的人工道德主體可以成為人類社會很好的補助。首先,我們可以按照分配給儒家道德機器人的角色來為其設計具體的工作,比如,為老年人提供幫助,為病人提供保健服務,為遊客提供嚮導服務,為汽車提供安全導航,等等。它的首要職責是忠於角色;因此,它在特定情境中所做的其他任何決定都不能違反其職責。第二,儒家機器人具有精確計算出的偏好指令,不會採取將給其他人類帶來極大的負面價值(包括傷害)或極不可欲後果的任何行動。這一原則要優於阿西莫夫第一定律,因為它既允許了更多對負面價值的考慮,又讓機器人在權衡可允許的行動範圍時更加靈活。而且,它也要優於康德原則或功利主義原則,因為這一道德原則基於儒家的“負面形式的金律”,它的作用是禁止做出錯誤行動,而不是靠主觀意志原則去採取自以為是的行動。在可預見的未來,在我們可能會將主動權交給人工智能的情境中,這一原則可以保護我們避免受因人工智能故意犧牲人類而帶來的傷害,儘管人工智能或許會考慮它們的行動將帶來多大的利益。最後,儒家道德機器人將是有仁德的機器人:在CR3的引導之下,它會協助而不會阻礙人類去努力行善,去成為更好的人,去建設更加美好的世界。也許,最終的人工智能發展會促成人類和人工智能共同生活在孔子理想中的“仁的王國”之中。