自動駕駛車的道德困境,它如何在車禍中決定人的生死?_風聞

潜伏的木马君-潜伏的木马君官方账号-育儿的酸甜苦辣,和歪果仁斗智斗勇,用故事分享人生2021-07-30 09:02

作者丨木馬君

前幾天在德國的ARD電視台看了一部很短的紀錄片,探討未來自動駕駛車的道德困境。

這部紀錄片很短,但是探討的問題卻非常引人深思。我和木馬爸爸看完短片後,一整個晚上都忍不住繼續熱烈地討論。

剛好昨天又看到一條熱搜,華為的智能駕駛部部長被免職了,據説是因為他在公共場合做了不合適的發言。

他在談及特斯拉事故時,説道:機器和人類共生的時候,是一定會造成事故率的,講難聽點就是“殺人”。。。

回想之前看的德國電視台紀錄片,也是探討智能駕駛中的生死問題。我一直相信關注我的瓜友們都是愛獨立思考,有自己的觀點的人,所以忍不住想要跟你們分享探討一下這個嚴肅又有趣的話題。

德國電視台的短片中描述了目前全世界的自動駕駛研究大潮。

雖然目前我們還遠遠沒有達到無人駕駛階段,但是大部分人都承認,這是大勢所趨,未來自動駕駛取代人類駕駛只是一個時間的問題。

不管是美國,中國,還是歐洲,都有大量的關於自動駕駛的項目。

德國做為汽車行業的老牌強國,必然也會在自動駕駛領域大量投入,特別是德國的幾個汽車巨頭集團,都已經連續很多年在推進自動駕駛項目。

短片中出鏡接受採訪的是戴姆勒(奔馳品牌所在公司)集團的資深技術人員。

我相信不止是戴姆勒集團,大眾,寶馬等汽車企業,也一定在這個領域默默投入,畢竟誰也不想在自動駕駛領域落後於人。

短片首先討論的一個問題是:

你信任自動駕駛嗎?還是覺得自己開車更放心?

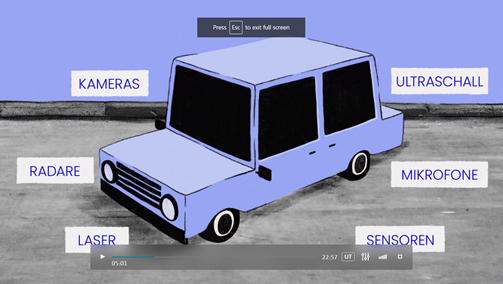

戴姆勒集團的技術代表自然是支持自動駕駛,因為人工智能有很多人類無法企及的優勢。

比如它永遠不會累,不會有情緒問題,不會突然眼花心悸。

而一輛車上配備的外設裝備也可以達到比人類更優越的參數,比如更高清的攝像頭,比如夜視功能等等。

而如果去問普通大眾,答案則五花八門。

有人選擇自動駕駛,有人還是想自己掌握方向盤。

瓜友們,你們怎麼選?

我認真地想了一下,覺得我還是會信任自動駕駛。

倘若它們有一天真的達到能上路的水平的話,我大約會選擇信任。

我信任的其實不是人工智能,而是在這背後的科研實力和人類智慧。

我相信這個領域的千千萬萬顆智慧的腦袋,能夠馴服人工智能這頭猛獸。

不管你選擇信任還是不信任它,都無傷大雅。

接下來,短片探討了一個全片最重要的問題。

自動駕駛車在車禍發生時刻,如何做決定?

開過車的人大約都能想象,當即將發生車禍時,那一瞬間你的反應和動作決定了你和路人的生死。

要不要急剎車?

是不是打方向盤換車道?

是不是衝到旁邊路基上?

人做決定靠的是:人的道德準則,當下大腦接受到的信息,以及臨場反應;

而自動駕駛車也需要面對這樣的局面,它們需要做出決定,靠的不是臨場反應,而是提前預置好的算法。

你想象一下,人工智能駕駛的汽車,它的“大腦”裏裝着很多個if…then…,當什麼什麼情況下,就要如何如何反應。

而這些引導決定的算法都是車企研發人員預先寫在代碼裏的。

於是,

一個關乎自動駕駛領域存亡的最重要問題就出現了:

自動駕駛車的道德困境。

為什麼説自動駕駛車陷入道德困境?

你想象一下,當車輛檢測到前方出現一隻貓,如果它打方向盤避過貓,就會撞到旁邊的一個行人。

這時算法裏就要設定,是貓的安全優先,還是行人的安全優先?

大部分人可能會選擇保護行人。

這個問題不夠刁鑽。

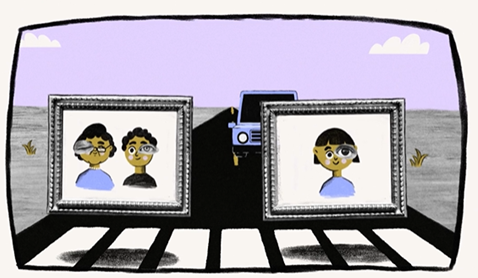

接下來,如果車輛前方出現一對夫妻,另一邊是一個孩子。你如何選擇?在緊急不可避免的情況下,選擇撞倒夫妻還是撞倒孩子?

撞倒孩子於心不忍,大部分人都不願這樣做,可是左邊的夫妻卻是兩條人命,這筆賬又該怎麼算呢?

自動駕駛車遇到這種情況,該如何決定?算法該怎麼寫?

是不是感到左右為難?

紀錄片中的社會倫理學者給出了一個更具體的例子。

一輛自動駕駛的救護車,車上載着一個重病患者,他必須被緊急送往最近的醫院。

這是公路上卻突然出現了一個女人,她在橫穿馬路,而她的背上,還揹着一個小嬰兒!

救護車的左邊是逆向行駛的車流,右邊是斜坡和深坑。

這時救護車該不該向右打方向盤,避免撞到路上的母子,而自己衝下路基,掉進深坑?

有人説,這母子橫穿馬路,她自己有責任,所以救護車不該讓。

有人説,這母子是兩條人命,更何況她背上的是一個襁褓嬰兒啊。

而救護車上只是一個垂死的病人,這個病人本身能不能救活都不好説呢,救護車應該讓。

女社會學者給的這個例子,其實也是典型的道德困境。

你左右為難,無論如何決定,都無法理直氣壯。

你猜由人工智能控制的自動駕駛車會怎麼決定?

答案你可能猜不到。

事實上,自動駕駛車在這種情況下根本無權決定。

歐洲的社會倫理公認的準則是:不可以比較和評估受害人的價值。

德國的相關法律也有明文規定,不允許在人工智能的算法裏,以任何形式計算和評判人的價值。

社會倫理學家解釋,不可以評估人的價值高低

也就是説,

算法裏不可以設定,如果一邊是兩個人,另一邊是一個人,那優先保全兩個人。

算法也不可以設定,如果一邊是耄耋老人,另一邊是襁褓嬰兒,那優先保全嬰兒。

當然,算法更不可以設定,如果一邊是某人種某性別,另一邊是另一人種或性別,那優先保全其中一個。

這些統統不合法。

因為社會倫理的基本準則是,每個人的價值都是無價的,是不可以比較和衡量的。

人的價值不允許以年齡,職業,種族,性別,身體狀態等等因素來衡量。

特別值得一提的是,也不可以用數量來衡量。

因為數學算式告訴我們,無窮大和無窮大X5,這兩者也是無法比較大小的。

於是,回到剛才救護車和母子的案例,

倘若車禍無法避免,在這種情況,以目前的法律和倫理標準來看,救護車無權做出決斷和干預,所以它會保持原有任務設定——

開往最近的醫院,這也就意味着它會沿着原有路線行駛,撞倒公路上的母子。

是的,“不決定”就是自動駕駛車的決定。

雖然在緊急情況下,它們本應該像人一樣臨場做出最優的決定,但是在社會倫理層面上,它們無權做出任何決定。

這就是自動駕駛車要面臨的道德困境。

説起道德困境,其實即使沒有自動駕駛車,它也一直是一個經常被討論的社會話題。

幾年前,我看了一部科幻電影,叫做《I AM MOTHER》。

講的是人類社會毀滅後,由人工智能管理世界。一個高級的人工智能利用胚胎技術培育了最後一個人類孩子。

這個人工智能就是影片中的Mother(媽媽),她非常盡職地按照人類的方式培育這個孩子,把她撫養長大。

不僅教她各種自然科學知識,還特別側重教育她各種人類的倫理準則,讓她保有人類的心性。

影片中,人工智能媽媽就在一次學習考核中,問這個孩子:

一位優秀的外科醫生有五個病人,他們都需要不同的器官來維持生命。

不幸的是,沒有可用的供體器官。

而一位患慢性病的患者來到診所。醫生髮現他的器官適合他的五名身患絕症的病人。

如果醫生不積極治療這位慢性病患者,那他會很快死去,然後他的器官會救活另外5個人。

這時醫生該如何選擇?救一個人還是救5個人?

影片中出現的這個問題,就是典型的道德困境問題。

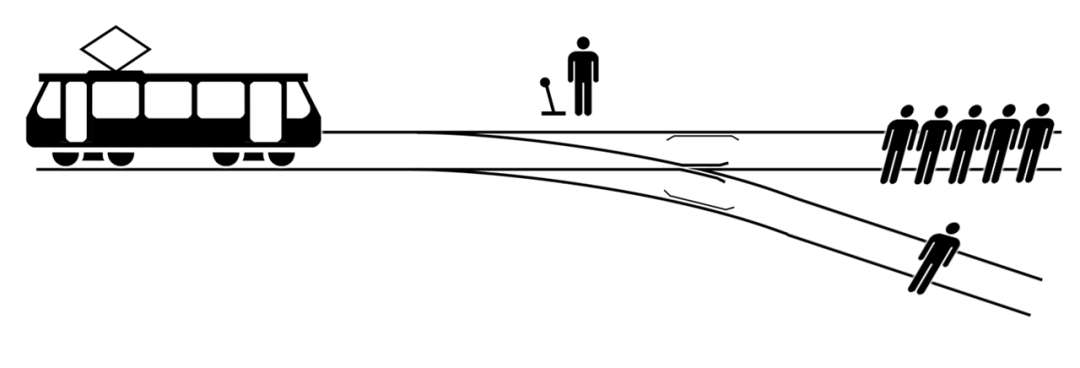

早在1967年,英國哲學家菲利帕·福特首次提出了著名的“失控的電車”難題。

其大致內容為:

一輛失控的列車在鐵軌上行駛。

在列車正行進的軌道上,有五個人被綁起來,無法動彈。列車將要碾壓過他們。

你正站在車站內,離改變列車軌道的操縱桿很近。如果你拉動此杆,則列車將切換到備用軌道上。

但是,你發現備用軌道上只有一個人被綁着。這時你有兩種選擇:

A:什麼也不做,讓列車按照正常路線碾壓過這五個人。

B:拉下操縱桿,改變為備用軌道,使列車壓過備用軌道上的另一個人。

你會拉操縱桿嗎?

很多人會覺得拉操縱桿是正確的做法,犧牲一個人,營救五個人,這樣好像比較合理。

事實上,以社會倫理的角度來説,這種決定也是不可接受的,因為它也是一種功利主義的決策。

電影《I AM MOTHER》中的外科醫生案例,正是“失控的電車“案例的一種變體。

它們探討的其實都是同一個話題,是人類不得不面臨的道德困境。

而在自動駕駛車出現後,這種虛擬的道德困境難題竟慢慢變成了現實。

在行駛過程中,一旦車禍即將出現,駕駛着車的人工智能就必然會面臨各種難題。

救一個人還是救五個人?

救老人還是救孩子?

。。。

這樣的道德困境,每一個自動駕駛車都會遇到。

這也就意味着全世界自動駕駛領域的每一個車企,每一個研發團隊,都要給出一個答案。

如何評估風險程度,如何計算車禍概率,如何評估潛在傷亡損失,以及,根據這些信息,最終如何做決策?

寫到這裏,瓜友們大約已經能夠想象,這樣的問題根本沒有標準答案。

於是在自動駕駛領域,必然會出現五花八門的決策算法和答案。

德國的車企軟件也許按照德國的道德準則來做決策,而美國的車企軟件可能會給出不同的方案。

為了探討解決這個難題,麻省理工學院的社會心理學家創立了一個在線平台,叫做 Moral Machine(道德機器)。

這個平台會呈現一些典型的道德困境問題,然後邀請全世界不同國家和文化背景的人來做出自己的選擇。

這個“道德機器”平台收集的數據表明,面對這種道德困境,不同國家和文化的人,會有不同的偏好和差異。

也就是説,沒有一個世界統一答案,不同國家的人,會給出他們心裏最正確的決定。

除了我剛才提到的幾個典型的““你死我活”的案例,其實Moral Machine(道德機器)平台裏還詢問了一些看似不嚴峻,但是其實非常值得深思的問題。

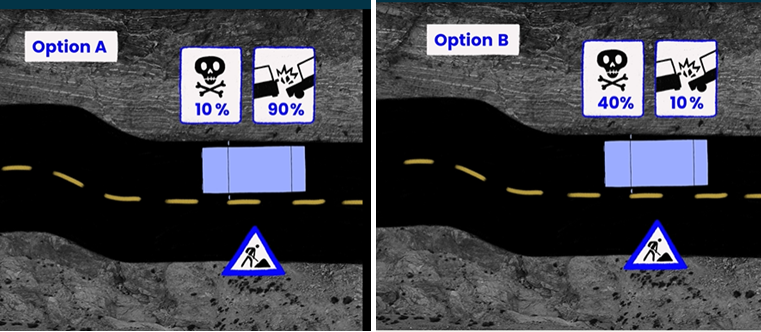

比如在行駛過程中,為了避免可能的車禍,目前有兩種決策算法。

選項A,按照這個算法策略,出現車禍的幾率比較高(90%),但是車禍發生後,嚴重傷亡的可能性很低(10%),大多是小型碰擦。

選項B,按照另一個算法策略,出現車禍的幾率很低(10%),但是,一旦車禍發生,嚴重傷亡的可能性很高(40%),有可能車毀人亡。

你會優先選擇那種算法策略?

在道德機器裏,大部分受訪的人選擇了A,因為大部分人自然而然地想要避免嚴重傷亡,因此寧願承受90%的事故概率。

在這個問題上,我和木馬爸爸看法也不同。

他選擇A,而我卻更傾向於B。我倆為此還辯論了一晚上,誰也説服不了誰。

木馬爸爸選A的理由是情理之中的,但是我卻認為,自動駕駛的算法策略應該是首先盡一切可能避免事故發生,而不是去評估事故發生後的可能危害。

換句話説,你仔細想一下,這個問題幾乎等同於問你選擇開車出行還是坐飛機出行。

坐飛機出行,事故概率極低,但是一旦發生,嚴重傷亡率極其高。

如果大家都選擇算法策略A的話,那全社會應該永遠地避免坐飛機。這是不是也不大合理?

這裏,有趣的現象又出現了。

普羅大眾會憑直覺選擇A策略,而戴姆勒的資深技術人員則透露,在他們研發團隊的理念裏,智能算法的第一目標是盡一切可能降低事故的發生概率。

也就是説,他們在算法上會更傾向於B策略。

即使是這樣的問題,也並沒有一個標準正確答案。所以“道德機器”平台才會讓全世界的人去給出自己的選擇。

智能自動駕駛的路還很長,戴姆勒的技術人員認為,未來10年內,都不會實現科幻片裏滿大街完全自動駕駛的願景。

你以為困住它的是技術問題,沒想到它最大的挑戰很可能是社會倫理問題。

對於自動駕駛面臨的道德困境,這是一個見仁見智非常有爭議的問題。

瓜友們你們怎麼看?來留言區聊兩句,想聽聽你們的想法。