字節跳動開源AI訓練引擎 最快提速3倍以上

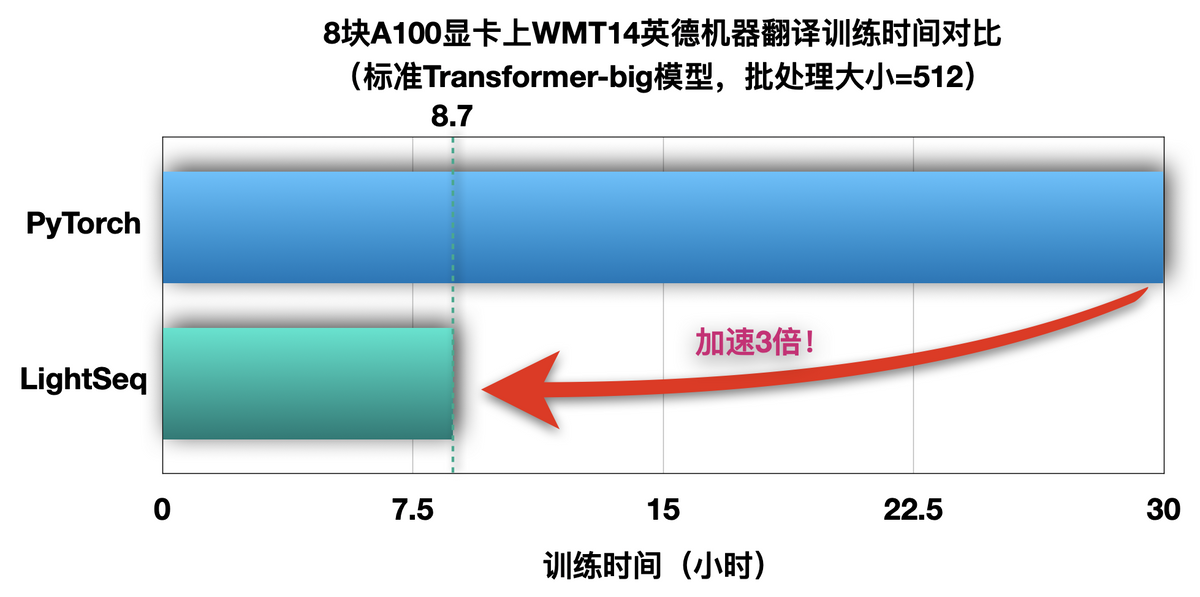

6月28日,字節跳動火山翻譯團隊宣佈推出LightSeq訓練加速引擎,並向全球開發者開源。這是業界首款完整支持Transformer模型全流程加速的訓練引擎,最快可提速3倍以上,幫助從業者大幅提升模型生產效率。

Transformer是自然語言處理、計算機視覺等AI技術領域最常用的基礎模型,被廣泛應用在機器翻譯、文本生成、文本摘要、圖像處理、時間序列預測等任務中。訓練和推理則是AI技術的兩個主要過程,相當於學習知識和解決問題。

受到硬件資源限制,一些高校實驗室和中小公司無法訓練大型模型,降低批處理大小等措施又會導致訓練時間成倍增加。如何利用有限的資源最快訓練出模型,成為計算機科研工作者和開發者們普遍關注的問題。

據悉,LightSeq訓練加速引擎能夠支持Transformer的完整加速,從詞嵌入層、編碼層、解碼層,到最後的損失函數層,業內首次實現了全流程支持。而且LightSeq的訓練速度極快,相比主流的序列生成庫,LightSeq最快只需要三分之一的時間就能完成訓練。

火山翻譯團隊負責人介紹説,LightSeq訓練加速引擎具有功能全面、簡單易用的特點,並提供了豐富的二次開發工具。通過插入自定義層或修改幾個命令行參數等方式,用户可以在各種流行訓練庫上輕鬆使用LightSeq。

字節跳動持續投入開源社區的建設,已開源了機器學習 平台Klever、聯邦學習 平台Fedlearner、高性能分佈式訓練框架BytePS等重磅項目。2019年底,火山翻譯團隊開源了LightSeq推理加速引擎,此次開源LightSeq訓練加速引擎,完全打通了Transformer模型從訓練到推理部署的整個流程。

“開源是推動科技進步的重要力量,我們受益於開源,更需要為開源社區做出貢獻”,上述負責人表示,字節跳動把LightSeq系列項目開源,與各界共享技術成果,希望能幫助廣大科研人員節約時間成本,為學術界和產業界激發創造力提供有力支持。