用人工智能解釋大腦,一個虛假故事的開端?_風聞

返朴-返朴官方账号-关注返朴(ID:fanpu2019),阅读更多!2022-07-18 10:03

在理論上,人工智能能自己學習大腦活動數據中的隱藏模式,並告訴我們一個關於大腦運作的故事。但這個故事不一定關於我們的大腦。

撰文 | Bahar Gholipour

翻譯 | P

校對 | Soda

人們通常將大腦比作一個黑箱,但任何曾窺見其內在的神經科學家都知道,這仍舊只是一個輕描淡寫的説法。技術進步正使我們越來越能夠接近神經環路,現在,我們有條件仔細觀察幾乎任何數量的神經元的活動。然而,大腦的神秘只隨之愈深。如同交響樂般的神經元同步發放,其藴含的意義是什麼?神經活動如何將光和聲波轉化為我們對視覺和聽覺的主觀體驗?神經元進行什麼樣的計算,它們所遵循的廣泛原則又是什麼?大腦並不是一個黑箱——它是一個陌生世界,那裏的語言和局部法則尚未被破解,而直觀則已然消亡。

人工智能可以為我們解決這個問題嗎?也許吧。但最近的一個認識是,即使是我們在人工智能技術方面已經取得巨大成功的最新、最強大的工具,在被用於解碼大腦時也是舉步維艱。誠然,機器學習算法,如人工神經網絡,已經為我們解決了許多複雜的任務。它們可以預測天氣和股市,或者識別物體和人臉。而更重要的是,它們不需要我們告知規則就能做到。至少在理論上,它們應該能夠自己學習大腦活動數據中的隱藏模式,並告訴我們一個關於大腦如何運作的故事。事實上,它們的確講出了一個故事。只不過,正如一些科學家所發現的那樣,這個故事不一定是關於我們的大腦。

這就是冷泉港實驗室(Cold Spring Harbor Laboratory)助理教授塔提亞娜·恩格爾(Tatiana Engel)最近在研究大腦決策時發現的。作為一名物理學家出身的計算神經科學家,恩格爾致力於開發能夠幫助解釋我們做決策時的神經元活動的數學模型。雖然神經科學家們已經提出了一些理論,但他們還沒有就決策——即便是最簡單的那些——是如何在大腦中實現的達成共識。帶着探索更廣泛的可能性,恩格爾轉向了機器學習:她不再從具體的假設出發建立神經活動的模型,而是從靈活的、可以根據數據自我塑造並自行找出自身參數的模型出發。

這就是冷泉港實驗室(Cold Spring Harbor Laboratory)助理教授塔提亞娜·恩格爾(Tatiana Engel)最近在研究大腦決策時發現的。作為一名物理學家出身的計算神經科學家,恩格爾致力於開發能夠幫助解釋我們做決策時的神經元活動的數學模型。雖然神經科學家們已經提出了一些理論,但他們還沒有就決策——即便是最簡單的那些——是如何在大腦中實現的達成共識。帶着探索更廣泛的可能性,恩格爾轉向了機器學習:她不再從具體的假設出發建立神經活動的模型,而是從靈活的、可以根據數據自我塑造並自行找出自身參數的模型出發。

在這種方法中,評估機器學習產生的模型的標準是它們在多大程度上能預測一組訓練時沒有見過的新的大腦測量結果。但在這一過程中,恩格爾想知道,我們到底有多確信這一最優模型反映了大腦的內在邏輯?

“現在,在神經科學以及其他領域,使用這種靈活模型作為了解真正的物理、生物系統的工具的現象越來越普遍了。”恩格爾説,“像這樣,我們建立一個模型,然後發現它可以很好地預測來自某個系統的數據。接着我們就會做出這樣一種假設,即這樣一個模型應該是以類似於真實系統的方式運作,因此,通過研究模型如何運作,我們就將理解系統如何運作。”

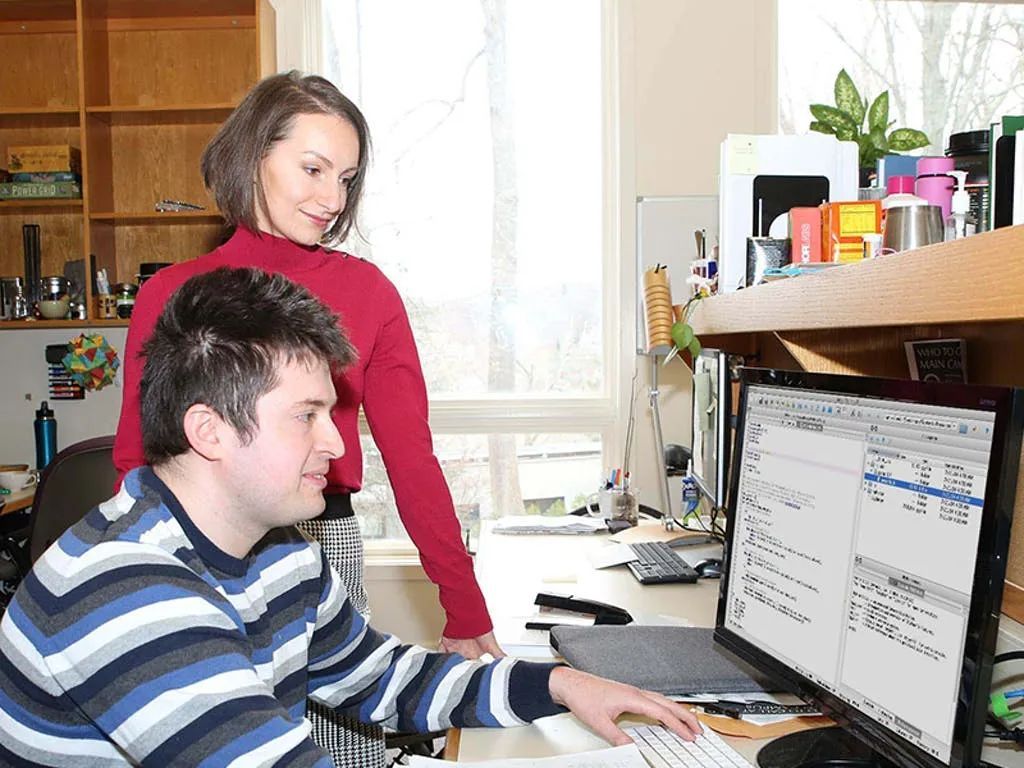

團隊合作:一位物理學出身的計算神經科學家,塔提亞娜·恩格爾,與同事米哈伊爾·根金的合照。他們正在開發數學模型以理解神經元如何協作,最後達成我們的大腦每天每分鐘都會做的決策。丨來源:冷泉港實驗室

團隊合作:一位物理學出身的計算神經科學家,塔提亞娜·恩格爾,與同事米哈伊爾·根金的合照。他們正在開發數學模型以理解神經元如何協作,最後達成我們的大腦每天每分鐘都會做的決策。丨來源:冷泉港實驗室

然而,更多時候,這一假設可能是沒有根據的。在2020年的一項研究中,恩格爾和她的同事,冷泉港實驗室的一名博士後,米哈伊爾·根金(Mikhail Genkin)檢查了靈活模型在人工合成的數據上的效果,這些數據的內部動態是研究人員已知的[1]。他們發現,反直覺地是,有時最優模型反而離反映產生數據的原始系統的核心特徵最遠。“它們(模型)可能具有系統中根本不存在的特徵或屬性。”恩格爾表示,“一個模型可以對數據進行良好的預測,同時依舊是錯誤的。”換句話説,預測能力——機器學習算法的黃金標準——在被應用到神經科學時可能是一個誤導性的指標。

如果沒有有效的計算模型,科學家們可能很難有機會理解海量的大腦數據,並解釋大腦的功能如何由神經活動產生。使用人工智能幫助大腦建模的前景正備受吹捧,而恩格爾和其他研究人員的發現可能會讓人覺得是在潑冷水。然而,這些問題並不是無法克服的,恩格爾説。她和其他人已經在想辦法避開這些陷阱。他們正在開發一些方法,這些方法將使他們能夠繼續使用人工智能的強大工具,而不會對誤導性的敍事信以為真。

在計算層面描述神經元行為的嘗試最後總是帶來讓人不得不謙卑的教訓,即使是那些成功的嘗試。1952年,阿蘭·霍奇金(Alan Hodgkin)和安德魯·赫胥黎(Andrew Huxley)把神經元想象成一個電路,其中被仔細排布的電阻和電容可以產生類似於神經元特徵性的峯電位(spike)的電流,而峯電位是大腦中通訊的基本要素。這一模型被證明是一項里程碑式的成就,但要理解其重要性卻遠不是看着方程式就能直接知道的。當赫胥黎花了好幾天時間費力地將電壓數字輸入一個機械計算器,觀察電路的輸出是否與真正的神經元相匹配時,他對這個簡單模型的複雜行為深感驚歎。“很多時候,我的期望都是錯誤的。”他在十年後的諾貝爾獎演講中回憶説,“我從這些手工計算中得到的一個重要教訓是,在試圖研究這種複雜程度的系統時,一個人的直覺是完全不夠的。"

神經科學家們現在面臨着更高數量級的複雜性,因為他們已經轉向研究活體動物和人身上的神經元羣體。即使只是來自於100個神經元的數據,也大得讓人眼花繚亂。它的變化是動態的,沒有明顯的韻律和緣由。而且,人們很少清楚其中哪些部分與正在被研究的大腦功能真正相關。這些因素使得我們更難提出概念或者數學模型來描述神經活動。

更難的是要弄清楚哪一個被提出的模型能解釋關於神經元的一些真實情況,而哪一個模型又只是幸運地正好在數學上和數據匹配。在不知道大腦的基本規則的情況下,科學家們能做的,最多就是看看這些模型相互之間比較起來會是怎樣的。

更難的是要弄清楚哪一個被提出的模型能解釋關於神經元的一些真實情況,而哪一個模型又只是幸運地正好在數學上和數據匹配。在不知道大腦的基本規則的情況下,科學家們能做的,最多就是看看這些模型相互之間比較起來會是怎樣的。

“這就像我們看到的只有一輛移動的汽車,而我們必須通過對引擎蓋下發生的事情做出假設來探明它是如何移動的。”與恩格爾合作研究決策的波士頓大學神經科學家錢德拉莫里·錢德拉塞卡蘭(Chandramouli Chandrasekaran)説,“然後我們試圖找出,所提出的想法——例如模型A和模型B——中到底是哪一個在匹配我們對汽車運動的測量,讓它做得更好。”

錢德拉塞卡蘭説,儘管這是一種越來越流行的方法,但這種方法仍然可能在重要方面失敗。作為一個在工作中直接接觸大腦測量的、同時做計算和實驗的研究人員,錢德拉塞卡蘭親身體會到,神經活動完全不像一輛平穩行駛的汽車——它理所當然地太複雜了,以至於不可能正好被我們只是粗略勾勒的模型所描繪得完全相符。“實驗數據通常要複雜並且異質得多。這就是它(神經活動)的本質。它不像你認為的那樣簡單和漂亮。”他説。錢德拉塞卡蘭已經在一篇文章[2]中説明,這在實踐中意味着,神經活動的細微變化有時會導致它被歸類為模型A,而實際上它遵守的是模型B,反之亦然。這就是為什麼對兩個模型進行正面的直接比較並不能保證確定模型正確性的原因之一。

最近在決策領域爆發的一場激烈爭論突出了這些困難。一切始於2015年發表於《科學》期刊的一篇論文中的爭議性發現。該論文比較了兩個模擬大腦如何做出決定的模型,特別是知覺決策(perceptual decisions)[3]。知覺決策涉及大腦對其收到的感覺信息做出判斷:它是紅色還是綠色?它是在向右還是向左移動?這個決定很簡單,但如果你正好被交警攔下,它就可能會帶來嚴重的後果。為了研究大腦如何做出這些決定,研究人員幾十年來一直在記錄動物體內神經元羣的活動。當神經元的發放率被繪製出來並對多次試驗取平均時,它呈現出一種逐漸升高的信號,以“上升”到一個決定。

自20世紀90年代以來,基於一個有影響力的模型的標準敍事,這一“上升”反映了神經元對證據的逐漸積累。換句話説,這就是神經元發出決策信號的方式:它們在收集支持一種或者另一種選擇的證據時,會增大自身的發放率,直到積累下來的證據使它們的發放率達到閾值。然而,那份2015年的研究問道,“上升”是否是對多次試驗進行平均造成的一個偽影(artifact):分析單一試驗的混亂且有限的數據要難得多,但在一次試驗中會發生什麼?一個神經元的發放率是真的在持續上升還是在進行離散的跳躍?這一差異可能指向決策背後的不同策略。他們的分析表明,相比起“上升”模型,神經元的應答更符合跳躍模型。幾年過去後的現在,經過許多研究,科學家們還是沒有一個關於哪個模型是正確的確切結論。

自20世紀90年代以來,基於一個有影響力的模型的標準敍事,這一“上升”反映了神經元對證據的逐漸積累。換句話説,這就是神經元發出決策信號的方式:它們在收集支持一種或者另一種選擇的證據時,會增大自身的發放率,直到積累下來的證據使它們的發放率達到閾值。然而,那份2015年的研究問道,“上升”是否是對多次試驗進行平均造成的一個偽影(artifact):分析單一試驗的混亂且有限的數據要難得多,但在一次試驗中會發生什麼?一個神經元的發放率是真的在持續上升還是在進行離散的跳躍?這一差異可能指向決策背後的不同策略。他們的分析表明,相比起“上升”模型,神經元的應答更符合跳躍模型。幾年過去後的現在,經過許多研究,科學家們還是沒有一個關於哪個模型是正確的確切結論。

而且情況還可能更糟:兩個模型可能都不正確。“如果有一個C模型呢?或者D呢?”恩格爾説。如果取而代之的是,她可以測試一系列連續的模型呢?這就是靈活建模最有用的地方,它不會把她限制在少數幾種情況下。但恩格爾發現,這種方法也可能選擇出與本質上的物理現實沒有多少共同之處的情景。首先,她必須找到一個解決這個問題的方法。

靈活模型在開發時考慮的是機器學習的目標:對預測能力進行優化。通過這種方式,它們可以把從一組數據中學到的東西,應用到它們以前沒有見過的新數據上。例如,當建立一個分類器來區分貓和狗時,目標是在現實世界中它仍然可以區分貓和狗。其算法是否使用與我們大腦相同的策略來實現這一目標並不重要。事實上,在這種情況下,它肯定不是這樣做的。

另一方面,神經科學家則有一個在根本上不同的目標:他們不想只是用一個模型擬合數據,而是想從數據中發現猜想。他們希望能夠有一個模型能從神經活動中學到如何變得像神經元一樣。恩格爾説:“我們不得不放棄這種為預測而優化模型的想法,並想出一種新的方法,將一個不同的目標提出來。”她和根金一起關注這樣一個事實,即在不同的數據樣本中,真實的特徵總是相同的,但噪聲是不同的。就這樣,他們開發了一個新的程式,以允許在不同的數據樣本上發現模型,並提取它們的共同特徵。這種新方法識別了生成合成數據的正確模型。而當應用於真實的大腦數據時,它為每個樣本得出了類似的模型,這表明與傳統方法的胡亂猜測不同,這些模型已經捕獲了系統的一些真實特徵。

這一解決方案發表在《自然-機器智能》上[4],它將使得靈活模型在其最初的目標之上更具有擴展性,並對生物科學更有用處。這不一定能成為每一個用於神經科學的人工智能工具的解決方案,恩格爾説,但它可以改善靈活模型這一被神經科學家廣泛使用的工具的實際應用。

對恩格爾本人來説,這一方法已經開始帶來對決策的新見解。該團隊正與錢德拉塞卡蘭合作探索他們最初的問題:什麼樣的模型能最好地描述決策過程中的神經活動?到目前為止,他們所看到的既不是“上升”也不是“跳躍”。他們的發現會解決這個爭論嗎?抑或開啓下一回合的爭論?但願我們很快就會知道。

參考文獻

[1] Genkin, M. & Engel, T.A. Moving beyond generalization to accurate interpretation of flexible models. Nature Machine Intelligence 2, 674-683 (2020).

[2] Chandrasekaran, C., et al. Brittleness in model selection analysis of single neuron firing rates. BioRxiv (2018). Retrieved from DOI:10.1101/430710.

[3] Latimer, K.W., Yates, J.L., Meister, M.L.R., Huk, A.C., & Pillow, J.W. Single-trial spike trains in parietal cortex reveal discrete steps during decision-making. Science 349, 184-187 (2015).

[4] Genkin, Mikhail, and Tatiana A. Engel. “Moving beyond generalization to accurate interpretation of flexible models.” Nature Machine Intelligence 2.11 (2020): 674-683.

本文經授權轉載自微信公眾號“神經現實”,編輯:老司橘。

本文經授權轉載自微信公眾號“神經現實”,編輯:老司橘。

原文:

https://nautil.us/ai-is-helping-scientists-explain-the-brain-14073/

特 別 提 示

1. 進入『返樸』微信公眾號底部菜單“精品專欄“,可查閲不同主題系列科普文章。

2. 『返樸』提供按月檢索文章功能。關注公眾號,回覆四位數組成的年份+月份,如“1903”,可獲取2019年3月的文章索引,以此類推。