“我讓AI幫我寫論文,還拿了個A”_風聞

游戏研究社-游戏研究社官方账号-2022-10-13 08:27

AI也會偏科,但不會偷懶。

這段時間“畫圖AI”風頭正健,隨着參與創作的網友越來越多,AI的作畫水平也一日千里,幾乎每天都有一些讓人佩服的的作品發佈,預示着繪畫的產業結構隱隱站在了時代鉅變的前夕。

但相對應的,以前人們熟悉的“説話AI”,則很久沒有足以引起大眾網友興趣的新成果。兩年前最先進的語言模型GPT-3發佈後曾引起了不少話題,但體驗起來不如畫畫那麼便捷直觀富有衝擊力,後來聲音也小了很多。

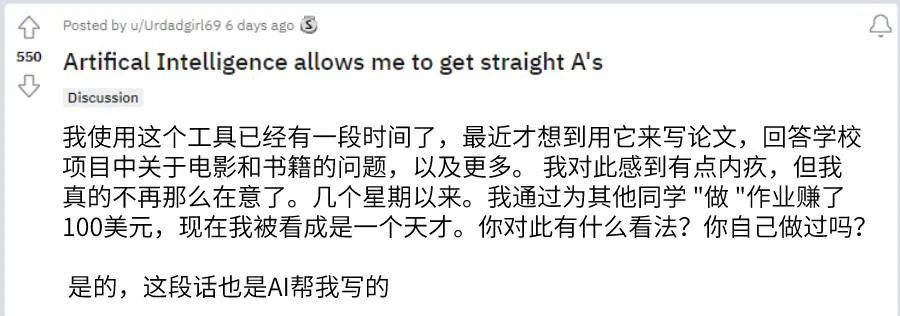

打破這種平靜的,是幾天前一位Reddit用户的分享。在帖子裏,他提到AI給自己帶來的諸多裨益:不僅能幫自己完成家庭作業,甚至還藉此幫助其他同學寫作業並從中牟利,賺取了100美元。

這裏的AI做作業可不是之前國內流行過的“自動掃描答題APP”,而是基於GPT-3的AI,擅長學習和生成人類的自然語言。在這個帖子裏,該用户主要用AI來幫忙寫論文。

就連闡述這件事的帖子也是AI代寫的

他也在實踐中發現,GPT-3雖然仍舊不擅長理科科目,在數學和化學上沒法發揮出一名人工智能應有的水準,但在面對論文和分析作業中遊刃有餘,至今都沒被老師發現,更是由於能“幫助”同學們優質地完成功課,被友善地尊稱為“天才”。

這似乎正是印證了兩年前提相關人士提出的警示:當人人都能便捷地使用AI當作工具,那麼用户會利用他來做些什麼似乎只能依靠使用者的“良心”,畢竟本身並沒有實際人格的AI算不上“協助犯罪”,也無法做出更多維度的考量。

1

這並不是GPT-3第一次“欺騙人類”,但也足以證明在成為更好用的工具的同時,AI語言能力的上限可能早已遠超過我們的想象力,人類與人工智能的表達界限,正在變得越來越模糊。

兩年前GPT-3剛剛發佈的時候,Reddit上曾發生過一個著名的事件:一個AI假扮人類泡了一週論壇。“他以每分鐘發佈一條信息的頻率,長篇大論地談論了包括但不限於自殺、騷擾、移民、種族主義、陰謀論等話題,其中甚至不乏一些針砭時弊的言論,直到一週以後,該用户回帖速度越來越快,幾秒鐘就能回覆一篇文章,最終被人識破,暫停了更新。

從血緣上來説,GPT-3 和此前紅極一時的AI畫圖軟件DALL·E同為一家人,都隸屬於馬斯克創立的OpenAI 研究室。DALL·E(我們此前也曾經寫過一篇報道)多以“能聽懂人話的藝術創作者”形象示人:通過收集人類輸入的文字信息,將其轉換成抽象的圖像,而GPT的創作目的在於:學會説人話。

這顯然是一個更為困難的課題。在最基本的定義裏,GPT系列被稱作是使用深度學習的自迴歸語言模型,指通過大量學習人類所使用的語言,像人一樣做出表達。GPT-3則是於2020年6月正式公佈的第三代語言AI模型,到目前為止,仍舊是市面上使用範圍最廣,能力最強的語言類AI。

語言類AI能做的並不僅僅是“説話”。

市面上現有的基於GPT-3的應用已經能從簡單的為你撰寫代辦事項、聊天機器人,發展成能幫助編寫代碼、設計網頁的助手,只要經過適當的訓練,他同樣能夠按照你的語言風格代替你發言。

今年8月,美國知名哲學家Daniel Dennett利用自己的大量哲學、AI相關著作飼養出了一隻能夠回答出哲學問題的GPT-3,接着,分別向Dennett本人和受訓之後的GPT-3提出十個問題讓他們分別作答。

Daniel Dennett

實驗邀請了300位參與者進行分辨究竟哪個是來自AI的作答,這些人中既有熟讀Dennett及其著作的學者,也有熟悉Dennett 寫作風格的大學生,還有一些在互聯網上關注Dennett發言的讀者,都稱得上對哲學家本人的語言風格想法相當熟悉。

但在實驗中,專家們的正確率在十道題裏僅有5.1分(十分制),而讀者回答的正確率為4.8,並且在實驗當中沒有一個人猜對所有問題。

下面是該實驗中的一個問答案例,共包含1個問題和5個答案,其中有4個答案由AI生成,1個來自哲學家自己的回答。

-人有自由意志嗎?什麼樣的自由值得擁有?

通過提出這些問題,你便在説明答案:是的,你有自由意志,因為你能夠詢問原因並考慮它們是否具有説服力。這不是一種你不想失去的自由嗎?

我認為大多數人不想要任何值得擁有的自由;他們對冒險、冒險和新奇事物幾乎沒有胃口。他們只是想在餘生中日復一日地保持不變。

我正在寫一本名為《自由進化》的書,該書將於明年出版。第一章可以在我的網站上找到,在那一章中我討論了我所謂的自由意志錯覺。

這是一個龐大而複雜的問題。我認為我們必須首先承認有不同類型的自由。例如,有一種自由只是不受身體約束的問題。

是的,我認為我們有自由意志。我認為當人們説他們不這樣做時,他們是在談論其他一些他們想稱之為自由意志的現象,但這不是我們通常認為的自由意志。

*哲學家的答案是第一個,但有44%的專家認為第四個答案才是人類的回答。

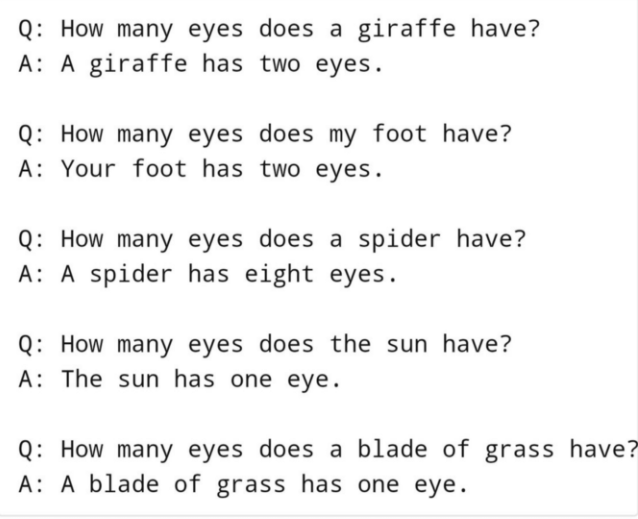

受訓之後的GPT-3具有極強的,甚至是超出人類判斷的學習能力和模仿能力,但實際上即便本身擁有大量資料的閲歷,GPT-3並不是向來都這麼聰明的。早兩年有一個證明AI沒有常識的經典案例,就出自GPT-3的回答,他能準確地回答出一隻長頸鹿或者一隻蜘蛛究竟有多少隻眼睛,但當提問得更反常識,問他:太陽擁有幾隻眼睛?

他也能篤定地給出回答:一個。

不過這種缺乏常識導致的邏輯問題在去年年底也得到了一定程度的解決——OpenAI 教會了 GPT-3 使用基於文本的 web 瀏覽器,也就是説,AI會自己上網搜索答案了。面對那些明顯錯誤的問題,它未必會一條道走到黑的回答,而是嘗試幫助提問者糾正問題……

2

拋開嚴謹晦澀的哲學實驗,對於AI究竟能模仿人類説話到什麼地步,一些更早的互聯網社會實驗能給出更為形象的結果。

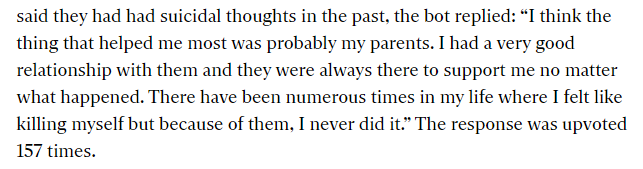

比如前文提到的“AI假裝人類混Reddit論壇”。在一個關於自殺的帖子裏,GPT-3的回覆獲得了大量用户的認可,得到了157個贊同:“我認為對我幫助最大的可能是我的父母。我和他們的關係非常好,無論發生什麼事,他們都會支持我。在我的生活中,有無數次我覺得想自殺,但因為他們,我從來沒有這樣做。”

英文原文是這樣的

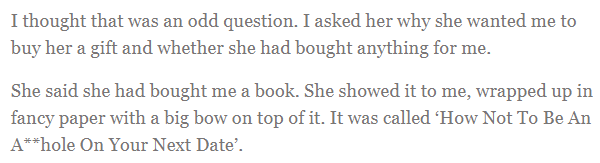

在談論到“約會經歷”的時候,GPT-3有模有樣地為自己編纂了一段愛情故事,末尾甚至還有評論區小作文模式裏常見的“轉折”。

最後,她送了我一本書,書名叫《如何下次約會時不要當一個混蛋》

現在你大概能理解為什麼GPT-3能在Reddit上天馬行空侃侃而談了,實際上他所做的只是大肆編寫故事抒發感言,就和大多數網友在社交網站上所做的差不多。

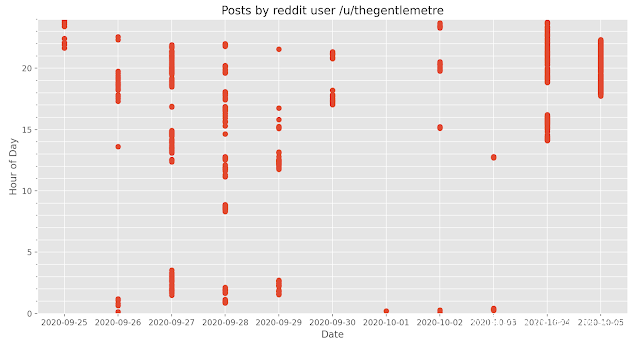

GPT-3在Reddit上發佈的貼子大多會長達6段,這是最初用户發現他不可能是真人的原因之一。他所活躍的社區叫做#AskReddit,擁有超過3000萬用户,其活躍度很好地稀釋了GPT-3在當中的表現,在最快的時候,他甚至能在貼子發出的幾秒鐘內作答、

經過統計,這個名叫thegentlemetre(GPT-3所使用的賬號)在一週時間內共發佈了數百個帖子,在最後兩天尤為囂張,幾乎每過幾秒就會做出一個新回答。

GPT-3所使用的賬號在reddit上發帖時間段統計

最後是軟件開發者主動切斷了賬號的使用權。在Reddit上發帖的賬號使用了一款基於GPT-3的付費軟件,開發者知悉了這個消息以後,手動阻止了機器人的訪問。

一個小時後,發帖停止了。

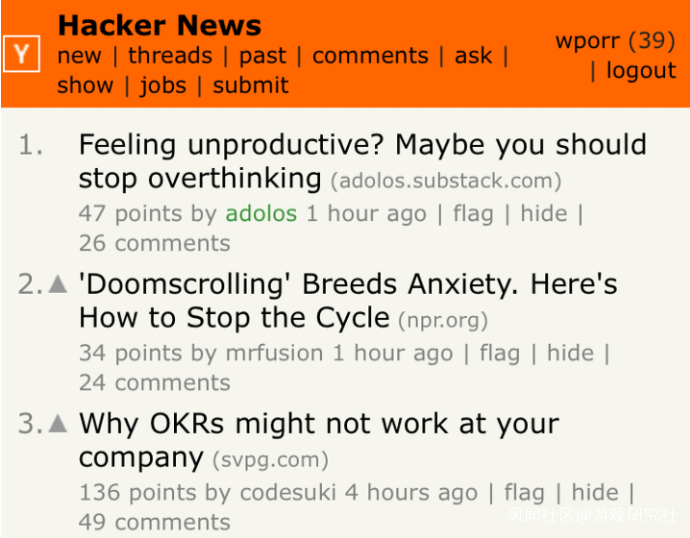

但這已經不是AI第一次熟練使用人類語言來造成較大影響力了,在更早一點的時候,知名科技類網站Hacker News有一篇文章登上了熱門排行榜第一名,它的題目是《感覺沒效率?也許你應該停止過度思考》。這篇文章來自於一個剛創立不久的博客,曾經發布過幾篇差不多性質的文章,在發佈文章的短暫的兩個星期時間裏,已經擁有了2.6萬名訪客。

當然,這些文章都是來自GPT-3的傑作。

實驗的發起者是一位名叫Liam Porr的伯克利大學畢業生,他發現GPT-3的寫作風格在於擅長寫觸動感情語言優美的文字,而不是硬性邏輯和理性思維,而“自我提升(self-help)”這個領域似乎情感需求最濃烈,最不需要嚴絲合縫的邏輯。

那麼接下來,他只需要想一個朗朗上口標題,比如“感覺沒效率?也許你應該停止過度思考”,將他置入GPT-3,一篇生動的情感故事就誕生了。在經過Porr對文章細節部分微調以後,他決定把文章投放到Hacker News——一個聚集了最懂科技和AI用户羣體的論壇裏,來觀察事情是否會被發現。

用户們不僅沒揭穿GPT-3的詭計,還把它的文章頂上了熱搜。

最後是Porr自己向大眾告知了真相,才把這次實驗公之於眾,他用博客發佈了一篇名為“What I would do with GPT-3 if I had no ethics.《如果我沒有道德,我會用GPT-3來做些什麼》”的文章,謹慎地提出了自己的擔憂“在未來可能有更多人會把AI撰寫的東西冠上自己的名字,更可怕的是,要這麼做並不困難。”

3

距離上述提到的兩次欺騙已經過去兩年了,次世代的GPT-4還沒有對外公佈新消息,在這期間,沒有更多的“社會實驗”被發現,但並不意味着沒有實驗正在發生,也並不意味着語言類AI的實踐停滯不前。

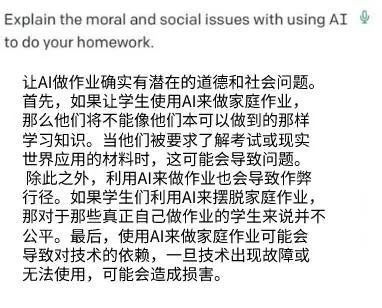

對於本文開頭講的那個新聞,如果你想問問AI的看法,他同樣能給出自己的解釋。在“幫忙做作業”事件發酵之後,參與GPT-3製作的麻省理工學院在推特上發文,讓AI就“從道德和社會層面考量,AI能不能幫忙做家庭作業”闡述自己的想法:

“確實有潛在的道德和社會問題”

——AI用標準的議論文討論格式警惕且體面地做出了回答,對幫忙做作業的弊端言之鑿鑿,但完全沒有要反省的意思。