當今旗艦電視最新畫質技術,馬上就被聯發科搬到手機上了_風聞

量子位-量子位官方账号-2022-10-19 14:44

蕭簫 發自 凹非寺

量子位 | 公眾號 QbitAI

現在居家看電影,大夥兒還是更願意用電視。

畢竟在同等條件下,電視的屏顯和畫質擺在那裏,手機再怎麼升級屏幕,沉浸感還是沒有電視好。

BUT,就在最新一期天璣旗艦技術溝通會上,聯發科卻突然宣佈,成功把電視上的**畫質“秘籍”**搬到手機上來了——

要知道在智能電視市場,聯發科智能電視芯片至今已助力累計超過20億台電視產品在全球各地上市,是這一領域的領導廠商,畫質增強技術更是早有積澱。

電視技術移至到手機上帶來了兩點好處,一方面,畫質品質更高了;另一方面,用到手機拍照甚至拍視頻上,可以節省算力進一步提升能效。

要知道,這可是各大頭部電視廠商都在用的畫質技術,有幾家才剛安排到新產品上。

此前手機雖然也get了不少影像處理技能,但和高端電視比起來還是要低調一些。

這究竟是怎麼做到的?

把電視畫質技術搬手機上來了

最新的電視技術全稱AI景深畫質增強技術(AI Depth PQ),目前這項技術已經被用在不少電視上。

既然如此,聯發科腦洞大開:為什麼不能將這類AI畫質優化相關技術直接用到手機拍照、視頻實時處理上,直接改善成片效果?

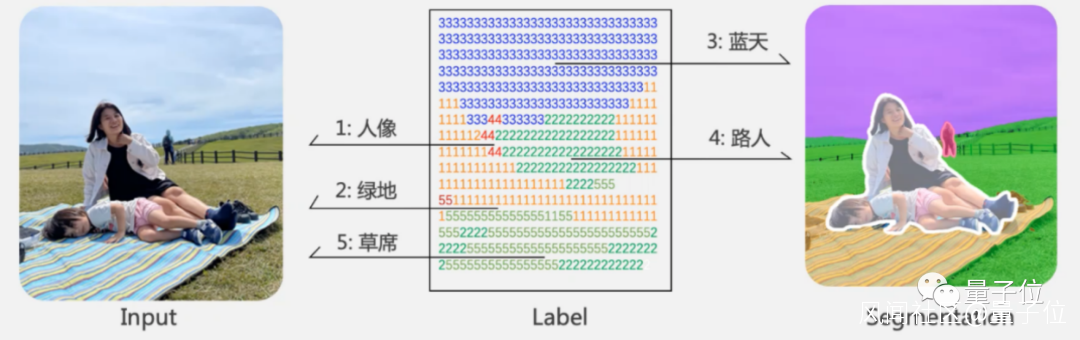

具體來説,通過AI來進行畫質增強的技術又可以被分為幾類技術,包括AI圖像語義分割技術、景深估計技術和智能優化技術等。

其中最重要也是整個技術的核心,就是AI圖像語義分割技術。

這項技術本身並不複雜,核心思路就是將場景中的不同物體按照“描邊”的方式分割成幾個區域,每個區域中的所有像素都可以用相同的標籤來標記:

**△**例如像素4標籤路人,像素3標籤藍天

但用在手機智能拍照上,又有至少三大考驗:

AI的理解能力,如何合理切分照片的前景和背景;AI的決策能力,如何選擇各區域的優化算法;受限於手機體積,AI算法的功耗不能太大……

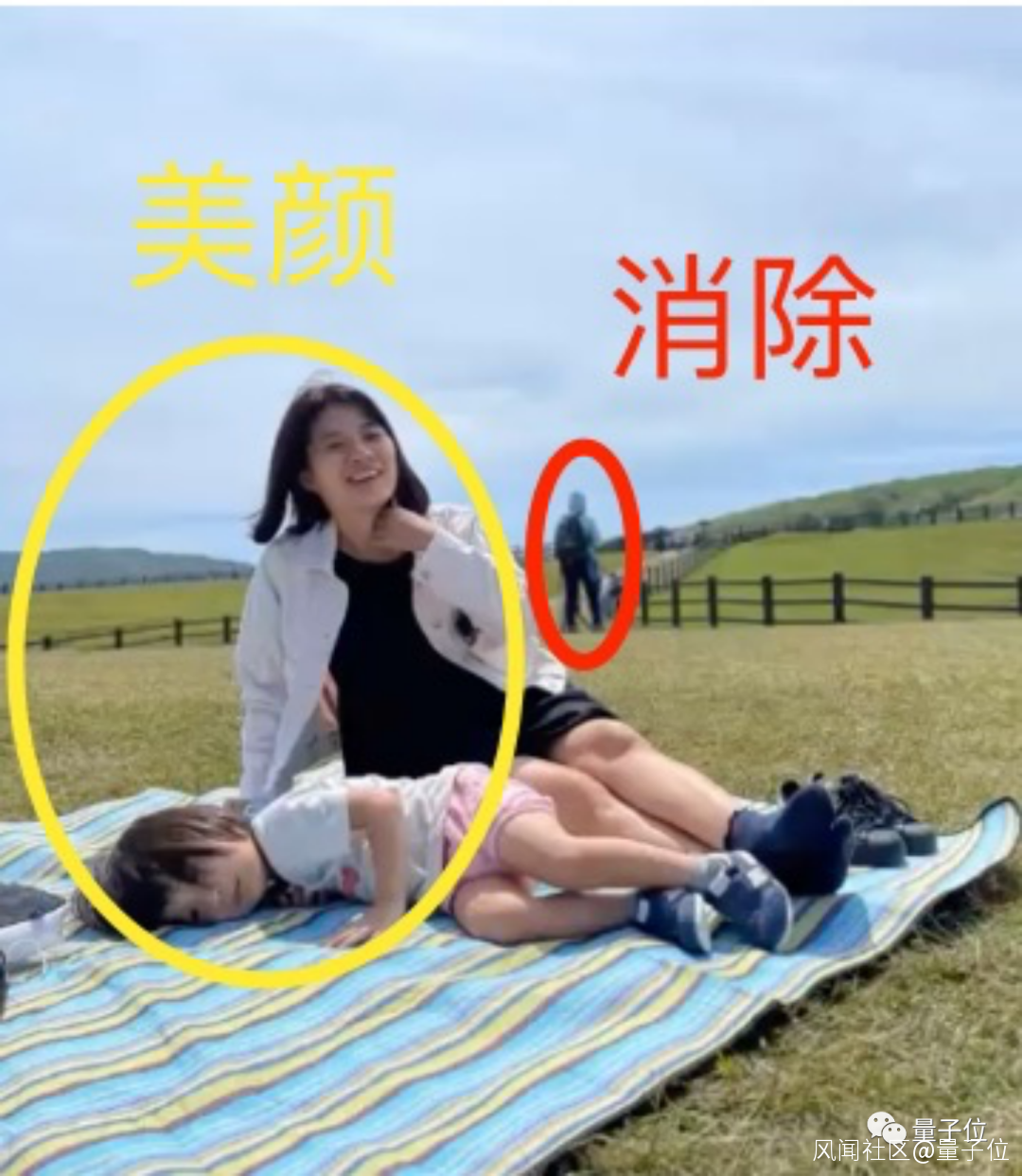

例如,上圖中站在背後的路人、和毯子上正在拍照的兩個主角,雖然都屬於“人”這一標籤,但需要進行的處理卻截然不同,一個需要摳圖並智能消除、另一個需要智能美顏算法:

又例如,即使是被劃分為“背景”的部分,在進行處理時也有不同的算法需求,像照片中的“普通藍天”需要被優化甚至智能替換成“更討好眼球的藍天”,而草地色彩則需要被調整得更明亮一點。

再例如,想將這個技術擴大到視頻拍攝中,像電視處理電影那樣實時進行,AI圖像語義分割技術又不能佔用太多算力,不然直接掉幀甚至快速掉電……

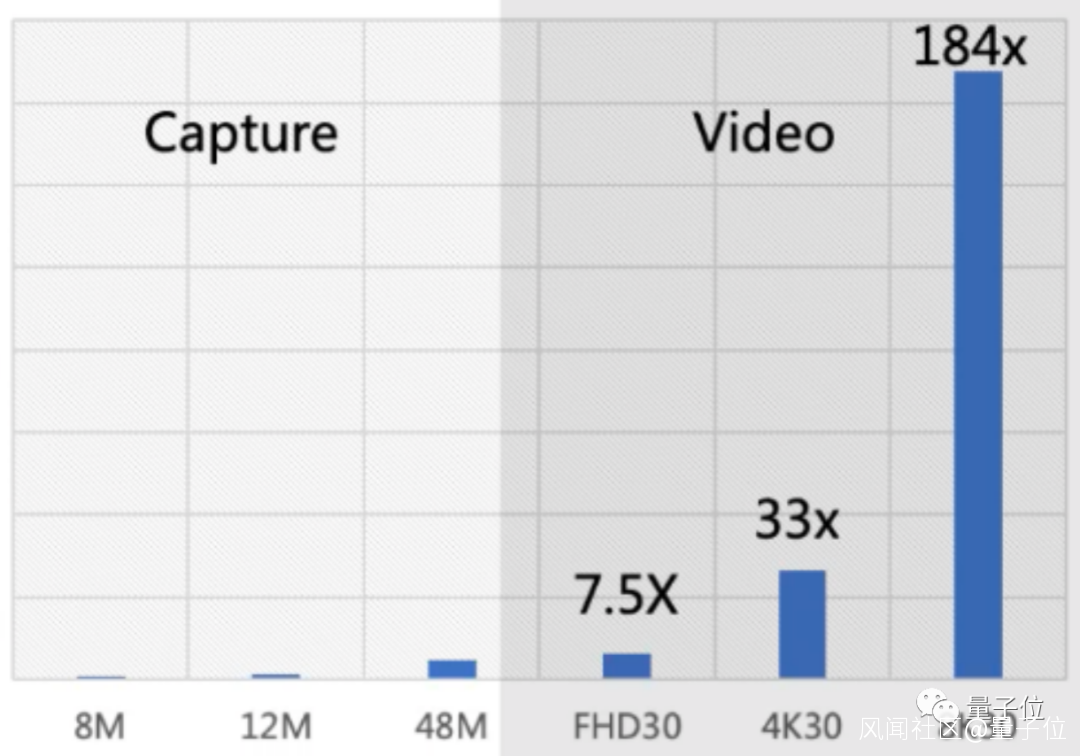

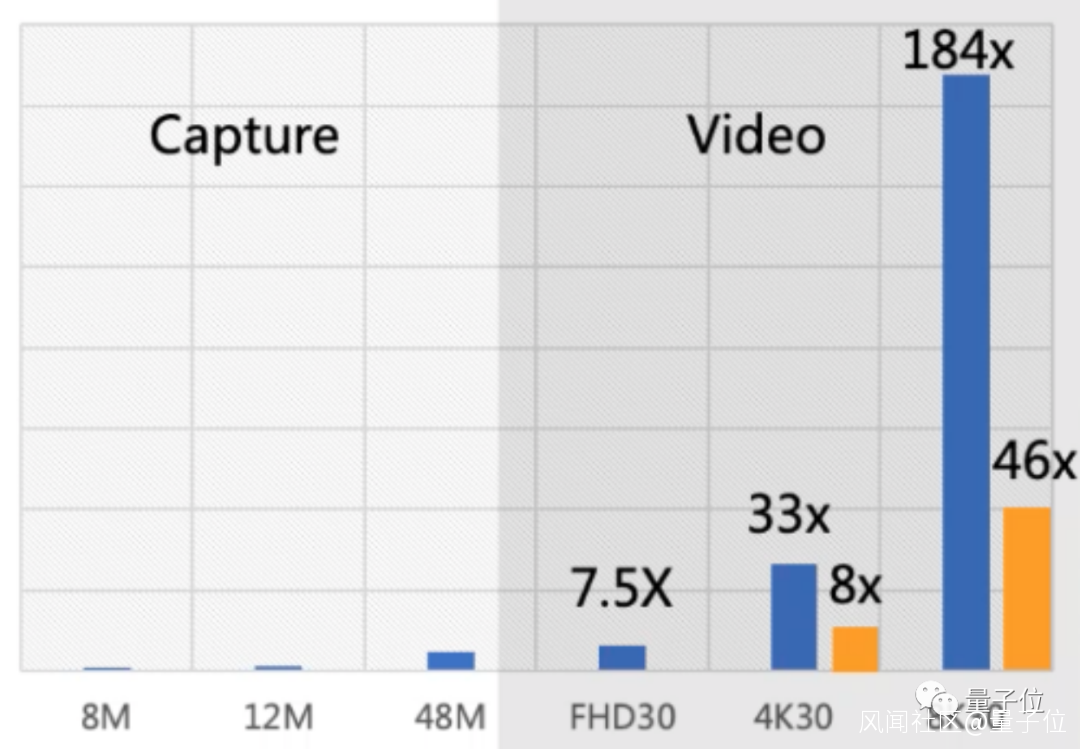

**△**4K30幀視頻(約800多萬像素/幀)需要的算力是800萬照片的33倍

針對這幾點,聯發科對應地研發了幾種算法,來“配合”語義分割算法打出組合拳。

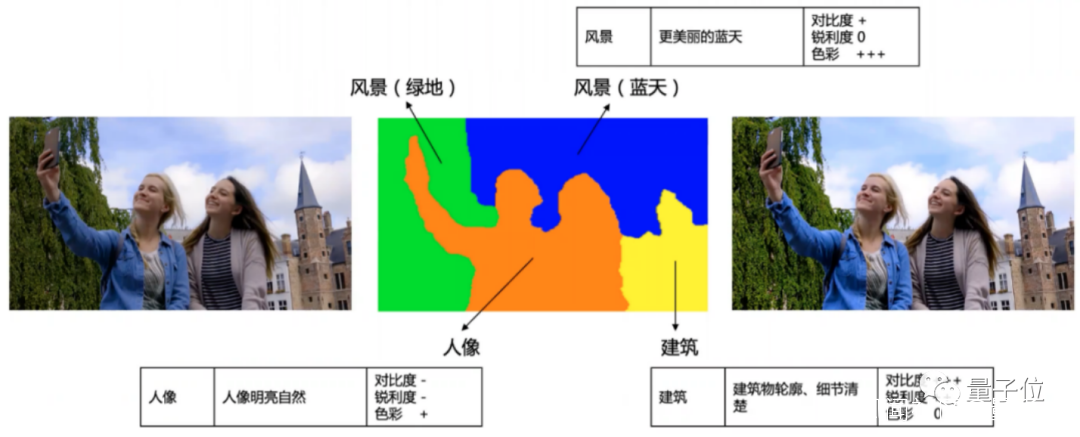

首先,結合場景識別優化語義分割算法,使得AI不僅能區分前景(如人像、動物等)和背景,還能進一步識別不同種類的背景,如建築、天空、綠地、植物和水池等。

然後,就是AI區域畫質增強技術(AI Region PQ)了。

將照片分割成前景和不同區域的背景後,AI會針對每個區域的物體特性,分析並選取最合適的優化算法,“拆分式”地優化照片不同區域的效果。

例如針對藍天的優化,基於色彩增強算法讓天色看起來更明亮;針對建築物的優化,則主要在對比度和鋭利度上,如結合超分辨率等算法,讓建築物的窗户等細節看起來更清晰……

最後,還能基於語義分割算法降低視頻的算力,實現精確對焦。

此前,針對視頻的實時追焦算法往往是進行逐幀追焦,通過計算幀間差異來調整清晰度,這樣不僅耗費算力,甚至可能降低視頻的流暢度。

相比之下,採用語義分割算法區分出前景後,只需要針對前景區域進行偵測和追焦就行,背景則不需要再耗費更多算力去進行優化,就省去了不少算力。

這樣一來,不僅照片和視頻都實現了實時算法優化,甚至相比原來還節省了一大波算力,例如4K30幀視頻和8K30幀視頻拍攝所需算力,都降低到了原來的1/4。

同時,聯發科也針對AI算法在硬件處理上進行了對應的優化,包括提升APU的能效等,進一步降低AI景深畫質增強技術在手機上消耗的算力。

事實上,這也並非聯發科第一次針對手機AI技術進行佈局了。

用AI突破計算攝影瓶頸

從2018年開始,聯發科開始將計算攝影作為手機芯片算法的研發重點。

當年10月份推出的Helio P70處理器,着重提升了多幀降噪 (MFNR)方面的性能,即通過一次性拍攝多張照片,隨後通過計算每個位置對應的多層像素均值進行輸出,提升照片的清晰度。

這其中涉及大量算法的優化,尤其是拍攝多張照片並進行處理的速度,當年Helio P70針對多幀降噪算法進行優化後提升了約20%的性能。

然而,在計算攝影研發過程中,團隊在計算機視覺方面遇到了一些算法優化極限。

適逢更多AI算法在手機端優化落地,計算攝影團隊的重心也逐漸轉到AI技術研發上。

一方面是芯片上有關AI算力的提升。

最早從2018年Helio P90強調提升AI算力速度、同時推出包含剪枝在內一系列優化算法的AI計算平台NeuroPilot v2.0,到2020年的天璣1000+的MiraVision畫質引擎和APU3.0;

再到2021年至今強調的“每瓦有效算力”指標,即APU長時間運行的功率大致在1W左右,聯發科在這方面強調的始終是“開源節流”,優化AI的能耗。

也就是説,儘可能在不增加功耗的情況下,提升手機上AI算法運行的效果。

另一方面則是不斷改進AI算法的性能。

而從整體研究範圍來看,聯發科這幾年也一直在提升對於AI的重視程度,包括進行貝葉斯優化、元學習相關的機器學習研究,相關論文發表在NeurIPS、ICLR等頂會上。

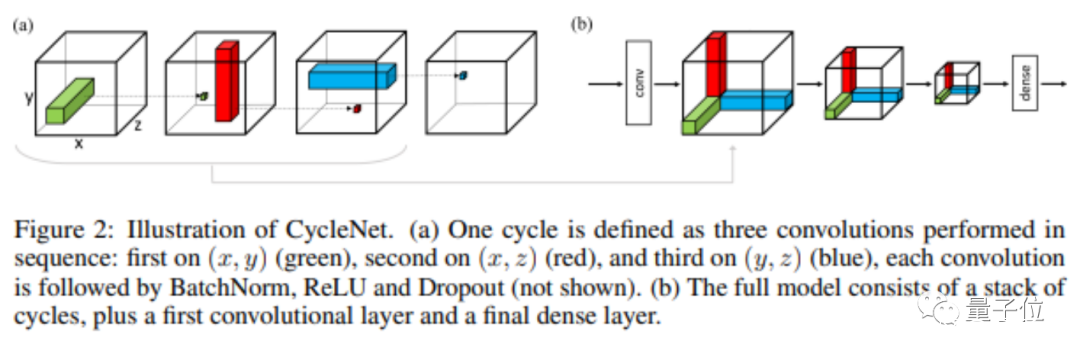

這其中就有與影像處理相關的研究,例如提出了一個名為CycleNet的框架,旨在提升AI識別拍攝場景中較深物體(即相對鏡頭的距離較遠)的能力。

具體來説,CycleNet借鑑了“神經元會和處理相同圖像中具有相同特徵物體的神經元產生聯繫”等一系列生物神經元處理信息的特點,來設計整體的框架邏輯,提升AI在處理較小較模糊的目標時整體的識別準確率。

至於我們多久會在手機上見到這樣的AI技術?還得看聯發科的速度了(doge)

還有哪些手機技能待點亮?

隨着AI落地的技術越來越多,手機應用似乎也在進一步逼近想象力的極限。

甚至有一種觀點認為,目前能提升手機性能和創造力的就只有AI技術了。

然而事實真是如此嗎?

即便這幾年手機功能需求逐漸趨於一致,人們的關注度也並不止放在手機AI技術上。

包括GPU、通信乃至導航等,同樣是大夥兒期待在手機上能有進一步提升的硬件設備“技能點”。

這種情況下,手機究竟還有哪些可待提升的功能空間?

如果仔細觀察這幾年芯片技術發展趨勢的話,會發現確實還有不少。

從聯發科在技術溝通會上透露的情況來看,芯片廠商針對手機遊戲性能提升的側重點仍然在移動光追上。

只不過相比於去年這一熱點概念的提出,今年移動光追已經逐漸成為手機上一個可以預見的功能性賣點,而且還會隨着技術的成熟普及到更多手機設備上。

同理還有移動GPU增效方案,也在與移動光追同步進行,目的是在增加圖像刷新率、分辨率和渲染複雜度的同時,保持芯片能效的優化,以實現軟硬件同步跟進的效果。

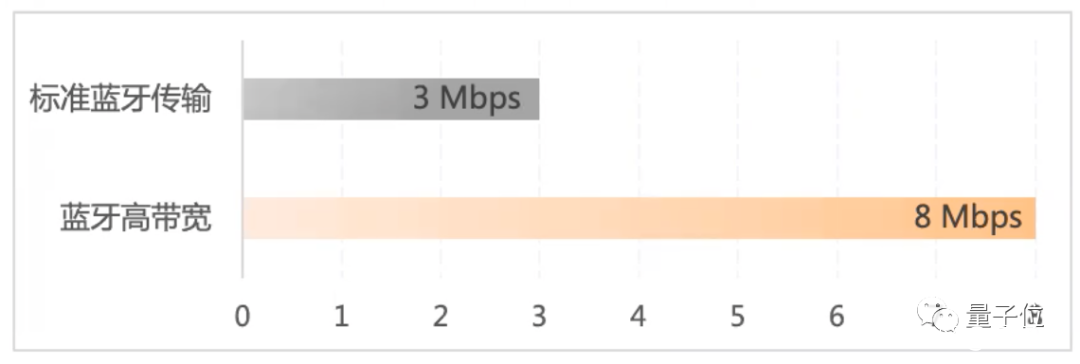

至於在通信技術方面,未來可預見的功能則包括5G新雙通、以及支持Wi-Fi 7、高保真藍牙音頻等。

其中,新雙通指在手機雙卡雙待的情況下,讓雙卡的信號徹底不互相影響的能力,即使用流量卡打遊戲時,主卡接電話也絲毫不受到影響。

隨着明年Wi-Fi 7標準的發佈,WiFi吞吐量、穩定性和時延還會有進一步的改善,到那時候手機上即時刷劇打遊戲的體驗也會再度提升。

至於高保真藍牙音頻這一方面,則主要是改進了音頻編解碼器和高帶寬的技術,讓音頻傳輸效率和音質進一步up。

最後則是高精度導航方面的技術了。

雖説隨着自動駕駛和V2X等技術發展火熱,如今車道級導航已經是車機標配。

但在不用車或是車內手機導航時,除了室內這種衞星信號無法觸達的場所,高樓大廈林立的區域也同樣需要用到手機高精度導航技術。

而隨着聯發科MPE(MEMS-sensor Positioning Engine)融合技術的發展,結合傳感器(陀螺儀、加速度計等)+全球衞星導航系統的導航技術也將應用到手機上,極大增加室內定位和弱信號區域的導航精度。

年底下一代天璣旗艦芯片又要發佈了,據網傳型號是天璣9200,你最期待什麼功能出現在上面?