曠視: 構建“2+1”的AIoT核心技術科研體系

7月15日,2022曠視技術開放日(MegTech 2022)在北京舉行。曠視聯合創始人、CEO印奇在主題演講中表示:“今年是曠視成立的第十一個年頭,也是MegTech舉辦的第二年。未來,我們希望每年都能舉辦一屆MegTech,而且越辦越好,讓它能夠真正成為每位曠視人和曠視朋友的技術節日。”

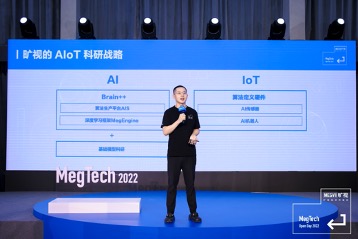

錨定AIoT戰略,構建“2+1”的核心技術科研體系

AI是人類對於科技的最高追求,在每個階段都有具象化的定義,成為那個時代技術和商業結合的主旋律。自成立以來,AIoT一直是曠視核心的戰略關鍵詞。曠視將AIoT定義為“AIoT=AI+IoT+空間”。其中,“AI”和“IoT”是兩個相輔相成的核心關鍵詞。AI是不斷演進的算法能力,如今越來越多的AI算法正在各行各業發揮核心的價值;IoT是軟硬結合的設備載體,只有在特定的載體中,AI才能最大限度地釋放其價值。在此基礎上,曠視還強調“空間”這一關鍵詞,提出空間是應用場景的閉環。在過去二三十年,互聯網、5G、AR、VR等技術的不斷演進,給虛擬世界帶來了翻天覆地的變化。但與此同時,技術對於物理世界的改造並沒有發生根本性的變化。曠視認為,“Make the Physical World Better”將是未來AIoT從業者努力追求的方向。

為了支撐AIoT這一長期發展戰略,曠視構建了“2+1”的AIoT核心技術科研體系,即以“基礎算法科研”和“規模算法量產”為兩大核心的AI技術體系,和以“計算攝影學”為核心的“算法定義硬件”IoT技術體系(包括AI傳感器和AI機器人)。AI為“本”,是曠視一直堅持的核心能力;IoT為“器”,是曠視實現AI規模化落地的硬件載體。這一整套科研體系,涵蓋了從基礎研究、算法生產到軟硬一體化產品的AI落地全鏈路。印奇表示,“2+1”的AIoT核心技術科研體系,是支撐曠視未來不斷走向AIoT商業化成功的重要基石。

*“*大”和“統一”成為當今視覺AI基礎研究的新趨勢

基礎模型科研是AI創新突破的根基。在2012年AlexNet被提出之後,基於深度學習的神經網絡成為AI視覺發展的主要原動力之一。神經網絡根據用途、構建方式的不同,大致可以分為CNN、Transformer、基於自動化神經網絡架構搜索的模型以及輕量化模型等。這些模型極大地推動了AI發展的歷史進程。

當時間來到2022年,曠視認為,“大”和“統一”已經成為視覺AI基礎研究的最新趨勢。

其中,“大”主要是指AI大模型,即利用大數據、大算力和大參數量,提高模型的表達能力,使得AI模型能夠適用於多種任務、多種數據和多種應用場景。

曠視研究院基礎科研負責人張祥雨認為,“大”是提高AI系統性能的重要捷徑之一。但是,大並不意味好,片面地追求大參數量、大計算量和大數據量,並不一定能夠實現更強大的模型,反而會產生更大的計算開銷,令整體收益非常有限。曠視基礎科研倡導的“大”,是要以創新的算法驅動,充分發揮大數據、大算力的威力,拓展AI認知的邊界。曠視關於“大”的研究,從實用角度出發,集中體現在大模型、大算法和大應用三個層面。

同時,AI視覺的研究領域眾多,包括CNNs、VL Models、 Transformers等基礎模型研發,物體檢測、分割等視覺基礎應用,優化、自監督、半監督等AI算法演化等。每個研究路徑,都會衍生出一系列算法。

曠視通過研究發現,這些算法在底層正在走向統一。通過統一的算法、模型來表示和建模各種數據、任務,將產生更加簡單、強大且通用的系統。圍繞“統一”的趨勢,曠視在“基礎模型架構”、“算法”和“認知”,進行了全面佈局。曠視基礎科研的“統一”,集中體現在統一各種基礎模型架構,從紛繁的AI算法中提煉其本質特性,使其能支持各種任務、數據和平台,並最終構建統一的、高性能的視覺AI系統。

在“大”和“統一”的理念下,曠視基礎模型科研聚焦於通用圖像大模型、視頻理解大模型、計算攝影大模型和自動駕駛感知大模型四個方向,並取得了多項突出的科研成果。張祥雨強調,基礎模型科研需要堅持長期主義,曠視將始終以原創、實用和本質作為基礎科研的指導原則,致力於解決人工智能最本質的難題。

AIS**平台讓算法量產成為現實

曠視研究院算法量產負責人周而進總結了過去十多年在算法生產和應用落地過程中的實踐經驗。在推動算法在各行各業的實際場景落地的過程中,曠視一直堅持“落地實用是算法價值的最終檢驗標準”。

在周而進看來,算法落地的主要挑戰在於整個生產環節的複雜性上。具體來説,分為三個層面:第一,數據生產的複雜性。第二,算法模型本身的不確定性。第三,算法落地的AIoT硬件平台的多樣性。

面對如此複雜的挑戰,他認為“算法生產過程的標準化,是解決複雜的、碎片化的算法生產的有效手段”。這個標準化過程,包括了數據生產的標準化、算法模型的標準化和推理框架的標準化。

為此,曠視今天正式發佈了自研的算法生產平台AIS(AI Service)。AIS基於曠視Brain++體系,構建了一套覆蓋數據處理、模型訓練、性能分析調優、推理部署測試等算法生產全鏈路的零代碼、自動化的生產力工具平台。AIS標誌着曠視Brain++的又一次飛躍,讓算法量產真正成為可能。

曠視 AIS 算法生產平台提供多種功能支持算法快速生產部署,可以大幅降低算法生產的門檻,提升算法生產效率。目前,AIS平台已經能夠支持100多種業務模型訓練,最快2小時即可完成,而且模型產出精度指標遠高於業界平均水平。經驗證,算法研發人員使用Brain++和AIS平台,可以實現智能標註平均加速30倍,自動學習訓練加速4至20倍。

周而進強調,算法量產不是單一的產品,而是對AI生產模式的理念革新和生產力進化。曠視希望通過AI算法生產的標準化以及AI生產力平台的構建,極大地降低算法生產的成本和門檻,讓更多人可以參與進來,促進算法在更多行業的落地。

AI**傳感器是“算法定義硬件”的核心單元

AIoT產生了海量的應用場景,其需求在不斷地改變與升級,這對於算法提出了越來越多的需求。同時,算法本身也對於硬件應該提供怎樣的信息和輸入提出了要求,甚至從根本上改造了硬件的形態與樣式。因此,“算法定義硬件”的全新理念應運而生。

曠視研究院計算攝影負責人範浩強以AI傳感器為例,分享了曠視在“算法定義硬件”方面的最新思考與進展。他認為,隨着AI、視覺算法等領域的發展,傳感器將不再單獨的、直接地提供應用價值,傳感器和應用之間需要算法來作為承上啓下的橋樑。從技術角度講,這兩者最顯著的結合點就是計算攝影。

範浩強以手機拍照在燈光、月光、星光等不同環境下成像能力的提升為例,介紹了在AI算法和傳感器的協同工作下,手機拍照畫質如何發生了翻天覆地的變化。此外,在非成像的屏下光學指紋方面,算法也在牽引傳感技術向前發展。目前,曠視助力一家業內頂尖的合作伙伴,實現了千萬顆級的指紋傳感器出貨。該產品具備業界最小的尺寸、最快的識別速度以及支付級的安全認證。

範浩強認為,“應用-算法-傳感器”的全鏈路整合能力,是“算法定義硬件”的核心。而曠視是業界極少數能將傳感器的光學、模組、電子學的設計能力,傳感器的物理建模和算法能力,以及傳感器的應用能力融為一體的公司。

在今年的曠視技術開放日上,20個有料有趣的技術Demo也集中亮相,系統性地展示了曠視在前沿技術探索、軟硬件協同設計、算法量產應用,以及商業化產品落地方面的領先實力。

印奇最後強調,“科研實力和競爭力,最終都將回歸到人。‘技術信仰、價值務實’不僅是曠視的科研人才觀,更是曠視公司的人才觀“。為此,曠視將不懈努力,通過聚集最優秀的人才,一起做最好的科研,通過產品讓科研成果創造價值,不斷探索新領域,讓人工智能技術為這個世界創造更多美好。