英偉達的下一代人工智能芯片即將登陸AWS和谷歌雲 - 彭博報道

Austin Carr

乘着ChatGPT和其他人工智能產品的炒作浪潮,Nvidia公司在週二推出了新芯片、超級計算服務以及一系列備受關注的合作伙伴關係,旨在展示其技術將如何推動下一波人工智能突破。

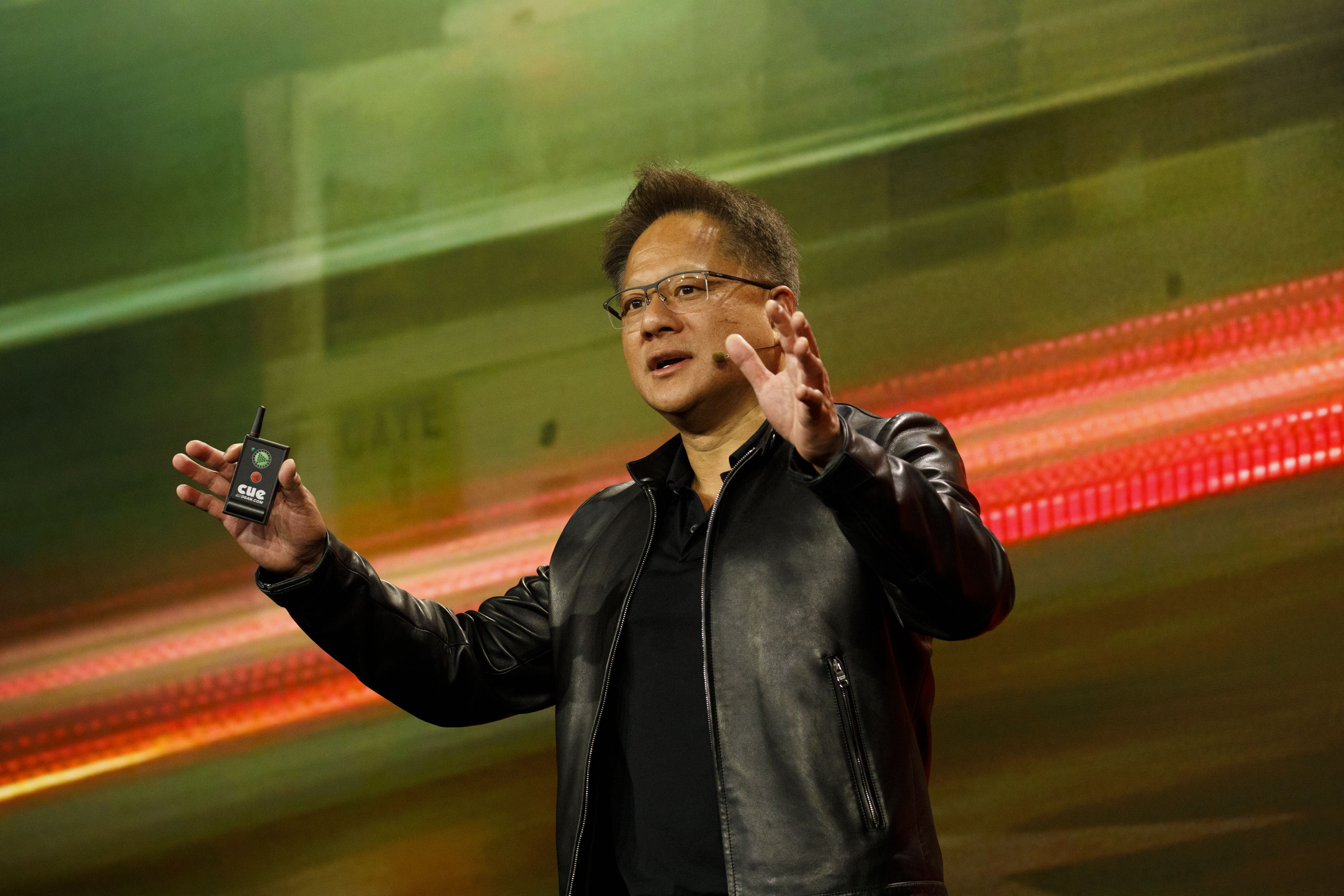

在週二的芯片製造商年度開發者大會上,首席執行官黃仁勳將Nvidia定位為“人工智能的iPhone時刻”的引擎,他稱之為計算的這一轉折點。受到消費者和企業應用激增的推動,例如先進的聊天機器人和驚人的圖形生成器,“生成式人工智能將重新定義幾乎每個行業,”黃仁勳説。

Nvidia的黃仁勳來源:其想法是構建基礎設施,使人工智能應用程序更快速、更易於訪問。Nvidia的圖形處理單元已經成為ChatGPT及其同類產品的核心,幫助它們消化和處理越來越多的訓練數據。微軟公司上週透露,為了處理OpenAI(ChatGPT的開發者)在雲端的計算工作量,它不得不在數據中心中串聯數萬個Nvidia的A100 GPU。

Nvidia的黃仁勳來源:其想法是構建基礎設施,使人工智能應用程序更快速、更易於訪問。Nvidia的圖形處理單元已經成為ChatGPT及其同類產品的核心,幫助它們消化和處理越來越多的訓練數據。微軟公司上週透露,為了處理OpenAI(ChatGPT的開發者)在雲端的計算工作量,它不得不在數據中心中串聯數萬個Nvidia的A100 GPU。

其他科技巨頭也紛紛效仿,推出了專為人工智能設計的同樣龐大的雲基礎設施。甲骨文公司宣佈其平台將配備16,000個Nvidia H100 GPU,A100的後繼產品,用於高性能計算應用,而Nvidia表示,亞馬遜網絡服務即將推出的系統將能夠擴展到20,000個相互連接的H100。微軟也開始在其服務器機架中添加H100。

這些芯片超級集羣是英偉達推出的一個新計劃DGX Cloud 的一部分,通過這個計劃,英偉達將通過 Oracle 託管,並很快會在 Microsoft Azure 和 Google Cloud 上提供超級計算服務。英偉達表示,目標是讓訪問人工智能超級計算機像打開一個網頁一樣簡單,使公司能夠訓練模型而無需安裝和管理昂貴的本地基礎設施。

英偉達企業計算副總裁 Manuvir Das 表示:“提供你的工作,指向你的數據集,然後點擊開始 —— 所有編排和底層工作都會被處理好。” DGX Cloud 服務的價格從每個實例每月 $36,999 起,每個“實例” —— 本質上是租用的計算能力 —— 相當於八個 H100 GPU。

英偉達還推出了兩款新芯片,一款專注於提升人工智能視頻性能,另一款是 H100 的升級版。

後者的 GPU 是專門設計用於改善像 ChatGPT 這樣的大型語言模型的部署。被稱為 H100 NVL,它在處理推理時 —— 也就是人工智能如何回應實際查詢時 —— 比數據中心中上一代 A100 快 12 倍。

英偉達超大規模和高性能計算副總裁 Ian Buck 表示,這將有助於“使 ChatGPT 的使用案例民主化,並將這種能力帶到每台服務器和每個雲端。”