這次是真不得了,又一波人工智能熱潮來了,我解釋下技術背景_風聞

陈经-亚洲视觉科技研发总监-02-08 09:13

這次是真不得了,又一波人工智能熱潮來了,我解釋下技術背景

1. 用專業的話説,牛逼的聊天機器人叫“大型語言模型”(LLM, Large Language Model)。技術關鍵是谷歌2017年引入的Transformer模型,搞機器翻譯,再語言模型、聊天機器人。

2. 上一波人工智能突破主要是圖像識別領域的“深度學習”(DL,Deep Learning)引領的,AlphaGo就是將棋盤當作圖像輸入。

3.

人們一度覺得“強化學習”(RL,Reinforcement Learning)以及“對抗生成網絡”(GAN,Generative

Adversarial

Network)很厲害。幾個模型反覆對抗訓練一起進化,自己生成學習樣例,AlphaGo的升級版本AlphaZero就是用了這兩個技術,厲害多了。

3.

有點意外的是,實際大突破到出圈的是LLM。關鍵是:“Transformer模型是一種具有注意力機制的深度學習模型,可以用來解決自然語言處理(NLP)問題。它使用注意力技術來聚焦模型中每個符號的輸入序列,從而可以捕捉句子中詞語之間的關係,而無需顯式地定義特徵或構建特徵提取器。此外,Transformer模型利用並行化,避免了傳統序列模型(如遞歸神經網絡)時需要等待前一步執行結束才能開始新一步的等待時間,提高了計算速度。”

4.

上面這段是chatGPT介紹的LLM技術關鍵:Transformer模型(這類常見概念介紹它不忽悠)。意思是説,Transformer訓練和計算有利於並行加速,這樣可以引入幾百億個參數的大模型。以前的語言模型,如“循環神經網絡”(RNN,Recurrent

Neural

Network),參數不能太多,訓練樣本也多不了,就是chatGPT説的,“需要等待前一步執行結束才能開始新一步”,RNN是將推理結果當作下一步推理的輸入(這就是“循環”)。不方便並行,訓練就慢,大模型訓練需要的時間太長,沒法用。

5. 2020年這樣做出來的GPT-3很厲害,幾百億個參數,整個互聯網素材送去訓練,震撼了業界。但是沒出圈,因為很專業,不懂的人不會用。

6.

2022年11月30日上線後沒多久,chatGPT就火出圈了,關鍵就是加上了聊天人工優化,算是GPT-3.5。原先GPT-3肚裏有大量乾貨,但是理解人的對話還有點困難,懂行的才知道怎麼引導它輸出有效內容。OpenAI就大量上人工測試,不對勁的反饋訓練修正,用有點意外的方式解決了問題(業界習氣是讓機器幹活,人工操作少搞)。

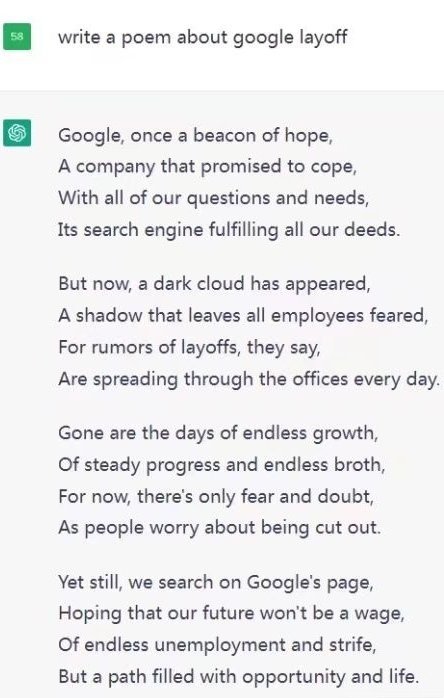

7. 威力在於,這點搜索引擎之外,第二個把整個互聯網知識都包進去的軟件產品。而且它的交流和輸出要友好多了,當然就很受歡迎,比搜索引擎確實好,而搜索已經引發了學習革命、互聯網革命。還有很多重大意義等待發掘。谷歌員工讓它寫了一首裁員的詩,是真的有威脅。