人工智能快速發展趨勢下,中國該如何應對?之一_風聞

蓝海大脑GPU服务器-水冷服务器、大数据一体机、图数据一体机03-23 13:28

人工智能 | 深度學習 | GPT-4

文心一言 | 機器學習 | ChatGPT

近日,隨着ChatGPT-4和百度的文心一言的出台,人工智能技術得到迅猛發展。人工智能(AI)是一種模擬人類智能的技術,它可以通過學習和自我改進來執行各種任務。ChatGPT是一種基於AI的聊天機器人,它可以與人類進行自然語言交互,回答問題和提供信息。

人工智能是通過模擬人類大腦的方式來工作的。它使用算法和數據來學習和自我改進,以便更好地執行任務。人工智能可以分為弱人工智能和強人工智能。弱人工智能是指只能執行特定任務的AI,例如語音識別或圖像識別。強人工智能是指可以像人類一樣思考和決策的AI。

2023年政府工作報告指出“過去五年極不尋常、極不平凡,我們經受了世界變局加快演變、新冠疫情衝擊、國內經濟下行等多重考驗,經濟社會發展取得舉世矚目的重大成就。”聚焦到科技領域,“全社會研發經費投入強度從2.1%提高到2.5%以上,科技進步貢獻率提高到60%以上。科技創新成果豐碩,人工智能領域的創新成果也不斷湧現。”

縱覽人工智能產業近年發展,雖然一定程度上突破了深度學習等各類算法革新、技術產品化落地、應用場景打磨、市場教育等難點;但如今也仍需致力解決可信、業務持續、盈利、部署的投資回報率等商業化卡點。

聚焦於2022年,這一歷史上極為重要一年中我國AI產業參與者的特徵表現、探討AI產業在我國經濟發展中的價值與地位、洞察各技術賽道參與者的發展路徑與產業進階突破點。

人工智能產業發展環境演變

一、人工智能參與社會建設的千行百業——價值性、通用性、效率化為產業發展戰略方向

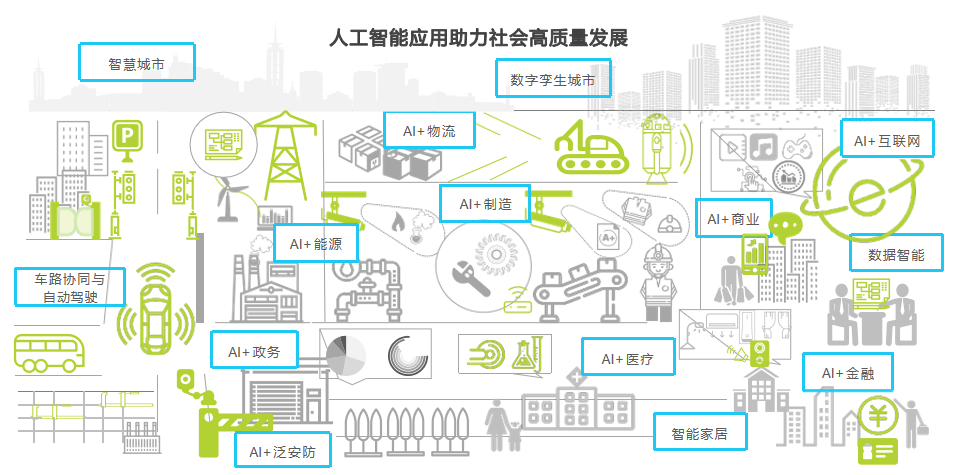

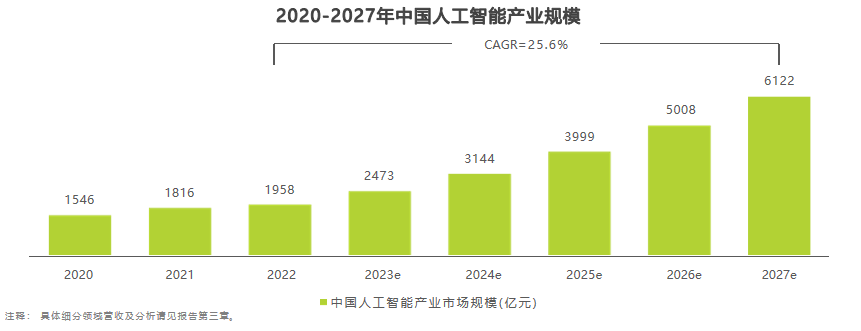

人工智能已成為推動產業發展的主流趨勢,其產品形態和應用邊界不斷拓寬,包括軟件服務、雲服務、硬件基礎設施等形式,應用場景涵蓋消費、製造業、互聯網、金融、元宇宙和數字孿生等領域。據艾瑞預測,到2022年,我國人工智能產業規模將達到1958億元,同時,人工智能產學研界在通用大模型、行業大模型等方向上取得了一定突破,促進技術通用性和效率化生產。AI技術的商業價值塑造、通用性提升和效率化應用是其助力產業發展、社會進步和自身造血的關鍵。

二、企業積極部署AI戰略以實現業務增長——對AI應用的比率及數量持續走高; AI提升營收能力進步

縱觀近五年來的AI技術商業落地發展脈絡,產品及服務提供商圍繞技術深耕、場景創新、商業價值創造、精細化服務不斷努力;需求側企業也在從單點試驗、數據積累到戰略改革的發展路線上,與AI技術逐漸深度綁定。AI成為企業數字化、智能化改革的重要抓手,也是各行業領軍企業打造營收護城河的重要方向。

麥肯錫2022年對企業應用AI技術的調研表明:相較於2017年的20%,2022年企業至少在一個業務領域採用AI技術的比率增加了一倍多,達到50%;應用的AI產品數量也從2018年的平均1.9個增加到2022年的3.8個。除了應用數量上的提升,AI產生的商業價值也不斷增長,企業部署AI的動力顯著。

埃森哲商業研究院針對中國250家領先企業的調研顯示,2018-2021年,企業營收中“由AI推動的份額”平均增加了一倍,預計到2024年將進一步增加至36%。落地AI應用對企業業務運營的商業價值與戰略意義越來越明確。

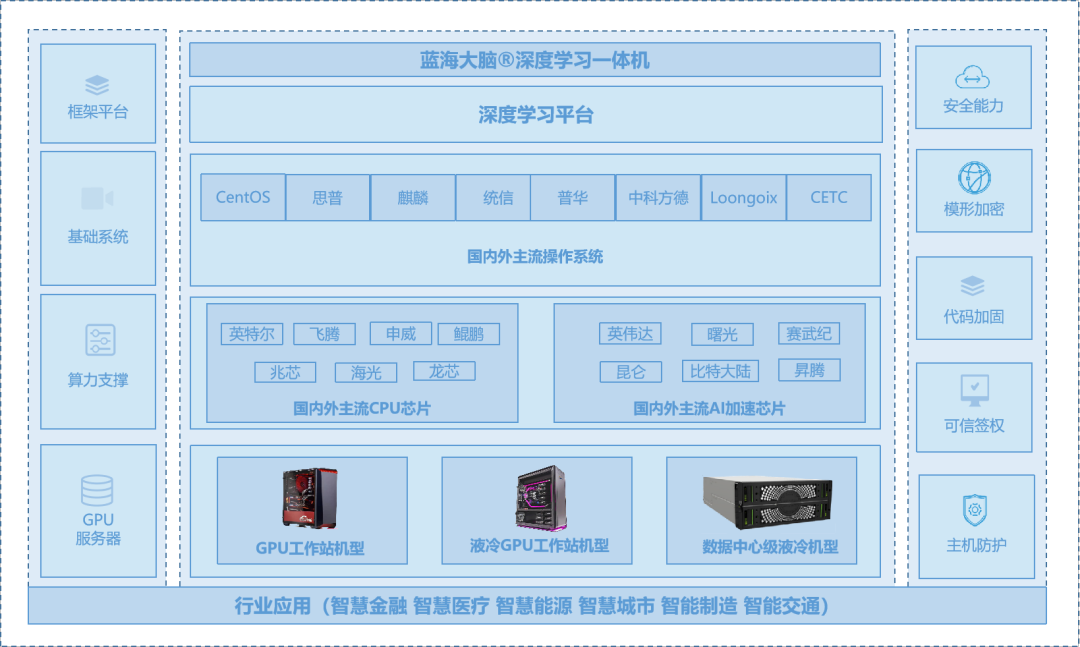

三、城市算腦建設推動區域發展與產業升級——各地加速佈局區域智算中心,夯實AI算力基礎設施

基於對支撐AI應用及研發的智能算力需求擴大、以及全國算力樞紐一體化和“東數西算”的工程建設方向。近兩年來,各地對人工智能計算/超算中心(智算中心)的關注度和投資增多。智算中心是指基於最新AI理論,採用領先的AI計算架構,提供AI應用所需算力服務、數據服務和算法服務的公共算力新型基礎設施。目前,我國有超過30個城市建設或提出建設智算中心,其中已有近10個城市的智算中心投入運營,為當地各行業領域提供算力支撐。智算中心建設對區域經濟發展和產業升級有明顯推動作用,同時可提高城市治理智能化水平和城市競爭力。從政府投資角度看,智算中心產業發展尚處於初期階段,建設、運營、應用推廣與生態建設、節能環保要求等投入較大,需結合地方財政能力合理評估,根據實際需求適度超前部署機櫃。

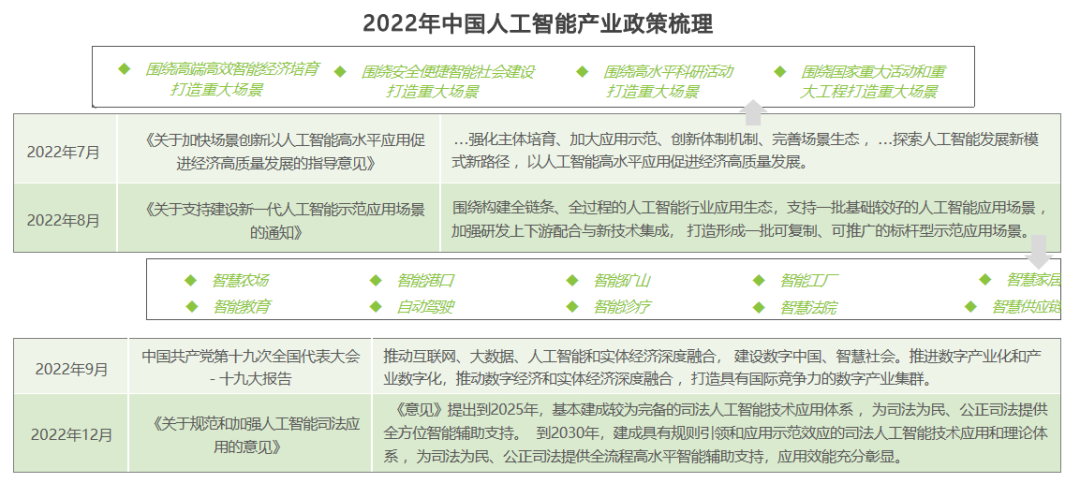

四、政策引導解決AI重大應用和產業化問題——着力打造人工智能重大場景,形成可複製推廣的標杆應用

儘管我國在數據、算力、算法及模型的基礎層資源與研究積累日益豐富,為開展下游人工智能場景創新應用打下了堅實基礎,但在應用場景上仍存在“對場景創新認識不到位,重大場景系統設計不足,場景機會開放程度不夠,場景創新生態不完善”等問題。為此,2022年,我國陸續出台一系列指導意見及通知,持續加強對人工智能場景創新工作的統籌指導,規範與加強人工智能應用建設,實現AI與實體產業經濟的深度融合。其中,政策引導是解決AI重大應用和產業化問題的重要手段之一。着力打造人工智能重大場景,形成可複製推廣的標杆應用,是政策引導的重要方向之一。通過政策引導,加強對人工智能場景創新工作的統籌指導,規範與加強人工智能應用建設,將有助於實現AI與實體產業經濟的深度融合。

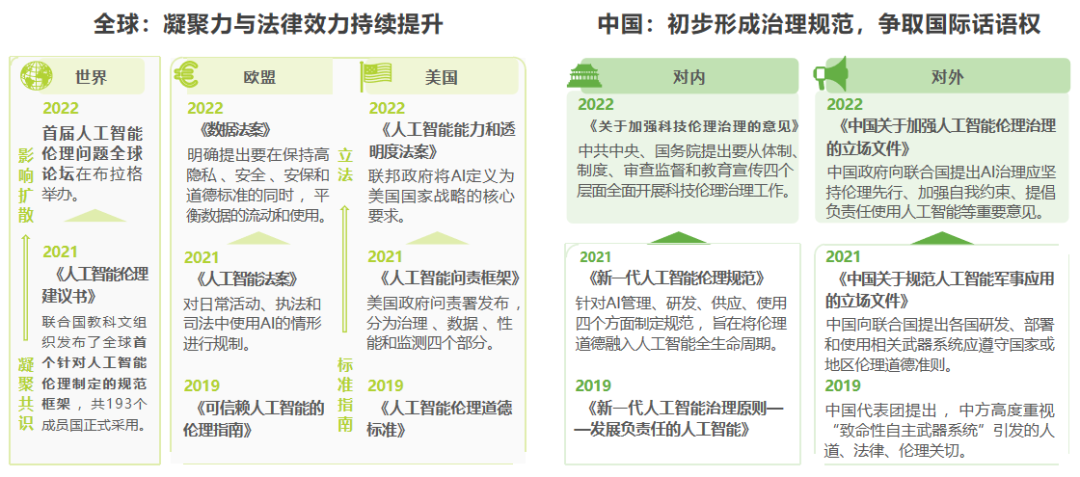

五、科技倫理治理持續引導AI “向善”——全球AI倫理治理邁入法治時代,我國積極倡導框架規範

隨着人工智能與社會產業的融合應用,其帶來的安全、法律和倫理方面的風險不容忽視。2022年,科技倫理治理的約束力和影響力持續提升。從全球範圍來看,主要發達國家和地區的人工智能倫理治理從政策建議正式進入法律範疇,相關立法逐步完善,國際組織也在凝聚共識的基礎上,啓動大規模深入研討。而在中國,在吸取發達國家治理經驗和思路的基礎上,2022年首次將人工智能倫理治理上升到國家政策層面,提出科技倫理治理的原則和行動方案,具體治理舉措將會不斷細化和完善。同時,我國也在科技倫理問題上通過國際組織積極表態,增強國際影響力和話語權,防止在科技倫理問題上陷入被動。

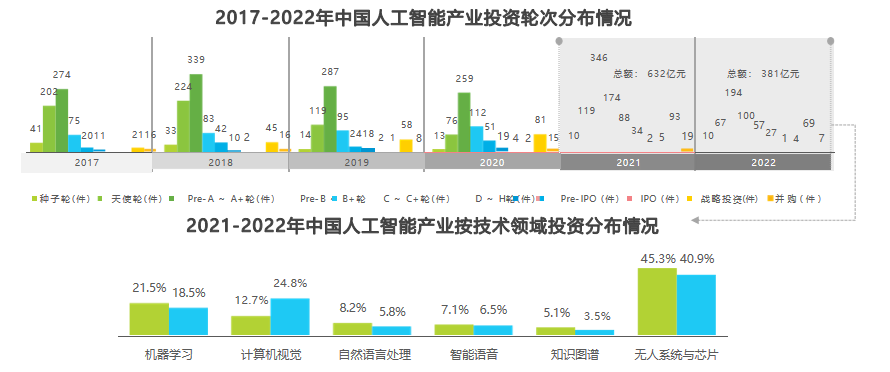

六、人工智能產業投資熱度仍在——融資向中後期過渡,視覺賽道上市浪潮湧動

人工智能產業一直是投資市場的熱門領域,而最近的數據顯示,這一趨勢仍在持續。統計數據顯示,Pre-A~A+輪人工智能產業創投輪次數量最多,但整體而言,Pre-B~B輪+及以後輪次的人工智能產業創投數量逐漸成長,資本流向穩定發展企業,融資逐漸向中後期過渡。此外,視覺賽道上市浪潮也在湧動,商湯科技、格靈深瞳、雲從科技、創新奇智等企業都已實現上市目標。雖然2022年我國人工智能產業資本市場投資金額整體縮水,但投資標的更加豐富,孵化出AIGC、元宇宙、虛擬數字人等新投資賽道,認知與決策智能類企業也吸引更多關注,智能機器人、自動駕駛兩類無人系統是融資的熱門賽道。

七、區域與獨角獸企業融資分佈特點——北上廣與江浙地帶融資密度高;獨角獸企業聚集於自動駕駛、醫療、工業、芯片賽道

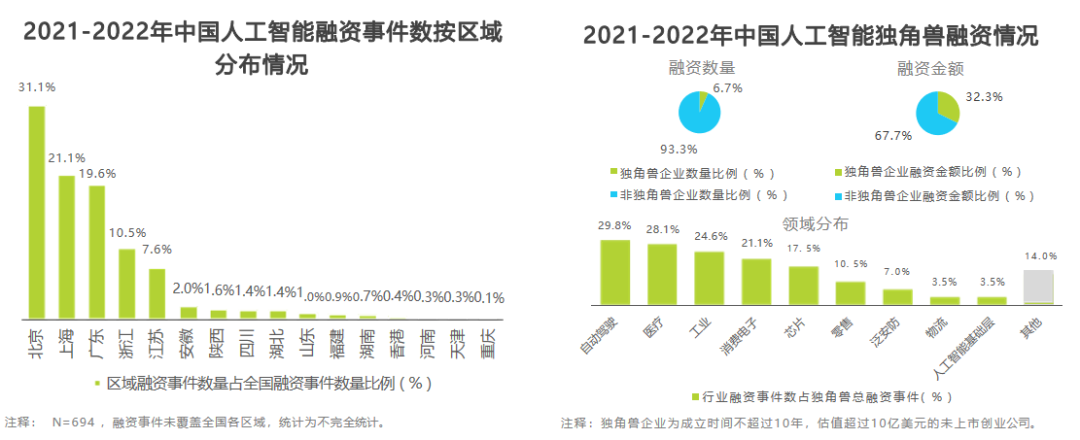

從區域分佈看,統計時間內融資事件集中分佈於北上廣、江浙地帶。北京的融資事件密度最高,融資事件數量佔全國的31.1%。除北上廣、江浙地帶以外區域融資密度較低且分散,相應融資事件數量佔全國不超過10%。這可能是因為北上廣、江浙地帶人工智能人才密集、具備產業園區進行產學研成果轉化、風投機構密佈等因素,為孵化創投項目提供了有利條件。

從獨角獸企業融資情況看,統計時間內獨角獸企業佔比6.7%,但對應的融資金額比例高達32.3%。獨角獸融資事件集中分佈於自動駕駛、醫療、工業、芯片行業賽道,分別孵化出L3及以上智能駕駛解決方案、AIDD藥物研發服務、工業機器人、雲端大規模訓練或端側推理芯片等產品或服務。隨着市場資金向獨角獸企業持續流入,AI產業未來或將逐步出現一批明星上市企業。

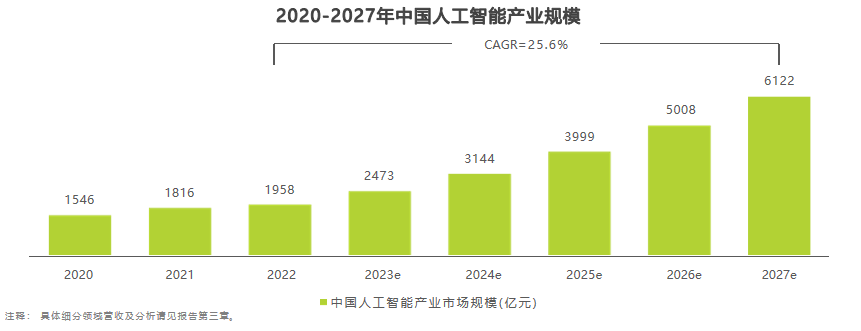

八、人工智能產業市場規模——2022年市場平穩向好,市場規模近2000億元

根據艾瑞的定義,我國人工智能產業規模涵蓋AI應用軟件、硬件及服務,主要包括AI芯片、智能機器人(商用)、AI基礎數據服務、面向AI的數據治理、計算機視覺、智能語音與人機交互、機器學習、知識圖譜和自然語言處理等核心產業。預計到2022年,中國人工智能產業規模將達到1958億元,年增長率為7.8%,整體平穩向好。2022年的業務增長主要依靠智算中心建設以及大模型訓練等應用需求拉動的AI芯片市場、無接觸服務需求拉動的智能機器人及對話式AI市場,除此之外的增長動力將在第三章詳細闡述。目前,中國大型企業基本都已在持續規劃投入實施人工智能項目,未來隨着中小型企業的普遍嘗試和大型企業的穩健部署,在AI成為數字經濟時代核心生產力的背景下,AI芯片、自動駕駛及車聯網視覺解決方案、智能機器人、智能製造、決策智能應用等細分領域增長強勁。預計到2027年,人工智能產業整體規模可達6122億元,2022-2027年的相關CAGR為25.6%。

人工智能的底層基礎

一、AI芯片

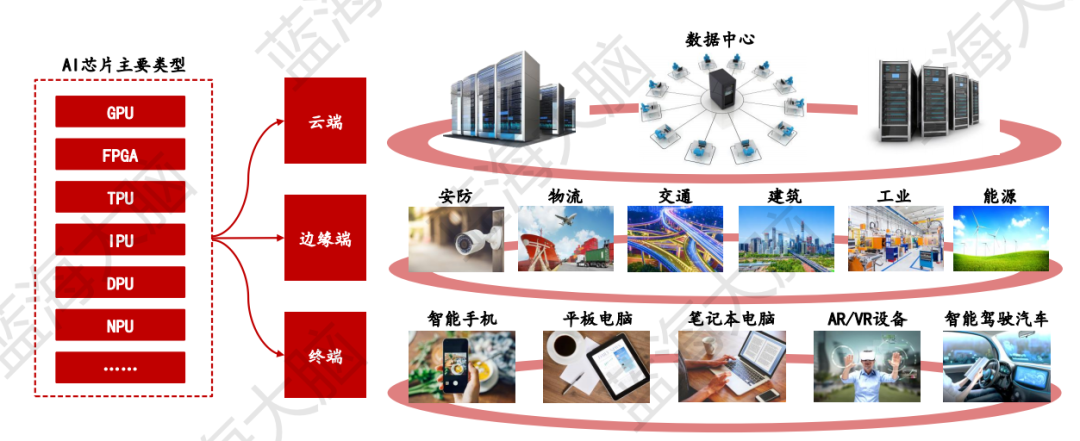

1、AI芯片針對機器學習算法設計開發,廣泛應用於雲、邊、端各類場景

AI芯片(AI Chip)是一種專門用於處理人工智能相關的計算任務的芯片。它的架構是專門為人工智能算法和應用進行優化的,能夠高效地處理大量結構化和非結構化數據。AI芯片能夠高效地支持視覺、語音、自然語言處理等智能處理任務。目前,AI芯片主要分為GPU、FPGA、TPU、IPU、DPU、NPU等類型。AI芯片廣泛應用於雲端、邊緣端、終端等各種場景。雲端AI芯片具有高性能特徵,終端AI芯片具有低功耗和高能效特性,而邊緣端AI芯片的性能介於雲端和終端之間。

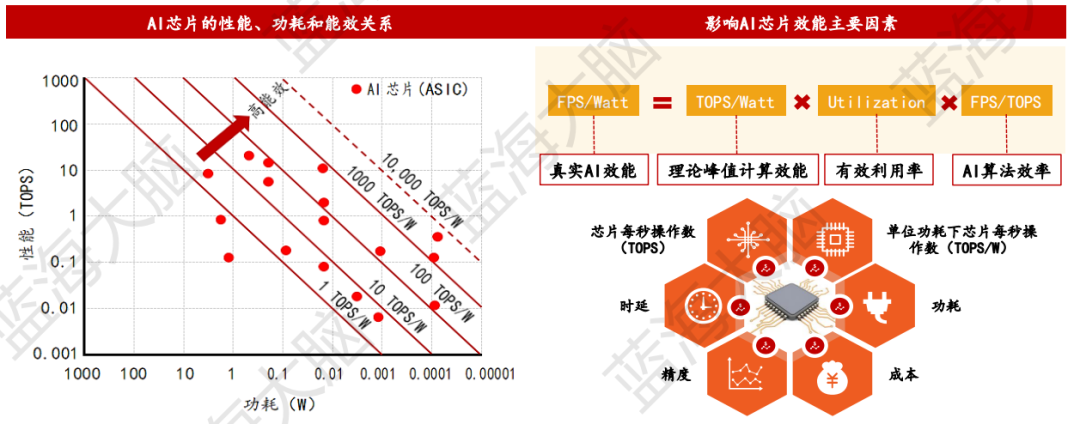

2、AI芯片性能指標評價評價AI芯片性能需重點關注TOPS/W、時延、功耗等相關指標

目前,評價AI芯片性能的指標主要包括TOPS、TOPS/W、時延、成本、功耗、可擴展性、精度、適用性、吞吐量和熱管理等。其中,TOPS/W是用於度量在1W功耗的情況下,芯片能進行多少萬億次操作的關鍵指標。近年來,MIT、Nvidia等研發人員開發了專門的芯片軟件評價工具,如Accelergy(評估芯片架構級能耗)和Timeloop(評估芯片運算執行情況),對於AI芯片的性能做出了系統、全面評價。此外,MLPerf是由來自學術界、研究實驗室和相關行業的AI領導者組成的聯盟,旨在“構建公平和有用的基準測試”,可用於衡量深度學習軟件框架、AI芯片和雲平台性能。

3、AI芯片:雲端場景數據中心

1)GPU具備矩陣和大規模並行計算優勢,適合數據中心場景

CPU是一種通用處理器,它由控制單元(負責指令讀取和指令譯碼)、存儲單元(包括CPU片內緩存和寄存器)以及運算單元(ALU約佔20%CPU空間)三個主要模塊組成。然而,由於成本、功耗、技術難度和算力瓶頸等問題的限制,目前還沒有出現適用於AI高算力要求的主流CPU產品。

相比之下,GPU是一種由大量核心組成的大規模並行計算架構,它具有較多的運算單元(ALU)和較少的緩存(cache),是專門為同時處理多重任務而設計的芯片。GPU擁有良好的矩陣計算能力和並行計算優勢,能夠滿足深度學習等AI算法的處理需求,因此成為主流雲端AI芯片。

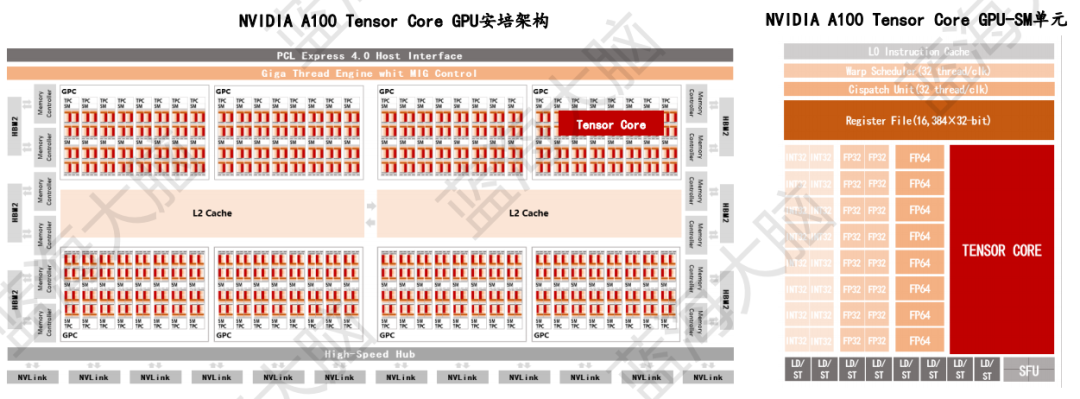

2)張量計算單元是GPU進行深度學習運算的核心組成部分

英偉達A100芯片是一種併發多核處理器,由多個SM單元(Streaming Multiprocessors,流式多處理器)構成。不同的SM單元共享L2 Cache存儲資源,以便進行數據訪問。該芯片採用安培架構,擁有128個SM核,其中SM結構是芯片架構升級的核心。此外,英偉達GPU架構中還設置了Tensor Core,這是專為深度學習矩陣運算設計的張量計算單元,也是英偉達GPU系列深度學習運算加速的核心。Tensor Core主要處理大型矩陣運算,執行一種專門的矩陣數學運算,適用於深度學習和某些類型的高性能計算。其功能是執行融合乘法和加法的運算,其中兩個4*4 FP16矩陣相乘,然後將結果添加到4*4 FP32或FP64矩陣中,最終輸出新的4*4 FP32或FP64矩陣。

4、邊緣端場景—AIoT。邊緣端集成AI芯片可以實現本地化數據的實時處理

AIoT是一種融合了人工智能和物聯網技術的新型智能化系統,它可以實現萬物智聯,涉及到安防、移動互聯網等多種場景。在智慧安防方面,由於終端攝像頭每天產生大量的視頻數據,若全部回傳到雲數據中心將會對網絡帶寬和數據中心資源造成極大佔用。為了解決這個問題,可以在終端加裝AI芯片,實現數據本地化實時處理,即僅將經過結構化處理、關鍵信息提取後帶有關鍵信息的數據回傳雲端,從而大大降低網絡傳輸帶寬壓力。目前,主流解決方案是在前端攝像頭設備內集成AI芯片,在邊緣端採用智能服務器級產品,後端在邊緣服務器中集成智能推理芯片。為了推動這項技術的發展,國內外企業正在加大對邊緣端AI視覺處理芯片的研發和投入,相關芯片產品如英偉達Jetson AGX Xavier、地平線旭日3、華為海思Hi3559A V100等。

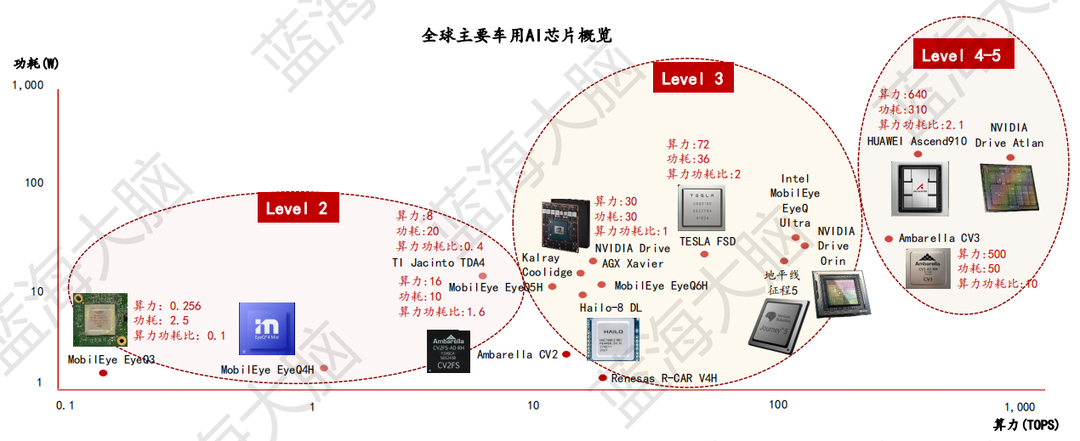

5、終端場景—智能駕駛。隨着智能駕駛等級的提高,技術不斷迭代促使車用AI芯片性能逐步增強

SAE(國際自動機工程師學會)將自動駕駛分為六個級別,從L0(非自動化)到L5(完全自動化)。每一級別需要強大的算力進行實時分析、處理大量數據和執行復雜的邏輯運算,對計算能力有着極高的要求。L1(駕駛員輔助)和L2(部分自動化)需要的計算能力相對較低,而L3(有條件自動化)需要約250TOPS的計算能力,L4(高度自動化)需要超過500TOPS,L5(全場景自動駕駛)需要超過1,000TOPS。隨着芯片設計和製造工藝的提高,車用AI芯片正朝着高算力、低功耗的方向發展。

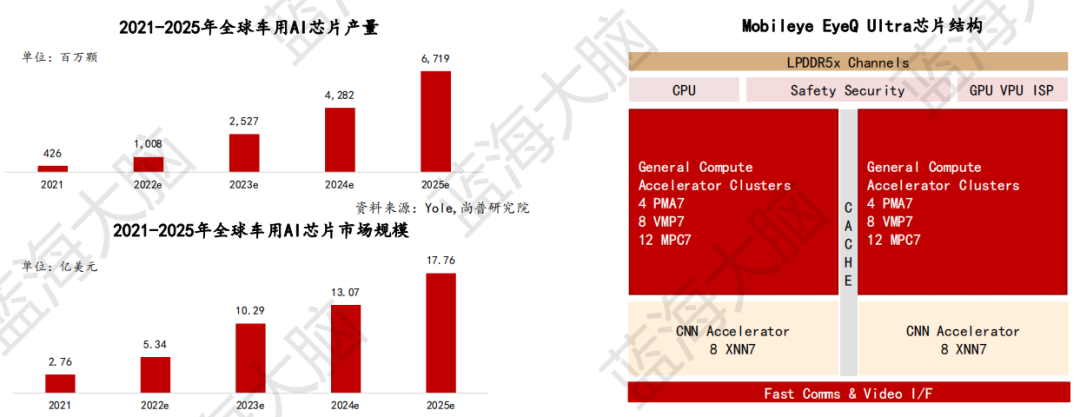

6、終端場景—智能駕駛。預計到2025年,全球車用AI芯片市場規模將突破17億美元

隨着汽車控制方式逐漸由機械式轉向電子式,每輛汽車對車用AI芯片需求提升,帶動車用AI芯片長期發展。據市場研究機構Yole預測,到2025年,全球車用AI芯片產量將達到67.19億顆,市場規模將達到17.76億美元,年複合增速分別達到99.28%和59.27%。此外,車用AI芯片逐漸往高能效方向發展。例如,英特爾計劃於2022年推出EyeQ Ultra自動駕駛汽車芯片,該芯片基於經過驗證的Mobileye EyeQ架構而打造,含有8個PMA、16個VMP、24個MPC、2個CNN Accelerator視覺處理單元(VPU),通過優化算力和效能以達到176TOPS,可滿足L4自動駕駛場景。該產品將於2023年底供貨,預計在2025年全面實現車規級量產。

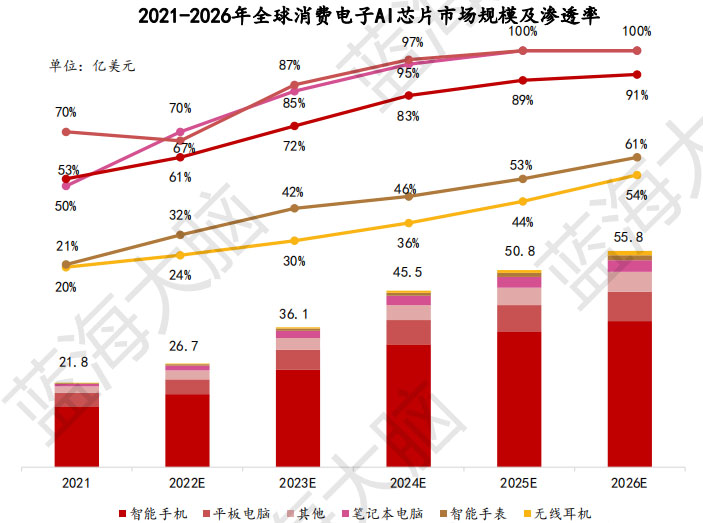

7、終端場景—消費電子。2026年全球消費電子AI芯片市場規模將突破55億美元

AI芯片在圖像識別、語音識別和快速建立用户畫像等方面具有重要作用。根 據Yole預測,2026年全球消費電子AI芯片市場規模將達到55.8億美元,其中筆記本電腦、平板電腦和智能手機AI芯片滲透率將分別達到100%、100%和91%, 未來全球消費電子AI芯片市場規模和滲透率呈現逐步增長態勢。

二、深度學習開源框架

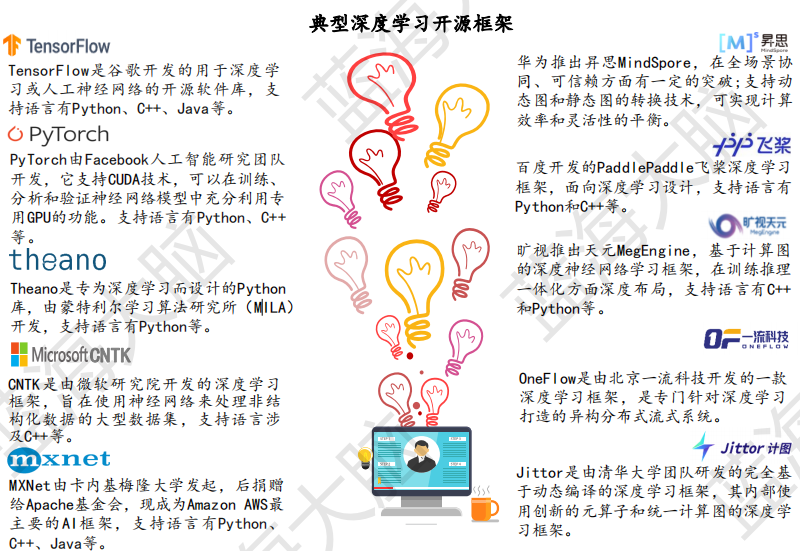

深度學習開源框架是一種標準接口、特性庫和工具包,用於設計、訓練和驗證AI算法模型。它們集成了數據調用、算法封裝和計算資源的使用,是AI開發的重要工具。目前,國際上廣泛使用的深度學習開源框架包括Google TensorFlow、Facebook PyTorch、Amazon MXNet和微軟CNTK等。在中國,也有一些深度學習開源框架,如百度PaddlePaddle、華為MindSpore等。這些框架已經初步應用於工業、服務業等場景,服務200餘萬開發者。

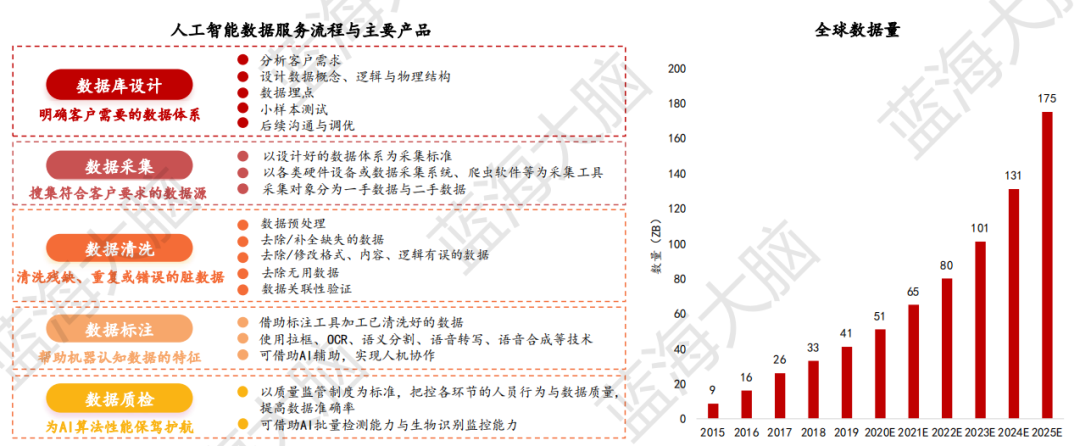

三、數據服務以AI訓練與調優為目的,涉及數據採集、標註與質檢等環節

人工智能數據服務是指提供數據庫設計、數據採集、數據清洗、數據標註和數據質檢等服務,以滿足客户的需求。這個服務流程是圍繞客户需求展開的,最終產出的產品是數據集和數據資源定製服務,為AI模型訓練提供可靠、可用的數據。隨着短視頻、直播、社交電商等應用的快速興起,全球數據量也在快速增長。根據IDC的預測,全球數據量將從2015年的9ZB增加到2025年的175ZB,這為人工智能技術的持續迭代提供了重要的底層基礎。

四、雲計算服務顯著降低人工智能算法開發成本,縮短產品開發週期

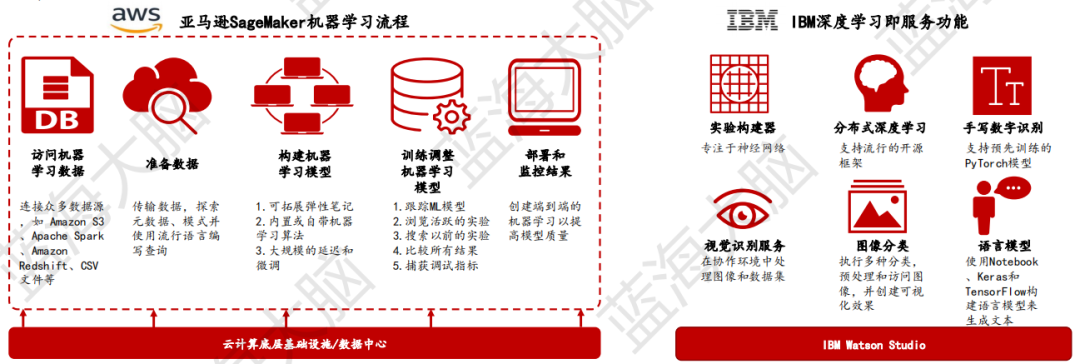

由於人工智能的開發和應用對於算力和數據有較大需求,雲計算服務可以為開發者提供智能服務器集羣等強大算力設施的租用。同時,雲計算服務還可以直接提供已經訓練好的人工智能功能模塊等產品,通過多元化的服務模式,降低開發者的開發成本和產品開發週期,為客户提供AI賦能。

例如,亞馬遜SageMaker可以提供圖片/圖像分析、語音處理、自然語言理解等相關服務。使用者無需瞭解參數和算法即可實現功能的應用。隨着底層技術的發展,IBM推出深度學習即服務(DLaaS),藉助此項服務用户可以使用主流框架來訓練神經網絡,如TensorFlow、PyTorch及Caffe。用户無需購買和維護成本高昂的硬件,每一個雲計算處理單元都遵循簡單易用的原則而設置,無需用户對基礎設施進行管理。用户可以根據支持的深度學習框架、神經網絡模型、訓練數據、成本約束等條件進行挑選,然後DLaaS服務會幫助完成其餘的事情,提供交互式、可迭代的訓練體驗。

人工智能的核心技術

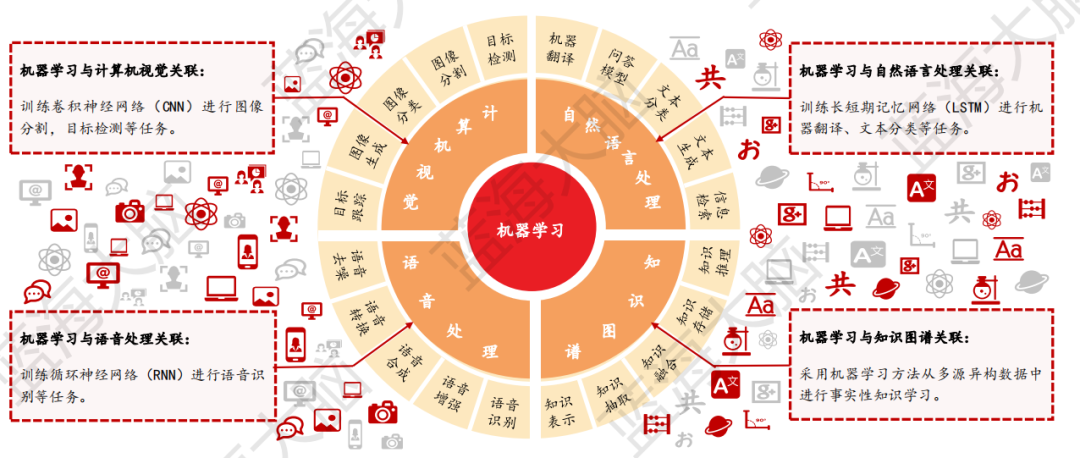

機器學習作為人工智能技術的核心,近年來實現了明顯的突破。它與計算機視覺、自然語言處理、語音處理和知識圖譜等關鍵技術緊密結合,相關機器學習算法主要應用於圖像分類、語音識別、文本分類等相關場景中。這些應用場景的不斷發展和完善,不僅提升了人工智能技術的整體應用效果,也使得人工智能技術在金融、醫療、交通等各領域實現了廣泛的應用。

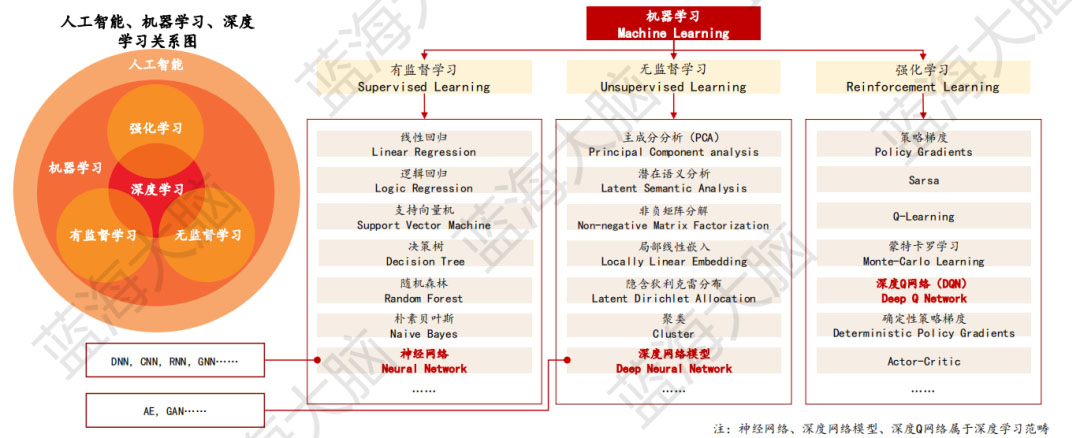

一、機器學習

機器學習是實現人工智能的核心方法,專門研究計算機如何模擬/實現生物體的學習行為,獲取新的知識技能,利用經驗來改善特定算法的性能。根據學習範式的不同,機器學習可劃分為有監督學習、無監督學習、強化學習三類。有監督學習是指通過給計算機提供標註數據,讓計算機學習如何將輸入映射到輸出的過程。無監督學習則是指在沒有標註數據的情況下,讓計算機自行學習數據的特徵和結構。強化學習則是通過讓計算機在與環境的交互中不斷試錯,從而學習如何最大化獎勵的過程。深度學習是機器學習算法的一種,具有多層神經網絡結構,其在圖像識別、語音處理等領域取得了劃時代的成果。

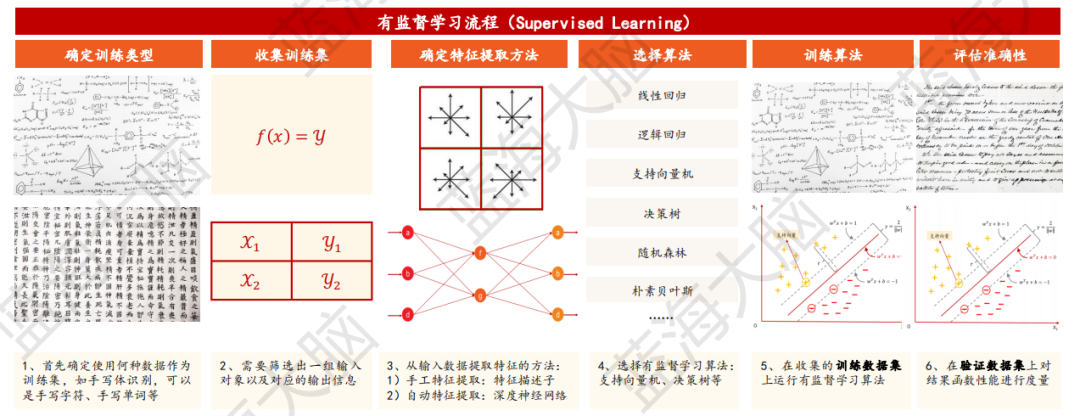

1、有監督學習:從有標註訓練數據中推導出預測函數

有監督學習是機器學習任務的一種類型,其目的是從給定的訓練數據集中學習出一個函數(模型參數),以便在新的數據到來時,能夠根據該函數預測結果。訓練集中包括輸入和輸出,也稱為特徵和目標,其中目標是由人工標註的。有監督學習的過程一般包括確定訓練類型、收集訓練集、確定特徵提取方法、選擇算法、訓練算法、評估準確性六個環節。通過已有的訓練樣本去訓練得到一個最優模型,再利用該模型將所有的輸入映射為相應的輸出,從而實現分類目的。

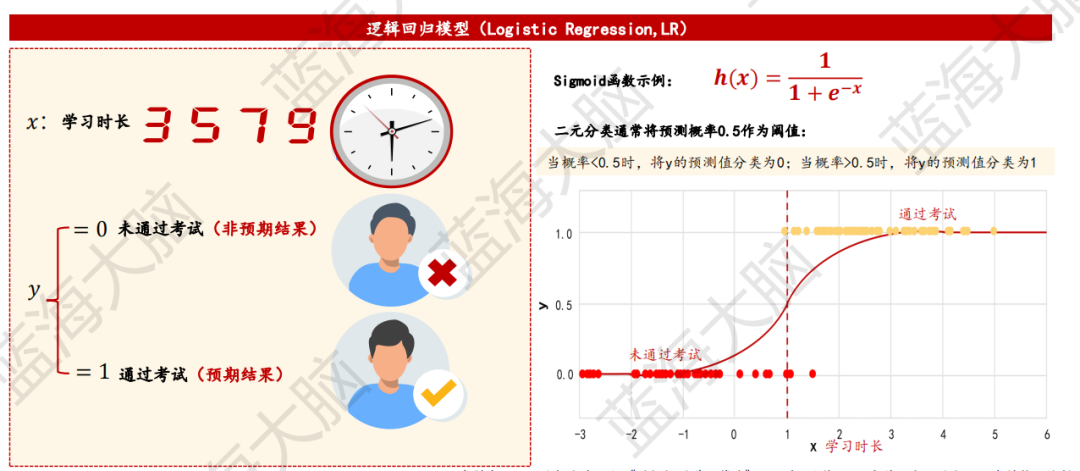

1)邏輯迴歸

邏輯迴歸是一種用於學習某事件發生概率的算法,它可以對某個事件的發生或不發生進行二元分類。邏輯迴歸使用 Sigmoid 函數來輸出結果,其輸出結果的範圍在 [0,1] 之間。邏輯迴歸的主要目標是發現特徵與特定結果可能性之間的聯繫。例如,我們可以使用邏輯迴歸來根據學習時長來預測學生是否通過考試,其中響應變量為“通過”和“未通過”考試。

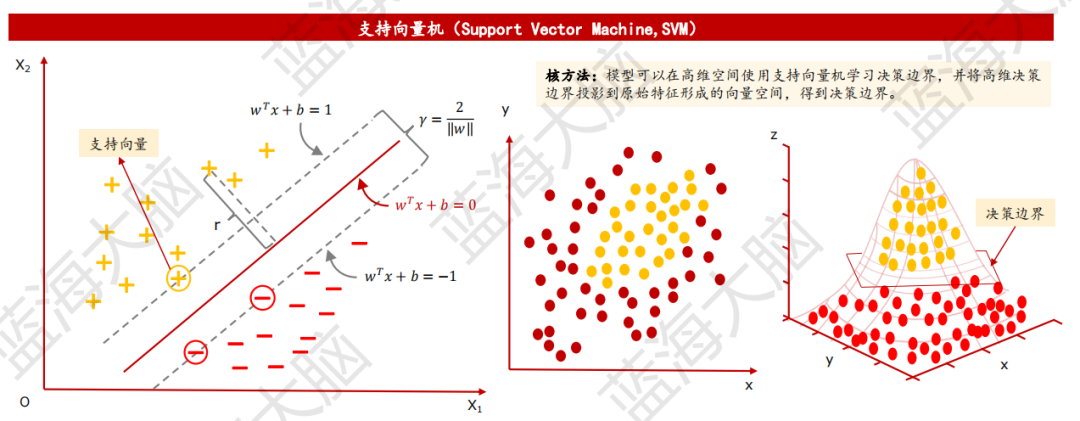

2)支持向量機:以間隔最大化為基準學習遠離數據的決策邊界

支持向量機(Support Vector Machine,SVM)是一種基於間隔最大化的決策邊界算法。其主要目的是學習一個儘可能遠離數據的決策邊界,以確保分類的準確性。在SVM中,支持向量是決策邊界的重要數據點,其位置對於分類結果具有重要的影響。

當訓練樣本線性可分時,SVM採用硬間隔最大化的方法學習線性可分支持向量機;當訓練樣本近似線性可分時,SVM採用軟間隔最大化的方法學習線性支持向量機。在解決線性不可分問題時,SVM引入核函數,將數據映射到另一個特徵空間,然後進行線性迴歸。通過採用核方法的支持向量機,原本線性不可分的數據在特徵空間內變為線性可分,從而實現了分類的準確性。

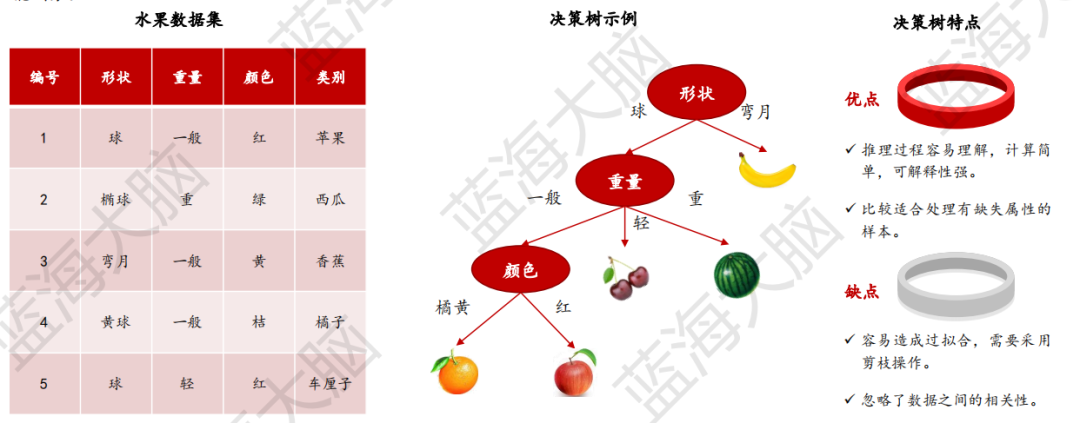

3)決策樹:以樹結構形式表達的預測分析模型

決策樹是一種樹狀結構,用於對數據進行劃分。它通過一系列決策(選擇)來劃分數據,類似於針對一系列問題進行選擇。一棵決策樹通常包含一個根節點、若干個內部節點和若干個葉節點。每個內部節點表示一個屬性上的測試,每個分支代表一個測試輸出,每個葉節點代表一種類別。

決策樹的生成是一個遞歸過程。在決策樹基本算法中,有三種情況會導致遞歸返回:

當前節點包含的樣本全屬於同一類別,無需劃分。

當前屬性集為空或是所有樣本在所有屬性上取值相同,無法劃分。

當前節點包含的樣本集合為空,不能劃分。

這些情況都是決策樹生成過程中的終止條件。

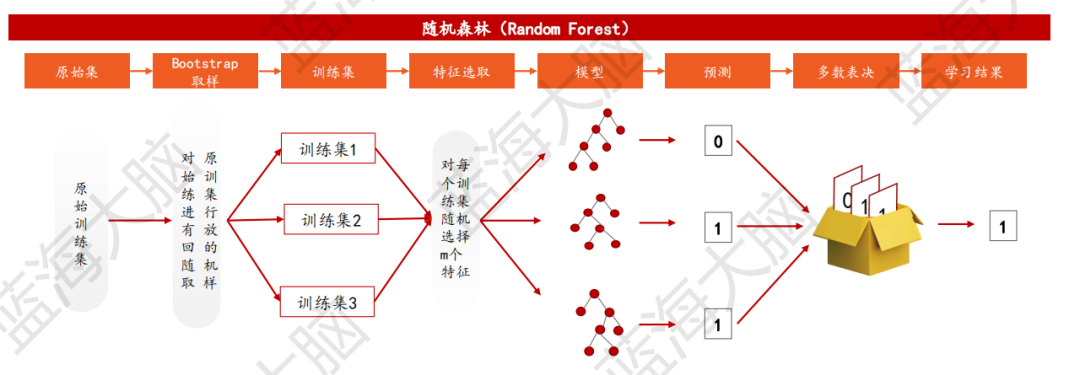

4)隨機森林:利用多決策樹模型,提高模型預測精度

隨機森林是一種分類器,它利用多棵決策樹對樣本進行訓練和預測。在隨機森林算法中,每個決策樹的輸出被收集起來,通過多數表決的方式得到最終的分類結果。這種方法類似於找人商量事情,不只聽一個人的意見,而是在聽取多人意見後綜合判斷。隨機森林的每棵樹都是通過以下步驟生成的:

從訓練集中隨機且有放回地抽取N個訓練樣本,作為該樹的訓練集,重複K次,生成K組訓練樣本集;

從M個特徵中隨機選取m個特徵,其中m<<M;

利用m個特徵實現每棵樹最大程度的生長,並且沒有剪枝過程。

這種方法可以有效地避免過擬合問題,並且在處理大型數據集時表現良好。

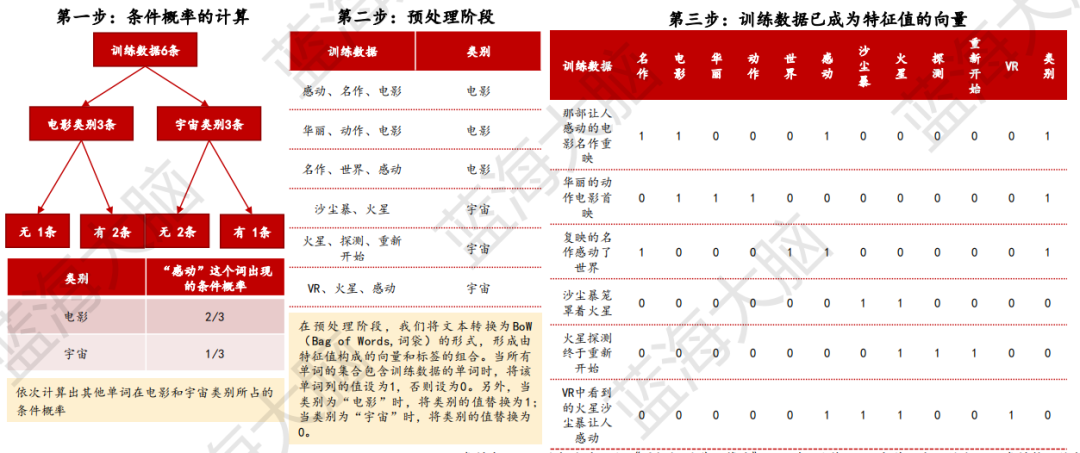

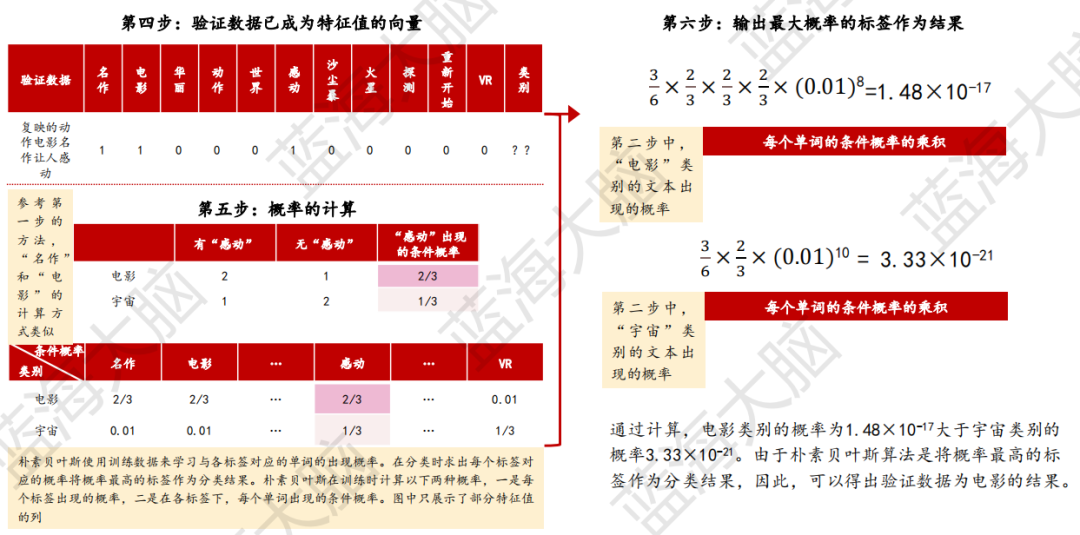

5)樸素貝葉斯是常用於自然語言分類問題的算法

樸素貝葉斯是一種基於概率進行預測的算法,主要用於分類問題。在實踐中,它被廣泛應用於文本分類和垃圾郵件判定等自然語言處理領域。具體來説,該算法通過計算數據為某個標籤的概率,將其分類為概率值最大的標籤。例如,假設訓練數據類別為電影(包括那部讓人感動的電影名作重映、華麗的動作電影首映和復映的名作感動了世界),訓練數據類別為宇宙(包括沙塵暴籠罩着火星、火星探測終於重新開始和VR中看到的火星沙塵暴讓人感動),而驗證數據為“復映的動作電影名作讓人感動”。在這種情況下,樸素貝葉斯算法將通過計算“復映的動作電影名作讓人感動”屬於電影或宇宙的概率,來判斷該數據屬於哪個類別。以下為樸素貝葉斯算法過程:

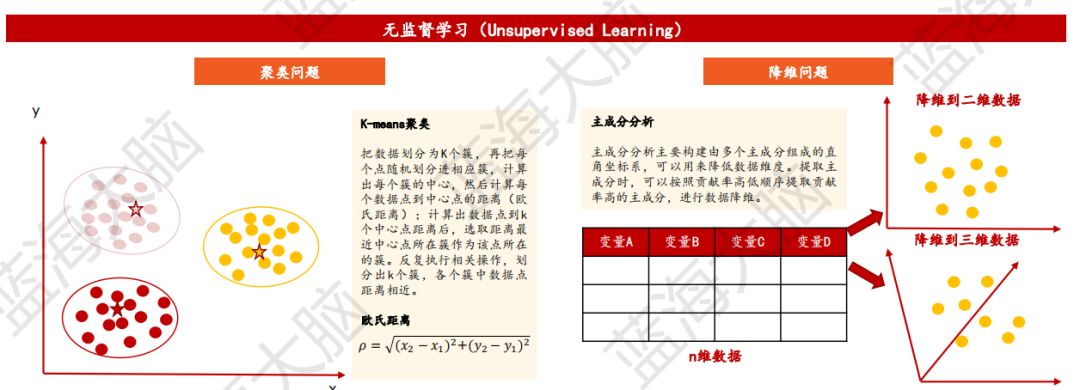

2、無監督學習:對無標籤樣本進行學習揭示數據內在規律

無監督學習是一種機器學習方法,其主要目的是在沒有標記的訓練數據的情況下生成模型。這種方法通常用於缺乏足夠的先驗知識難以進行人工標註類別或進行人工類別標註成本高的情況下。無監督學習的目標是通過對無標籤樣本的學習來揭示數據的內在特性及規律。該方法主要涉及聚類和降維問題。聚類問題包括K-means聚類、概念聚類、模糊聚類等算法,其目標是為數據點分組,使得不同聚類中的數據點不相似,同一聚類中的數據點則是相似的。降維問題主要是主成分分析、線性判別分析、多維尺度分析等算法,其中主成分分析將數據中存在的空間重映射成一個更加緊湊的空間,此種變換後的維度比原來維度更小。無監督學習適用於發現異常數據、用户類別劃分、推薦系統等場景。

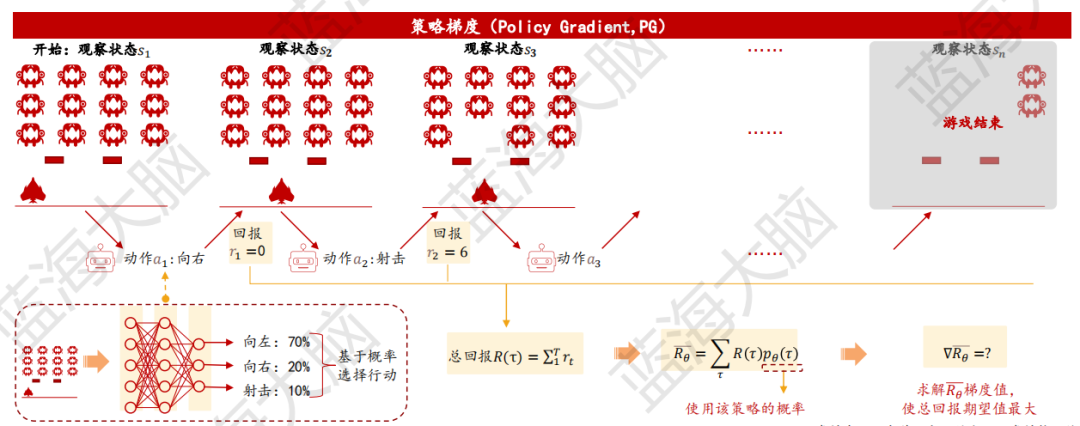

1)策略梯度:有效處理高維及連續動作空間問題

策略梯度(Policy Gradient,PG)是一種基於策略優化的強化學習算法。在強化學習中,機器通過判斷在特定狀態下采取不同動作所得環境回報大小來評價採取該動作的優劣。PG的核心思想是,當一個動作的環境回報較大時,增加其被選擇的概率;反之,減少該動作被選擇的概率。每個動作選擇概率由神經網絡決定,以參數化神經網絡表示策略(記為𝜋𝜃)。通過調整參數𝜃,使總體回報期望值最大化,從而實現最優策略的學習。最大化問題可轉化為求取回報函數關於參數𝜃的梯度,一般使用梯度上升算法,即為策略梯度算法。為提高算法的收斂性和效率,通常採取引入基線(baseline)、修改因果關係(當前策略不影響該時間點之前的回報)和引入回報權重等方式。

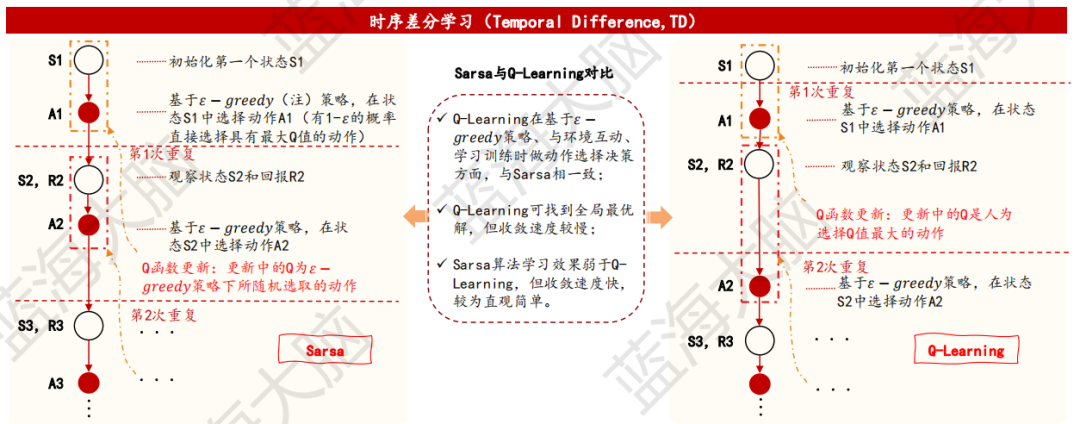

2)時序差分學習:結合蒙特卡羅方法與動態規劃特點,提升策略優化速度

時序差分學習(Temporal Difference,TD)是一種無需具體環境模型,可直接從經驗中學習的方法。它結合了動態規劃和蒙特卡羅方法的優點,能夠在每執行一步策略後即進行Q函數更新,而不必等到完成一個採樣軌跡後才進行更新。根據算法中採樣策略和更新Q值策略是否相同,TD學習可分為同策略算法(on-policy)和異策略算法(off-policy)。同策略代表算法為Sarsa,其行為策略和目標策略均為貪心策略;異策略代表算法為Q-Learning(或稱SarsaMax),其行為策略為貪心策略,而目標策略為確定性策略。Sarsa收斂速度較快,但可能無法得到全局最優解;Q-Learning可找到全局最優解,但收斂速度較慢,因此需要根據具體問題選擇合適的算法。

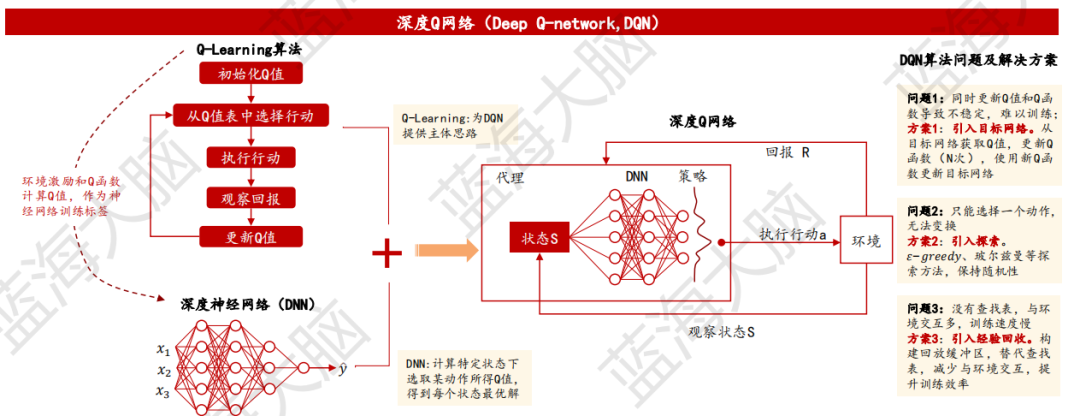

3)深度Q網絡:神經網絡與Q-Learning結合,有效應對複雜狀態空間

深度Q網絡(Deep Q-network, DQN)是一種基於深度學習的Q-Learning算法,由Google DeepMind團隊於2013年提出,並在2015年進一步完善。傳統的強化學習算法(如動態規劃、蒙特卡羅方法、時序差分學習等)的狀態均為離散、有限的,並使用查找表存儲狀態價值或Q函數。然而,現實生活中的狀態多為連續的,即使離散化後狀態空間(系統全部可能狀態的集合)仍十分龐大,因而產生內存不足、表格搜索耗時過長等問題。DQN則通過DNN、CNN或RNN等神經網絡對價值函數做近似表示,利用經驗回放方式替代查找表,令最終結果無限逼近全局最優解,有效解決Q-Learning狀態空間有限問題。

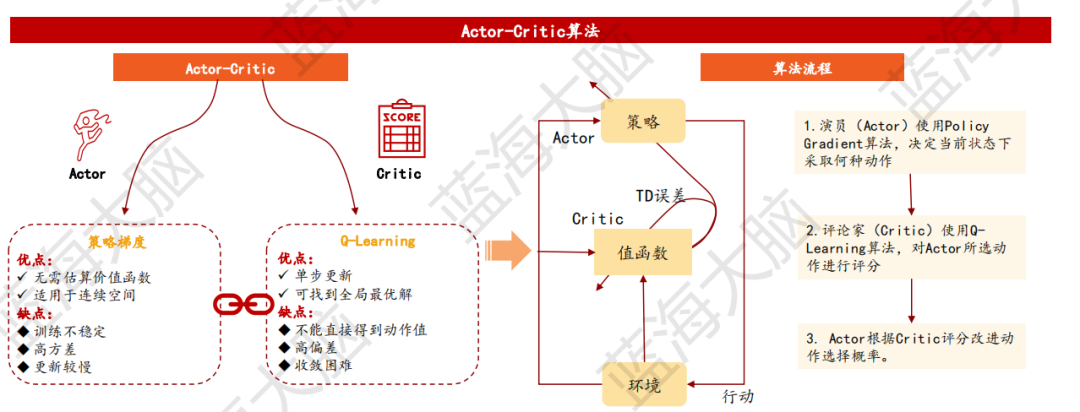

4)Actor-Critic算法:綜合策略梯度與Q-Learning優勢,提高學習效率和準確性

Actor-Critic算法(AC)是一種強化學習算法,也被稱為“演員-評論家”算法。它由兩個神經網絡組成:策略網絡Actor和評價網絡Critic。Actor使用基於策略優化的算法,如策略梯度,來決定在當前狀態下采取何種動作。Critic使用基於值優化的算法,如Q-Learning,對Actor所選動作進行評分,Actor根據Critic評分改進動作選擇概率。AC算法結合了策略梯度和Q-Learning算法的優點,既可以做到單步更新,又可以擴展至連續狀態空間,提高策略更新效率同時解決高偏差問題。目前,AC算法已經發展出了Advantage Actor-Critic(A2C)以及Asynchronous advantage Actor-Critic(A3C)等改進型,進一步提高了策略準確性,降低了內存需求。

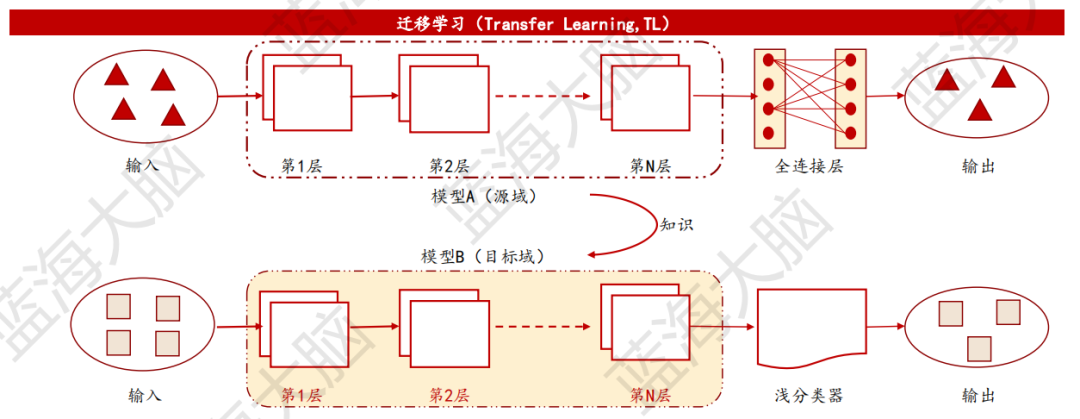

3、遷移學習:將知識由源域遷移至目標域,提高機器學習效率

遷移學習(Transfer Learning, TL)是一種機器學習方法,其核心目標是將已訓練好的模型參數遷移到新的模型來幫助新模型訓練。這種方法可以將知識從源域遷移到目標域,讓機器也可以做到“觸類旁通”。遷移學習的主要優點是節省模型訓練時間,且在目標域訓練數據不足時,模型仍能取得較好的性能。遷移學習的訓練框架可以概括為:

1)選擇源模型,從可用模型中挑選出預訓練模型;

2)重用模型,在目標域中使用源模型進行訓練;

3)調整模型。模型可以在目標數據集中對輸入-輸出進行選擇性微調,以讓其適應目標任務。

實現遷移學習的方式主要包括樣本遷移、特徵遷移、模型遷移。目前,遷移學習主要應用在計算機視覺、自然語言處理等領域。

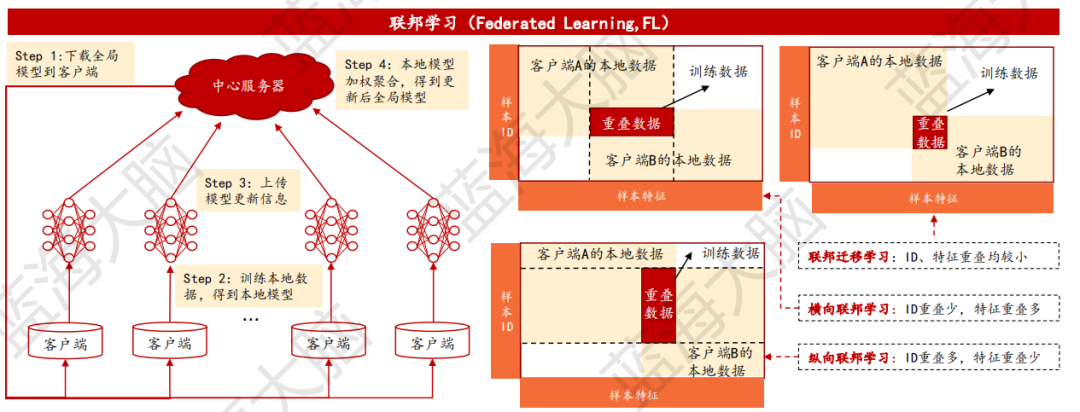

4、聯邦學習:以分佈式機器學習方式,有效化解信息孤島問題

聯邦學習(Federated Learning,FL)是由Google公司首次提出的一種學習機制,它允許多個數據持有方協同訓練模型,而不需要共享數據,僅在中間階段交換訓練參數。根據數據分佈情況,聯邦學習可分為橫向聯邦學習、縱向聯邦學習和聯邦遷移學習。聯邦學習的基本流程包括:

1)客户端從服務器下載全局模型;

2)訓練本地數據得到本地模型;

3)上傳模型更新信息;

4)中心服務器加權聚合本地模型,得到更新後的全局模型。

通過多次迭代,聯邦學習可以得到趨近於集中式機器學習結果的模型。聯邦學習是一項新興技術,在物聯網、智慧醫療、金融風控、智慧城市等領域都有廣闊的應用前景。

二、深度學習

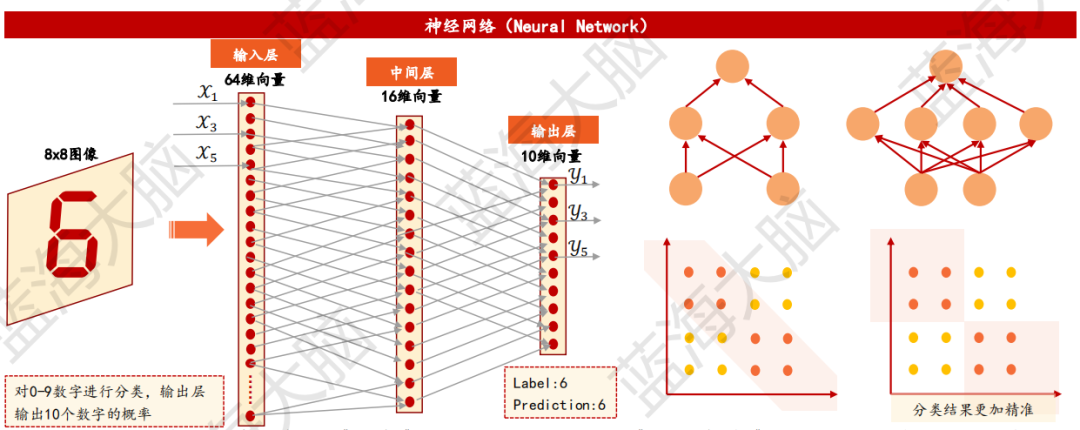

1、神經網絡:具有適應性簡單單元組成的廣泛並行互聯網絡

神經網絡是一種由數千甚至數百萬個緊密互連的簡單處理節點組成的模型。它主要包括輸入層、中間層/隱藏層和輸出層。輸入層接收輸入數據,中間層使用非線性函數對輸入數據進行計算,輸出層使用非線性函數對中間層數據進行計算,最終輸出結果。神經網絡可以用於迴歸,但主要應用於分類問題。通過設置中間層的數量和層的深度,神經網絡可以學習更復雜的邊界特徵,從而得出更加準確的結果。

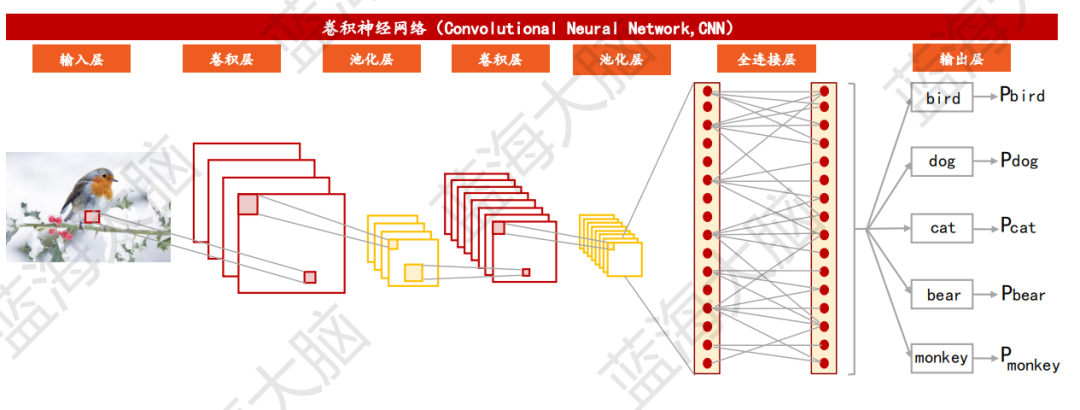

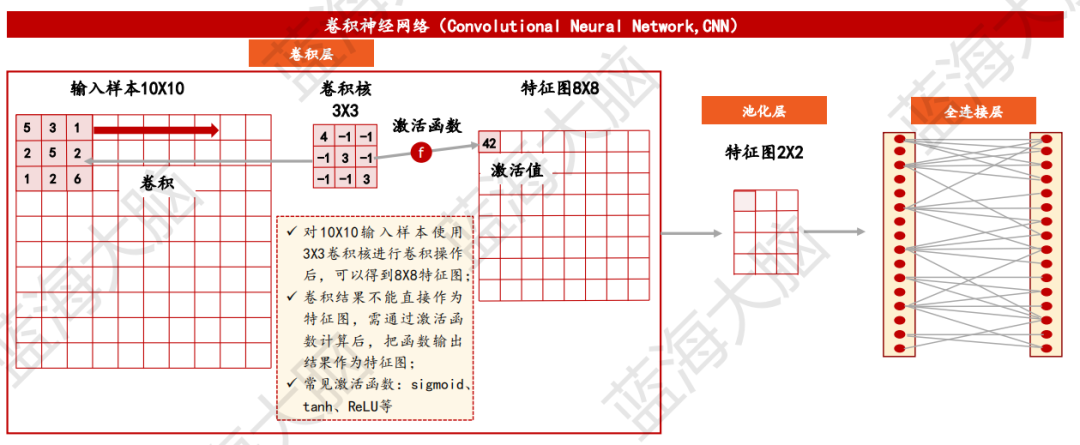

2、卷積神經網絡:以圖像識別為核心的深度學習算法

卷積神經網絡(Convolutional Neural Network,CNN)是一種由數千甚至數百萬個緊密互連的簡單處理節點組成的神經網絡結構,主要用於處理圖片、視頻等類型數據。該網絡結構主要包括輸入層、卷積層、池化層、全連接層和輸出層。早在1980年,日本科學家福島邦彥就提出了一個包含卷積層、池化層的神經網絡結構。隨後,Yann Lecun將BP算法應用到該神經網絡結構的訓練上,形成了當代卷積神經網絡的雛形。在1998年,Yann LeCun及其合作者構建了更加完備的卷積神經網絡LeNet-5,並在手寫數字的識別問題中取得了成功。此外,1998年Wei Zhang提出了第一個二維卷積神經網絡:平移不變人工神經網絡(SIANN),並將其應用於檢測醫學影像。

卷積層、池化層、全連接層和輸出層是卷積神經網絡中的四個主要組成部分。在卷積層中,輸入的圖片會被轉化成RGB對應的數字,並通過卷積核進行卷積操作,以提取輸入中的主要特徵。池化層的作用是壓縮特徵映射圖尺寸,從而降低後續網絡處理的負載。全連接層計算激活值,並通過激活函數計算各單元輸出值,常用的激活函數包括Sigmoid、tanh、ReLU等。輸出層使用似然函數計算各類別似然概率。

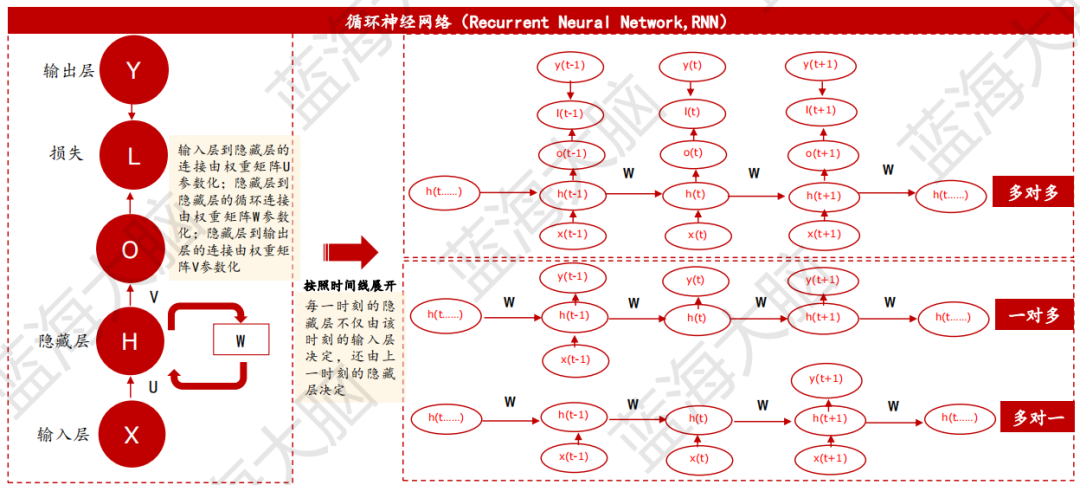

3、循環神經網絡:用於處理序列數據的神經網絡

循環神經網絡(Recurrent Neural Network, RNN)是一種神經網絡,其輸入為序列數據,例如時間序列數據、信息性字符串或對話等。該網絡在序列的演進方向進行遞歸,並通過鏈式連接所有節點(循環單元)。RNN在語言建模和文本生成、機器翻譯、語音識別、生成圖像描述和視頻標記等領域得到廣泛應用。

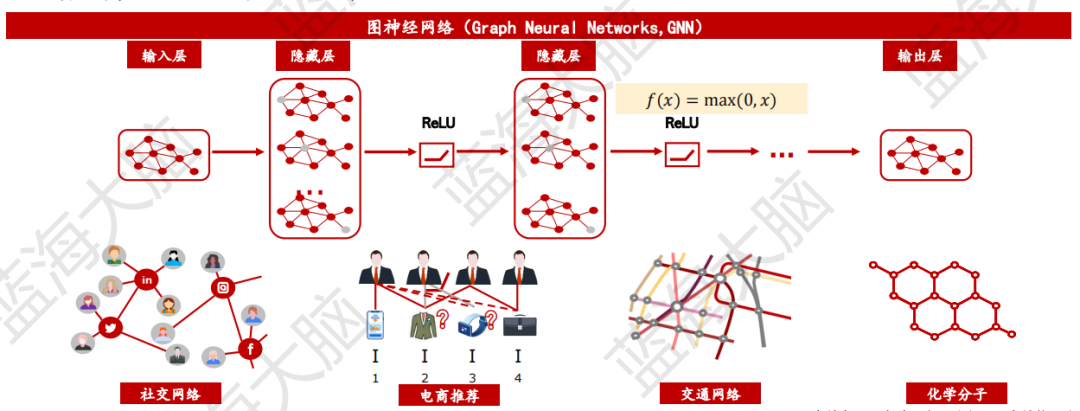

4、圖神經網絡:用於處理圖結構數據的神經網絡

圖神經網絡(Graph Neural Networks,GNN)是一種將圖數據和神經網絡進行結合的新型機器學習方法。它能夠在圖數據上進行端對端的計算,具備端對端學習、擅長推理、可解釋性強的特點。目前,圖神經網絡已經發展出多個分支,主要包括圖卷積網絡、圖注意力網絡、圖自編碼器、圖生成網絡和圖時空網絡等。

圖神經網絡的訓練框架如下:首先,每個節點獲取其相鄰節點的所有特徵信息,將聚合函數(如求和或取平均)應用於這些信息。聚合函數的選擇必須不受節點順序和排列的影響。之後,將前一步得到的向量傳入一個神經網絡層(通常是乘以某個矩陣),然後使用非線性激活函數(如ReLU)來獲得新的向量表示。

圖神經網絡在許多領域的實際應用中都展現出強大的表達能力和預測能力。例如,在物理仿真、科學研究、生物醫藥、金融風控等領域,圖神經網絡已經被廣泛應用。它不僅能夠對圖數據進行分類、迴歸和聚類等任務,還能夠進行圖生成、圖表示學習和圖推理等任務。因此,圖神經網絡被認為是一種非常有前途的機器學習方法。

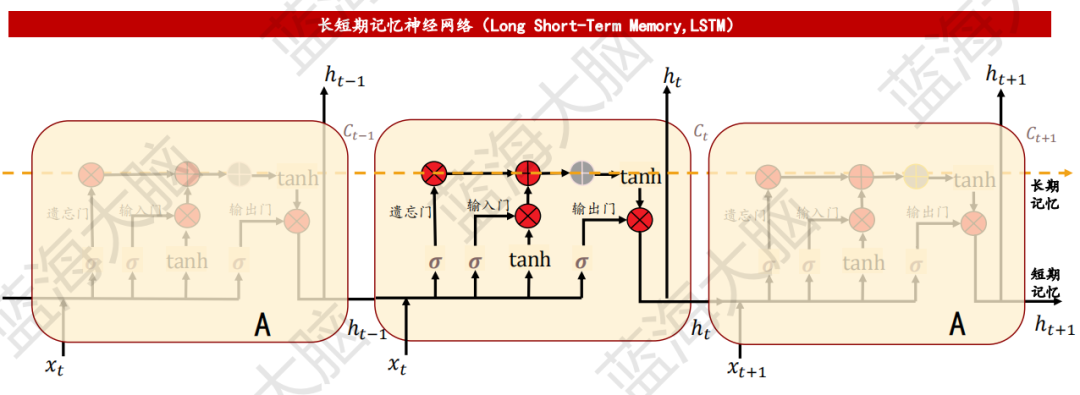

5、長短期記憶神經網絡:在RNN中加入門控機制,解決梯度消失問題

長短期記憶神經網絡(Long Short-Term Memory,LSTM)是一種特殊的循環神經網絡(RNN),它可以有效地解決傳統RNN在訓練中出現的“長期依賴”問題。在訓練時間加長和層數增多的情況下,傳統RNN很容易出現梯度爆炸或梯度消失問題,導致無法處理長序列數據。LSTM由狀態單元、輸入門、遺忘門和輸出門組成,通過這些門的控制,可以實現長期記憶與短期記憶的結合,從而達到序列學習的目的。LSTM的應用領域非常廣泛,包括文本生成、機器翻譯、語音識別、生成圖像描述和視頻標記等。

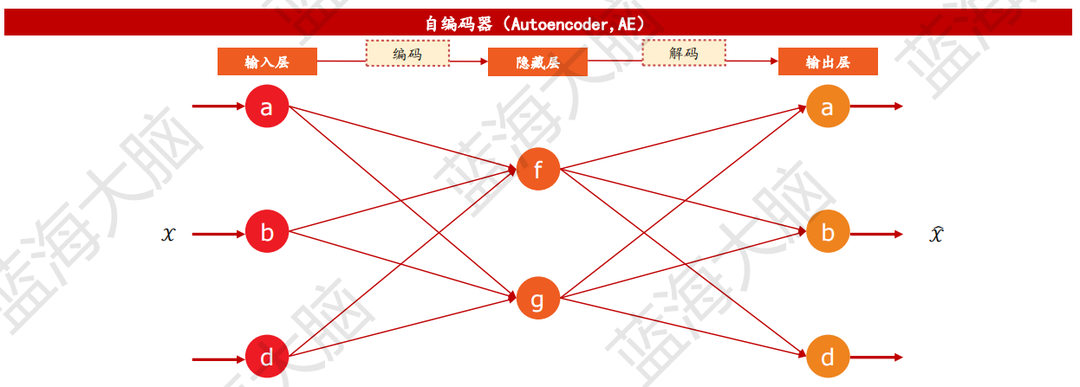

6、自編碼器:通過期望輸出等同於輸入樣本的過程,實現對輸入樣本抽象特徵學習 典型深度無監督學習模型包括自編碼器、受限波爾茲曼機與生成對抗網絡。

自編碼器(Autoencoder,AE)是一種神經網絡模型,由編碼器和解碼器兩部分組成。編碼器將高維輸入樣本映射到低維抽象表示,實現樣本壓縮和降維;解碼器將抽象表示轉換為期望輸出,實現輸入樣本的復現。自編碼器的輸入和期望輸出均為無標籤樣本,隱藏層輸出則作為樣本的抽象特徵表示。自編碼器通過最小化輸入樣本與重構樣本之間的誤差來獲取輸入樣本的抽象特徵表示,但無法保證自編碼器提取到樣本的本質特徵。為避免這個問題,需要對自編碼器添加約束或修改網絡結構,進而產生稀疏自編碼器、去噪自編碼器、收縮自編碼器等改進算法。自編碼器憑藉其優異的特徵提取能力,主要應用於目標識別、文本分類、圖像重建等領域。

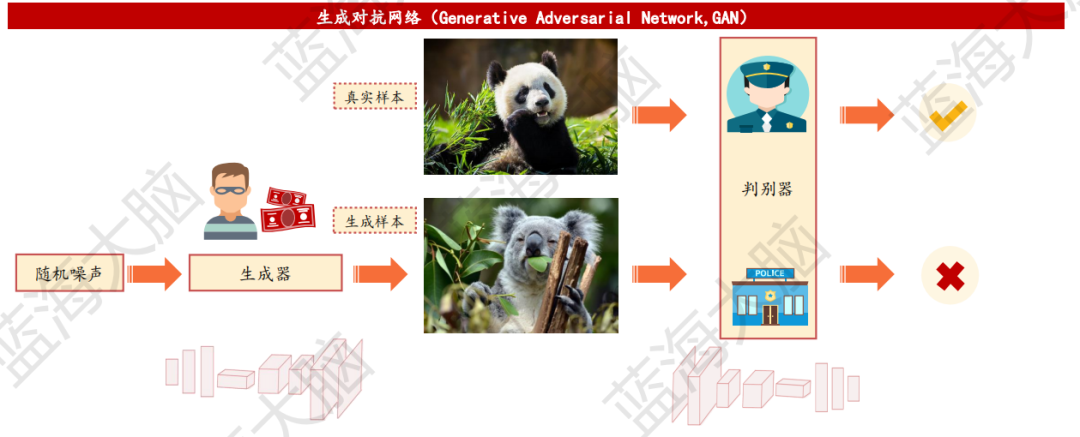

7、生成對抗網絡:通過對抗訓練機制使得生成器生成以假亂真的樣本

生成對抗網絡(GAN)是一種通過對抗訓練機制對兩個神經網絡進行訓練的方法,以避免反覆應用馬爾可夫鏈學習機制帶來的配分函數計算,從而明顯提高應用效率。GAN包含一組相互對抗的模型,即判別器和生成器。判別器的目的是正確區分真實數據和生成數據,使得判別準確率最大化;而生成器則是儘可能逼近真實數據的潛在分佈。類比於造假鈔的人和警察的博弈,生成器類似於造假鈔的人,其製造出以假亂真的假鈔;而判別器則類似於警察,儘可能鑑別出假鈔。在這個博弈中,雙方不斷提升各自的能力,以達到更高的準確率和更逼真的生成數據。

三、計算機視覺

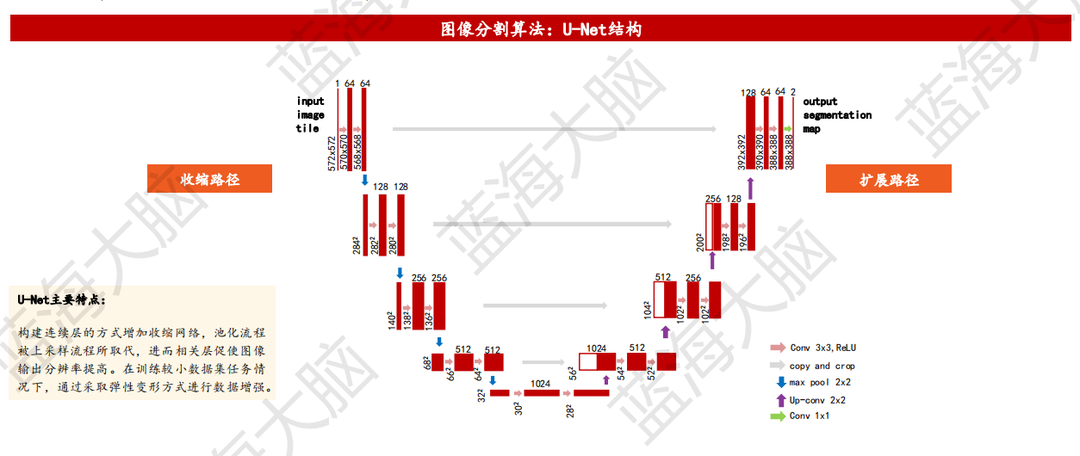

1、U-Net:在有限數據集圖像分割方面獨具優勢

U-Net是一種由Olaf Ronneberger、Philipp Fischer等人於2015年首次提出的神經網絡結構,最初應用於醫學圖像分割領域。該網絡結構可視化的結果形如字母“U”,由左側的收縮路徑和右側的擴展路徑兩部分組成。相較於傳統模型,U-Net在架構和基於像素的圖像分割方面更具優勢,且在有限數據集圖像上更加有效。在生物醫學圖像領域,U-Net通過彈性變形方法幫助擴充數據集,從而提高學習效果。此外,U-Net在衞星圖像遙感和無人駕駛系統等相關領域也有應用。因此,圖像分割不僅限於醫學圖像領域,其在其他領域也有廣泛的應用。

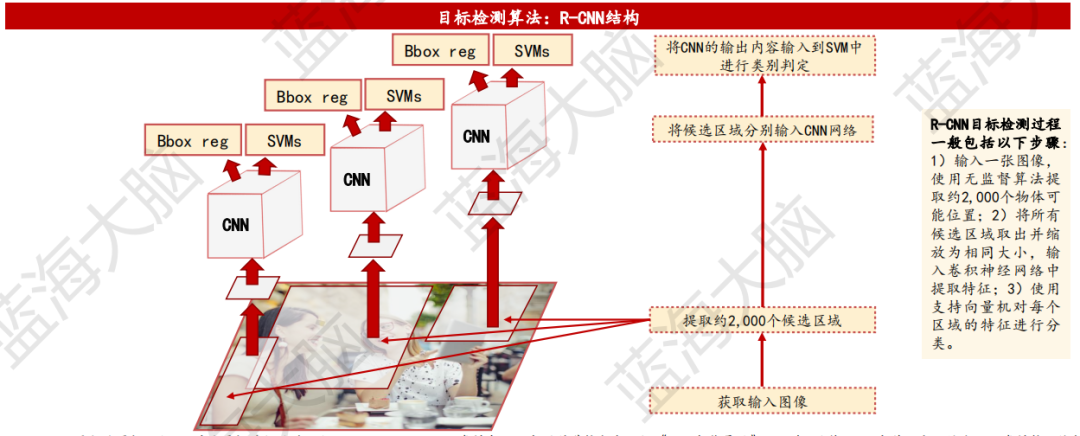

2、R-CNN:基於深度學習模型的目標檢測算法

目標檢測算法主要分為兩類:R-CNN和Yolo。R-CNN(Region-CNN)最早將深度學習應用在目標檢測任務中。目標檢測任務是計算機視覺中的重要組成部分,其在人臉識別、自動駕駛等領域有着廣泛應用。傳統目標檢測方法大多以圖像識別為基礎,在圖片上使用窮舉法選出所有物體可能出現的區域框,對這些區域框提取特徵並使用圖像識別方法分類,得到所有分類成功的區域後,通過非極大值抑制算法得到輸出結果。R-CNN遵循傳統目標檢測的思路,但在提取特徵這一步,將傳統特徵換成深度卷積網絡提取的特徵。雖然R-CNN準確度高,但速度慢。相比之下,Yolo算法速度快但準確性相對低。

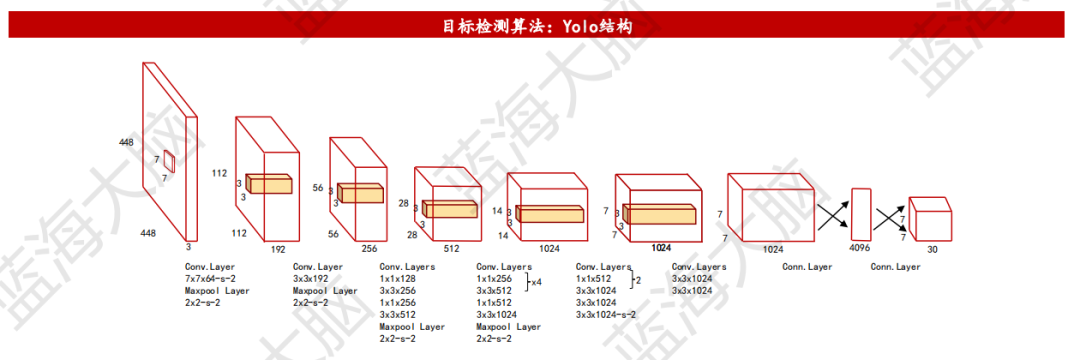

3、Yolo:採用CNN模型實現端到端的目標檢測算法

以往的目標檢測算法通常採用滑動窗口的方式,將檢測問題轉化為圖像分類問題,但存在計算量過大等弊端。為了解決這個問題,Yolo算法應運而生。Yolo算法直接將原始圖片分割成互不重合的小方塊,然後通過卷積產生特徵圖。具體而言,Yolo算法採用單獨的CNN模型實現端到端的目標檢測,包含24個卷積層和2個全連接層。卷積層主要使用1x1卷積來做通道縮減,然後緊跟3x3卷積。卷積層和全連接層採用Leaky ReLU激活函數,最後一層採用線性激活函數。Yolo算法的優點在於採用CNN實現檢測,訓練和預測都是端到端過程,因此該算法比較簡潔且速度快。同時,由於Yolo是對整張圖片做卷積,因此在檢測目標時擁有更大的視野且不容易對背景誤判。然而,Yolo算法的缺點是其在物體的寬高比方面泛化率相對較低,無法定位不尋常比例的物體。

四、自然語言處理

1、自然語言處理:用於分析、理解和生成自然語言,便於人機間交流

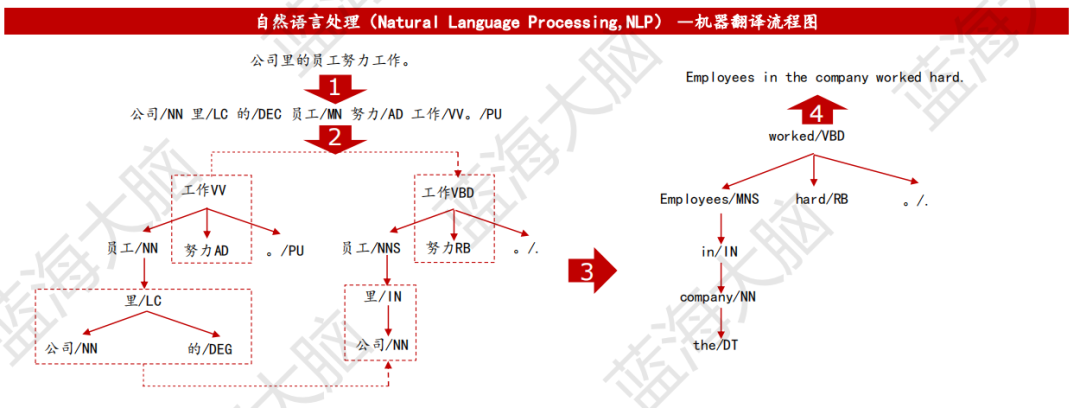

自然語言處理(NLP)是一種通過對詞、句子、篇章進行分析,理解其中的人物、時間、地點等內容,從而支持一系列核心技術的技術。這些技術包括跨語言的翻譯、問答系統、閲讀理解、知識圖譜等,可以應用於搜索引擎、客服、金融、新聞等領域。例如,在機器翻譯中,輸入的源語言句子經過詞法和句法分析得到句法樹,然後通過轉換規則將源語言句子句法樹進行轉換,生成目標語言的句法樹,最後得到目標語言句子。

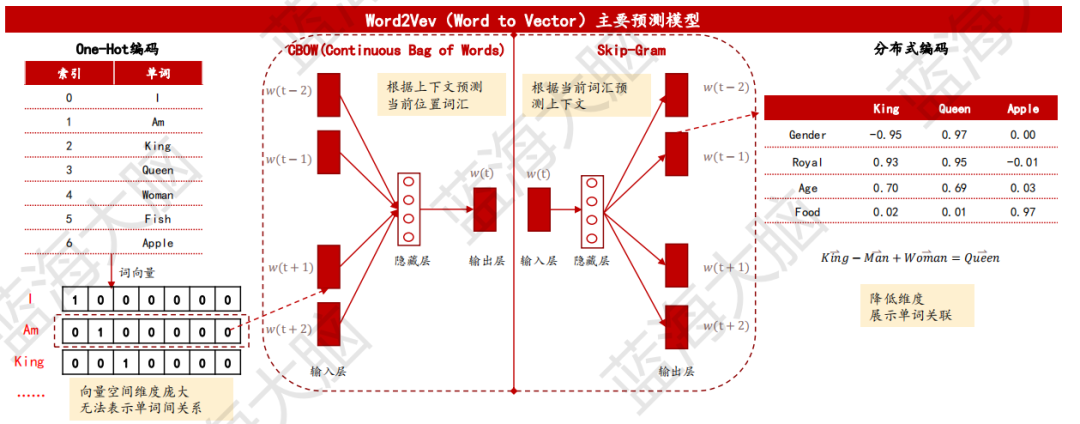

2、Word2Vec:以分佈式方法表示詞向量,有效降低維度,豐富詞語間關係

Word2Vec,即Word to Vector,是一種高效的詞向量訓練模型,由Google團隊Tomas Mikolov等人於2013年提出。在自然語言處理任務中,需要將單詞或詞語轉化為數值向量(詞向量)以供計算機識別,這一過程稱為詞嵌入。早期的One-Hot編碼方法簡單易懂、有較好的魯棒性,但存在維度爆炸問題,且無法表示詞語相關關係。Word2Vec使用分佈式詞向量表示方法,有效降低詞向量維度,豐富單詞間關係。Word2Vec主要使用CBOW(連續詞袋)模型和Skip-Gram(跳詞)模型兩種預測方法。前者根據上下文預測當前詞,適用於小語庫;後者根據當前詞預測上下文,在大型語料庫中表現更好。

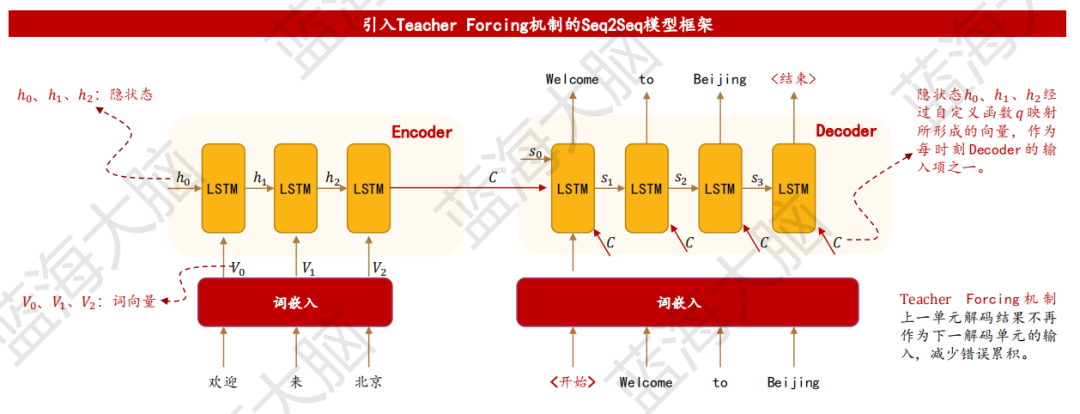

3、Seq2Seq:基於循環神經網絡輸出非固定長度語句

Seq2Seq(Sequence to Sequence)是一種神經網絡模型,由Google Brain和Yoshua Bengio團隊在2014年分別獨立提出。它的主要應用場景是解決機器翻譯任務中輸出語句長度不確定的問題。Seq2Seq模型基於RNN或LSTM等神經網絡算法,由編碼器(Encoder)和解碼器(Decoder)兩部分構成。編碼器負責將輸入序列壓縮為指定長度的語義向量,而解碼器則根據語義向量生成指定序列。這種模型可以實現序列信號轉化為無固定長度序列輸出,而傳統的RNN只能將序列信號轉化為固定長度序列輸出。除了機器翻譯,Seq2Seq還被應用於文本摘要、圖像描述文本生成、語音識別等場景。

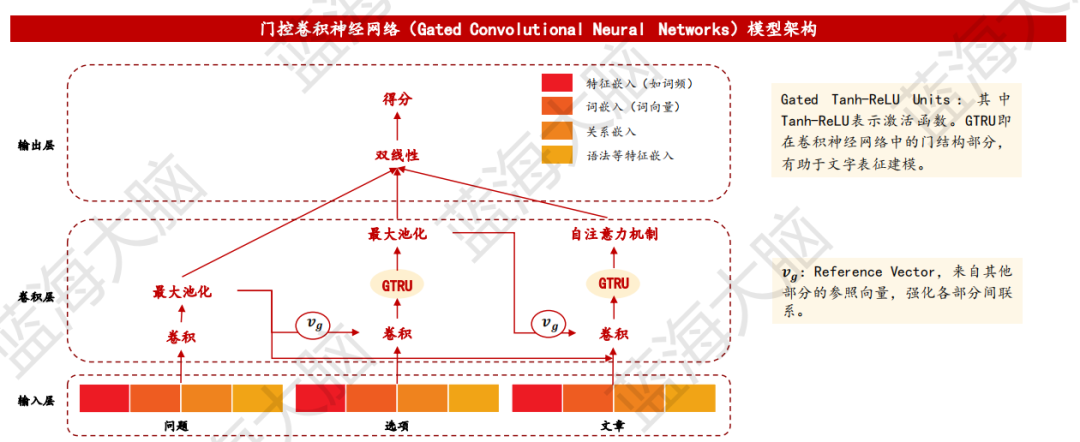

4、門控捲積神經網絡:應用於語言建模,以並行計算方式加速學習過程

門控捲積神經網絡(Gated Convolutional Neural Networks):由Facebook團隊Yann等人在2016年提出,使用基於門控機制的卷積神 經網絡處理語言建模問題。與循環神經網絡(RNN)相比,門控捲積神經網絡可實現並行計算,有效縮短運行時長。由於卷積神經網絡 不存在梯度消失問題,因而門控捲積神經網絡中的門控機制更加簡化,僅需保留輸出門用於判定信息是否傳遞至下一層,可實現更高精 度及更快收斂速度。目前,門控捲積神經網絡模型已被應用於光學字符識別(OCR)、機器閲讀理解等多個領域。

五、語音處理

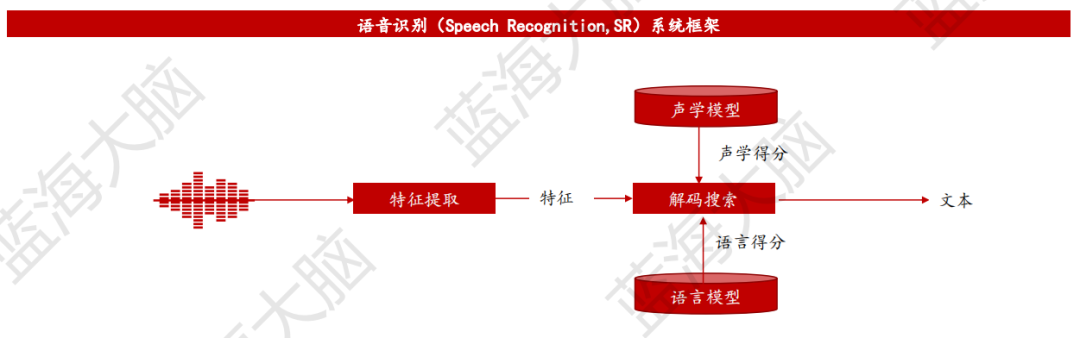

1、語音識別:將語音自動轉換為文字的過程

語音識別(Speech Recognition,SR)是將語音自動轉換為文字的過程,目的是將語音信號轉變為計算機可讀的文本字符或命令。動態規劃匹配方法是最具代表性的研究成果之一,該方法能夠將輸入語音與樣本語音的各自特徵,按時間軸進行伸縮、匹配。隨着時間的推移,基於隱馬爾可夫模型的統計建模方法逐漸取代了基於模版匹配的方法,基於高斯混合模型-隱馬爾可夫模型的混合聲學建模技術推動語音識別技術的蓬勃發展。到21世紀初,深度學習技術在語音識別中發揮重要作用,使語音識別的研究獲得突破性進展。語音識別技術主要包括特徵提取、模式匹配和模型訓練三個方面。特徵提取是將語音信號轉化為計算機能夠處理的語音特徵向量,常用的特徵參數有基音週期、共振峯、短時平均能量或幅度等;模式匹配是根據一定的準則,使未知模式與模型庫中的某一個模型獲得最佳匹配的過程;模型訓練是提取語音庫中語音樣本的特徵參數作為訓練數據,合理設置模型參數初始值,對模型參數進行重估,使識別系統具有更佳的識別效果。

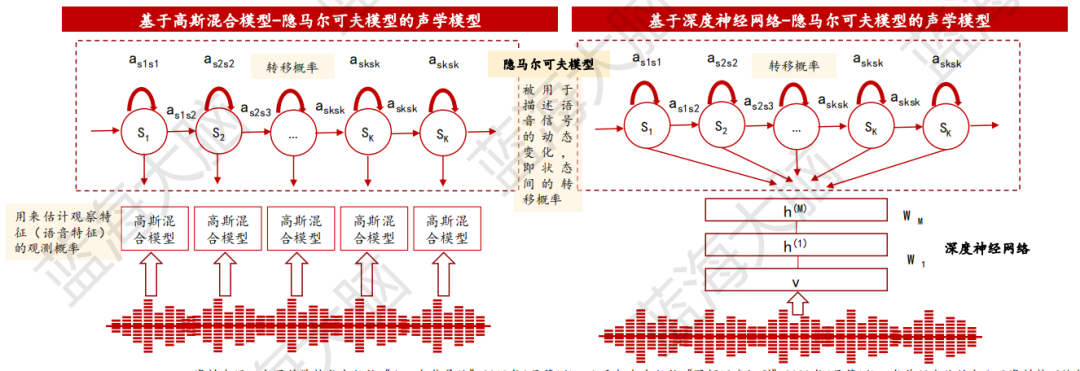

2、基於深度神經網絡-隱馬爾可夫模型的聲學模型成為主流聲學建模技術

聲學模型承載着聲學特徵與建模單元之間的映射關係,其中建模單元包括音素、音節、詞語等,其單元粒度依次增加。然而,若採用詞語作為建模單元,每個詞語的長度不等,導致聲學建模缺少靈活性,很難充分訓練基於詞語的模型。相比之下,詞語中包含的音素是確定且有限的,利用大量的訓練數據可以充分訓練基於音素的模型。因此,目前大多數聲學模型一般採用音素作為建模單元。

混合聲學模型是比較經典的聲學模型,通常可以分為兩種:基於高斯混合模型-隱馬爾可夫模型的聲學模型和基於深度神經網絡-隱馬爾可夫模型的聲學模型。後者具有兩方面優勢:一是深度神經網絡能利用語音特徵的上下文信息;二是深度神經網絡能學習非線性的更高層次特徵表達。因此,基於深度神經網絡-隱馬爾可夫模型的聲學模型已成為目前主流的聲學建模技術。

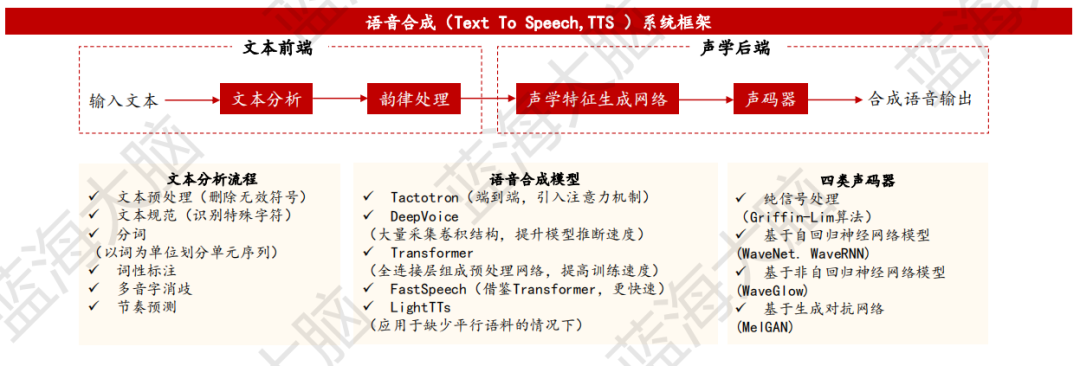

3、語音合成:將任意輸入的文本轉換成自然流暢的語音輸出

語音合成(Text To Speech, TTS)是一種將文本轉換為語音的技術,賦予機器像人一樣自如説話的能力,是人機語音交互中重要的一環。語音合成系統分為文本前端和聲學後端兩個部分。文本前端主要負責在語言層、語法層、語義層對輸入文本進行預處理,如為文本添加韻律信息,並將文本詞面轉化為語言學特徵序列。聲學後端可以分為聲學特徵生成網絡和聲碼器。聲學特徵生成網絡根據文本前端輸出的信息產生聲學特徵。聲碼器利用頻譜等聲學特徵,生成語音樣本點並重建時域波形。近年來出現的端到端語音合成系統則將聲學後端合併為一個整體,可直接將語言學特徵序列,甚至字符直接合成語音。

目前,語音合成技術已經廣泛應用於銀行、醫院信息播報系統、自動應答呼叫中心等領域。這些應用場景需要機器能夠快速、準確地將大量的文本信息轉化為語音,以提供更好的用户體驗。隨着技術的不斷發展,語音合成系統的語音質量和性能也在不斷提高,未來將會有更多的應用場景湧現。

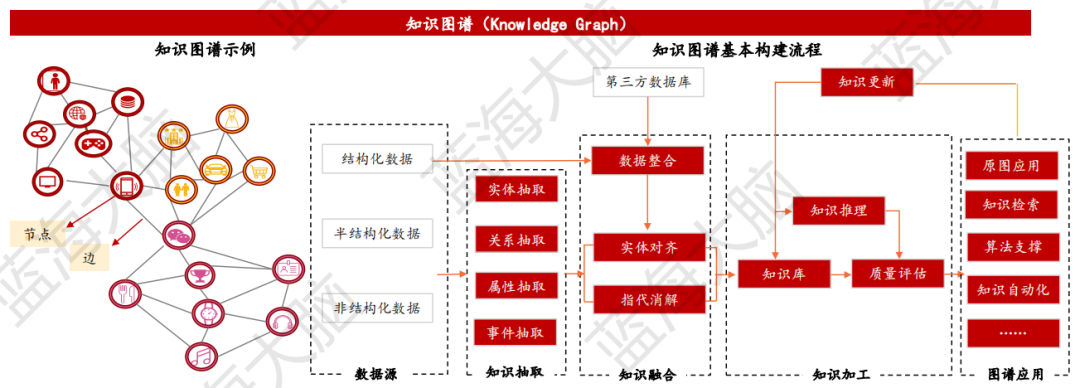

六、知識圖譜:利用圖模型來描述知識和建模萬物關係的語義網絡

知識圖譜是一種結構化描述客觀世界中概念、實體之間關係的方式,旨在提高搜索引擎的能力,提高用户搜索質量,改善用户搜索體驗。其最常見的表示形式是RDF(三元組),即“實體x關係x另一實體”或“實體x屬性x屬性值”集合,其中節點代表實體或概念,邊代表實體/概念之間的各種語義關係。知識圖譜的構建過程旨在讓計算機更好地理解各行業領域信息,使其具備人的認知能力。基本構建流程包括知識抽取(如實體抽取、關係抽取)、知識融合(如數據整合、實體對齊)、知識加工(如知識推理)等。由於圖數據相對於傳統的關係型數據具有更強大的表達能力,善於處理大量、複雜、互聯、多變的網狀數據,因此圖數據的計算與推理逐漸成為知識圖譜的重要研究任務之一。