虛幻5再次炸場!1部iPhone搞定3A大作級動作捕捉,網友:遊戲行業要變天_風聞

量子位-量子位官方账号-03-26 13:10

Pine 魚羊 發自 凹非寺

量子位 | 公眾號 QbitAI

什麼樣的新技術,能在ChatGPT的包圍圈裏脱穎而出火爆全場?

一部iPhone,兩分鐘,真人大變數字人!

還是表情動態、眼神細節一比一還原的那種。

沒錯,動作捕捉視頻,發佈會現場iPhone錄製,後期處理全過程也都當場完成。

在此之前,這位《地獄之刃》女主演經歷的動捕都是醬嬸的:

複雜的設備必不可少,而且不僅要在臉上標滿定位點,後期花費的時間也還得長達幾周甚至數月。

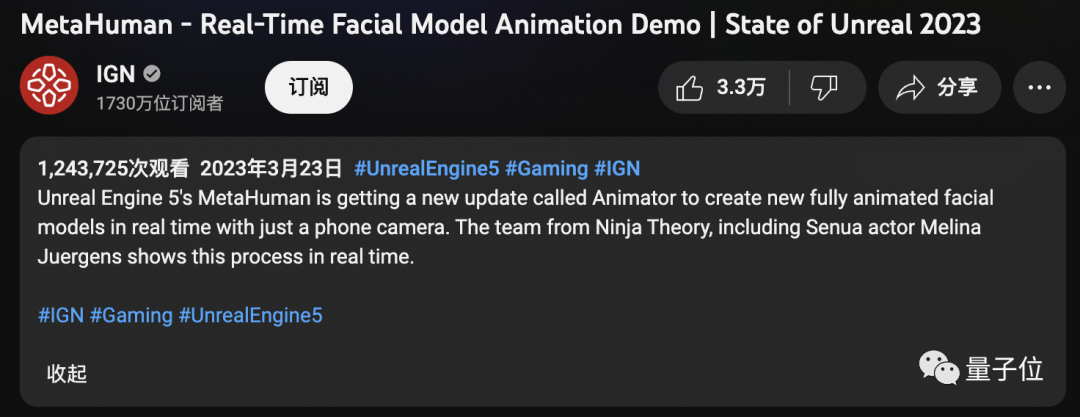

這不,Epic剛把虛幻引擎5這一新能力公佈出來,網友們都炸了鍋了,相關視頻播放量迅速突破百萬。

“現場”氛圍嘛,總結起來就是一通操作猛如虎,網友直呼太瘋狂:

(實現面部建模)從幾個月到幾分鐘,未來幾年遊戲的發展必定是瘋狂的。

還有網友表示,以後再也不能説什麼眼見為真了。

三幀視頻就能生成3D模型

具體來看看,這一名為“MetaHuman Animator”的騷操作,究竟是如何做到兩分鐘搞定面部動捕的。

以現場演示為例。首先,演員要錄製一段視頻,期間可以做出任何表情。可以是誇張的憤怒:

也可以是細小的眼神變化:

並且錄製全程只需一部iPhone。

接下來,技術人員將錄製好的視頻上傳到軟件,整個處理過程都是在本地進行。

總結下來,處理過程分為兩步:

1、最新版本的Live Link Face應用程序會儘可能用最佳的分辨率捕獲所有面部動態;

2、MetaHuman Animator使用視頻和Dev數據將其轉換成高保真的動畫。

在這個過程中,先是用Live Link Face對演員的視頻進行面部動作捕捉。

完成面捕之後,只需要三幀視頻 (正面、左側面、右側面)就能生成演員的“元人類DNA”。

其中用到的算法是定製版面部特徵算法,生成的過程只要幾秒鐘。

這樣一來,所有的面部數據都會被標定,還原出剛剛視頻錄製中的面部表情也就更加容易了。

更重要的是,在這個過程中,可以將真人視頻與生成的建模視頻進行逐幀比較。

然後等幾分鐘不到,完整的動畫視頻就成功生成了,最終工作人員要做的就只有微調和導入音頻。

在新應用的加持下,做到下圖這樣的效果,對於工作人員來説也是信手拈來。

算法細節上,Epic是採用自家“面部求解器”和“標誌檢測器”來確定視頻中人物面部的關鍵操作點。

利用這些關鍵點,基於語義空間解決方案,AI會將每一幀視頻映射到“n維人類空間”數據庫中的最近鄰居上。

這個所謂“n維人類空間”,是Epic在多年來收集到的詳細面部捕捉數據的基礎上,挑選打磨過的龐大數據庫,包含頭部各個部位的各種運動姿態。

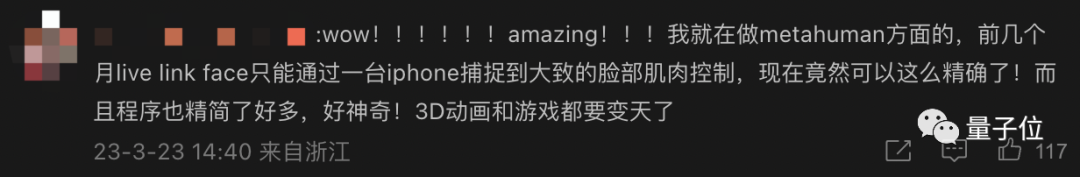

網友:3D動畫和遊戲都要變天了

Epic這波炸場,算是給最近被AI大浪衝擊得恍恍惚惚的人類,又添了一點刺激。

有metahuman領域的網友就説“3D動畫和遊戲都要變天了”:

幾個月前用iPhone還只能捕捉到大致的面部肌肉控制。

不過,相比於各種“失業”現場,對於這項技術,更多人樂見其成。

有網友表示,有了這項技術之後,開發人員直接效率翻倍,能夠節省太多時間,要做的就只有後期潤色。

還有網友已經在期待電影製作人使用這項技術了:

Epic自己則説,新的MetaHuman Animator有利於“複雜角色技術的民主化”。並表示這項新技術有望在今年夏天更廣泛地推出。

那麼,你期待嗎?

參考鏈接:[1] https://www.unrealengine.com/en-US/blog/new-metahuman-animator-feature-set-to-bring-easy-high-fidelity-performance-capture-to-metahumans

[2] https://www.youtube.com/watch?v=pnaKyc3mQVk

[3]https://arstechnica.com/gaming/2023/03/epics-new-motion-capture-animation-tech-has-to-be-seen-to-be-believed/