馬斯克等千名大佬呼籲暫停超強AI研發,中國機遇與挑戰並存_風聞

刘典-复旦大学中国研究院特邀副研究员-03-29 23:07

突然間,馬斯克、圖靈獎得主等千名專家呼籲暫停超強AI研發,至少6個月。

3月15日,OpenAI發佈了多模態預訓練大模型GPT-4,幫助ChatGPT功能再升級。隨後第二天,百度正式發佈了備受矚目的“文心一言”,並開啓了第一批內測。中美兩家企業一前一後推出自主研發大模型人工智能,將這波全球人工智能浪潮推上了高點。然而就在此刻,網上曝出了一封千位大佬的聯名信,要封殺所有比GPT-4強的AI。

01 一封暫停Ai的聯名信

01 一封暫停Ai的聯名信

在這封聯名信上,超過1000位大佬呼籲——我們應該立即停止訓練比GPT-4更強大的AI系統,暫停期至少6個月。目前簽名的有:

圖靈獎得主Yoshua Bengio

Stability AI首席執行官Emad Mostaque

蘋果聯合創始人Steve Wozniak

紐約大學教授馬庫斯

馬斯克

「人類簡史」作者Yuval Noah Harari

……

信中寫道:廣泛的研究表明,具有與人類競爭智能的人工智能系統可能對社會和人類構成深遠的風險,這一觀點得到了頂級人工智能實驗室的承認。正如廣泛認可的“阿西洛馬人工智能原則(Asilomar AI Principles,阿西莫夫的機器人三大法則的擴展版本,於2017年由近千名人工智能和機器人專家簽署,詳細內容見片尾附文)中所述,高級AI可能代表地球生命史上的深刻變化,應該以相應的關照和資源進行規劃和管理。不幸的是,這種級別的規劃和管理並沒有發生,儘管最近幾個月人工智能實驗室陷入了一場失控的競賽,以開發和部署更強大的數字思維,沒有人——甚至他們的創造者——能理解、預測或可靠地控制。

這封信呼籲,所有人工智能實驗室立即暫停訓練比GPT-4更強大的人工智能系統至少6個月。這種暫停應該是公開的和可驗證的,並且包括所有關鍵參與者。如果不能迅速實施這種暫停,政府應介入並實行暫停。

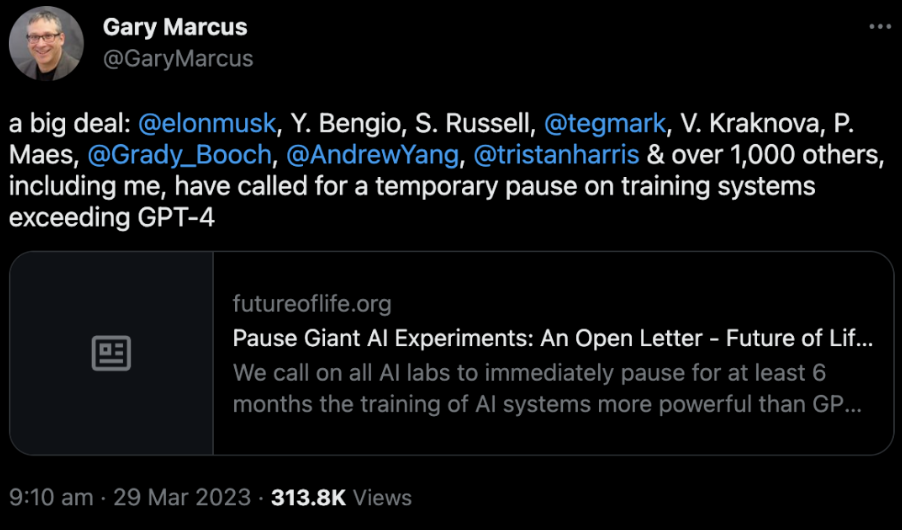

紐約大學教授馬庫斯在這叫媒體轉載公開信

紐約大學教授馬庫斯在這叫媒體轉載公開信

有關人工智能大模型領域技術創新對數字經濟領域生產力進步的討論成為熱點話題。人工智能大模型可以處理和分析比傳統計算機算法更大量、更復雜的數據,從而提高數據分析和決策的準確性和效率,推動數字經濟領域生產力的巨大進步。這次多名大佬公開信更説明國家高度重視人工智能發展的重要性。

2020年4月,國務院發佈《新一代人工智能發展規劃》,指出要充分發揮大數據、雲計算、物聯網等優勢,促進人工智能同實體經濟深度融合。目前,我國人工智能市場規模逐年擴大。2022年,我國人工智能市場規模達到2680億元,已成為全球第二大人工智能市場。隨着人工智能成為新一輪科技革命和產業變革的標誌性技術,不但自身呈現高速增長的勢頭,更能為其他產業轉型升級賦能。

為此,中國正在加速以人工智能大模型技術推動製造業行業轉型升級和經濟發展模式轉變。所以説,發揮人工智能在產業轉型升級中的作用,是推動中國經濟邁向高質量發展的必然要求。

02 危機中的機遇,必須抓住

面對人工智能大模型技術浪潮,中國的挑戰和機遇並存。中國在人工智能大模型領域取得了一定的進展,但仍然缺少良好的創新生態。當前,中國的大模型算力和算法都與美國頂尖大模型存在差距。從技術創新的角度來説,一些中國企業、研發者以及投資者沒能共建一個良好的創新生態,反而更加關注商業化和應用化方面的問題,忽視了底層技術研究的重要性。這種情況的出現主要是由於市場需求和商業回報的壓力。許多企業更傾向於追求短期利益和快速成功,而不注重長遠的科技研發。

反觀美國,由科技企業、科研人員和資本共同打造的創新生態正是美國人工智能模型快速發展的原因之一。其中,資本的長期眼光和耐心尤為重要。在OpenAI成立四個月後,微軟就對其進行了10億美元的投資。2023年微軟再次追加100億美元投資。總的來説,我國產學研界需要更多的共同合作和溝通,為創新提供更多的支持和投入,鼓勵企業和研發者注重長期的投資和研發。

圖片來源於網絡

圖片來源於網絡

但中國的天生優勢也不可忽視,廣泛的商業場景和應用創新為中國發展人工智能大模型提供了良好的環境。得益於我國的海量數據和超大市場的優勢,人工智能的日益成熟將會在各個領域和不同應用場景中加快數實融合步伐,進一步全面賦能經濟社會發展。

**一是人工智能大模型將推動行業數字化和智能化轉型升級。**人工智能產業進入高速發展階段,人工智能的應用場景從硬件擴展到了軟件、服務與平台體系,在工業、農業、醫療領域的行業應用不斷深入。一方面,**人工智能可以通過對大量數據的分析和處理,實現智能化的生產和管理。**例如,通過對生產數據的分析,可以實現預測性維護,避免機器故障和停機時間的浪費,提高生產效率和降低成本。另一方面,**人工智能可以對企業內部和外部的大量數據進行挖掘和分析,**提供全面的數據支持,為企業的決策和業務運營提供更加精準的指導。

以金融行業為例,人工智能大模型的應用將會給金融機構帶來更智能化的風險控制和投資決策。金融機構可以利用人工智能大模型來分析和預測市場變化和風險事件,從而更好地管理風險並減少損失,也可以利用人工智能大模型來分析市場趨勢和數據,預測投資收益和風險,並輔助決策者做出更加科學的投資決策。

二是人工智能大模型將加快推進大數據、雲計算和物聯網的的佈局建設和聯動進程。人工智能通過與新一代信息技術,大數據、雲計算、物聯網、工業互聯網、無人駕駛的融合發展,極大地提高各個商業和應用場景下的勞動生產率。大數據和雲計算既是人工智能大模型的基礎,也因為人工智能高效的採集、存儲和分析才有了意義。

同時,**人工智能也可以為物聯網提供更加智能化的應用。**人工智能技術可以對海量的物聯網數據進行分析和處理,從而提供更加準確的預測和決策支持。例如,在智能製造領域,人工智能可以對生產線上的傳感器數據進行分析,從而優化生產過程並提高產品質量。

03 亟待更大政策支持

北京市經濟和信息化局於2月13日發佈的《2022年北京人工智能產業發展白皮書》中,明確提出支持頭部企業打造對標ChatGPT的大模型,着力構建開源框架和通用大模型的應用生態。大力發展國產人工智能大模型,充分發揮應用支撐作用,全面賦能各行各業高質量發展,是我國走好數實融合發展之路的關鍵所在。隨着國內人工智能技術的創新和發展,為行業提供更多的創新機遇和發展空間。

來源:北京市政府官方網站

來源:北京市政府官方網站

人工智能發展同步帶來的風險對治理能力提出了更高的要求。這主要是因為人工智能所存在的倫理風險和監管問題。

一方面是**人工智能大模型回答的誤導性問題和潛在的失控風險。**由於訓練數據的偏差和算法的設計問題,人工智能可能會出現偏見和歧視,也包括向公眾傳播虛假信息和錯誤信息。在醫療衞生和金融領域,人工智能大模型的訓練和決策過程往往是不透明的,這意味着用户無法理解模型如何得出答案。這可能會導致誤導性的答案和潛在的失控風險。而人工智能作為工具,也有可能被用作犯罪活動和政治活動,引發不可控的風險。對於大多數人來説,誤導性的回答更是存在引起羣體激進化和政治分化的風險。但目前各國都沒有完善的監管框架來規制由人工智能所產生的誤用和濫用問題。

另一方面,**人工智能技術也意味着許多傳統的工作崗位可能會大面積減少或消失。**根據OpenAI發佈的報告,人工智能驅動的聊天技術可能嚴重影響美國19%的工作崗位。OpenAI的首席執行官山姆·阿爾特曼也承認,儘管類似的技術可能會釋放更多的生產力,也意味着許多人將因此失去工作,因此人們需要去適應和掌握類似的技術。人工智能未來的迭代將影響人們的工作方式,而社會和政策制定者需要為此提前做好準備。

未來中國人工智能應用場景廣闊。在中國的產業互聯網和數字化轉型進程中,人工智能已經被廣泛應用,涉及到許多不同領域,例如智能製造、智慧城市、金融科技、醫療健康、智能交通等。

當前中國主要的人工智能大模型有百度文心大模型、阿里通義大模型、騰訊混元大模型、華為盤古大模型等,其中最近最受矚目的就是百度的文心大模型。國外專家已經開始意識到人工智能危機的時刻,中國的人工智能大模型起步卻相對較晚,openAI已經發布到Gpt-4,拋開此次公開信來説,其後續發展速度不可限量。這時百度看準時機快速發佈其同類型產品,實數難能可貴。近期科技部啓動“人工智能驅動的科學研究”專項部署工作,佈局“人工智能驅動的科學研究”前沿科技研發體系,從人工智能的研究提供政策支持,未來,**我國更應加緊建設良好的科技創新生態建設,加速推進國產大模型的研發和更進。**從硬件、軟件、機制等方面協同發力,加強關鍵技術的研究開發,提高大模型產業鏈上關鍵基礎設施的自主可控度。利用我國廣闊市場和海量數據優勢,為人工智能技術應用和商業化創新場景,加速數實融合發展。同時,同步加強和完善人工智能領域的法律和規則建設工作,確保發展的安全性和規範性。

——附文《阿西洛馬人工智能原則 23 條》——

Asilomar AI Principles

阿西洛馬人工智能原則 23 條

Research Issues 科研問題

1) Research Goal: The goal of AI research should be to create not undirected intelligence, but beneficial intelligence.

**研究目的:**人工智能研究的目標,應該是創造有益(於人類)而不是不受(人類)控制的智能。

2) Research Funding: Investments in AI should be accompanied by funding for research on ensuring its beneficial use, including thorny questions in computer science, economics, law, ethics, and social studies, such as:

**研究經費:**投資人工智能應該有部份經費()用於研究如何確保有益地使用人工智能,包括計算機科學、經濟學、法律、倫理以及社會研究中的棘手問題,比如:

How can we make future AI systems highly robust, so that they do what we want without malfunctioning or getting hacked?

如何使未來的人工智能系統高度健全(“魯棒性”),讓系統按我們的要求運行,而不會發生故障或遭黑客入侵?

How can we grow our prosperity through automation while maintaining people’s resources and purpose?

如何通過自動化提升我們的繁榮程度,同時維持人類的資源和意志?

How can we update our legal systems to be more fair and efficient, to keep pace with AI, and to manage the risks associated with AI?

如何改進法制體系使其更公平和高效,能夠跟得上人工智能的發展速度,並且能夠控制人工智能帶來的風險?

What set of values should AI be aligned with, and what legal and ethical status should it have?

人工智能應該歸屬於什麼樣的價值體系?它該具有何種法律和倫理地位?

3) Science-Policy Link: There should be constructive and healthy exchange between AI researchers and policy-makers.

**科學與政策的聯繫:**在人工智能研究者和政策制定者之間應該有建設性的、有益的交流。

4) Research Culture: A culture of cooperation, trust, and transparency should be fostered among researchers and developers of AI.

**科研文化:**在人工智能研究者和開發者中應該培養一種合作、信任與透明的人文文化。

5) Race Avoidance: Teams developing AI systems should actively cooperate to avoid corner-cutting on safety standards.

**避免競爭:**人工智能系統開發團隊之間應該積極合作,以避免安全標準上的有機可乘。

Ethics and values 倫理和價值

6) Safety: AI systems should be safe and secure throughout their operational lifetime, and verifiably so where applicable and feasible.

**安全性:**人工智能系統在它們整個運行過程中應該是安全和可靠的,而且其可應用性的和可行性應當接受驗證。

7) Failure Transparency: If an AI system causes harm, it should be possible to ascertain why.

**故障透明性:**如果一個人工智能系統造成了損害,那麼造成損害的原因要能被確定。

8) Judicial Transparency: Any involvement by an autonomous system in judicial decision-making should provide a satisfactory explanation auditable by a competent human authority.

**司法透明性:**任何自動系統參與的司法判決都應提供令人滿意的司法解釋以被相關領域的專家接受。

9) Responsibility: Designers and builders of advanced AI systems are stakeholders in the moral implications of their use, misuse, and actions, with a responsibility and opportunity to shape those implications.

**責任:**高級人工智能系統的設計者和建造者,是人工智能使用、誤用和行為所產生的道德影響的參與者,有責任和機會去塑造那些道德影響。

10) Value Alignment: Highly autonomous AI systems should be designed so that their goals and behaviors can be assured to align with human values throughout their operation.

**價值歸屬:**高度自主的人工智能系統的設計,應該確保它們的目標和行為在整個運行中與人類的價值觀相一致。

11) Human Values: AI systems should be designed and operated so as to be compatible with ideals of human dignity, rights, freedoms, and cultural diversity.

**人類價值觀:**人工智能系統應該被設計和操作,以使其和人類尊嚴、權力、自由和文化多樣性的理想相一致。

12) Personal Privacy: People should have the right to access, manage and control the data they generate, given AI systems’ power to analyze and utilize that data.

**個人隱私:**在給予人工智能系統以分析和使用數據的能力時,人們應該擁有權力去訪問、管理和控制他們產生的數據。

13) Liberty and Privacy: The application of AI to personal data must not unreasonably curtail people’s real or perceived liberty.

**自由和隱私:**人工智能在個人數據上的應用不能充許無理由地剝奪人們真實的或人們能感受到的自由。

14) Shared Benefit: AI technologies should benefit and empower as many people as possible.

**分享利益:**人工智能科技應該惠及和服務儘可能多的人。

15) Shared Prosperity: The economic prosperity created by AI should be shared broadly, to benefit all of humanity.

**共同繁榮:**由人工智能創造的經濟繁榮應該被廣泛地分享,惠及全人類。

16) Human Control: Humans should choose how and whether to delegate decisions to AI systems, to accomplish human-chosen objectives.

**人類控制:**人類應該來選擇如何和決定是否讓人工智能系統去完成人類選擇的目標。

17) Non-subversion: The power conferred by control of highly advanced AI systems should respect and improve, rather than subvert, the social and civic processes on which the health of society depends.

**非顛覆:**高級人工智能被授予的權力應該尊重和改進健康的社會所依賴的社會和公民秩序,而不是顛覆。

18) AI Arms Race: An arms race in lethal autonomous weapons should be avoided.

**人工智能軍備競賽:**致命的自動化武器的裝備競賽應該被避免。

Longer-term Issues 更長期的問題

19) Capability Caution: There being no consensus, we should avoid strong assumptions regarding upper limits on future AI capabilities.

**能力警惕:**我們應該避免關於未來人工智能能力上限的過高假設,但這一點還沒有達成共識。

20) Importance: Advanced AI could represent a profound change in the history of life on Earth, and should be planned for and managed with commensurate care and resources.

**重要性:**高級人工智能能夠代表地球生命歷史的一個深刻變化,人類應該有相應的關切和資源來進行計劃和管理。

21) Risks: Risks posed by AI systems, especially catastrophic or existential risks, must be subject to planning and mitigation efforts commensurate with their expected impact.

**風險:**人工智能系統造成的風險,特別是災難性的或有關人類存亡的風險,必須有針對性地計劃和努力減輕可預見的衝擊。

22) Recursive Self-Improvement: AI systems designed to recursively self-improve or self-replicate in a manner that could lead to rapidly increasing quality or quantity must be subject to strict safety and control measures.

**遞歸的自我提升:**被設計成可以迅速提升質量和數量的方式進行遞歸自我升級或自我複製人工智能系統,必須受制於嚴格的安全和控制標準。

23) Common Good: Superintelligence should only be developed in the service of widely shared ethical ideals, and for the benefit of all humanity rather than one state or organization.

**公共利益:**超級智能的開發是為了服務廣泛認可的倫理觀念,並且是為了全人類的利益而不是一個國家和組織的利益。