去年股價跌去四分之三的meta,元宇宙的故事才剛剛開始_風聞

差评-差评官方账号-04-23 08:13

本文原創於微信公眾號:差評 作者:差評君

在各種 AI 新聞滿天飛的 2023 年,大家還記得大明湖畔的元宇宙嗎?

在各種 AI 新聞滿天飛的 2023 年,大家還記得大明湖畔的元宇宙嗎?

至少從大夥們討論度上來看。。。是有點涼透了的意思。

最近一次上熱搜,也只剩林俊杰元宇宙血虧 90% 這類的被套牢新聞。

而其中,曾扯着嗓子高調梭哈,甚至不惜押上了姓名的 **Meta ,**更成了大夥們的笑料。

先是去年 10 月份股價一度較最高點跌去 75% 。

而後今年在其他科技大廠大模型滿天飛, AI 發佈會都快開了一輪的情況下。

這個 Meta ,好像除了裁員**,還是****裁員。**

“ 呦 ~ 扎哥你是不是因為搞元宇宙又裁員了。 ”

“ 呦 ~ 扎哥你是不是因為搞元宇宙又裁員了。 ”

“ 隨後什麼降本增效啊,為社會輸送人才啊,一句句冒了出來,到處充滿了歡聲笑語。 ”

就連隔壁部門的同事,都玩着類似的梗。。。並問着差評君,Meta 在AI時代咋掉隊了?他們還元得下去不?

不過,笑歸笑,鬧歸鬧,咱還真別拿 Meta 的人工智能開玩笑。

差評君在這兒,直接給大家先省個流,那就是 Meta 在 AI 領域,還真不是大家眼中的軟蛋。

並且給個暴論啊( 不構成投資建議),他們離自己的元宇宙目標可能還更近了。

這麼説吧,雖然 Meta 官方在大模型的聲量和宣傳上,確實沒別家高,但 Meta 的人工智能技術,在世界範圍內,還真沒有誰能説它不行。

深度學習框架這個東西大家曉得伐?

深度學習框架這個東西大家曉得伐?

這個東西是用來方便開發訓練深度學習模型的,相當於 AI 界的操作系統。

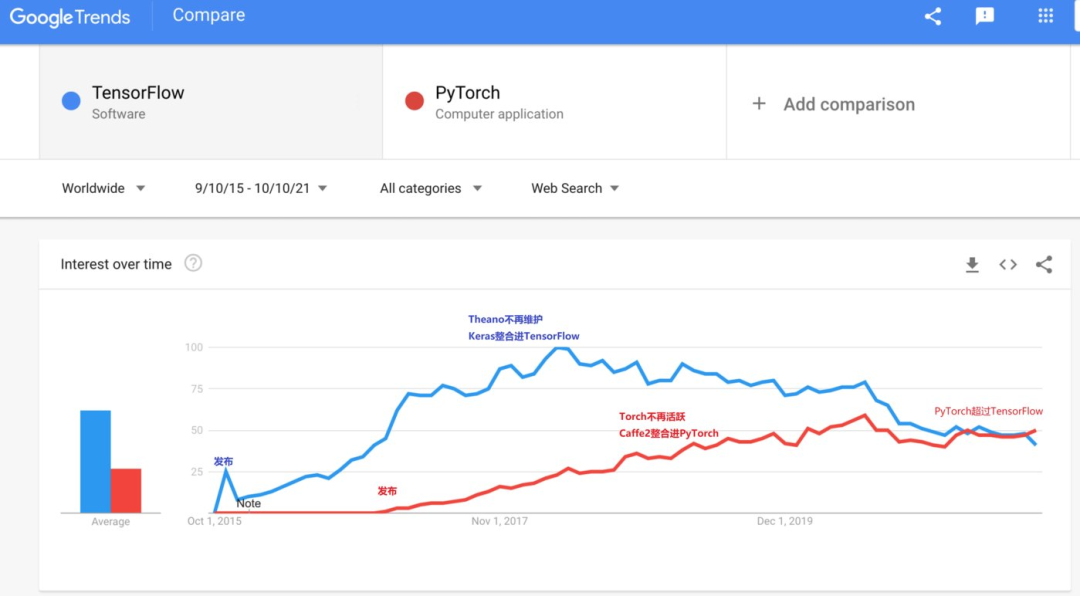

在 17 、 18 年這會兒,市場上佔據最多使用率的,還是人谷歌大名鼎鼎的 TensorFlow 。

這個時候的 TensorFlow 可以説是眼中毫無對手,畢竟 15 年發家,大量人力維護更新,自開源後就把市場上的其它深度學習框架擠得沒有生存空間了。

可沒想到,谷歌這好日子過了還沒多久,半路突然殺出來一個程咬金, Pytorch 發佈了,這個由當時還叫 Facebook 的公司主導開發的深度學習框架,從易用性着手,自發布之後,用户一路走高。

並在 19 年逆襲谷歌,成為目前最受歡迎的深度學習框架。

但好漢總不能只提當年勇,如今大火大語言模型,Meta其實也不拉**,只是人家沒有專門開發佈會發佈而已。**

但好漢總不能只提當年勇,如今大火大語言模型,Meta其實也不拉**,只是人家沒有專門開發佈會發佈而已。**

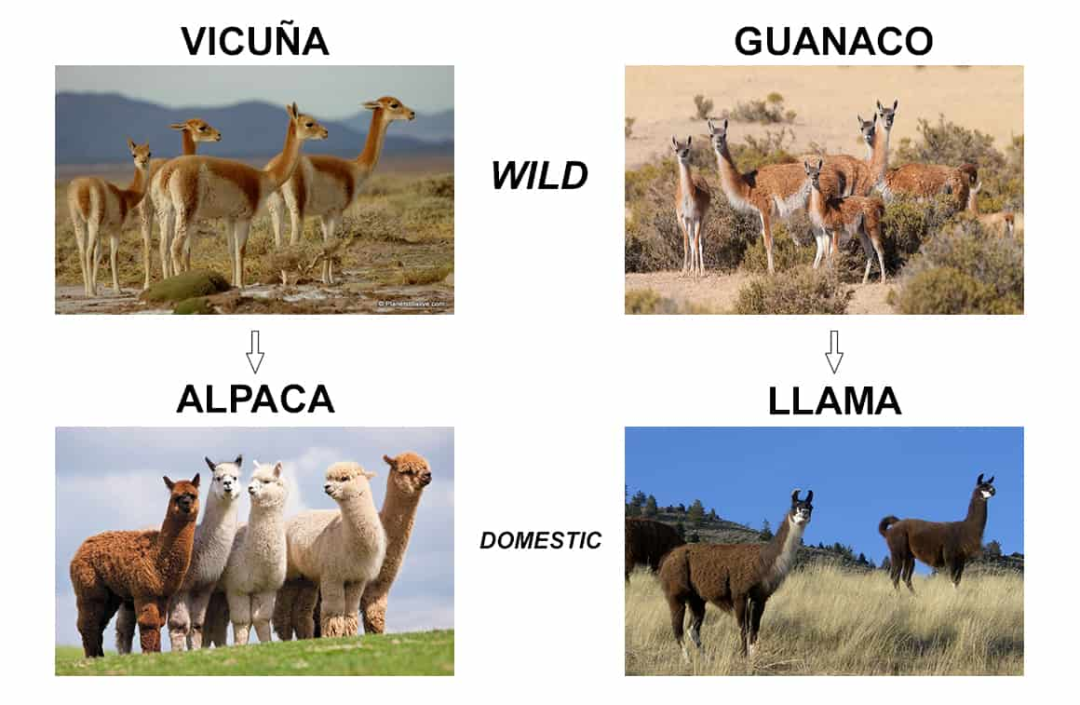

它們家的大語言模型 LLaMA ,也就是羊駝( 或者翻譯成:草泥馬 ),在圈兒內的名聲,完全不輸 GPT 。

本來呢,這個模型是隻釋放給一些科研機構用作研究用的,結果,不知道哪個小崽子,腦子一熱,就給公開到網上去了。

好傢伙,不公開不要緊,這一公開,各種各樣復刻 ChatGPT 的項目就來了。

什麼斯坦福的羊駝只要 100 美元就能比肩 GPT3.5 啊。。。

又是什麼 UC 伯克利的 “ 小羊駝 ”130 億參數平替 ChatGPT 啊。

感覺是個人就能出大語言模型的樣子。。。

感覺是個人就能出大語言模型的樣子。。。

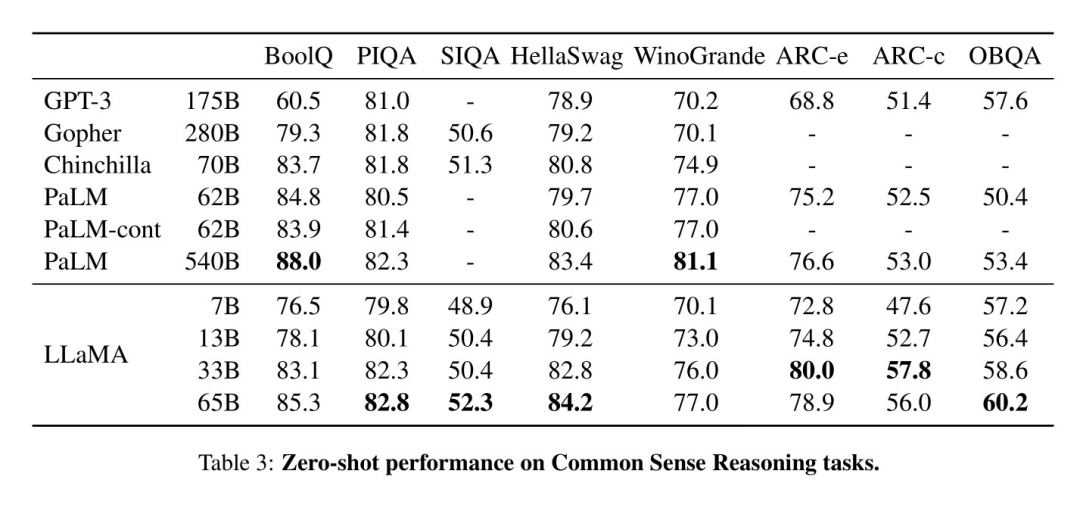

而且,據他們測試,這個 LLaMA 在很多項的能力比拼下,是優於 GPT-3 的。。。

到現在,這個模型已經在各大機構大佬的努力勞作下,開枝散葉,誕生了一批 “ 羊駝家族 ” 了。。。

甚至可以説現在的學術圈和開源社區,已經是一隻只草泥馬的形狀了。

在另一個人工智能領域, CV ( 計算機視覺 )圈, Meta 的動靜可就更大了。

在另一個人工智能領域, CV ( 計算機視覺 )圈, Meta 的動靜可就更大了。

4 月 5 號, Meta 就發佈了一個用於圖像分割的 AI 大模型:Segment Anything Model 。

就和它的名字一樣,這個模型可以識別圖像和視頻中的物體,並且一鍵剪切任何圖像中的任何對象。

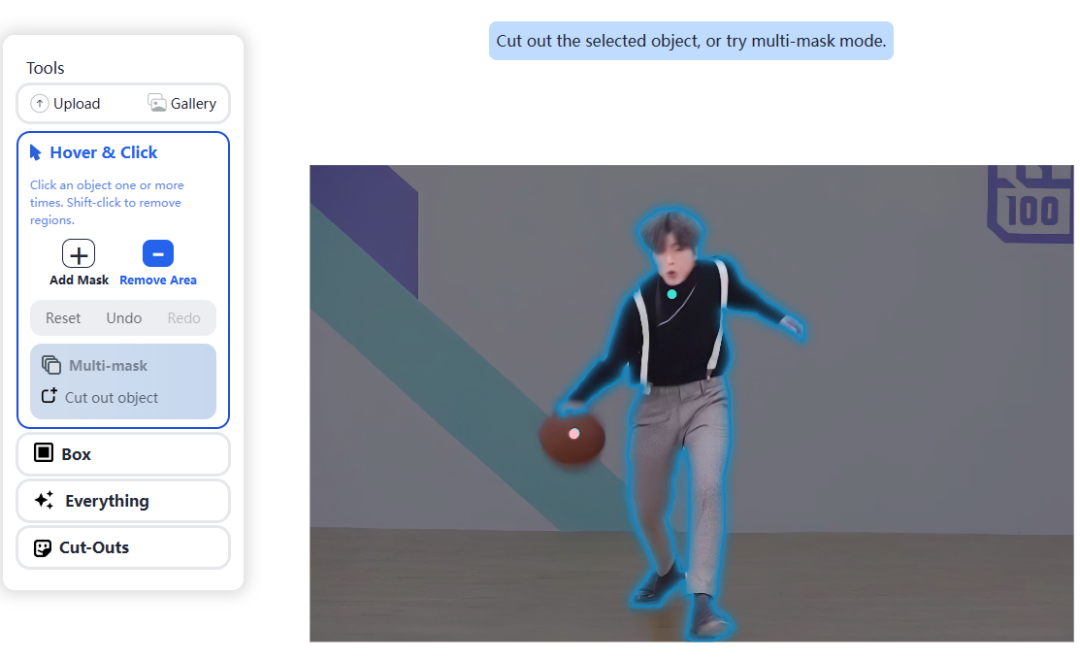

在官網的演示中,比如這張男子打籃球的圖片,只需要給圖片中的物體標一個點,就能自動切割出咱們想要的主體。

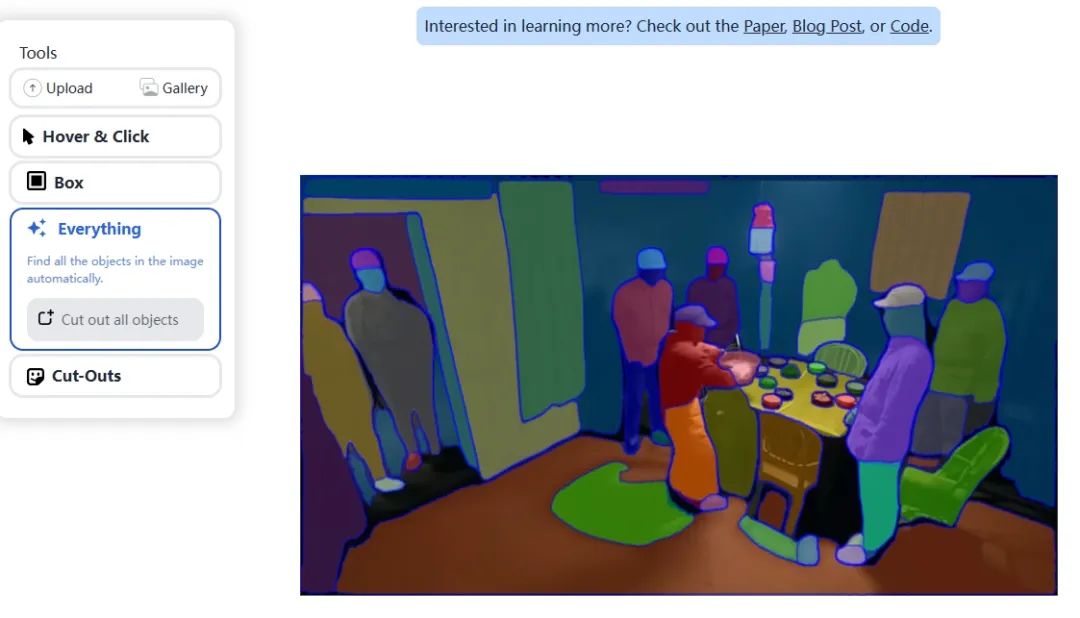

甚至,如果有一些圖片過於複雜,你自己都懶得去點標記的話,你還可以把分割的任務全權交給 SAM ,直接點擊 Everthing ,它就自動幫你把圖片中的可分割物體切割出來。

整個過程方便簡單快捷。

所以,這個模型一經推出,眾多 CV 界師生紛紛大喊:CV 不存在了。

所以,這個模型一經推出,眾多 CV 界師生紛紛大喊:CV 不存在了。

原因就是他把現在 CV 比較熱門的方向,比如目標檢測,圖像分類,物體分割等等,差不多都解決得很好了。

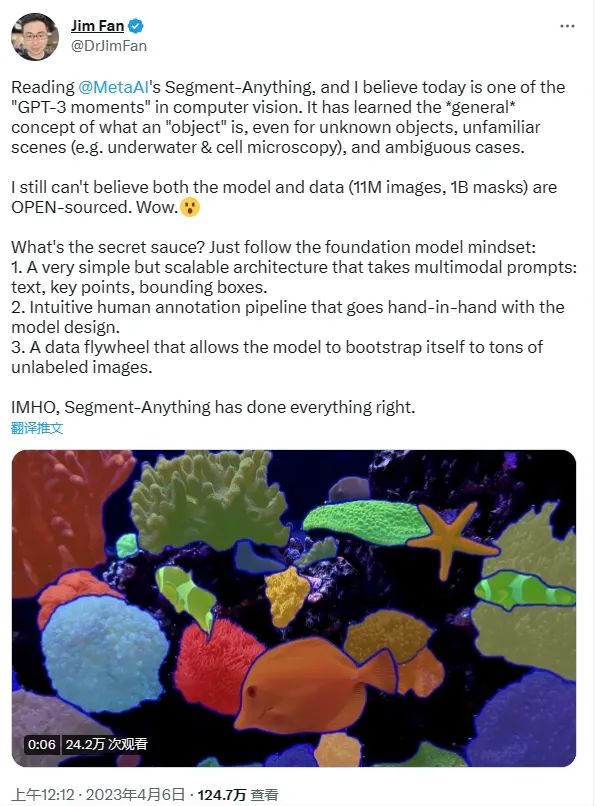

英偉達的人工智能科學家 Jim Fan ,甚至還把 SAM 的出現比喻成 CV 界的 “GPT-3 時刻 ” ,可見各位業內人士對 SAM 的認可了。

但,這還不是結束,僅僅就在幾天前。

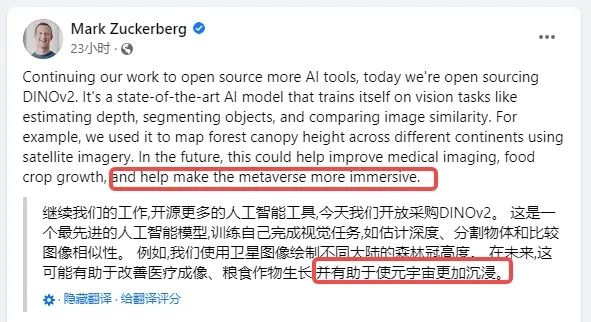

咱們的扎哥又親自通過臉書,宣佈開源了另一個重磅模型, DINO V2 。

同樣的也是 CV 方向,但這個 DINO V2 可不僅僅只能對圖像進行識別、分類、分割了。

它還能通過一張二維的圖片,去估計場景的三維深度,比如下圖右邊的灰度圖,就是通過左邊的場景估算生成的。

深度圖記錄了整個場景的深度信息,有了這個深度信息,你甚至能從一張平面的圖像中,建模出一個 3 維的場景。

另外, DINO V2 的圖像特徵提取功能 + 語義分割,更是把以圖搜圖的能力抬到了另外一個台階。

另外, DINO V2 的圖像特徵提取功能 + 語義分割,更是把以圖搜圖的能力抬到了另外一個台階。

以往的以圖搜圖,只能搜索相似的畫面。

但是加上了特徵提取和語義分割之後,你不僅能搜索到相似的圖片,還能以單個圖像特徵為條件,搜索不同風格的圖片。

只要是 CV 類的任務,這個 DINO V2 基本都能作為任務的主幹去完成。

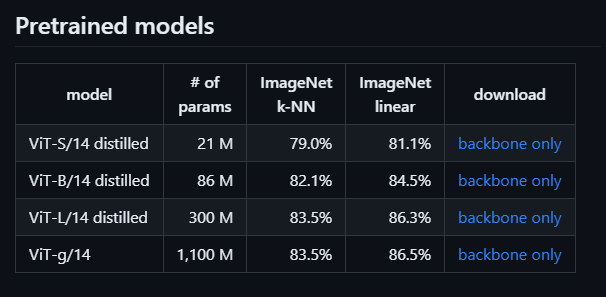

而且,從官方提供的四個預訓練模型來看,這四個面模型,參數最高的一個, ImageNet Linear 精度最大達到了 86.5% 。

在之前,同領域表現最好的 OpenClip ,其所預訓練出來的模型,表現最好的精度也只有 80.1%

不管是 Pytorch 、 LLaMA 、 SAM ,還是 DINO V2 ,上面的這些成果,其實大都來自 Meta 的兩個專攻 AI 的實驗室。

不管是 Pytorch 、 LLaMA 、 SAM ,還是 DINO V2 ,上面的這些成果,其實大都來自 Meta 的兩個專攻 AI 的實驗室。

其中一個是 Facebook ’ s Artificial Intelligence Research ,簡稱 FAIR ,主攻研發,另一個則是 Applied Machine Learning ,主攻應用落地。

而且他們的研究基本全部開源, 在測試可用後,你都能在開源網站上找到項目的源碼。

所以説,Meta 不但沒有在 AI 時代掉隊,反而已經屬於靠前的梯隊。

那麼説了這麼多,**它們和小扎一直掛在嘴邊的元宇宙,**有啥毛線關係呢?

其實早在 16 年的開發者大會上,小扎就給出了在公司未來的發展方向上,給出了三步走的計劃。

第一步,先要連接世界,這個就是扎哥的老本行了,社交網絡。

第一步,先要連接世界,這個就是扎哥的老本行了,社交網絡。

第二步,以人工智能為核心,打造連接世界的技術核心,這也是它們從好幾年前一直做的事情。

而第三步的 VR 和 AR 嘛。。。要放到現在,翻譯翻譯,這還是元宇宙。。。

所以説發展 AI,早在小扎的小本本上。

咱們也回頭看看一下之前 Meta 那些無論是大模型、還是計算機視覺的開源項目,在某種程度上,其實都是在降低 AI 使用的門檻。

而 AI 的發展,又能推動元宇宙的建設。

可以細品一下幾天前,小紮在發佈 DINO V2 時臉書上寫的這麼一句話:

可以細品一下幾天前,小紮在發佈 DINO V2 時臉書上寫的這麼一句話:

“ 在未來,這可能有助於改善醫療成像、糧食作物生長,並有助於使元宇宙更加沉浸。 ”

説白了小紮在 “ 元宇宙 ” 的路上不僅沒自認折戟,反而可能更加自信了。

而隨着 AI 技術的持續發展,特別是 AIGC 的普及,各種AI建模,AI繪圖,AI音樂等工具的出現。。。

説不定真能讓元宇宙裏的內容越來越多,越來越逼真。

説不定真能讓元宇宙裏的內容越來越多,越來越逼真。

反正在使用過了不少大語言模型,被無數以假亂真的AI圖震撼過之後。。。。

元宇宙這個不久前還那麼縹緲的概念,在 AI 的助力下,好像也沒那麼的玄了。

圖片、資料來源:

DINOv2 by Meta AI 演示地址。

FaceBook最新的圖像分割模型SegmentAnything到底有多厲害?

知乎 - 有問題,就會有答案

https://baijiahao.baidu.com/s?id=1763489271537430409&wfr=spider&for=pc

OpenCLIP

Nikolaj Buhl : Segment Anything 模型 (SAM) 解釋_踏實鑽研的博客-CSDN博客

www.cnbeta.com.tw Meta開放 那個元宇宙

Yahoometa 裁員

夢想家扎克伯格為Facebook插上人工智能之翼 - 點滴網