全球法治觀察 | 以制度創新賦能ChatGPT等生成式人工智能技術的有序發展_風聞

大湾区评论-大湾区评论官方账号-事实、洞见、影响。04-27 14:33

導讀**· 2023.04.26**

“全球法治觀察"專欄持續關注制度範式與法律規則應如何回應ChatGPT等人工智能技術給經濟和社會帶來的衝擊。人工智能充分體現了技術創新的“一體兩面”,隨着技術的迭代發展,監管原則和行業標準也在校準和適配。本文從美國聯邦政府出台的相關法律出發,簡析《AI問責政策》對人工智能技術的包容和審慎的監管,闡釋了美國政府如何通過頂層設計賦能人工智能技術與規則的發展。

無論是美國還是中國,都希望通過制度建設做到對國家信息安全和個人信息保護的整體可控,在促進行業自律、有序發展的同時,不扼殺技術創新帶來的機遇。由於美國的生成式人工智能技術發展較快,其相關政策與規範作為他山之石,能為我國進一步完善人工智能服務管理規範體系提供一定參考。

引言

由OpenAI公司開發的生成式人工智能技術,已經成為了2023年首個現象級熱點,在產業政策、技術迭代、風險投資、教學科研、社會倫理、政治生態等諸多領域引爆了激烈探討,也對現有制度範式與法律規則能否有效應對人工智能帶來的的負面效應,優化其積極的經濟與社會效能,提出系統的挑戰。(可參考專欄上一篇《ChatGPT等AI工具的數據合規風險》)

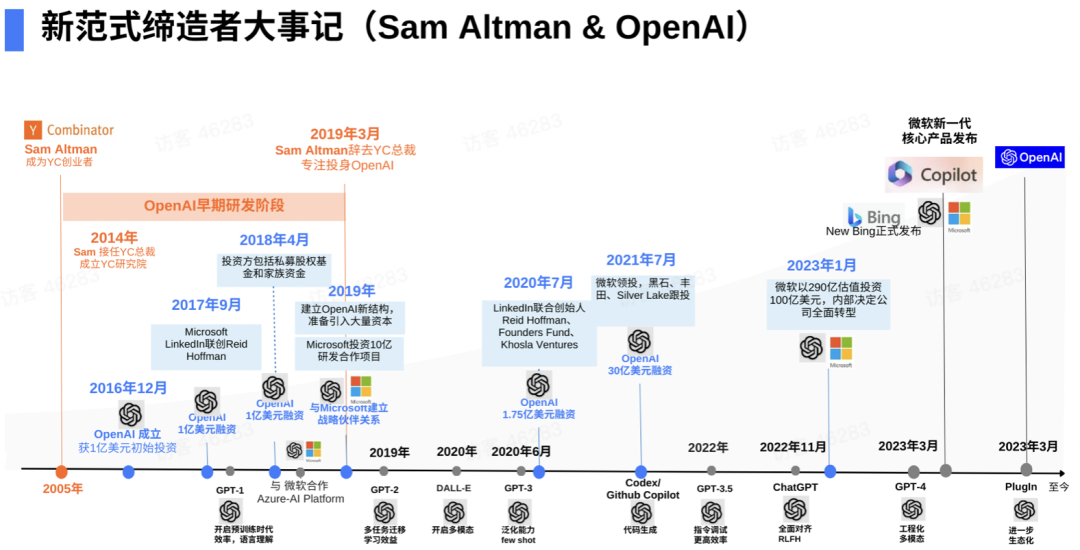

圖源:陸奇《我的大模型世界觀》

3月23號,生命未來研究所(Future of Life Institute)發佈了名為“暫停巨型人工智能實驗”的公開信(Pause Giant AI Experiments: An Open Letter),呼籲全球範圍內的人工智能實驗室停下“飛奔的腳步”,暫停比GPT-4更強大的人工智能系統的訓練至少6個月,並在此期間開發制定一套共享安全協議(shared safety protocols),並由獨立第三方專家進行評測、監督。

3月31日,意大利“個人數據保護局”(Garante Per La Protezione Dei Dati Personali,GPDP)繼在2月3日宣佈取締了“Replika”智能聊天程序之後,又宣佈出於用保護户隱私數據和未成年人利益的考慮,暫時封禁ChatGPT 以限制OpenAI公司處理意大利用户信息。OpenAI公司必須在20天內通報採取了哪些措施來確保用户數據隱私,否則將被處以最高2000萬歐元或公司全球年營業額4%的罰款。

圖源:意大利“個人數據保護局”官網

4月11日,為促進生成式人工智能技術在我國的健康發展和規範應用,國家互聯網信息辦公室(網信辦)也公佈了《生成式人工智能服務管理辦法(徵求意見稿)》(以下簡稱《管理辦法(徵求意見稿)》),向社會公開徵求意見。對“基於算法、模型、規則生成文本、圖片、聲音、視頻、代碼等內容”的生成式人工智能服務與產品,《管理辦法(徵求意見稿)》草案提出了真實性、準確性、合法性等合規要求。

無獨有偶,在網信辦公佈《管理辦法(徵求意見稿)》的當日,隸屬於美國商務部的“國家電信和信息管理局”(National Telecommunications and Information Administration,NTIA),也發佈了《人工智能問責政策(徵求意見書)》(AI Accountability Policy Request for Comment)(以下簡稱《AI問責政策》),就如何確保AI系統的合法性、有效性、道德性、安全性與信賴性(legal, effective, ethical, safe, and trustworthy),以及是否要求新人工智能模型在發佈前應經過認證程序等諸多規範措施,向公眾徵求立法建議。

本篇觀察從特朗普、拜登兩任總統期間美國政府發佈的標誌性法律為出發點,簡要分析了美國商務部此次發佈的《AI問責政策》的主要內容,闡釋了人工智能技術監管的美國政策與規範重點,為我國進一步完善人工智能服務管理規範體系,提供一定的借鑑參考。

頂層設計:

賦能AI技術發展與規則創新

2021年1月,在聯邦參、眾兩院再次以三分之二多數票表決,推翻時任特朗普總統的否決後,美國2021財年《國防授權法》在未得到總統簽字的情況下成為了聯邦法律。據此,收錄於《國防授權法》第五篇的《國家人工智能行動法》(Division E—National Artificial Intelligence Initiative Act of 2020)也正式生效。

美國“國家人工智能行動辦公室”徽標

(圖源:官網)

《國家人工智能行動法》規定了一系列雄心勃勃的人工智能產業計劃,比如成立“國家人工智能行動辦公室”(National AI Initiative Office),作為聯邦政府人工智能聯絡中心,以統一協調政府部門和私人公司之間的溝通與合作。

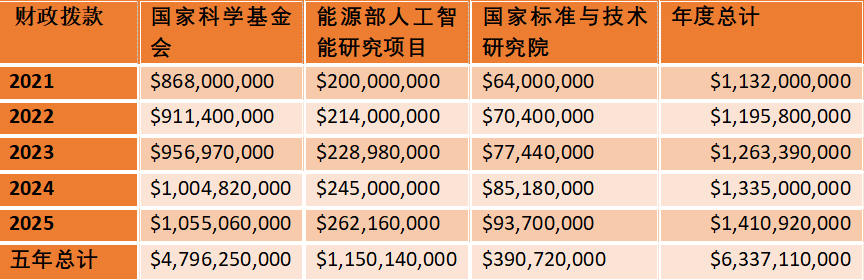

《國家人工智能行動法》也要求美國砸以重金,明確規定在其後的五個財政年度,分別向“國家科學基金會”(National Science Foundation)撥款47.96億美元,“能源部人工智能研究項目”(Department of Energy Artificial Intelligence Research Program)撥款11.50億美元,“國家標準與技術研究院”(National Institute of Standards and Technology)撥款3.91億美元,一方面大力促進人工智能技術與產業的創新發展,另一方面促進人工智能最佳規則和標準的研究制定,以確保美國繼續在技術與制度兩方面,引領全球人工智能的競爭發展。

數據:美國2021財年《國防授權法》

**拜登總統入主白宮之後,美國政府進一步加強了頂層設計,以賦能人工智能的技術與規則發展。**特別是,2022年10月,美國白宮科技政策辦公室(White House Office of Science and Technology Policy, OSTP)正式發佈了《人工智能權利法案藍圖:讓自動化系統為美國人民服務》(The Blueprint for an AI Bill of Rights: Making Automated Systems Work for The American People),再次為人工智能和其他自動化系統的設計、開發和部署提供了重要的制度賦能。

《人工智能權利法案藍圖》指出,人工智能自動化系統已經帶來了諸多非凡的好處,比如高效的農業種植技術、預測風暴路徑的計算機,以及能識別病患疾病的算法。但是,人工智能自動化系統也給美國社會帶來了諸多負面影響,比如用於招聘考核和信用評估的算法加深了歧視性的社會偏見,違反了種族平等原則;而社交媒體公司,在用户不知情或未同意的情況下,大量數據收集個人信息,嚴重侵犯了用户隱私與數據安全。

圖源:網絡

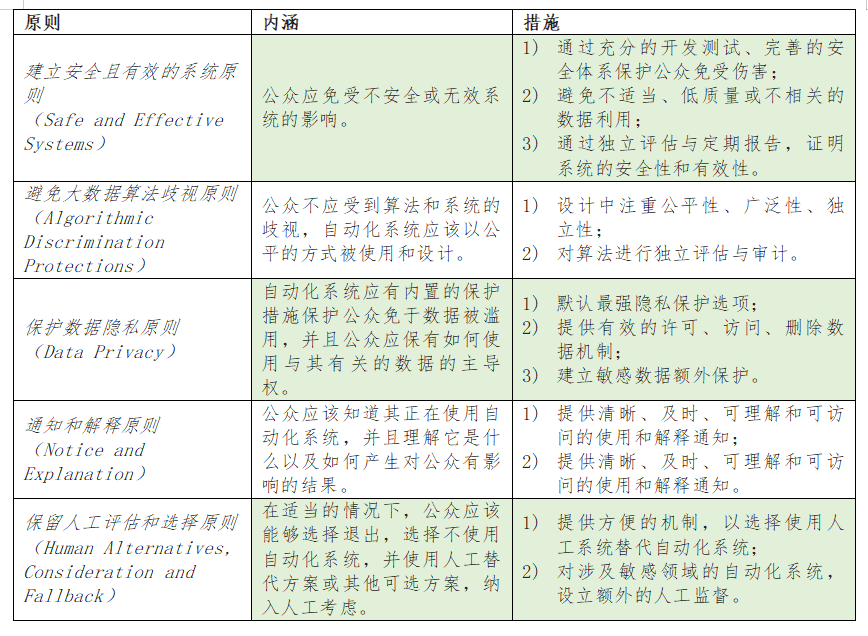

針對人工智能技術系統對於美國人民權利與政治生態的影響,《人工智能權利法案藍圖》提出了五大基本原則,以及一系列具體的應對措施:

圖源:作者製圖

規則落地:

《AI問責政策》體現的包容審慎監管

成立於1978年的國家電信和信息管理局(National Telecommunications and Information Administration,NTIA)是隸屬於美國商務部的一個專門機構,負責向總統及其它聯邦政府部門提供有關電信和信息政策建議。早在2018年7月,NTIA就曾以國家安全和執法風險為理由,建議美國聯邦通信委員會(FCC)拒絕中國移動在美提供國際電信服務的《通信法》第214條許可請求。

圖源:NTIA官網

4月11日,國家電信和信息管理局(National Telecommunications and Information Administration,NTIA),在其官網發佈《人工智能問責政策(徵求意見書)》(AI Accountability Policy Request for Comment)(以下簡稱《AI問責政策》)。通過這次公開徵詢,NTIA將為拜登政府就人工智能系統風險和監管,提供採取全面的聯邦立法規範參考建議。

《AI問責政策》指出,鑑於人工智能和算法系統的潛在風險,在向市場推出人工智能產品與服務時,須保證AI系統是合法的、有效的、合乎道德的、安全的與值得信賴的(legal, effective, ethical, safe, and trustworthy)。使用AI技術與服務的消費者,不論是企業還是個人,都有權知道相關AI系統是否已經建立了充分的保護機制,並通過了政府或者第三方的安全測評,足以有效地管控與AI產品與服務伴生的風險。

因此,正如食品和汽車在沒有適當安全保障的情況下不能投放市場一樣,在提供人工智能系統產品與服務時,相關AI開發公司也應向公眾、政府和企業提供相應的信任保障。具體而言,NTIA就如何完善人工智能問責體系,在《AI問責政策》中向公眾提出了以下六大主題,總計34道極為詳盡的立法徵詢。

1. AI問責的目標

比如:人工智能問責機制(如認證、審計和評估)的目的是什麼?考慮到生成式人工智能工具(如大型語言模型ChatGPT或其他通用人工智能或基礎模型)可能整合到下游產品中,人工智能問責機制如何告知人們這些工具如何運作和/或這些工具是否符合值得信賴的AI標準?

2. 現有立法資源和範式

比如:在問責政策中,公平、安全、有效、透明和值得信賴等常用術語的最佳定義是什麼?在哪些方面,這些術語可以在不同部門和司法管轄區之間具有相同的含義?在哪些方面,術語的含義因司法管轄區、部門或用例而有所不同?從網絡安全、隱私、金融或其他領域的問責過程和政策中,我們可以學到哪些經驗教訓?

3. 問責主體

比如:人工智能價值鏈或供應鏈具有複雜性,通常涉及開源和專有產品,以及與人工智能系統開發者最初設想相去甚遠的下游應用。此外,人工智能系統的訓練數據可能來自多個來源,包括使用該技術的客户。人工智能系統中的問題可能出現在部署或定製階段的下游,也可能出現在模型開發和數據訓練的上游。

a. 問責工作應關注價值鏈的哪個環節?

b. 價值鏈不同節點上的問責工作如何最佳地協調和溝通?

c. 供應商應如何與客户合作進行人工智能審計和/或評估?審計或評估在商業和/或公共採購過程中的作用是什麼?是否有特定的做法可以促進可信賴的審計(例如,免責聲明)?

d. 由於人工智能系統的效果和性能取決於其部署的環境,問責措施如何應對最終下游實施的未知因素?

4. 信息記錄和透明度

比如:為了支持人工智能問責,人工智能系統的開發者和部署者應保存哪些記錄(例如,日誌、版本、模型選擇、數據選擇)和其他文檔?這些文檔應保留多長時間?是否存在促進問責為本設計的人工智能系統的設計原則(包括技術設計)?在某些情況下,供應商本身可能出於隱私和安全原因故意限制了其自身的數據收集和訪問。人工智能問責要求或實踐應如何處理這些數據問題?政府、民間社會和學術界在提供有用的數據集(合成的或其他)以填補空白並創建公平獲取數據的途徑方面應扮演什麼角色?

5. 有效問責的障礙

比如:美國目前缺乏一般性的聯邦數據保護或隱私法,以及專門針對AI系統的聯邦法律,這是否會成為有效的AI問責的障礙?AI審計和評估的成本是多少?哪些實體應承擔這些成本?AI問責要求可能對受監管實體造成重大成本的可能後果是什麼?有辦法降低這些成本嗎?在權衡成本與收益時,最佳方法是什麼?

6. AI問責政策

比如:政府政策在AI問責生態系統中應扮演什麼角色(如果有的話)?AI問責政策和/或監管應該是部門性的還是橫向的,還是兩者兼有?如果有的話,AI問責監管應側重於審計或評估的輸入(例如,文檔、數據管理、測試和驗證),提高審計師和研究人員對AI系統的訪問權限嗎?在美國以及全球範圍內,統一AI問責規則與標準的一致性是否具有必要性?實現這一目標的最佳方法是什麼?

結語

早在2015年1月,生命未來研究所(Future of Life Institute)在史蒂芬·霍金(Stephen Hawking,1942-2018)、埃隆·馬斯克(Elon Musk)以及數十位人工智能專家的倡議之下,就發佈了名為“邁向強大和有益的人工智能需要優先考量的研究方案”的公開信(Research Priorities for Robust and Beneficial Artificial Intelligence: An Open Letter)。公開信強調,鑑於人工智能的巨大潛力,研究如何在避免超出人類控制的潛風險的同時收穫其人工智能帶來的利益變得尤為重要。

圖源:TechCrunch

針對人工智能帶來的機遇與挑戰,中、美兩國經過多年的制度建設,目前都已經在技術迭代、產業投資、人才培養方面,出台了諸如《新一代人工智能發展規劃》(中國)、《國家人工智能行動法》(美國)等一系列國家級的戰略政策,以及諸如《新一代人工智能治理原則——發展負責任的人工智能》(中國)《人工智能風險管理框架1.0》(美國)等行業技術標準。

**而在人工智能技術的規範、規則制定方面,美國國內囿於聯邦制度、兩黨政制、以及資本遊説等諸多因素,短期內還難完成全面監管立法。**相較而言,我國監管機關已經先後出台了包括《關於加強互聯網信息服務算法綜合治理的指導意見》《互聯網信息服務算法推薦管理規定》《互聯網信息服務深度合成管理規定》《生成式人工智能服務管理辦法(徵求意見稿)》在內的強制性法律法規,一定程度上抑制了侵犯個人信息與隱私權益,擾亂社會經濟和公共秩序等不良市場行為。

**我們也還需要清醒地認識到,當前我國人工智能技術在算力、算法、數據等方面與美國公司都還存在現實差距。**算力方面,英偉達、ARM等公司主導着AI芯片的研發與生產;算法方面,OpenAI 、DeepMind等公司領導着ChatGPT、Gato為代表的大型自然語言(Large Language Models)的開發與應用;數據方面,英文作為互聯網通用語言(lingua franca),便利了美國公司對於海量全球數據的收集與處理。

特別是,美國當下正在與少數盟國以所謂的 “護欄”(guardrails)戰術,對我們包括人工智能在內的科技發展進行全方位地圍、追、堵、截。因此,**我們更需要在守住底線、積極管控人工智能技術風險的同時,充分認識到過於嚴苛的制度規則對於技術創新、產業生態、全球競爭可能帶來的負面扼阻效應。**我們迫切需要通過制度創新,賦能市場主體建立開放、包容、審慎的技術研發與應用轉化新業態。

作者遊傳滿

香港中文大學(深圳)國際事務研究院副研究員、規則標準與涉外法治研究中心主任。