AI服務器價格漲近20倍!帶火哪些芯片?_風聞

芯世相-芯世相官方账号-芯片电子元器件IC半导体分销教科书式必读公众号05-26 14:01

“所有與英偉達相關的AI服務器都在漲價。”有企業最近向媒體透露,“去年8萬元一台的AI服務器,今年已經漲到160萬元,漲了近20倍。”

ChatGPT大火後,各大科技企業紛紛發力AI大模型,作為通用的算力芯片,英偉達的高端GPU開始供不應求。A100價格從去年年底開始暴漲,至今漲幅接近40%,連上一代V100的價格也被炒到近10萬元,中國特供版A800更是相當緊缺。

AI服務器的漲價很大程度上與這波行情有關,作為算力的基礎設施,無論是訓練,還是模型推理,AI服務器都是必需品,且往往需要的不止是一台兩台。那麼AI服務器是什麼?跟一般服務器有什麼區別?英偉達的GPU,為何讓AI服務器大漲特漲?除了GPU,AI服務器裏還用到哪些芯片?哪些芯片能夠跟着受益?

01

什麼是服務器?

如何分辨AI服務器?

AI服務器由傳統服務器演變而來。服務器,幾乎是辦公室打工人手裏電腦的翻版,它屬於高性能計算機,存儲、處理着網絡上80%的數據、信息,被稱為網絡的靈魂。

如果微機、筆記本、手機等網絡終端是分佈在家庭、辦公場所 、公共場所的電話機,那麼服務器就是郵局的交換機,把網友們共享的網絡遊戲、網站,企業的數據等存放其中,又可分為文件服務器、雲計算服務器、數據庫服務器等。

放置服務器的機房,全年無休,來源:ecl-ips.com

相比電腦,服務器在穩定性、安全性、性能等方面都要求更高,毫不誇張地説,每年雙十一若不是有足夠牛X的服務器,購物狂歡節會變成“網絡錯誤”或“請稍後再試”的刷屏節。

畢竟短短一兩分鐘內,就要處理剁手黨們發送給電商服務器的上千億交易訂單,再發送給用户進行響應,數據流量到達巔峯(2018年,天貓雙11支付峯值為25.6萬筆/秒,數據庫處理峯值為4200萬次/秒),每年對服務器的性能都是一次大考。

這操作放在1964年誕生的第一代服務器System/360身上大概是無法想象的,那時無論網絡還是分佈式計算都沒誕生,當年IBM推出它的時候,還是在協助美國太空總署建立阿波羅11號的數據庫,助力人類登月。它每秒可計算100萬次,價格高達200-300萬美元一台,體積龐大,很多銀行採購這樣的IBM大型機開展業務。

很快在1965年,服務器的價格被打了下來,這年DEC公司開發了PDP-8小型機,掀起了小型機革命。90年代初,互聯網興起,RISC架構的服務器如日中天,英特爾x86架構的服務器讓很多小企業甚至是個人用户都能買得起,不到20年的時間,英特爾迅速統治了各類計算機市場。

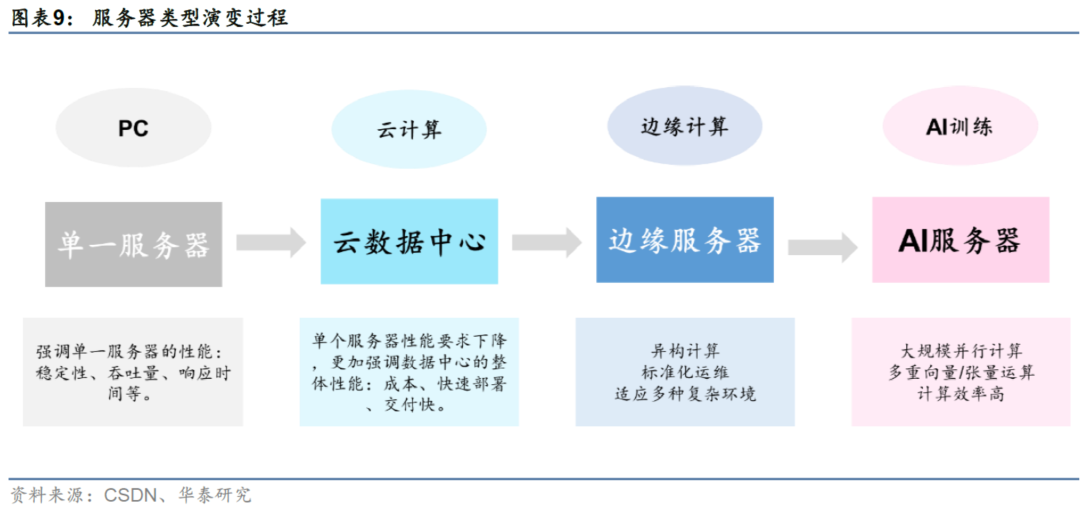

在AI服務器之前,服務器大致經歷了Wintel時代、雲計算時代兩個時代的演變,隨着新一代人工智能技術的到來,摩爾定律的“到頭”,CPU的物理工藝和核心數接近極限,單靠CPU提供算力的傳統服務器,很難滿足AI對密集型計算的需求。

機器學習和人工智能代表了一個基本的新架構,人工智能需要專屬的基礎結構進行承載和支撐,AI服務器從此應運而生。

谷歌、BAT等企業面對海量的數據,打造一座數據中心時,通常都要配備成千上萬台服務器。以用到A100的ChatGPT為例,其部署的大算力計算,每個GPU或大算力AI芯片的算力大於100TFLOPS。這時就要給服務器們上更高的配置,強強聯手,搭載GPU或者其他類型的AI芯片,比如GPU就非常擅長做一些CPU做不了的密集型數據運算。

AI服務器和普通服務器最大的區別,就是AI服務器通常打組合拳,比如CPU+GPU、CPU+TPU、CPU+其他的加速卡等,CPU在AI服務器中,徹底卸下了算力的包袱,噹噹領導指揮下就行。

02

一台AI服務器漲價近20倍,

憑啥?

一台AI服務器的價格,從去年到現在漲了近20倍。而一台普通服務器,都換不到AI服務器裏的8個GPU,價格上相形見絀。大家都在數據中心裏躺着,憑什麼AI服務器這麼金貴,價格瘋漲?

在AI服務器中,CPU退居幕後,GPU等AI芯片在其中充當主角做大量運算,算力無止境,事實上,AI服務器通常有且不僅只有一塊GPU。

雖然FPGA、各類ASIC芯片也可以做大量運算,但GPU強大的通用性使得它更吃香。IDC數據顯示,2021年上半年中國人工智能芯片行業中,GPU顯著成為實現數據中心加速的首選,佔有90%以上的市場份額。

CPU方面,AI服務器一般僅搭載1-2塊CPU,GPU的數量就佔上風了,根據GPU數量的不同,AI服務器進一步分為四路、八路和十六路服務器,搭載8塊GPU的八路AI服務器最常見。

AI大模型分為訓練和推理兩種,訓練模型要求的算力很高,推理相對要求低一點,但大模型總有一天會訓練出來,推理卻永無止境,比如ChatGPT與我們對話就是推理的過程,從算力總需求上來看,推理可能甚至要高過訓練。

算力的高低最直觀的影響就是速度,誰也不想訓練一個模型要耗上個把年,等AI回答個問題,等到人老珠黃。在這個內卷的時代,誰快,誰就有飯吃。

有研究機構測算,以GPT-4為例,為滿足最高 75352 PFlop/s-day的算力,在5 PFlop/s-day的計算速度下,20天完成,需要採購754台浪潮NF5688M6服務器(2 CPU + 8 GPU),縮短至15天,就要1005台,縮短至5天完成,就要多達3015台!

浪潮NF5688M6搭載了兩顆intel ice lake處理器,8顆英偉達A800GPU,京東售價約105萬,按照CPU約5.3萬/顆,GPU約10.4萬元/顆計算,CPU和GPU的價值量****佔比為10.10%和79.24%。

説白了,玩家為了大模型的運算效率,得加錢,氪金充值。

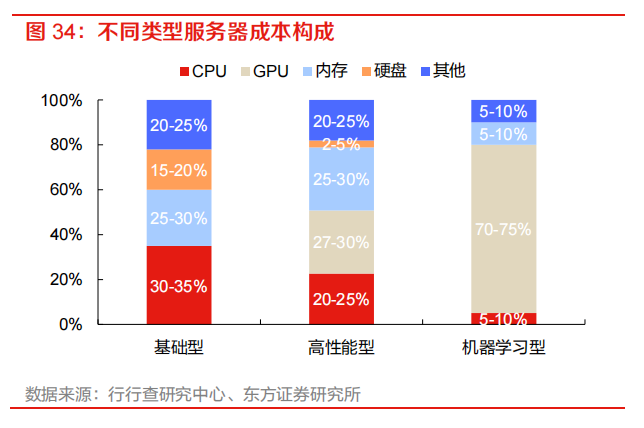

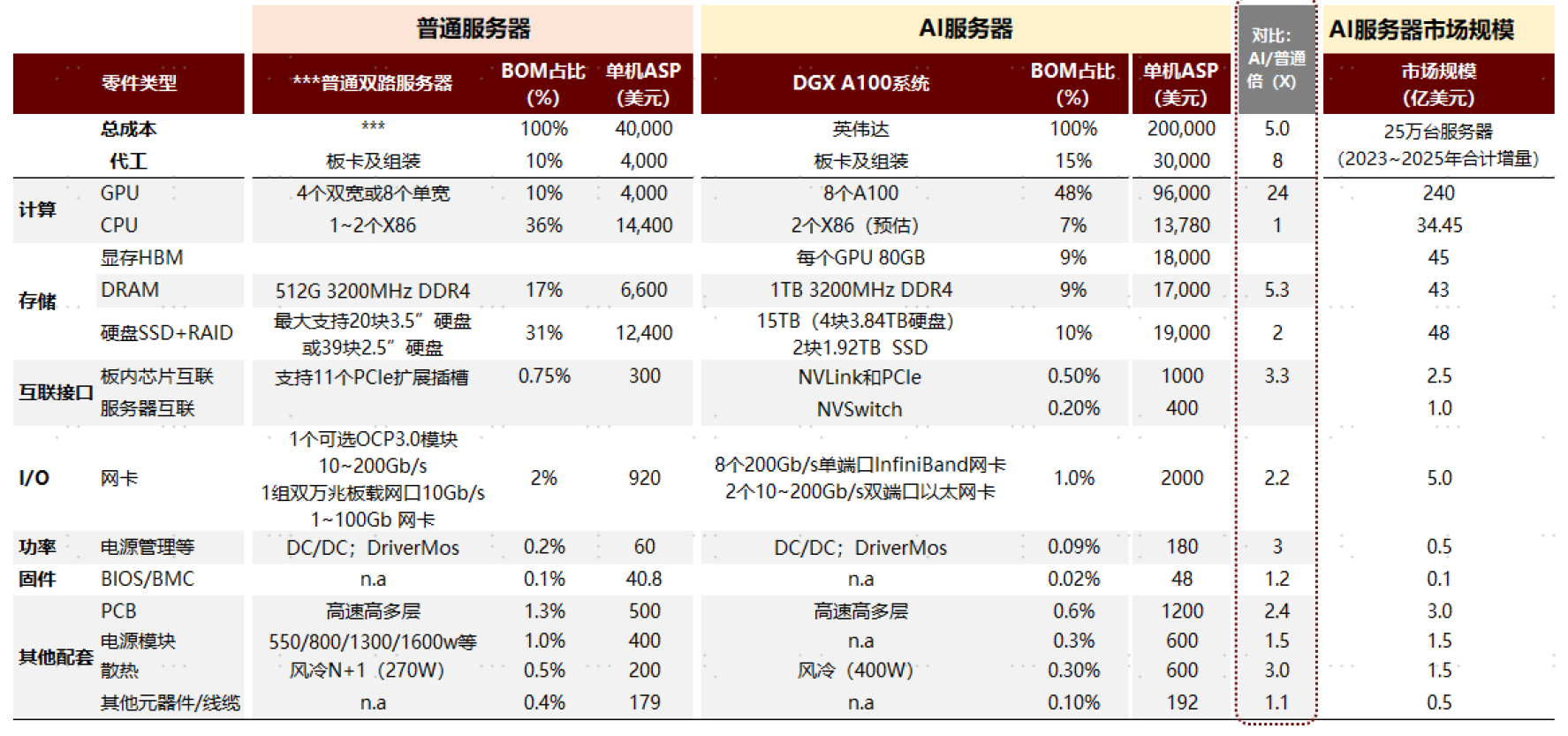

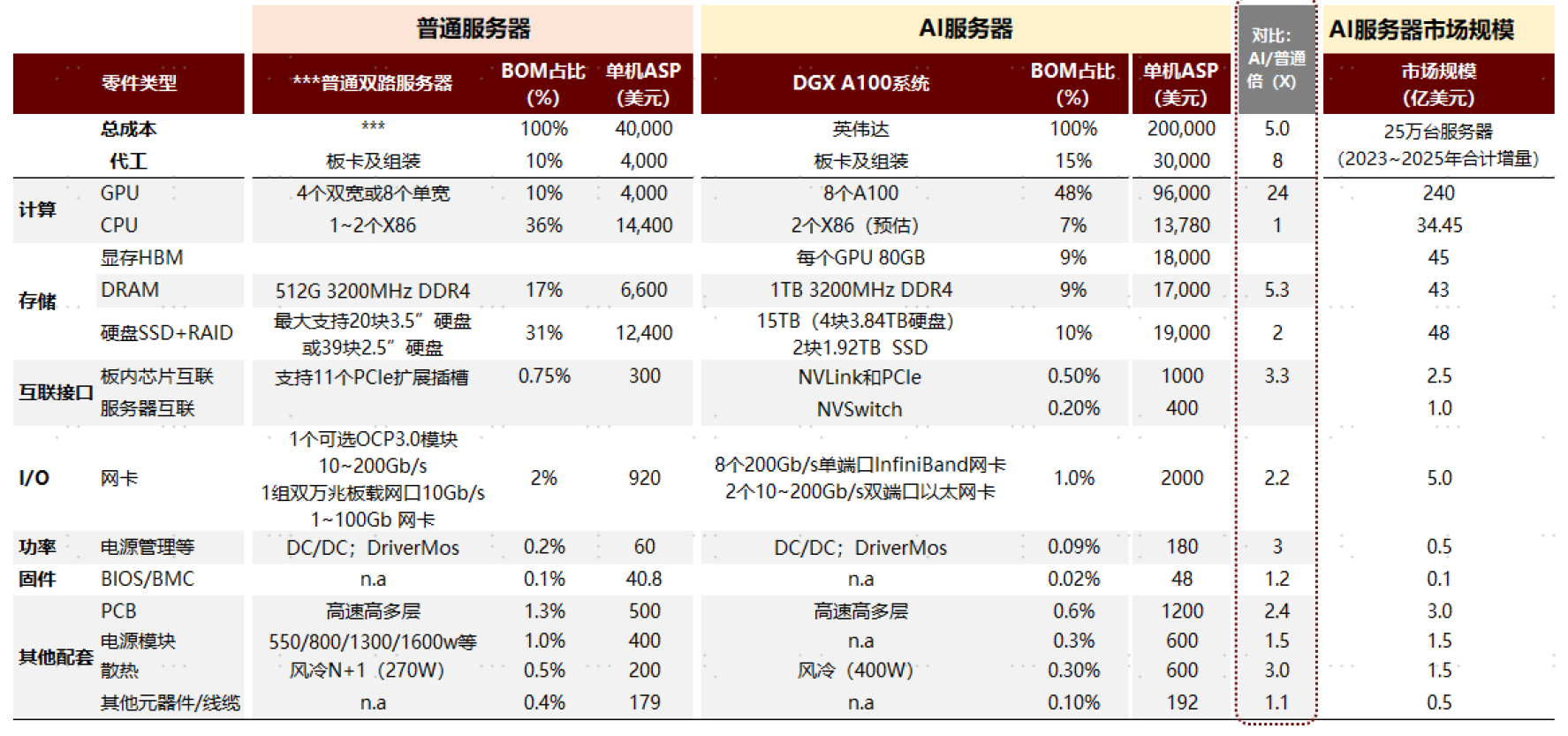

放在整機上,GPU的成本還是遙遙領先,無人能敵。普通服務器和AI服務器的BOM表顯示,AI服務器單機平均售價(ASP)比普通服務器要高出5倍,AI服務器對AI芯片如英偉達的A100需求大,而普通服務器甚至都不需要用到專業的AI芯片。

普通服務器最貴的CPU,單機ASP 14400美元,不到AI服務器中GPU 96000美元的四分之一,而普通服務器40000美元的單機總成本ASP,也不及AI服務器GPU這一項成本的一半。講個笑話,一台普通服務器,都換不到八路AI服務器裏的8個英偉達A100。

這就是AI服務器容易價格瘋漲的原因,背後成本佔比高,單價昂貴的英偉達A100等GPU幾乎成了決定性因素。

來源:中金點睛

挖礦潮過去後,英偉達顯然嗅到了生成式AI熱潮的銅臭味。有業內人士表態,早在去年6月開始,英偉達就已經宣佈上調A100價格,漲幅在20%左右,由於美國禁令,英偉達特供中國的A800版本在ChatGPT爆火之前已經出現了漲價,導致市場上出現了眾多炒貨行為。

雖然國內有華為、百度、阿里等自研的AI芯片,也有部分服務器廠商使用這些芯片,但整個AI服務器市場,英偉達還是獨佔鰲頭的那個,所以英偉達就成了AI服務器這條漲價線的源頭。

ChatGPT的大火,導致英偉達高端GPU價格一路上漲。有代理商透露,英偉達A100價格從去年12月開始上漲,截至今年4月上半月,5個月價格累計漲幅達到37.5%;同期A800價格累計漲幅達20.0%。

GPU的持續缺貨,進一步影響AI服務器廠商的出貨,連帶着下游雲服務廠商,AI企業都要受到影響。今年以來,AI服務器價格大漲的消息不絕於耳。

英偉達也向台積電追加訂單,但GPU需要的先進製程產能畢竟有限,因此交貨週期還是沒有幸免拉長,之前拿貨週期大約為一個月,現在基本都需要三個月或更長。甚至,部分新訂單“可能要到12月才能交付”。

一些雲服務廠商開始縮衣減食,嚴格限制內部對GPU的使用量。有廠商表示,“後悔買少了。”頗有種汽車缺芯時那種差之一“芯”,失之萬台的感覺。

03

AI服務器

還帶動了哪些芯片需求?

無論GPU如何帶動AI服務器漲價,本質上是AI市場需求的體現,就像前兩年汽車缺芯一樣。這種需求的出現往往伴隨的不只是一種芯片的激增。

中金測算,AI服務器核心組件按價值量由高到低依次為GPU、DRAM、SSD、CPU、網卡、PCB、高速互聯芯片和散熱模組等,按7.5萬台訓練型和17.5萬台推理型服務器測算,對應市場規模分別為240億美元、88億美元、48億美元、34億美元、5億美元、3億美元、2.5億美元和1.5億美元。

來源:中金點睛

而除了GPU、存儲這兩個價值量提升比較大的芯片外,接口、網卡、散熱、PCB等的價值量都有提升。相較普通雙路服務器,AI服務器核心器件單機價值量提升倍數由高到低依次為GPU(24x)、DRAM(5.3x)、板內互聯接口芯片(3.3x)、電源管理(3x)、散熱(3x)、PCB(2.4x)、網卡(2.2x)和SSD(2x)。

排在GPU之後,存儲芯片,貌似第一個活過來了。

存儲芯片**(成本佔比近30%)**

據Open AI測算,2012年以來全球頭部AI模型訓練算力需求3-4個月翻一番,每年頭部訓練模型所需算力增長幅度高達10倍,遠超摩爾定律的增長速度,GPT-3相較GPT-2在數據存儲端從百G提升至40T,在存儲量上有約100倍的提升。

數據中心成為存儲增長的重要引擎。TrendForce 最近將32GB DDR5 DRAM的Q2平均固定交易價格預估值從75美元調升至80-90美元。分析師指出,應用於AI服務器的128GB DDR5比64GB DDR4貴上10倍,訂單仍持續湧進。

美光的數據顯示,一台AI服務器DRAM使用量是普通服務器的8倍,NAND是普通服務器的3倍。此外,**HBM(高帶寬內存)**也逐步提高在中高端GPU中的滲透率,自2021年以來在數據中心應用中快速增長,2023年2月以來,HBM3規格DRAM價格上漲。TrendForce預測,2023-2025年HBM市場CAGR有望成長至40%-46%以上。

根據美光測算,數據中心整體存儲需求約佔存儲總市場的31%,2021年數據中心DRAM和NAND分別約300億美元和200億美元,預計到2025年分別增長至500億美元和300億美元,預計到2030年分別增長至1000億美元和700億美元,2021年~2025年合計CAGR為14%。隨着數據量的大規模增長,存儲設備在數據中心採購的BOM中佔比進一步提升,美光曾提及,目前存儲芯片在數據中心採購中比例約為40%,未來預計將提升至50%。

CPU**(成本佔比7%)**

x86、ARM、RISC-V是CPU的三大技術架構,在服務器市場,x86處理器市佔率超90%處於主導地位,而英特爾是CPU市場,特別是服務器領域是絕對的領導者。

Mercury Research最新公佈的統計數據顯示,2023年第一季度,英特爾繼續在台式 PC、移動和數據中心CPU市場佔據主導地位,在整個X86數據中心市場,英特爾市場份額為74.2%,AMD市場份額為25.8%。

服務器用的CPU從製程工藝上而言可能都落後於個人電腦用的一代,但售價往往是其10倍以上。但兩者邏輯不同,服務器講究後台運算,它看重功耗和穩定性,以此通過更多的核心數,更大的緩存來提高算力,而個人電腦強調影音娛樂體驗,頻率要求高。

接口芯片**(3.3倍的價值量提升)**

PCIe 開關或 PCIe 交換機,主要作用是實現 PCIe 設備互聯,PCIe Switch 芯片與其設備的通信協議都是 PCIe。根據 QYResearch(恆州博智)的統計及預測,2021 年全球 PCIe 芯片市場銷售額達到了 7.9 億美元,預計 2028 年將達到 18 億美元,年複合增長率(CAGR)為 11.9%。博通、微芯科技和祥碩科技為領域龍頭。目前全球僅少數幾家公司具備 PCIe Switch 芯片技術,核心廠商主要包括博通、微芯科技和祥碩科技三家,共佔有全球約 58%的份額。

數模信號混合芯片,Retimer,功能主要為重新生成信號。在 AI 服務器中,GPU 與 CPU 連接時至少需要一顆 Retimer 芯片來保證信號質量。很多 AI 服務器都會配置多顆 Retimer 芯片,例如 Astera Labs在 AI 加速器中配置了 4 顆 Retimer 芯片。目前譜瑞、Astera labs、瀾起科技是 PCIe Retimer 藍海市場中的三家主要廠商,佔據領先地位。

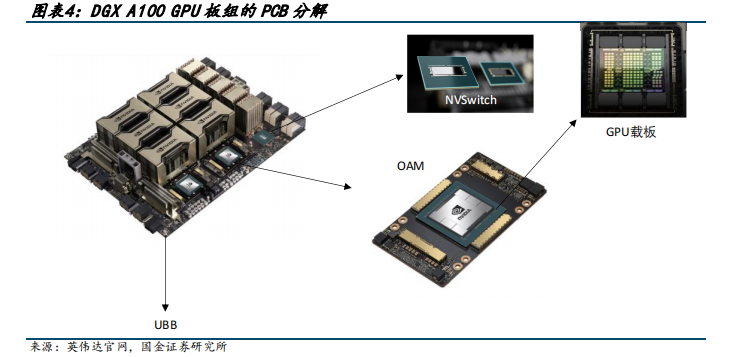

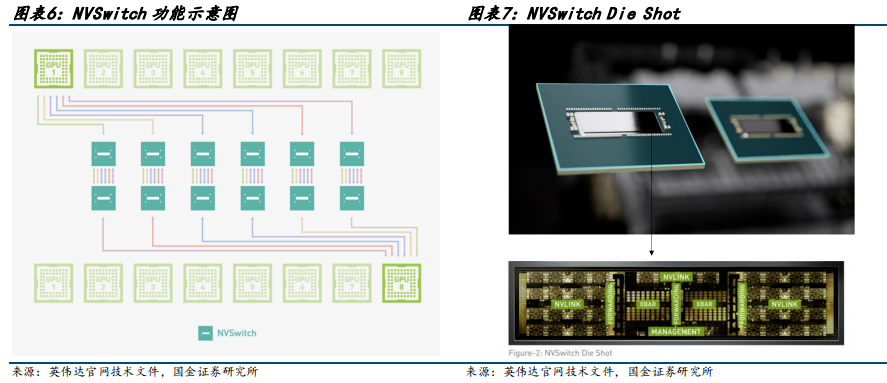

高速串行接口芯片,針對 AI 服務器中 PCIe 帶寬限制對於 GPU 間通信帶來的阻礙,以 NVIDIA NVLink 為代表的高速接口芯片應運而生。全球各大芯片廠商均在關注高速接口的相關技術,除了NVIDIA的 NVLink 之外,AMD 的 Infinity Fabric 和 Intel 的 CXL(Compute Express Link)等也為服務器內部的高速串聯提供瞭解決方案。

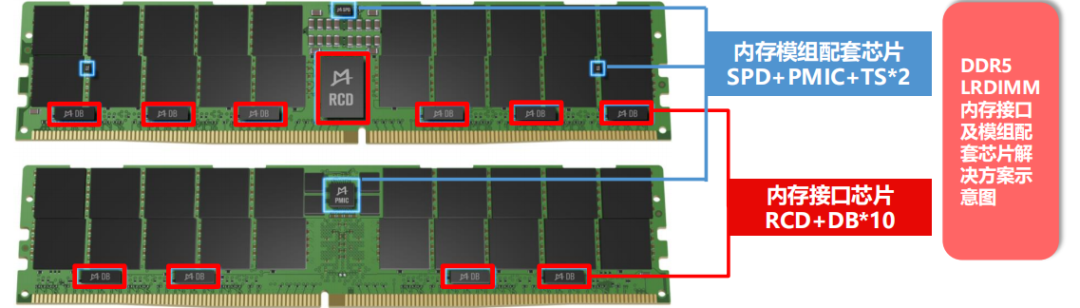

來源:方正證券

內存接口芯片,按功能分為兩類,分別是寄存緩衝器(RCD)以及數據緩衝器(DB)。內存接口芯片是技術密集型行業,需要通過 CPU、內存和 OEM 廠商的全方位嚴格驗證後,方可進行大規模使用,新的玩家很難介入。在 DDR5 世代,全球只有三家供應商可提供 DDR5 第一子代的量產產品,分別是瀾起科技、瑞薩電子(IDT)和 Rambus。

電源模塊相關芯片**(PMIC芯片,3倍的價值量提升)**

服務器內部主要使用模塊化的開關電源,具有體積小、功率密度高、轉換效率高和噪聲低等優勢。中金預計全球服務器電源模塊的市場規模約150億元。全球主流電源廠商包括台達電子、艾默生和光寶科技等,國內中國長城規模領先。截至目前,我國模塊電源商有上百家,格局分散,CR10小於60%。

參考資料:

[1]到底什麼是AI服務器:世間本無AI服務器,胡克

[2]AI浪潮之巔系列:服務器,算力發動機,中金點睛

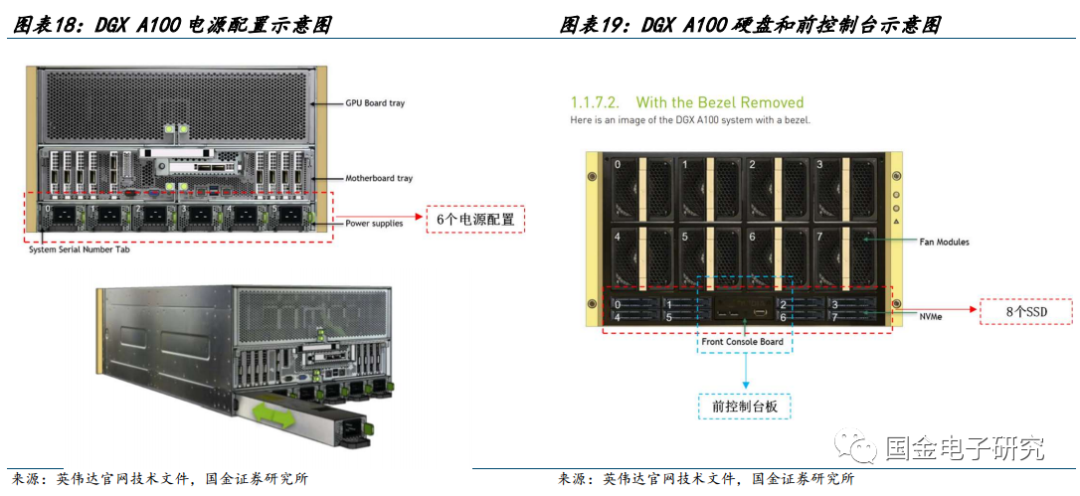

[3]行業深度:AI服務器中到底需要多少PCB,國金電子