10分鐘騙走400萬!騙子手裏的AI,把所有人都耍了_風聞

金错刀-金错刀官方合作-科技商业观察家,爆品战略理论提出者05-26 08:53

文/ 金錯刀頻道

10分鐘,騙走430萬。

無所不能的AI,再次刷新了瞞天過海的速度。

最近,“AI詐騙正在全國爆發,詐騙成功率接近100%”登頂了熱搜第一,中國警方在線也緊急提醒大家反詐。

這次被AI耍的團團轉的,沒想到是一位科技公司的老闆。

老郭的好友給他打了一通微信視頻,説自己的朋友在外地投標,需要430萬元保證金,且需要公對公賬户過賬,所以想要借用郭先生公司的賬户走一下賬。

在這通微信視頻裏,對方先要了老郭的銀行卡號,聲稱已經打了錢,甚至還發了銀行轉賬截圖。

又是視頻聊天,又是轉賬記錄,誰都猜不出來對面是個AI假人。

結果,老郭沒有核實錢是否到賬,迅速把430萬打過去了。

直到錢款轉賬後,老郭給好友微信發了一條消息,稱事情已經辦妥。但讓他沒想到的是,好友回過來的消息竟然是一個問號。

他這才意識到竟然遇上了“高端”騙局,對方通過智能AI換臉技術,佯裝成好友對他實施了詐騙。

騙子對於AI技術的運用之快、運用程度之高令人咋舌——AI換臉、AI換聲,攔截微信號,幾乎無一不出自AI技術之手。

最恐怖的是效率之快,整個過程不過短短十分鐘。

谷歌前CEO之前就發出警告,“AI被濫用遲早會威脅人類生存”,但那時不少人覺得是杞人憂天。

“徹底黑化”的AI詐騙,到底是如何一步步瞞天過海的?

AI一黑化,坐地鐵也能一絲不掛

這兩年,AI換臉已經不是新鮮事。

AI技術一秒整容,baby的臉變成熱巴,這樣的視頻從一開始的驚掉下巴到如今的見怪不怪。

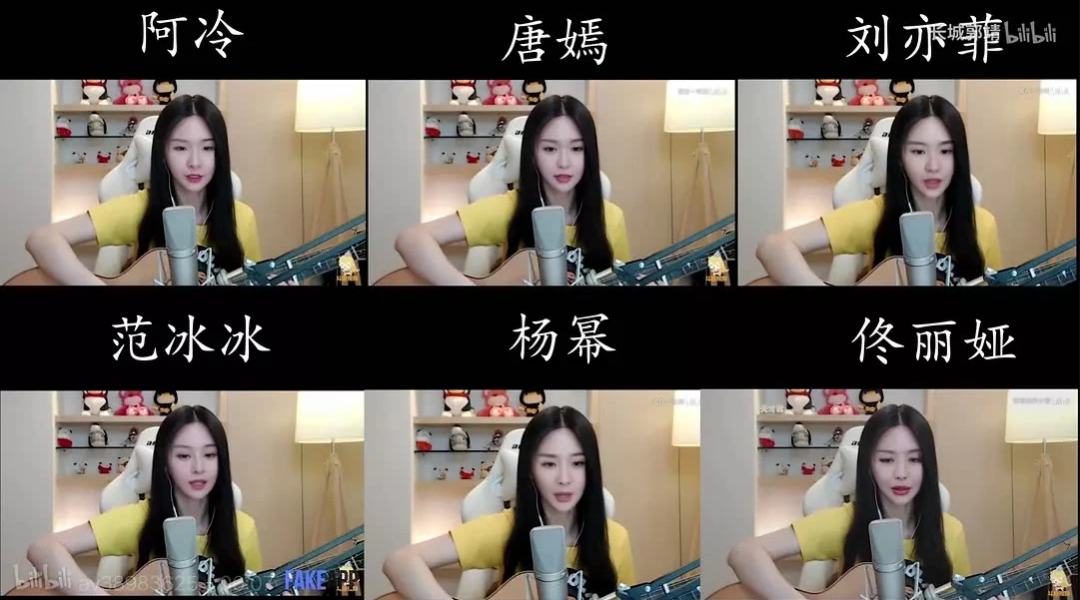

有些直播間發現商機,乾脆用AI換臉的楊冪、迪麗熱巴在直播間賣貨。

小到惡搞名人,自娛自樂。

比如,之前有國外網友用Midjourney生成“教皇穿羽絨服”,圖片質量之高完全做到了以假亂真,被瀏覽了2800多萬次,還引起了不小的騷動。

前不久,日本的一位女議員在網上大火。

在大部分人的印象中,議員這個職位總是嚴肅並且保守的,根據網上的信息,這位女議員是日本內閣的**“厚生勞動大臣”**。

作為日本內閣中重要的職位之一,這位女議員卻過於“賞心悦目”了。

外表和身份所帶來的反差感,讓這位女議員在推特上積累了超高的人氣,只要有她的照片,隨便一發都能帶來幾百萬點擊量。

還有美國前總統川普被警察逮捕,編寫的有鼻子有眼,而且有圖有真相。

就衝這酷似視頻截圖的畫質,很多人似乎認為川普真被抓了。

大到一張AI圖片,就能讓股價暴跌。

就在這週一,美國國防部五角大樓爆炸、濃煙滾滾的造假照片在網上瘋傳,引起了不小恐慌。

由於當下沒有可以交叉比對的新聞報道,很多網友都信以為真。

結果,美股聞訊一度暴跌,這可能是人工智能生成圖片影響市場的首例。

美國許多觀察家認為,這張疑為AI生成的照片經由多個帳號散佈出去,迫使國防部出面澄清五角大樓並未發生爆炸。

最後,美國防部發言人説:“我們可以證實這是假消息,五角大樓並未遭到攻擊。”

真是造謠一秒鐘,闢謠一整天。

而當AI“以假亂真”的作圖技術,遇到ChatGPT“瞬間寫作”的能力,會發生什麼?

結果是,更放飛自我了。

前不久,估計很多刀哥讀者也看到這樣一條新聞—— 22歲的加拿大小哥為了在韓國順利出道,以防彈少年團的樸智旻為模版,整容了12次,花費了上百萬。

每日郵報報道,最後不幸喪命。

在這條新聞下面,很多人痛批韓娛的畸形審美、整容就是圈錢,結果被證實是AI炮製的假新聞。

甚至你會發現,有了AI的“加持”,流量就能輕鬆拿捏。

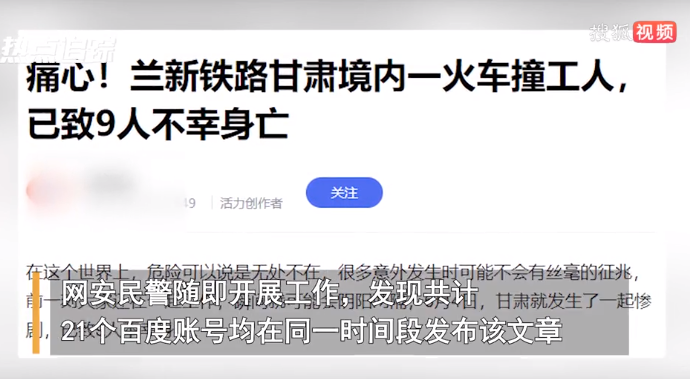

甘肅平涼市公安局崆峒分局網安大隊發現,多達21個網站上同步出現了一條本地“新聞”:《痛心!甘肅一火車撞上修路工人,致9人死亡。》

如此駭人聽聞的標題外加大體量的集中報道,這條“新聞”的點擊量迅速爆炸。

當地網警立刻介入,調查後發現,犯罪嫌疑人就是利用了AI技術進行的新聞造假。

他先是購買了大量賬號,再通過ChatGPT全網抓取社會熱點新聞素材,簡單修改一番就能避開平台的查重審查,炮製出假新聞。

為的就是在各大平台獲取流量變現。

廣州一個女孩只是在小紅書上,發了張自己坐地鐵出門的普通照片,沒想到卻被人用AI“一鍵脱衣”,並配上虛構的文字造黃謠。

在時間、地點都對得上的情況下,搭配AI強大的算法,謠言滿天飛。

當騙子擁有AI,成功率飆到100%

如果説前期AI的“黑化”還停留在惡搞和造謠,那麼直到被騙子盯上時:

突破想象的騙局才剛剛開始。

比如在10分鐘騙走430萬這個詐騙中,核心涉及了AI換臉以及語音合成這兩個技術。

有關AI 換臉軟件,多數是AI深度偽造(Deepfake)技術的化身,最初源於一個名為 “deepfakes” 用户。

Deepfake 最初的用法,侷限性還較大,只能對已有視頻進行後期“換臉”。

比如,把《射鵰英雄傳》裏的朱茵換成楊冪,五年前就實現了。

原理就是把視頻分割成一張張連續圖片,將每一張圖片中的臉進行替換,最後將全部替換後的圖片再合成視頻。

然而隨着 AI 技術的逐漸發展,最讓人擔心的事情還是發生了:用 AI 可以實時“換臉”了。

比如,下面這個換臉速度和逼真程度,只有一個字:絕。

,時長00:19

甚至成本也越來越低,合成一個動態視頻,成本也僅在2元至10元。

有行業內人士爆料,“客户”往往是成百上千購買,牟利空間巨大。

至於面向更精準、更實時的大型直播平台,視頻實時換臉的全套模型購買價格在3.5萬元,甚至不存在延遲、也不會有bug。

至於像語音合成方面,技術效果也是越來越逼真。

比如,過去騷擾電話只是詐騙,但現在就算詐騙不成,騙子通過騷擾電話錄音等來提取你的聲音,獲取素材後進行聲音合成。

這樣一來,你的聲音樣本就被騙子輕鬆提取。

前段時間,微軟發佈了新模型VALL·E:只需3秒,就可以複製任何人的聲音,甚至連環境背景音都能模仿。

當這兩項技術門檻和成本變得越來越低時,騙子就嗅到了錢的味道。

在南京,有人收到了自己大學同學的QQ留言,説目前在醫院,表姐住院了真的很着急,急需3800元住院費。

這時候,一般人還不會上當。

直到對方發過來一條視頻,不僅背景在醫院,而且還打了聲招呼,語音語調都非常逼真。

沒想到,在他轉賬之後迅速被拉黑,最後發現視頻原來是AI偽造的。

不久之前,西班牙的一家電影製作公司也遭受了AI電話的詐騙,詐騙者偽裝成著名演員“卷福”。

大佬主動找上門,這讓這家電影公司很興奮。

但“AI卷福”説,“我對你們很感興趣,但需要公司先轉20萬英鎊(約170萬人民幣)的定金,之後再談具體的合作細節。”

三天前,美國CBS電視台的電視新聞雜誌節目60 Minutes,現場展示了黑客是怎樣克隆聲音來騙過同事,併成功竊取護照信息的。

小到在網購、兼職、刷單的小錢 ,大到冒充客服、投資理財人員等身份,獲取銀行卡賬號密碼直接轉一大筆賬…

當騙子擁有AI,詐騙成功率幾乎到了100%。

無所不能之前,先要解決瞞天過海

AI的發展速度讓外界始料未及,唱衰和警告的聲音也越來越多。

五天前,英國首相蘇納克針對AI安全性發出的一則警告:英國將帶頭限制AI可能帶來的危險。

馬斯克更極端,甚至把AI比作未來人類文明最大的風險之一,威脅程度遠高於車禍、飛機失事、毒品氾濫等,甚至比核武器都要危險得多。

這次AI詐騙全國爆發,更讓人覺得AI一旦作惡,就會讓人防不勝防。

但這件事,或許並不能完全甩鍋給AI本身。

首先,對待新科技,大忽悠們總是比普通人具有更靈敏的嗅覺。

比如,在比特幣出現之時,普通人當成談資和新聞,可很快就有犯罪團伙將其用於洗錢。

洗錢者在交易所購買比特幣,通過多次轉賬和分割,使交易鏈變得複雜,破壞交易記錄的可跟蹤性——最後,比特幣轉換為現金。

再比如,自封為聯合國科學技術組織的執行主席的向主席,成功騙過了北大、清華、復旦等一眾中國名校。

對外發行30億比特幣,差不多價值近200億元人民幣。

對互聯網、區塊鏈、元宇宙、AI,騙子的撈金KPI驅使着他們不斷利用技術的黑暗面。

騙子的詐騙手段無所不用其極,開發利用新技術的速度也令人瞠目結舌。

結 語:

快播創始人王欣在法庭上發表的“技術無罪論”,但出獄後的王欣修正了他的觀點:“技術是無罪的,但人會犯錯”。

不得不承認,AI騙局對大部分普通老百姓來説,簡直就是災難。

過去我們一直説,“殺豬盤”的騙子不敢視頻,冒充公檢法的騙子不敢視頻。

但如今,圖片、聲音、視頻都可以造假。

在第七屆世界智能大會上,中國科學院院士管曉宏認為,安全性如果得不到保證,AI 系統的應用將會受到極大的挑戰。

OpenAI CEO在美國國會聽證會上大聲呼籲,世界應該要設立可以規範和監管AI 的獨立機構。

樂觀的想,AI詐騙門檻越來越低,不就意味着用AI反詐的成本也在降低?

如今,誰更瞭解AI,誰就決定了AI的“角色”。

不如讓技術解決技術,用立法打敗魔法。

圖片來源於網絡,侵權請聯繫刪除

@The End