如何在10分鐘騙走430萬?_風聞

酷玩实验室-酷玩实验室官方账号-05-27 08:12

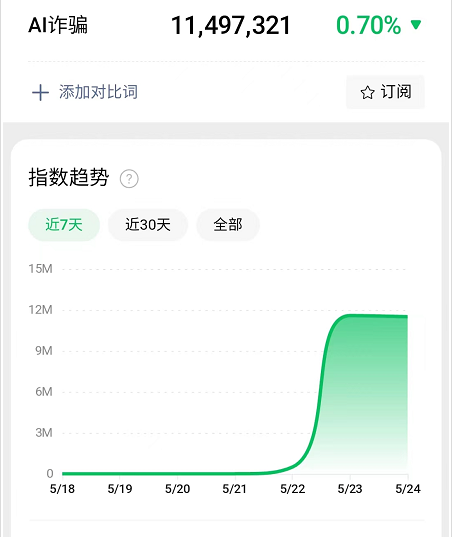

不知大家最近有沒有察覺,關於AI詐騙的消息簡直可以説是鋪天蓋地。光是這一週,就已經喜提了三個微博熱搜。

而微信指數,也從22號之前的無人問津,一下暴漲到1150萬的搜索熱度。

這熱度的起因,其實源於包頭警方公佈的一宗詐騙案。

01

案件發生在福州,主角是某科技公司的法人代表郭先生。某天郭先生的好友通過微信找到郭先生,説他的一位朋友在外地競標,需要430萬的保證金,但得公對公賬户過賬,便想借用郭先生的公司過個賬。

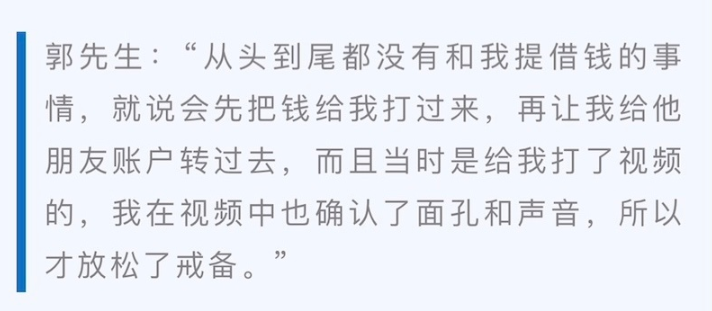

這事雖少,但也偶爾有之,不算什麼大事。郭先生通過微信視頻確認了跟他通話的人,就是他的朋友後,便爽快地答應了。

很快,那位朋友就給郭先生髮了一張轉賬成功的截圖。出於對朋友的信任,郭先生在沒有核實款項是否到賬的情況下,直接就把自己卡里的430萬轉到了那朋友給的卡號上。

整個過程,耗時十分鐘。

轉完之後,郭先生覺得有必要再確認一下,便給朋友打了個電話,這才驚覺:

十分鐘前那個跟他通話的朋友,居然是騙子用AI技術偽造的!

而整個案件的詐騙手法,大致如下:

首先,詐騙團伙可能通過木馬遠程操控了郭先生好友的微信,從而獲取到這位朋友的照片及語音等資料。這些資料被用來餵給AI,以便生成後面要用來詐騙的視頻和語音。

然後,騙子們便開始瀏覽郭先生這位朋友的微信聊天記錄,以篩選出有錢且跟這位朋友關係好的詐騙目標。

在選定了郭先生之後,詐騙團伙還得將微信視頻實時傳輸的視頻及音頻數據,替換成事先用AI生成的視頻和音頻。以此獲取郭先生的信任,實施詐騙。

縱觀全程,像不像是好萊塢電影裏才有那些高科技犯罪情節?

但非常遺憾的告訴大家,上述運用到的技術手段,其實一年前就有了。換句話説,chatgpt3.5出來之前,就已經存在了。

早在去年的1月2日,B站UP主**@林亦LYi** 就發佈過一期用AI複製自己好友的視頻。

在視頻裏面,UP主説道,只需一段5秒的語音,AI就能把一個人的聲音完全復刻,之後不管要想那個人説什麼話,都能用AI替他講出來。

至於視頻的生成,那更是簡單。僅需一張照片,就能變臉生成視頻,還能把説話的口型對好。其流暢的程度,若不是事先知道右邊的原畫,你壓根看不出其中的違和之處。

相較之下,反倒是微信視頻通話的攝像頭數據替換,看起來略顯簡單,一個APP就能搞定,根本沒啥技術含量。

話雖如此,但不知道大家有沒有從上面三個技術琢磨出一些結論?如果沒有,我這裏倒是有一個現成的——

只要給AI一張照片和5秒語音,它就能復刻出一個你認識的人,來跟你視頻…

不過這還不是最恐怖的,因為以上這些技術,一年前就有了。那麼現在的技術又如何呢?

最近一個提醒大家提防網戀的視頻裏,向我們展示了一秒換臉術。

但最逆天的是,現在的AI不僅能換臉,都到了連膚色都可以改變的程度。

如果未來有了更高性能電腦和算法的加持,AI實時拍攝渲染,並進行特定場景的生成,那麼微博熱搜裏的那句**#AI詐騙成功率接近100%#**,可能真就不是什麼危言聳聽了。

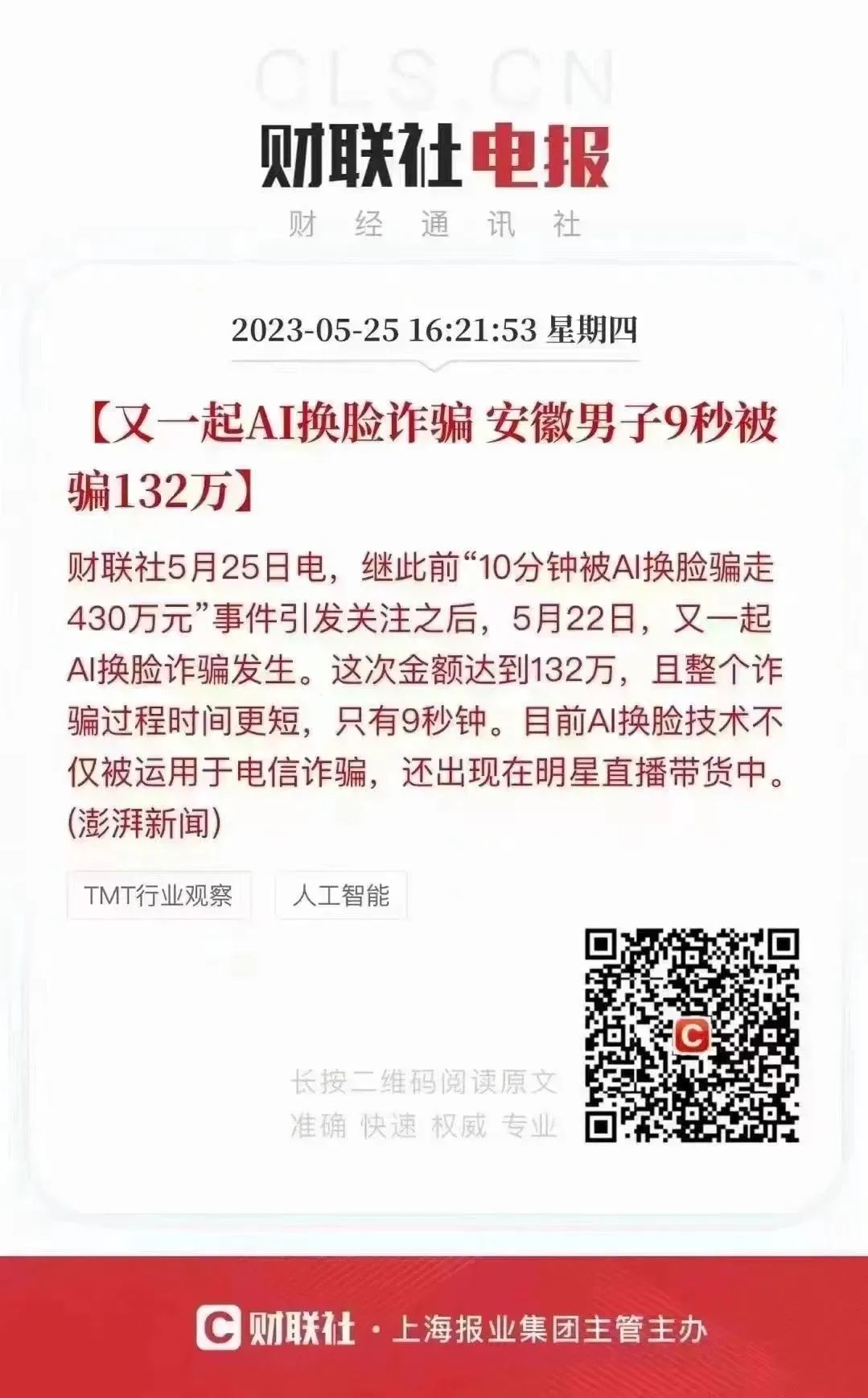

事實上,我才寫完上面這部分,另一起AI詐騙的消息又冒了出來。這次更快,用時僅9秒,安徽某男子就被騙走了132萬。

難怪當AI技術被用於詐騙這事一出來後,官媒們便紛紛下場呼籲,警惕AI詐騙!

但與官媒的緊張相反,大部分人好像對AI詐騙的破壞性,仍然停留在一個非常初級的階段:覺得只要管住自己的錢袋子,AI詐騙就拿他們沒轍。

可事實上,這一波AI詐騙,比之前所有的詐騙手法,都要來得更狠更精準!但同時,操作起來卻也更加簡單了…

02

大家可能有所不知,市面上所有的詐騙行為,其實都可以歸結於四個步驟:

實施接觸→獲取信任→陷入服從→指導行動

一句話解釋,就是騙子跟你進行接觸後,通過一系列偽裝獲取你的信任,並用事先準備好的腳本説辭,讓你陷入一個被動的服從境地,最終讓你聽從騙子的指示,做出某種行為傷及自身利益的事情。

這其中,又以獲取信任這步最為重要。操作得當,簡直可以達到洗腦的效果。

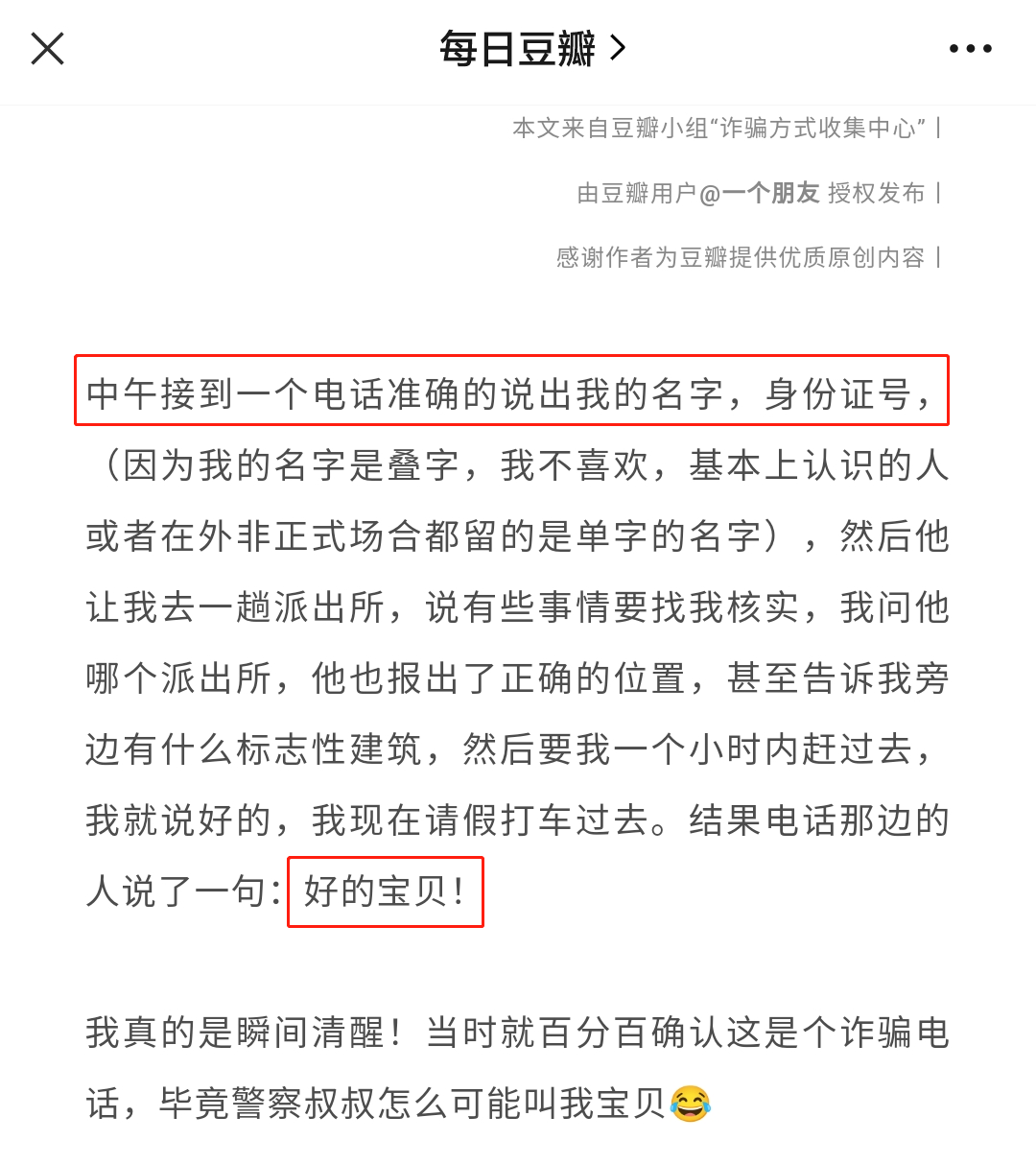

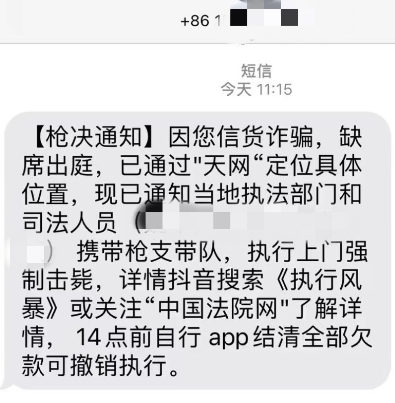

在AI詐騙出現以前,獲取陌生人的信任最常見的方式,就是假扮權威人士。騙子們通過一些非法渠道獲取你的個人身份信息後,冒充公安、檢察院、法院,甚至反詐中心等工作人員給你打電話。

然後編造你涉嫌銀行卡洗錢等罪名,並同步發送偽造的公檢法官網通緝令、財產凍結書等,對你進行威逼、恐嚇,以使你相信和就範。

然而隨着反詐的普及和深入,越來越多人瞭解到了相關的手法後,這一方式開始變得不那麼管用了。

可是當AI進入詐騙這個領域後,整個玩法都變了。這時獲取信任,已不再需要那種廣撒網、全憑運氣釣到冤大頭的方式了。

就拿最近熱傳的槍決詐騙短信來説,大家都覺得這條消息假得離譜,但它本意就是以此來篩選那些信以為真的傻子,這樣騙子的詐騙成功率才高。

但也只是高而已,完全沒有可能接近100%,甚至可能連**0.00001%**都不到,效率極其低下。

但AI詐騙則是完全利用你對熟人的信任。這時的殺傷力,可就不是一個數量級的了。

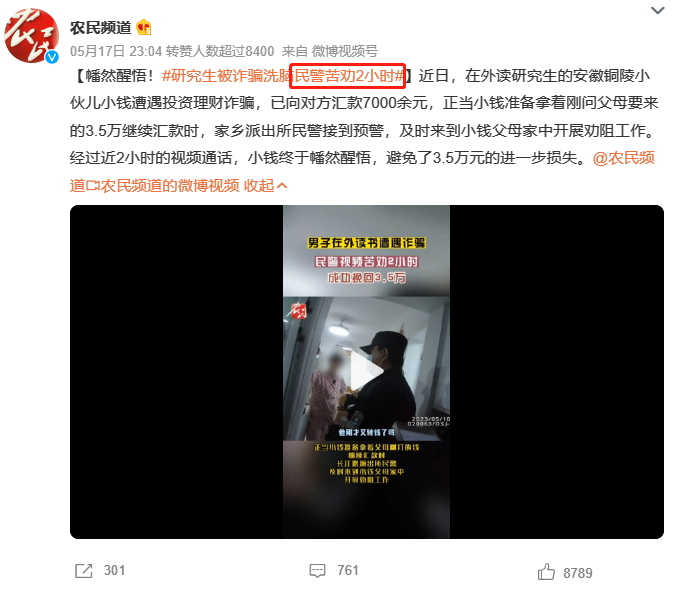

前面兩個案例,已經充分説明了這一點。一個10分鐘,另一個才9秒,以至於我們可以如此斷言:用AI詐騙時,耗時短,見效快,幾乎不會引起受害者的懷疑。

此外,AI詐騙還有另一個顯著的特點,那就是涉及金額巨大。先不説安徽男子9秒被騙132萬,這種巨離譜情況。

作為一家科技公司的法人代表郭先生,按説也是見過世面的人。卻也在短短10分鐘內,被騙子捲走了430萬…最後多虧了警方和銀行的通力合作,才幫郭先生挽回了大筆損失。

可見AI詐騙,完全有能力把受害者的所有積蓄都給掏空!

就拿前面提到的“扮演權威人士”舉例。騙子扮演公安,最多也只能從你這裏騙走幾萬塊錢,因為金額一多,你自己都會感覺離譜,甚至產生懷疑。

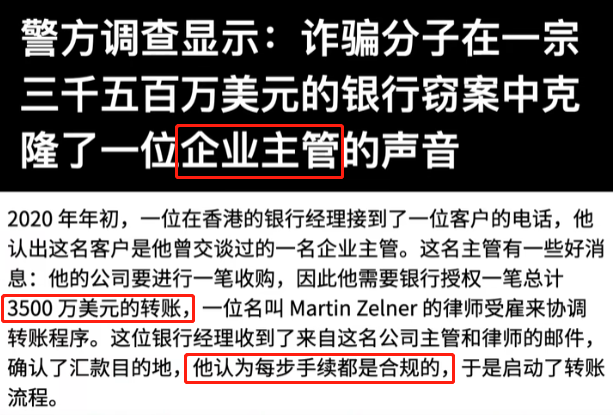

比如你是財務,而騙子通過AI假冒成你老闆,讓你給他轉一筆錢,好用來收購一家公司呢?

這其實是個真實事件,2020年初,一位銀行經理就是這樣被AI合成的聲音,騙走了3500萬美元。

在AI詐騙精能準取得信任,並有超強破壞力的情況下了。一個迫切的問題擺在了我們面前——

我們之後要怎麼去信任一個不在面前的熟人?

03

不知大家有沒有聽過這樣一句話:

如果某個生物走起路來像鴨子、説話像鴨子、長得像鴨子、啄食也像鴨子,那它肯定就是一隻鴨子。

這句話,其實是**“事物的外在特徵,就是事物本質的表現”**這一邏輯理論的通俗解釋。

可如今有AI詐騙介入的網絡世界,這一理論將不再適用。因為往後跟你用視頻聊天的那個人,雖然TA説着你熟悉的口音,長着你習以為常的相貌,但卻有可能完全不是你所認識的那個人。

還記得之前我有提到過,“大部分人都低估AI詐騙對自己的影響”嗎?

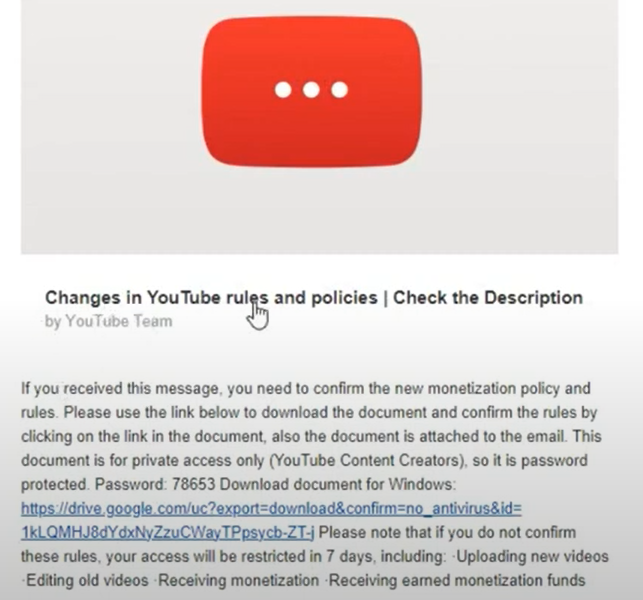

一個多月前,國外發生過一起AI詐騙羣體案件。

騙子們假借“YouTube團隊”之名,向不少油管博主羣發了一封電子郵件。説是油管最近出台一項新政策,建議各位油管博主下載相關細則進行查看。

這種釣魚式的詐騙郵件,我們應該並不陌生。通常情況下,我們壓根看都不看,直接點擊刪除。

但這封郵件裏,卻居然帶了上一個谷歌CEO皮查伊“親口解釋”的視頻,於是不少油管博主便放鬆了警惕,下載了相關政策的説明。

這個細則文件表面上看,是一個PDF文檔沒錯,打開之後,也的確有着相關規則細節的解説。但它實際卻是一個木馬病毒,可以直接竊取你瀏覽器保存的所有密碼等相關資料(郭先生那位好友的微信,可能就是這樣被監控竊取的)。

説白了,**我們身上值錢的東西,並不一定只有我們的錢包而已。**家庭地址、社會關係,還有在公司擔任的職務身份等等,都有可能是騙子想要獲得的東西。

為此,我想給大家舉一個更極端的例子,方便大家感受一下AI詐騙的可怕——

假設我們的手機被人偷了,很快便被轉到了AI詐騙的團伙手中。而手機的鎖屏設置嘛,破解起來不要太簡單…華強北的老師傅們,分分鐘就能搞定。

然後騙子將我們的手機接到電腦上,通過AI模擬出一個遭遇車禍的場景。他用微信假裝是我們的同事,給我們的爸媽打電話,説我們出車禍受傷了。這便是之前所提到的第一步:實施接觸。

接着騙子用手機拍攝下我們受傷的樣子(當然這是AI模擬出來的),通話的過程中,滿身是傷的我們,只能支支吾吾説出幾句含糊的話,但聽聲音無疑是我們的。於是第二步:獲取信任,就達成了。

而通過讓我們處於受傷的境地,一方面能使父母快速陷入混亂,另一方面也能減少騙子暴露的痕跡。

接着假冒的醫生和護士相繼出場,説是要想立即手術治療,就得先交納一筆的手術費用。這時那個號稱是我們同事的人,對我們的父母説,他身上的錢根本不夠…ze我們的父母就只能陷入第三步:服從境地。

後面是否掏空我們父母所有的積蓄,那就完全取決於騙子的良心了…

這樣一套劇本下來,有視頻有聲音,足以獲取信任了吧?而這,僅僅只是我一個業餘的編劇,隨手就能編出來的劇本。

一些騙子甚至還能根據你手機裏的聊天記錄,來進行量身定製的下套,就如郭先生所遭遇的那樣。

換句話説,僅僅只是弄丟手機,就有可能讓你身邊的人遭受巨大損失。這或許就是官媒們,如此聲勢浩大地呼籲大家警惕AI詐騙的原因。

AI詐騙的波及面實在是太廣太大,沒人可以獨善其身。

尾聲

如此看來,我們似乎面對的是一個比較暗淡的前景。

但好在一些科技公司,已經在着手處理這件事情了。它們能夠通過眨眼頻率、瞳孔形狀、還有口型與聲音之間的吻合度等等,來判斷視頻中的人物是否為AI生成。

只是,目前這項技術還只是處於測試當中,距離大範圍運用,還有着一段距離。

而就AI詐騙這一問題,我還專門詢問過chatGPT。它除了開頭直接點出這事非常困難外,剩下給出來的建議,幾乎全是正確的廢話。

難道目前我們能做的,只有小心翼翼、妥善地管理好自己的手機以及其他電子設備,以防止自己被AI詐騙所波及?

也不全是。

有一項,是AI至今無法突破的——脾氣。

早在1990年代,人類學家羅賓·鄧巴就提出一個著名的**“鄧巴數字”**。

鄧巴提出,人的大腦認知能力決定了人類擁有穩定社交網絡的規模上限為148人。其中,深入交往的人數約20人左右。

同理,我們可以畫出信任的同心圓。

詐騙,本質上是打破了我們原有的信任鏈條,重建了一條虛擬的鏈條。

過去的詐騙,多是利用我們“邊際”社交關係,或者假冒警察等公共關係,進行行騙,這種詐騙的“犯罪成本”很低,受害者防範意識也較差。而隨着全民反詐,過去的詐騙手段,越來越難奏效。

AI詐騙,更像是為受害者“定製”詐騙方案,偽裝成熟人以突破層層同心圓,突破的層數越多,詐騙造成的損失也就越大。

防範這類詐騙,最大的難點,就是具備強烈的反詐意識:意識到聲音、圖片、視頻,都能造假。

真正自己熟悉的人,“脾氣”是不會造假的。只要多説幾句話,最好是聊一些此前從沒聊過的話題,在大數據之外,人的一言一行都是感性的。

AI這個魔盒已經打開,它的好,它的壞,我們都要一步步接受。

眼下AI給我們的“教訓”,**讓我們重新思考平生交往的所有人,哪些才是深交之人,哪些才是AI無法偽裝的人。**這些人,如果真的急需一筆錢,一定不會怪罪你對他百般驗證。