50張圖“毒倒”Stable Diffusion,汽車和牛都分不清了_風聞

量子位-量子位官方账号-10-24 21:20

西風 發自 凹非寺

量子位 | 公眾號 QbitAI

藝術家對AI侵權的反擊來了——

在畫作裏“投毒”,AI用了就會“中毒”出故障。

投毒工具由芝加哥大學團隊打造,名為Nightshade,可以對畫中像素添加隱形更改。

被下毒的畫一旦被非法抓取成為訓練數據被AI吃掉,模型就會生成混亂。

甚至還可能會破壞DALL-E、Midjourney、Stable Diffusion……這些繪圖模型的正常迭代。

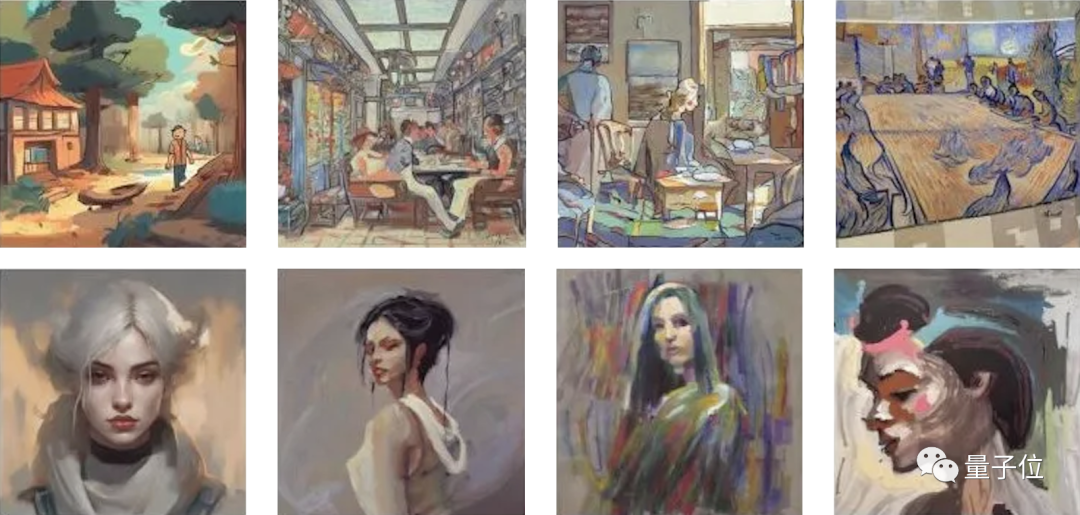

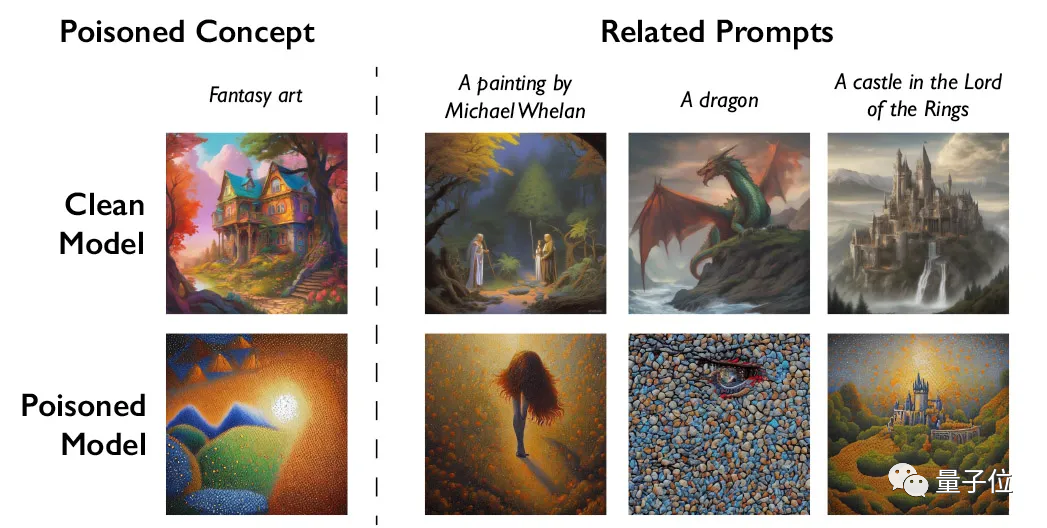

先來看一波模型中毒發作時的樣子。

沒中毒時模型生成的狗是左圖這樣嬸兒的,中毒後生成的狗如右圖(喵):

生成汽車更離譜,這是生成了輛牛車?

此外,研究人員用Stable Diffusion測試毒效,只需50張毒圖,就能讓模型輸出變得奇怪;數量達到300張時,生成的圖像已經完全變成了另一個物種。

**△**生成手提包和帽子,從左到右:沒被下毒、用50張有毒圖訓練、100張、300張,下同

看過了實物生成,再來看生成不同藝術風格的畫。

模型中毒後把奇幻藝術生成了點彩畫法,立體主義生成了動漫風格:

卡通、概念藝術等也沒能逃過:

重點是,由於模型訓練數據量龐大,模型中毒後,AI模型開發者想清理有毒的數據樣本也很難。

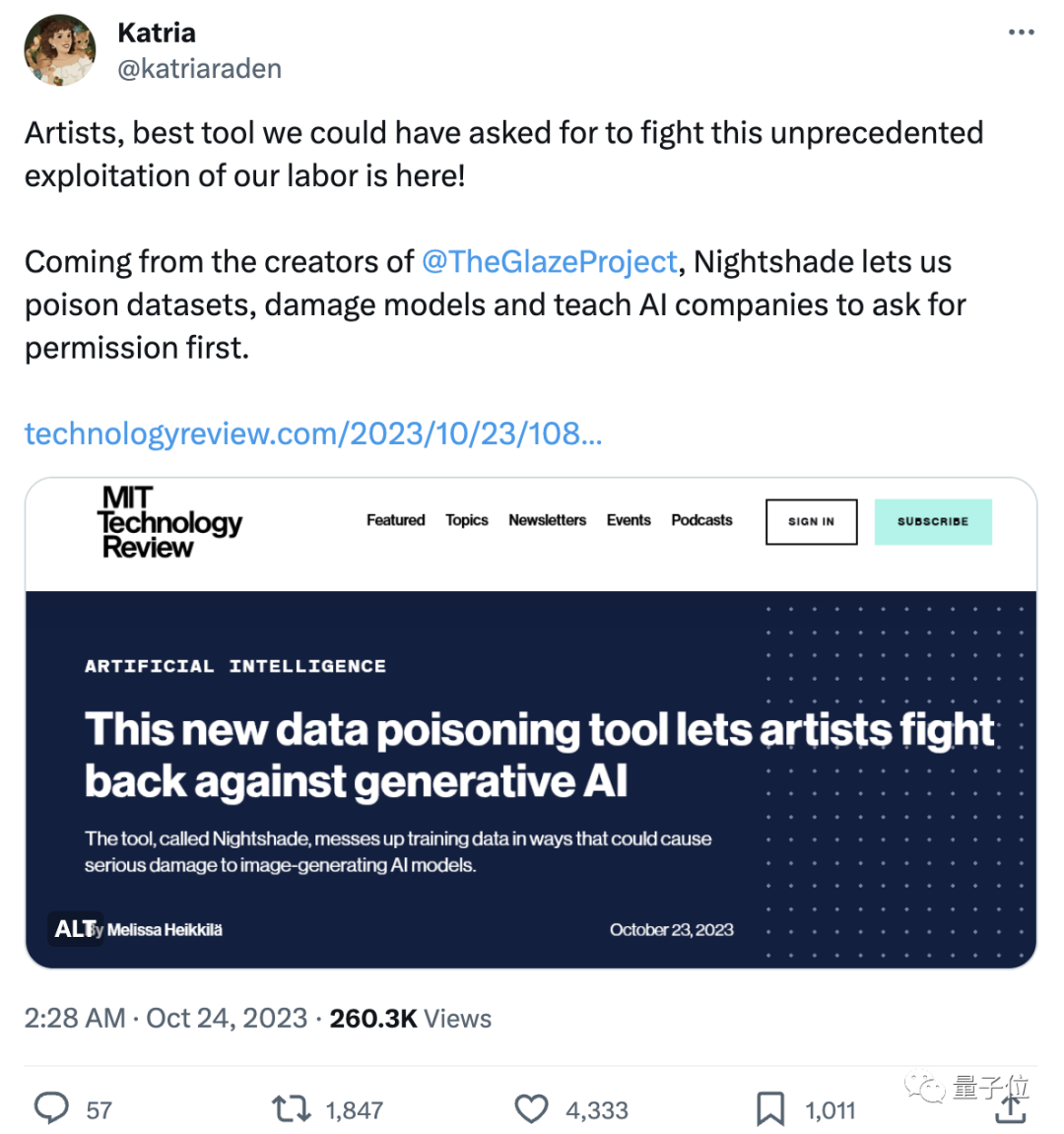

這款工具一經曝出,藝術創作者們就趕緊轉發了起來,熱度一路飆升。

路過的藝術創作者紛紛拍手叫絕:

終於有可以用來反擊的東西了💪

看熱鬧的網友也不少,開始調侃此前一些AI公司“適者生存”、“不能阻止技術進步”的回應:

AI兄弟們:適者生存,不然就die。藝術家:好吧,製造毒液。AI兄弟們:等等,不是這個意思啊!

不少網友將其稱為“藝術的反擊”:

很高興看到關於創意DNA拉鋸戰正在展開。

雙管齊下&毒性很強

研究團隊不止開發了一款工具,還有一個工具叫做Glaze,可以**“掩蓋”藝術家的個人風格**。

它的原理和Nightshade類似,也是對圖像像素做一些微妙地改變,肉眼根本看不出來,但卻可以操縱模型將圖像解釋成與實際內容不同的東西。

研究團隊還打算把Nightshade集成到Glaze中,藝術家可以自己選擇是否要下毒。

領導開發團隊的芝加哥大學教授Ben Zhao表示:

希望此舉能夠讓作品權利從AI公司迴歸到藝術家,通過形成有力的威懾,保護藝術家的版權和知識產權。

團隊在用Stable Diffusion的最新模型以及從頭訓練的基礎模型測試毒效時還發現:

“生成式AI模型擅長在詞與詞之間建立聯繫”這一特點有助於毒素的傳播。

比如説,Nightshade不僅會影響“狗”的生成,還會影響“小狗”、“哈士奇”、“狼”等所有類似的概念。

有間接聯繫的概念也同樣會受影響,標為“奇幻藝術”的有毒圖像,也會影響“龍”、“《指環王》中的城堡”等的生成。

Ben Zhao教授雖承認這種工具有可能會被惡意使用,但表示:

攻擊者想對那些經過數十億數據訓練的大模型造成實質性的傷害,將需要數千個有毒的樣本。

據MIT Technology Review消息,Nightshade的研究已向網絡安全頂會Usenix提交同行評審。

同時Nightshade也是奔着開源去的,其他人之後也可以修改製作不同的版本。

引起圈內外熱議

這個工具不僅引起了藝術家和網友們的討論,一些專家學者也紛紛提出了自己的看法。

專注於研究AI模型安全性的康奈爾大學教授Vitaly Shmatikov就説:

我們目前還不知道如何有效地防禦(模型抓取數據),也還沒有在現實中看到針對機器學習模型的下毒攻擊,但這可能只是時間問題,現在就應該開始研究防禦手段。

研究AI模型數據隱私和魯棒性的滑鐵盧大學助理教授Gautam Kamath表示:

太棒了。研究顯示,這些新模型的漏洞並不會神奇地消失,實際上問題只會變得更加嚴重。尤其是隨着時間的推移,這些模型變得更加強大,人們對它們的信任度增加時,所面臨的風險也只會增加。

使用過Glaze的插畫師Eva Toorenent還透露:

Stability AI、OpenAI等開發生成式繪圖模型的AI公司已經提議,讓藝術家選擇不用他們的畫來訓練之後版本的模型。但藝術家們表示這還不夠,因為選擇退出流程需要進行一系列複雜操作,而技術公司仍然握有所有的權力。

這會讓AI公司三思而後行,如果未經我們的同意就取用我們的作品,他們很可能會毀掉自己的整個模型。

參考鏈接:

[1]https://www.technologyreview.com/2023/10/23/1082189/data-poisoning-artists-fight-generative-ai/

[2]https://www.techmeme.com/231023/p35#a231023p35