可能對人類構成深遠風險?馬斯克等千人呼籲暫停訓練高級AI

周毅是故意的还是不小心?

【文/觀察者網 周毅 編輯 呂棟】

馬斯克等1000名科技人士,日前簽署了一封特殊的公開信。

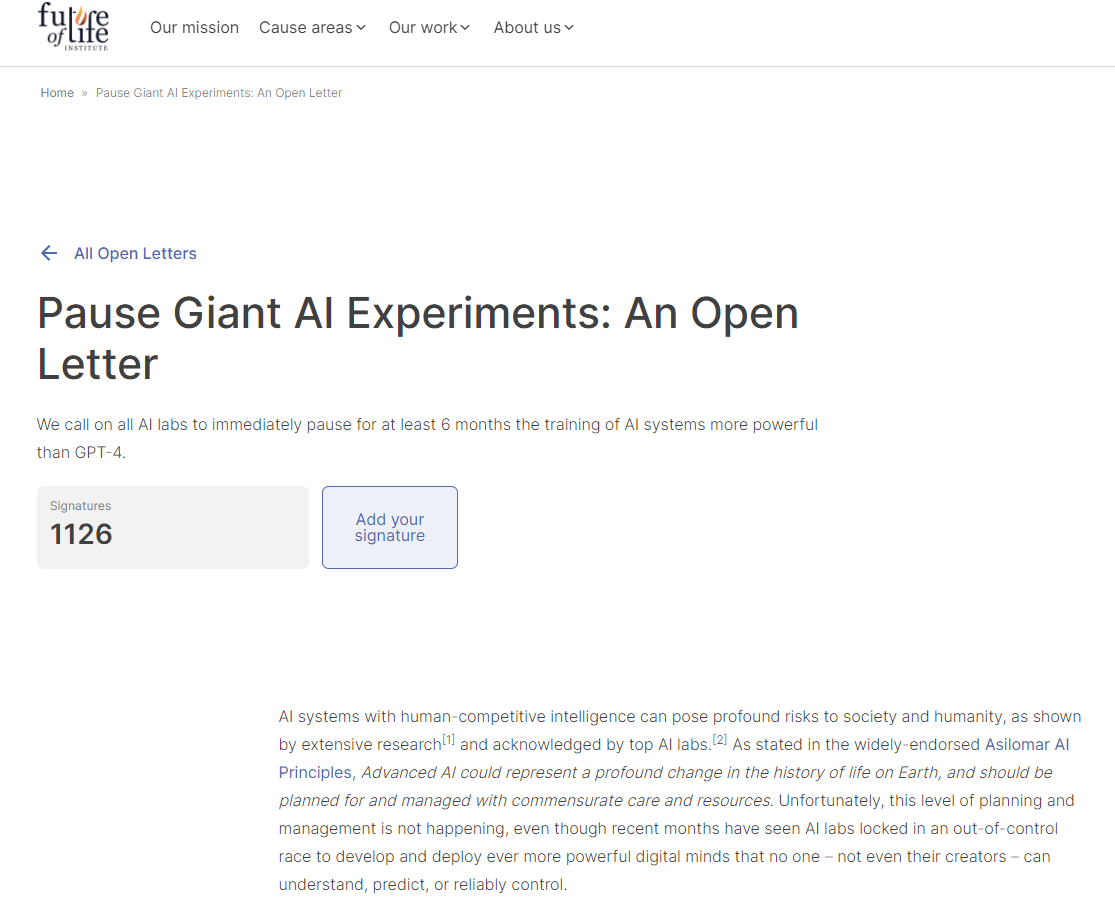

據未來生命研究所(Future of Life Institute)網站披露,該網站曾以公開信的方式發起倡議,呼籲所有AI(人工智能)實驗室立即暫停訓練比GPT-4更強大的AI系統至少6個月。截至北京時間3月29日下午13時許,在該網站上,這封公開信獲得了包括馬斯克在內的1126名人士的聯名簽署。

綜合目前的公開資料來看,這項倡議的宗旨在於為人類留出時間,思考AI開發的合規性和安全性,並助力人類展開相關的工作。對於此,GPT-4認為,“6個月的時間可能對於實現這一目的具有一定的挑戰性。”

未來生命研究所網站截圖

公開信認為,高級AI可能代表地球生命史上的深刻變化,人類應以相應的關懷和資源進行規劃和管理——但不幸的是,對應級別的規劃和管理並沒有發生。此外,最近幾個月AI實驗室們陷入了一場失控的競賽(an out-of-control race),但包括這些AI系統的創造者們,都無法完全去理解、預測或者可靠地控制(reliably control)它們。

公開信寫道,廣泛的研究表明,具有與人類競爭智能的人工智能系統可能對社會和人類構成深遠的風險,這一觀點得到了頂級人工智能實驗室的承認。

公開信表示,人們只應在這樣的背景下去開發強大的人工系統:確信它們的影響是積極的,確信它們的風險是可控的。信件還援引了OpenAI(ChatGPT的開發者)在其最新聲明中的表態,“在某個時候,在開始訓練未來的AI系統之前,對它進行獨立審查可能很重要。”

“現在就是那個時候。”公開信認為。

公開信呼籲,所有AI實驗室立即暫停至少6個月的訓練工作——對象是那些比GPT-4更強大的AI系統。公開信稱,這種暫停應該是公開的和可驗證的,並且包括所有關鍵參與者。如果不能迅速實施這樣的暫停,政府應該介入並暫停。

“這並不意味着總體上暫停AI開發,”公開信表示,AI實驗室和獨立專家應該利用這次暫停,共同開發和實施一套用於高級AI設計和開發的共享安全協議,並由獨立的外部專家進行嚴格審計和監督。此外,公開信還呼籲,AI開發人員必須與政策制定者合作,以顯着加快開發強大的AI治理系統。

未來生命研究所網站顯示,該組織成立於2014年,它的目標是“引導變革性技術造福於生活,遠離極端大規模的風險。”網站信息顯示,其註冊地址在美國賓夕法尼亞州蒙哥馬利縣。經查證,在2020年6月聯合國發佈的《數字合作路線圖》中,該機構是該活動在AI領域的民間倡議者(Champions)之一。

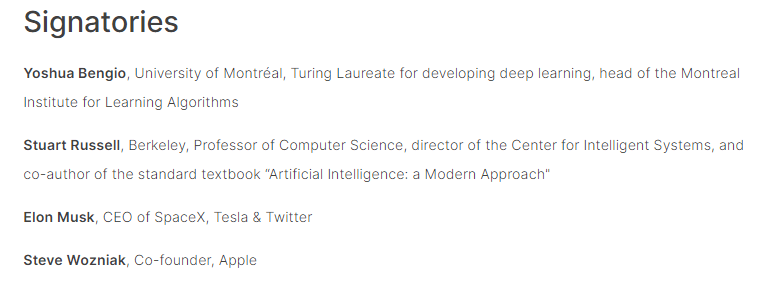

網站最新頁面顯示,在該公開信的聯合簽名欄,有眾多大學學者、工程師和企業創始人和高管在列。例如“圖靈獎”獲得者約書亞·本希奧、特斯拉CEO馬斯克、蘋果聯合創始人史蒂夫·沃茲尼亞克等。這份名單中也包括一些記者、教師和學生的名字。

未來生命研究所網站截圖

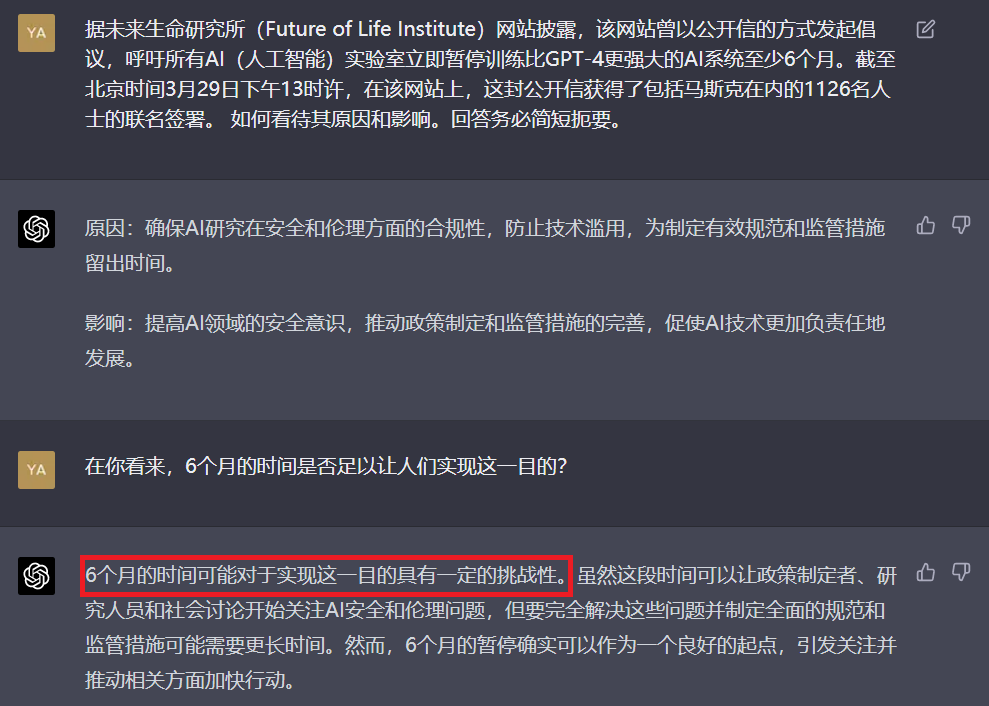

對於此事,“GPT-4怎麼看”?

ChatGPT在回答提問時表示,其原因為確保AI研究在安全和倫理方面的合規性,防止技術濫用,為制定有效規範和監管措施留出時間。對於這一行動的影響,GPT-4稱,這將提高AI領域的安全意識,推動政策制定和監管措施的完善,促使AI技術更加負責任地發展。

當被問道,“在你看來,6個月的時間是否足以讓人們實現這一目的?”GPT-4認為,雖然這段時間可以讓政策制定者、研究人員和社會討論開始關注AI安全和倫理問題,但要完全解決這些問題並制定全面的規範和監管措施可能需要更長時間。然而,6個月的暫停確實可以作為一個良好的起點,引發關注並推動相關方面加快行動。

“6個月的時間可能對於實現這一目的具有一定的挑戰性。”

OpenAI網站截圖

本文系觀察者網獨家稿件,未經授權,不得轉載。