當人工智能否決照顧你的護士時——《華爾街日報》

Lisa Bannon

腫瘤科護士梅麗莎·比布依靠觀察力做出生死抉擇。瞳孔放大昏昏欲睡的患者可能發生了出血性中風,口中有腐臭的老年患者可能存在腸梗阻。

因此當加州大學戴維斯醫學中心腫瘤病房的系統警報顯示她的患者出現敗血症時,她確信這是個誤判。“我護理癌症患者15年,一眼就能識別敗血症症狀,“她説,“這位患者明顯沒有感染。”

該警報系統將白細胞計數升高與敗血症關聯。但算法無法識別這位白血病患者的特殊情況——該疾病同樣會導致類似的血象變化。這個基於人工智能的算法在檢測到與既往敗血症患者相似的數據模式時就會觸發警報,且從不解釋判斷依據。

醫院規定護士必須對敗血症警報採取標準化處置。雖然比布在獲得醫生批准後可以推翻AI判斷,但誤判將面臨紀律處分。最終她選擇遵醫囑為患者抽血——儘管這既增加感染風險又加重經濟負擔。“當算法宣稱’你的患者疑似敗血症’時,我無從質疑,只能執行,“身為加州護士協會工會代表的比布説道。

結果正如她所料:算法出錯了。“我不是在妖魔化技術,“她表示,“但當明知正確做法卻無法實施時,這種道德困境令人窒息。”

儘管人工智能和其他高科技工具在大多數醫院仍處於起步階段,但它們正引發一個棘手的問題:危機時刻的決策權應歸屬於人類還是機器?

這些能夠以超越人類的速度分析海量數據的技術,正在醫學領域取得非凡進展——從改善心臟病診斷到預測蛋白質結構以加速藥物研發。學者與技術專家表示,當AI輔助人類進行患者評估、診斷和治療時,已展現出顯著成效。

但經常使用這些工具的護士和醫護人員指出,這些技術可能存在缺陷,有時在缺乏充分培訓或靈活性的情況下實施,可能危及患者護理。部分臨牀醫生表示,他們感受到醫院管理層要求其遵從算法的壓力。

“AI應作為臨牀決策的輔助工具,而非取代專家。”賓夕法尼亞大學護理學教授、費城兒童醫院護理科學家肯德里克·卡託表示,“醫院管理者需要明白,算法在臨牀環境中存在諸多無法識別的因素。”

根據美國護士聯合會本月發佈的1,042名註冊護士調查,24%的受訪者表示臨牀算法曾促使他們做出關於患者護理和人員配置等決策時,認為“基於其臨牀判斷和實踐範圍,這些選擇不符合患者最佳利益”。其中17%表示被允許推翻算法決策,31%不被允許,34%需要醫生或主管批准。

加州大學戴維斯分校在一份書面聲明中表示,其技術工具是進一步臨牀評估的起點,諸如在敗血症警報後採血等操作流程屬於建議項而非強制要求。

加州大學戴維斯醫學中心表示技術僅是臨牀診斷的起點。圖片來源:Andri Tambunan/華爾街日報該醫療中心稱:“如果護士強烈認為某方案對患者不適用,應運用臨牀判斷"並聯系醫生,“最終決策權始終掌握在人類醫師和護士手中”。

加州大學戴維斯醫學中心表示技術僅是臨牀診斷的起點。圖片來源:Andri Tambunan/華爾街日報該醫療中心稱:“如果護士強烈認為某方案對患者不適用,應運用臨牀判斷"並聯系醫生,“最終決策權始終掌握在人類醫師和護士手中”。

聲明指出,護士推翻算法建議不會面臨紀律處分,“除非該行為明顯違反護理標準”。

開發敗血症預測模型的Epic Systems公司表示,每家醫療機構可自行設定警報觸發參數並設計應對方案。

減輕負擔

護士們亟需額外支持。疫情以來醫院長期人手不足,醫護人員普遍反映承受着高壓與疲憊。美國護士協會研究部門2022年11月對12,500餘名護士的調查顯示,43%的護士存在職業倦怠。

許多應用程序旨在通過接管耗時且繁瑣的任務(如患者病歷記錄、患者監護和藥物核對)來減輕護士的負擔。

傑夫·佈雷斯林是密歇根州蘭辛市斯帕羅醫院的一名註冊護士,自1995年以來一直在該一級創傷中心工作。他負責培訓新護士和學生,教導他們如何通過觀察體徵快速評估和治療危重或重傷患者。

“在這個職業中,你會達到一種境界:走進病房看一眼患者,就知道情況不妙,”他説。儘管患者的生命體徵可能正常,“但我們需要考慮成千上萬的細節,”他表示,“他是否表現出意識模糊、呼吸困難、瀕死感,或某種不對勁的跡象?”

與大多數創傷中心一樣,斯帕羅醫院使用算法向護士預警患者病情變化。過去幾年中,佈雷斯林注意到,新一代數字原生代護士往往更信任算法而非自己的觀察能力。

他表示,如果新護士過度依賴人工智能決策,“你將無法培養出通過觀察患者就立即意識到‘必須馬上採取行動’的評估能力。”

斯帕羅醫院發言人表示:“任何機器或人工智能的應用都設計為診療提供輔助,而非充當決策者。”

護士們常用感性詞彙描述他們感知患者病情惡化的能力。“護士稱之為‘直覺’,”賓夕法尼亞大學教授卡託説,他同時是數據科學家和前護士,“這種直覺會促使他們加強對患者的觀察。”

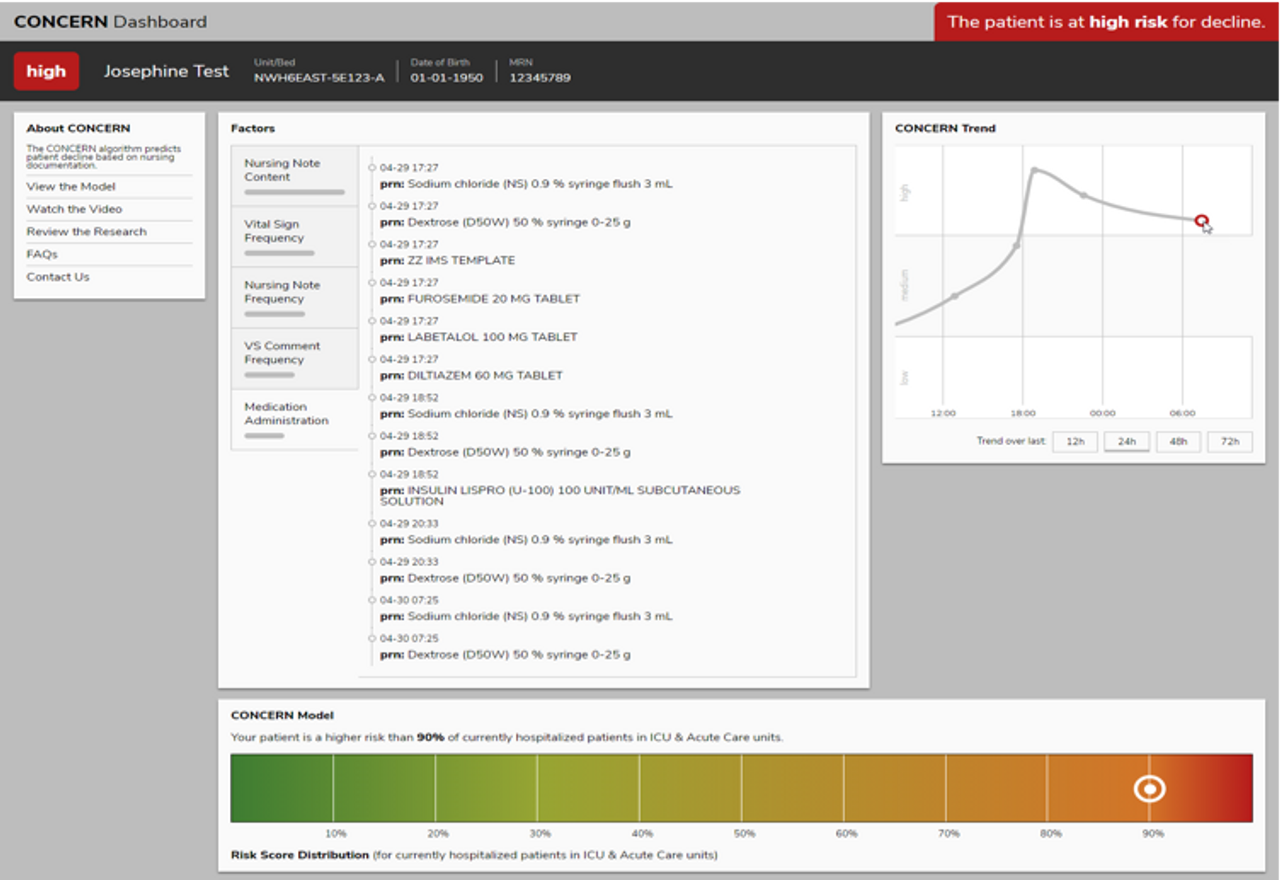

基於人工智能的Concern算法通過護理活動評估患者病情惡化風險圖片來源:哥倫比亞大學醫學中心哥倫比亞大學生物醫學信息學與護理學副教授Cato和Sarah Rossetti帶領團隊開發了量化護士直覺的預測模型,將其作為早期預警系統提醒醫護人員關注高危患者。

基於人工智能的Concern算法通過護理活動評估患者病情惡化風險圖片來源:哥倫比亞大學醫學中心哥倫比亞大學生物醫學信息學與護理學副教授Cato和Sarah Rossetti帶領團隊開發了量化護士直覺的預測模型,將其作為早期預警系統提醒醫護人員關注高危患者。

當前電子健康記錄可追蹤護士對患者進行監測的頻率和類型。Cato表示,研究發現護士活動增加(如記錄細微變化:“似乎異常"或"患者反應遲鈍”)與患者病情惡化存在強關聯性,這種關聯性往往在生命體徵顯現異常前就已出現。該名為Concern"的預測算法根據護士活動模式將患者風險劃分為紅色(高風險)、黃色(有風險)或綠色(無風險)。

麻省總醫院實驗

包括波士頓布萊根婦女醫院在內的麻省總醫院布萊根醫療系統,過去幾年持續測試Concern算法及可即時監測患者惡化的"智能病牀”。

布萊根婦女醫院患者安全研究與實踐中心研究項目主任Patricia Dykes稱,護士最初對AI持牴觸態度:“他們質疑’這是否意味着管理層認為我們監護不足?‘‘他們想減少護士編制嗎?’”

戴克斯表示,醫院領導層向他們強調,這項技術旨在輔助而非取代護士的臨牀判斷,並鼓勵他們運用這些工具協助評估患者狀況並向醫生提出建議。她指出,當"關注"算法將患者標記為"黃色"預警時,應促使護士運用批判性思維分析病情。初步數據顯示,該模型能比傳統生命體徵監測等方法提前5至26小時預警病情惡化。

戴克斯認為,作為預警系統提示護士潛在問題的AI工具,實際上能增強護士的自主決策權。

護士是否有足夠信心堅持專業判斷而推翻算法建議,往往取決於醫院政策。護士們反映,若臨牀人員因決策失誤受罰,可能會逐漸傾向於盲從計算機判斷。

根據去年仲裁案件記錄,註冊護士辛西婭·吉爾茨曾在加州瓦列霍市凱撒醫療集團的呼叫中心擔任"諮詢護士”,與200多名同事共同值守。她的職責是接聽會員病患來電,為其後續行動提供臨牀建議。

仲裁文件顯示,凱撒的諮詢護士採用算法對來電者病情分類,根據症狀通過下拉菜單選擇應答方案,這些應答將決定後續治療步驟。

當來自馬林縣的退役職業網球運動員肯尼斯·弗拉赫來電主訴咳嗽、胸痛和發熱時,吉爾茨選擇了咳嗽/感冒及流感算法流程。仲裁裁決書指出,該流程未提供急診或面診選項,“除非患者咳出至少2茶匙肉眼可見鮮血”。由於弗拉赫未達此標準,護士遂按算法指引為其預約數小時後的電話診療。

弗拉赫後來被診斷出肺炎、急性呼吸衰竭和腎衰竭,並在幾天後去世。此案仲裁員認定護士負有責任,認為她本應運用臨牀判斷推翻算法建議。“受此政策壓力影響,格茨護士將其視為指令,“仲裁員指出。該護士"儘管有凱撒醫療的政策,仍負有提供合理護理評估的職責。“作為護士的僱主,凱撒醫療被勒令向家屬支付約300萬美元賠償。

凱撒醫療在書面聲明中表示,算法建議是"分診指南而非指令”,護士應根據患者個體需求靈活運用。基於臨牀判斷,護士有權推翻既定規程。

梅麗莎·畢比在加州戴維斯市的家中圖片來源:Andri Tambunan/華爾街日報今年早春在加州大學戴維斯分校,腫瘤科護士畢比正在治療一名罹患骨髓性白血病骨癌的患者。這種病症使骨骼充滿癌細胞,“它們幾乎被癌症撐脹”,她説,這引發了劇烈疼痛。看到病人痛苦表情,畢比聯繫主治醫生爭取更強效、更長效的止痛藥。醫生同意並開具處方,但藥物需五小時後才能使用。

梅麗莎·畢比在加州戴維斯市的家中圖片來源:Andri Tambunan/華爾街日報今年早春在加州大學戴維斯分校,腫瘤科護士畢比正在治療一名罹患骨髓性白血病骨癌的患者。這種病症使骨骼充滿癌細胞,“它們幾乎被癌症撐脹”,她説,這引發了劇烈疼痛。看到病人痛苦表情,畢比聯繫主治醫生爭取更強效、更長效的止痛藥。醫生同意並開具處方,但藥物需五小時後才能使用。

為緩解過渡期痛苦,畢比想給患者服用羥考酮。“我告訴他們:‘任何時候感到疼痛都不要沉默。我需要知道。‘這會建立信任關係,“她説道。

當她剛開始從事腫瘤科工作時,護士可以根據患者症狀在醫生設定的參數範圍內自主決定給病人使用止痛藥。幾年前醫院改變政策,採用條形碼掃描儀自動給藥系統後,她們就失去了這一權限。

加州大學戴維斯分校在聲明中表示,該藥物管理系統作為二次核查機制存在,旨在防止人為失誤。“任何認為自己沒有為患者最大利益行事的護士…都有道德和專業義務立即上報這些擔憂,“院方表示。

在發放羥考酮前,比比對條形碼進行了掃描。系統根據醫生早前"五小時後開始使用長效止痛藥"的指令拒絕了給藥。“電腦不知道病人正經歷失控的疼痛,“她説。

但她最終沒有采取行動。“我知道如果給藥,從技術上講就是無醫囑用藥,可能會受到處分,“她説道。她手裏攥着止痛藥片,眼睜睜看着病人在痛苦中扭曲面容。

本文節選自2023年6月16日印刷版《護士與AI在患者護理上的衝突》。