Deepfakes、能源、中國、戰爭和選舉:AI政治已經來臨 - 彭博社

Niall Ferguson

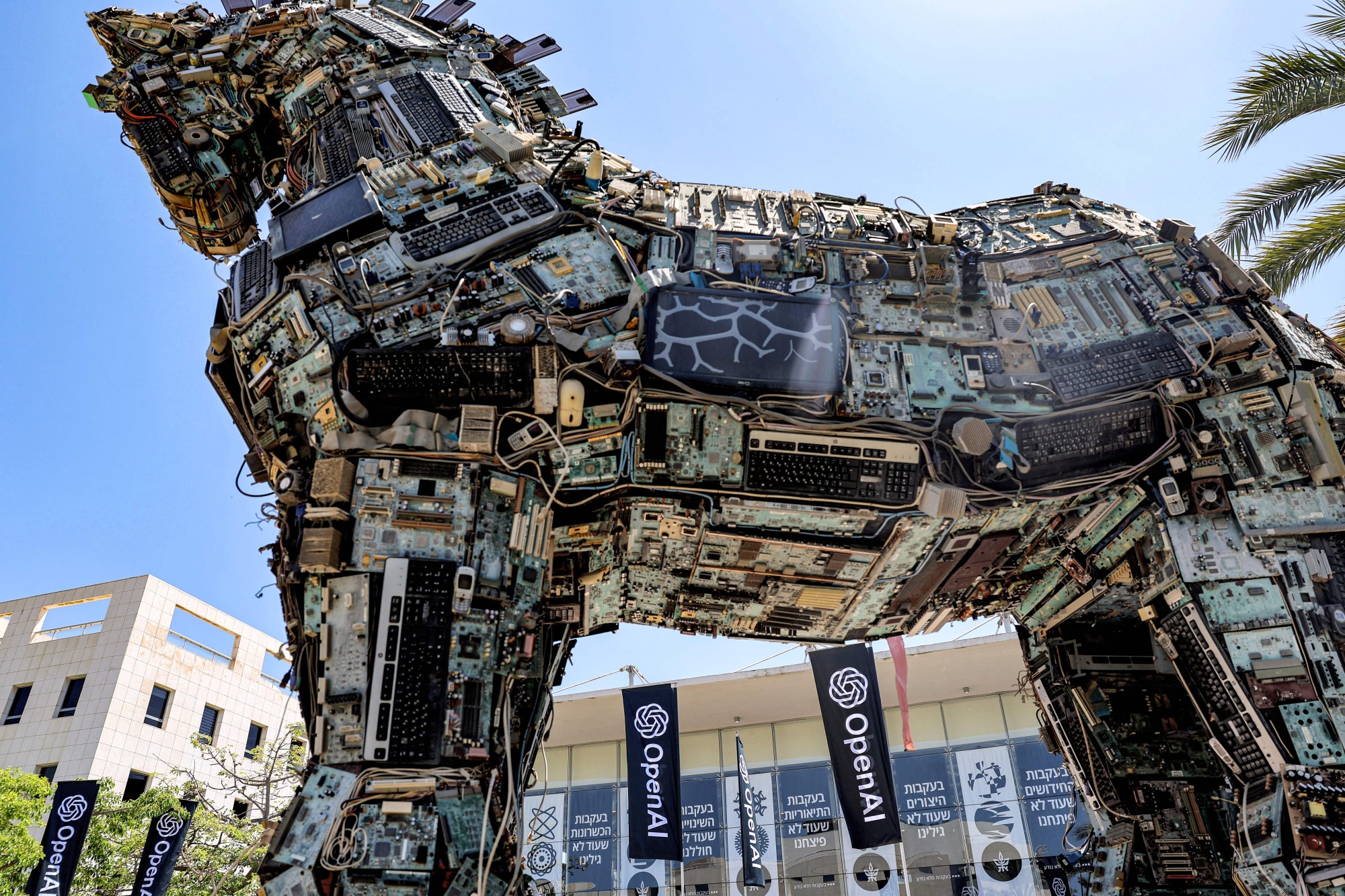

加油,@sama。

加油,@sama。

攝影師:傑克·蓋茲/法新社/蓋蒂圖片社

兩週前,我提出並試圖回答六個問題關於人工智能革命的經濟和金融後果。今天,我有更多 — 八個 — 政治和地緣政治問題。這些問題更難回答。

1. 人工智能會對2024年的選舉產生不利影響嗎?

這似乎是非常可能的。因為美國的選舉活動擁有比其他發達國家更大的競選預算,每一項新的通訊技術都會被政治企業家迅速採用。想想谷歌在2012年為奧巴馬總統競選提供了什麼,或者Facebook廣告為特朗普競選提供了什麼。在2020年,硅谷通過所謂的內容管理幫助了喬·拜登。

彭博觀點特朗普媒體的股價與其業務無關讓日食成為你孤獨的解藥人工智能會製造比揭露更多的假新聞嗎?《沙丘2》比福山更好地預測未來像OpenAI的GPT-4這樣的大型語言模型(LLMs)具有巨大的政治潛力。它們可以生成大量的似是而非的內容,幾乎不需要人類監督。這包括虛假電話和視頻剪輯。我們已經看到了第一個虛假電話(模仿拜登的聲音)在新罕布什爾州初選中。

很難相信政治上對人工智能的使用將被簡單地禁止。

但是,其大規模部署意味着什麼呢?最近的研究顯示,即使是比GPT-3更不先進的開源LLMs也能夠產生被調查對象評為與紐約時報同一主題材料一樣可信的內容。一項實驗研究表明,人工智能系統可以通過虛假的選民反饋淹沒立法者或政府機構。

其他調查顯示,即使選民被提醒要警惕深度偽造視頻,他們也不會變得更擅長識別深度偽造視頻,但他們會失去對真實視頻的信任。

所有這些可能意味着選舉將產生額外的公共壓力來進行監管,特別是如果發現某個競選活動以惡意方式使用人工智能。

2. 美國是否會通過監管來限制人工智能?

去年十月,拜登發佈了一項行政命令,詳細説明了他的政府監管人工智能的優先事項。

在其中一個更具約束力的安全規定中,該命令援引了1950年的國防生產法案,要求開發可能威脅國家安全的先進人工智能系統的公司通知聯邦政府並報告安全測試或“紅隊測試”的結果。此要求僅適用於非常龐大的系統(進行超過10的26次方次數的訓練運算)。

行政命令不規範公司構建AI模型的責任或要求許可,正如OpenAI首席執行官Sam Altman等人提出的那樣。 Altman在五月份向國會作證時呼籲成立一個新的聯邦機構來許可AI公司並監督審計。這是不太可能的。

因此,行政命令的可執行性和實施將在很大程度上取決於聯邦機構的執行和規則制定,以及司法審查和科技公司遵守新規定的意願。

聯邦貿易委員會主席Lina Khan 在紐約時報中寫道,去年五月,她的機構已經對一系列與AI相關的問題具有管轄權,包括競爭和消費者保護。她的文章提出了三個焦點問題:反壟斷、欺詐和濫用以及勞工歧視。去年七月,FTC啓動了一項調查,以確定OpenAI是否從事與隱私和數據安全相關的“不公平或欺騙性行為”。

在國會中,迄今為止最連貫的提案是美國AI法案的兩黨框架,由康涅狄格州民主黨參議員Rich Blumenthal和密蘇里州共和黨參議員Josh Hawley贊助。

Hawley-Blumenthal將澄清《通信廉正法》第230條——互聯網歷史上的一項關鍵立法——“不適用於AI”,這意味着公司將對傳播有害的AI生成內容承擔責任。該法案還將要求AI開發者和提供者向用户披露何時與AI系統互動;制定保護兒童的規則;讓消費者控制其個人數據在AI系統中的使用方式;要求AI生成的深度偽造內容加水印;並限制向中國轉讓AI技術。

這項立法會通過嗎?可能不會。國會在對新技術進行監管方面有着緩慢的記錄。從鐵路的發明到第一項聯邦監管之間的時間為62年。對於電話是33年;無線電是15年;互聯網是13年。核能是個例外:滯後時間僅為四年。

3. 歐洲能成功監管人工智能嗎?

歐洲委員會一如既往地希望在人工智能監管方面引領世界。其AI法案將於今年晚些時候正式通過,並且其大部分規定將於2026年生效,該法案規定了數據質量、監督和披露要求。

AI法案將AI系統分為四個級別,取決於它們可能對人類健康、安全和基本權利構成的威脅。每個級別都面臨不同的監管要求。包括某些形式的生物特徵監視和“社會評分”系統在內的不可接受風險應用被徹底禁止。關鍵基礎設施運營、教育培訓、邊境檢查和執法是被視為“高風險”的AI系統的例子。最低風險的AI系統包括垃圾郵件過濾器,它們只需遵守自願行為準則。最後,“透明度風險”AI系統,涉及與用户的互動(例如聊天機器人),必須披露其內容是由機器生成的。

歐洲人希望重複他們在在線隱私方面通過《通用數據保護條例》(GDPR)所取得的成就。許多非歐盟國家在其國內市場內採納了嚴格的歐洲監管標準,純粹是因為他們希望將產品銷售到歐盟市場。自2018年以來,GDPR監管機構已經處以45億歐元的罰款,儘管美國的大型科技公司已經通過訴訟進行了反擊。

然而,我懷疑歐洲人能否制定AI監管標準。2021年,華盛頓和布魯塞爾成立了貿易和技術理事會。在這個框架內,他們試圖並未能就AI監管的“自願行為準則”達成一致。歐洲面臨的一個大問題是幾乎沒有任何主要的人工智能公司,法國的Hugging Face是一個明顯的例外。

4. 是否存在全球治理體系的前景?

DeepMind的聯合創始人(2014年被Google收購)和微軟AI的新負責人穆斯塔法·蘇萊曼去年提出了一份雄心勃勃的藍圖,旨在建立一個國際“技術審慎”制度來監管這項技術。他和歐亞集團的伊恩·布雷默提出了一個模型,即“全球金融機構(如金融穩定理事會、國際清算銀行和國際貨幣基金組織)發揮的宏觀審慎作用”。

我仍然不相信AI可以像金融那樣受到監管。然而,布雷默-蘇萊曼模型還有另外兩個要素。一個是類似於氣候變化政府間專門委員會的機構,以確保我們定期進行嚴格的AI影響評估。另一個是“華盛頓和北京應該致力於創建由第三方提出和監督的共同點和甚至防範措施。在這裏,常見於軍備控制體制的監測和驗證方法可能會被應用。”

人工智能和核武器之間的類比顯然並不完美。正如蘇萊曼和布雷默自己所承認的:“人工智能系統不僅比核武器更容易開發、竊取和複製;它們由私營公司控制,而不是政府。”然而,他們——就像幾乎所有試圖系統地思考如何應對人工智能帶來的威脅的人一樣——又被引導回與冷戰軍備競賽的比較。

一個理想的全球治理體系將構建各國之間的協調,以阻止非國家行為者和流氓國家開發或獲取尖端人工智能模型。執法將通過全球出口管制制度來實現(針對GPU,即由Nvidia設計、由台積電製造的最複雜的半導體)和雲計算的全球瞭解客户協議。

這樣的系統已經在建設中。然而,出於地緣政治原因,它的目標是中國。由於中國是唯一的另一個人工智能超級大國,這顯然毫無意義。在他生命的最後一年,亨利·基辛格試圖在美國和中國之間建立一場有意義的人工智能軍備控制對話。這一舉措能夠長久存在是值得懷疑的。

歷史和最近的事件因此表明,在短期甚至中期內,全球人工智能治理體系是非常不太可能的。我們離人工智能限制談判的理念還有很長的路要走。因此,軍備競賽將繼續以目前的疾馳速度進行。

5. 中國能趕上嗎?

回到2021年,由前谷歌CEO埃裏克·施密特主持的一個委員會發布了一份報告,預測“中國可能超越美國成為世界人工智能超級大國。” 然而,這似乎並沒有發生。最大的中國LLM不及美國領先者。

為什麼中國落後?簡單的答案是它無法自行製造最複雜的半導體,而美國能夠限制其獲取由TSMC生產的以及由荷蘭公司ASML生產的複雜芯片製造機器。根據我的同事克里斯·米勒的著作芯片戰爭,“多達95%的中國服務器中運行人工智能工作負載的GPU由Nvidia生產。” 中國可以為自己生產較不花哨的芯片 — 例如,用於電動汽車的芯片。但無法生產AI芯片。

這是否意味着“科技戰”已經結束 — 起初是在唐納德·特朗普總統的政府針對華為和中興展開,最終在2022年10月商務部對所有中國公司實施限制 — 已經贏了?不要那麼快下結論。確實,中國在人工智能支出和人工智能公司成立方面落後於美國。但在機器人領域卻領先。中國正在極力尋找繞過美國限制的方法。Nvidia也並非對中國對其芯片的貪婪漠不關心。近年來,來自中國的收入佔該公司總收入的五分之一至四分之一。《經濟學人》並非唯一懷疑Nvidia芯片是否通過新加坡走私到中國。

美國仍然是人工智能人才的主要市場。但最新一期MacroPolo關於頂尖人工智能研究人員職業生涯的研究 — 那些在2022年12月神經信息處理系統(NeurIPS)會議上被接受論文的人 — 表明北京正在迎頭趕上。中國是很大一部分頂尖人工智能研究人員開始他們的學術生涯的地方,2022年達到47%,而2019年為29%。自2019年以來,美國在人工智能就業方面的主導地位已經受到侵蝕,從65%下降到57%。記住:蘇聯在核武器競賽中遠遠落後於美國。它花了20年時間趕上,但最終做到了。

6. AI真的是新的曼哈頓計劃嗎?

我的科技領主朋友Vinod Khosla和Marc Andreessen上個月就人工智能進行了有趣的交流。兩人都是著名的風險投資家。但Khosla是OpenAI的支持者,也是Altman的監管理唸的粉絲;而Andreessen更喜歡看到開源模式蓬勃發展。“你會開源曼哈頓計劃嗎?”Khosla在X(前身為Twitter)的交流中問道。“這對國家安全更為嚴重。我們正處於與中國的技術經濟戰中,而AI是必須取勝的。這正是愛國主義的真諦,而不是口號。”

正如我所説,人工智能與核裂變之間的類比遠非完美。但有一點對我來説非常引人注目。如今,世界上大約有12,500枚核彈頭,而隨着中國迅速增加其核武庫,這一數字正在上升。相比之下,目前只有436個核反應堆在運行。核能在全球總發電量中所佔比例已從1996年的15.5%下降至2022年的8.6%,部分原因是對少數核事故的政治過度反應對人類健康和環境的影響微乎其微。事實上,以絕對值計算,核電發電量在2006年達到峯值。

在考慮人工智能的可能用途時,我們應該記住,作為一個物種,我們有着一部記錄。是的,人工智能可以被用於各種美妙的用途。醫學科學的可能性尤其令人驚歎。但核裂變的歷史表明,我們至少會付出同樣多的努力來開發人工智能的破壞潛力。

7. 人工智能世界將需要多少能量?

核裂變和人工智能之間的一個重要區別在於人工智能只會 消耗 能量。但是需要多少呢?一些危言聳聽的評論者預測,到2030年,人工智能可能需要接近全球電力產量的四分之一。然而,我迄今閲讀過的最徹底的分析(由 Dylan Patel, Daniel Nishball 和 Jeremie Eliahou Ontiveros 撰寫,發表在SemiAnalysis上)得出結論稱,“到2030年,人工智能將推動數據中心使用全球能源產量的4.5%。”

這仍然是很多。由於很多人工智能活動集中在美國,數據中心“關鍵” IT容量將需要從2023年到2027年增加兩倍,從美國電力產量的4.5%增加到14.6%。

最近幾周,美國主流媒體開始意識到這意味着什麼,尤其是對於減少由天然氣產生的電力份額、增加由“可再生”來源產生的份額的夢想。

那個夢想已經破滅。

8. 人工智能將對戰爭的未來意味着什麼?

安德森在他的人工智能文章中最值得懷疑的斷言是,“為什麼人工智能將拯救世界”,他聲稱“人工智能將通過大幅降低戰時死亡率來改善戰爭,因為人工智能將幫助政治家和指揮官們“做出更好的戰略和戰術決策,最小化風險、錯誤和不必要的流血。”

我強烈懷疑情況將相反。在即將到來的人工智能戰爭中,由於人工智能將使導彈和其他武器更加精確,軍隊的死亡率將非常非常高。這已經在烏克蘭顯現,那裏的無人機戰爭正在逐漸從遠程人駕駛系統過渡到人工智能驅動的自主系統。

我們這個時代的中心問題應該是顯而易見的。美國實際上在沒有仔細考慮的情況下,將最先進的半導體制造外包給了中國聲稱擁有主權的一個島嶼。 TSMC的主要原因 —— 該公司生產超過90%的GPU —— 其市盈率僅為14.3的原因是其易受攻擊的位置。

引用 華爾街日報,“美中圍繞台灣的戰爭幾乎肯定會導致TSMC的晶圓廠被摧毀。這將使全球芯片供應鏈倒退五到十年,從而破壞人工智能的繁榮。” 再次引用克里斯·米勒的話,“如果台灣的晶圓廠被摧毀,我們在接下來的一年內將生產的計算能力將減少37%。” 即使中國“只是”封鎖了台灣,“TSMC的芯片生產也將停止,因為政府會對能源進行配給。”

如果美國能在美國本土建立自己的TSMC版本,那將非常非常好。這個夢想激發了充滿補貼的CHIPS法案。

我只能説我 不抱太大希望。

弗格森還是Greenmantle諮詢公司、FourWinds Research、Hunting Tower風險投資合作伙伴和電影製片人Chimerica Media的創始人。

更多來自Niall Ferguson在彭博觀點的內容:

- 抵抗 是徒勞的,但也許人工智能除外

- 全球人口崩潰 不再是科幻

- 如果你認為第三次世界大戰是不可想象的,讀一下這篇文章

想要更多彭博觀點嗎? OPIN <GO> 。或訂閲 我們的每日新聞簡報**。**