為什麼人工智能如此昂貴 - 彭博社

Seth Fiegerman, Matt Day

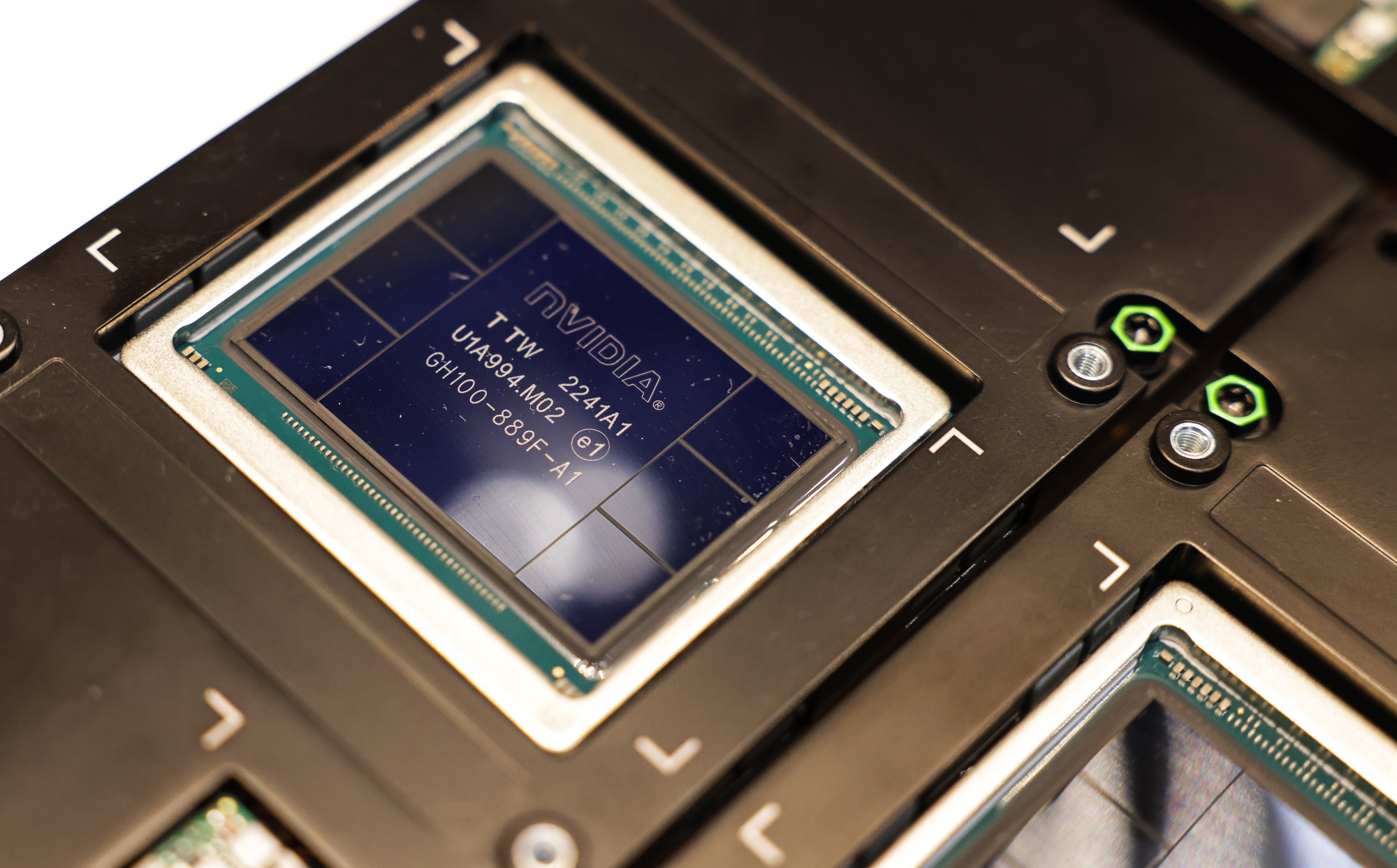

Nvidia Corp. HGX H100人工智能圖形處理單元

Nvidia Corp. HGX H100人工智能圖形處理單元

攝影師:I-Hwa Cheng/Bloomberg 中心的Satya Nadella在4月30日抵達雅加達獨立宮與Joko Widodo會面。攝影師:Bay Ismoyo/AFP/Getty Images在生成式人工智能狂熱持續近18個月後,一些最大的科技公司證明了人工智能可以成為真正的收入驅動力。但這也是一個巨大的金錢陷阱。

中心的Satya Nadella在4月30日抵達雅加達獨立宮與Joko Widodo會面。攝影師:Bay Ismoyo/AFP/Getty Images在生成式人工智能狂熱持續近18個月後,一些最大的科技公司證明了人工智能可以成為真正的收入驅動力。但這也是一個巨大的金錢陷阱。

微軟公司和Alphabet Inc.的谷歌報告顯示,他們的最新季度業績中雲服務收入激增,因為企業客户在人工智能服務上的支出增加。而Meta Platforms Inc.雖然在技術商業化方面落後,但表示其人工智能工作已幫助增強用户參與度和廣告定位。

為了實現這些早期收益,這三家公司已經花費數十億美元來開發人工智能,並計劃進一步加大這些投資。

4月25日,微軟表示,在最近一個季度,其資本支出達到了140億美元,並預計這些成本將“大幅增加”,部分原因是人工智能基礎設施投資。這比去年同期增長了79%。Alphabet表示,在該季度花費了120億美元,比去年同期增長了91%,並預計今年其餘時間將“達到或超過”這一水平,因為公司專注於人工智能機遇。而Meta則提高了全年投資預期,現在認為資本支出將達到350億至400億美元,這將是該範圍的高端增長42%。公司指出正在積極投資於人工智能研究和產品開發。

人工智能的成本上升讓一些投資者措手不及。特別是 Meta 的股票,在支出預測和增長速度低於預期的情況下下跌。但在科技行業內部,長期以來一直認為人工智能成本會上升。這其中有兩個關鍵原因:人工智能模型變得越來越大且開發成本更高,全球對人工智能服務的需求需要建立更多數據中心來支持。正在嘗試使用這類人工智能服務的企業可能會花費數百萬美元來定製來自 OpenAI 或 Google 的產品。一旦運行起來,每次有人與聊天機器人交互或請求人工智能服務分析銷售數據時都會有額外成本。但更昂貴的工作是為這些人工智能系統打下基礎。以下是這些努力的一瞥。

大型語言模型變得更大

如今最知名的人工智能產品,包括 OpenAI 的 ChatGPT,都是由大型語言模型驅動的 — 這些系統被喂入大量數據,包括書籍、文章和在線評論,以便為用户的查詢提供最佳可能的回應。許多領先的人工智能公司押注的是,通往更復雜人工智能的道路 — 甚至可能是能夠在許多任務上勝過人類的人工智能系統 — 就是使這些大型語言模型變得更大。這需要獲取更多數據、更多計算能力,還需要對人工智能系統進行更長時間的訓練。在四月初的一次 播客採訪中,OpenAI 競爭對手 Anthropic 的首席執行官 Dario Amodei 表示,目前市場上的人工智能模型訓練成本約為1億美元。“目前正在訓練中的模型,以及將在今年晚些時候或明年初推出的模型,成本接近10億美元,”他説。“然後我認為在2025年和2026年,我們將更接近50億或100億美元。”

芯片和計算成本

其中大部分成本與芯片有關。這些不是讓英特爾公司聞名的中央處理單元(CPU),也不是為數十億智能手機提供動力的精簡版移動芯片。為了訓練大型語言模型,人工智能公司依賴於可以以高速處理大量數據的圖形處理單元(GPU)。這些芯片不僅供應短缺,而且價格昂貴,最尖端的功能主要由一家公司生產:英偉達公司。

英偉達的H100圖形芯片,是訓練人工智能模型的黃金標準,據估計售價為30,000美元 — 一些轉售商甚至以多倍的價格出售。大型科技公司需要大量這些芯片。Meta首席執行官扎克伯格之前表示,他的公司計劃在今年年底前收購35萬個H100芯片,以支持其人工智能研究工作。即使他獲得批量購買折扣,這也很容易累積到數十億美元。

公司可以在不購買實際芯片的情況下進行這項工作,但借用也很昂貴。例如:亞馬遜公司的雲計算部門將以大約每小時6美元的價格租給客户由英特爾製造的大型工作處理器集羣。相比之下,一組英偉達H100芯片的成本幾乎是每小時100美元。

上個月,英偉達推出了一款名為Blackwell的新處理器設計,處理大型語言模型的速度是多倍於H100系列的Hopper線,價格預計也會相似。英偉達表示,需要大約2,000個 Blackwell GPU來訓練一個1.8萬億參數的人工智能模型。這是OpenAI的GPT-4的估計大小,根據一份針對這家初創公司使用其文章訓練人工智能系統的《紐約時報》訴訟。相比之下,英偉達表示,需要8,000個Hopper GPU來執行相同的任務。但這種改進可能會被行業推動構建更大的人工智能模型所抵消。

數據中心

購買這些芯片的公司需要一個地方來放置它們。Meta與最大的雲計算公司 — 亞馬遜、微軟和谷歌 — 以及其他提供計算能力租賃的公司正在競相建設新的服務器農場。這些建築通常是定製建造的。它們容納硬盤架、處理器、冷卻系統、電氣設備和備用發電機。

研究機構Dell’Oro Group估計,今年公司將花費2940億美元建設和裝備數據中心,而2020年這個數字為1930億美元。其中很大一部分的擴張是由數字服務的廣泛增長所推動 — 視頻流媒體、企業數據的爆炸增長,以及你的社交媒體信息。但越來越多的支出被用於購買昂貴的英偉達芯片和其他專門硬件,以支持人工智能的蓬勃發展。

交易和人才

儘管芯片和數據中心佔據了大部分成本,一些人工智能公司也花費數百萬美元從出版商那裏獲取數據許可。OpenAI已經與幾家歐洲出版商達成協議,將他們的新聞內容納入ChatGPT,並訓練其人工智能模型。這些協議的財務條款尚未披露,但彭博新聞此前曾報道,OpenAI同意支付數千萬歐元給Politico和Business Insider的德國出版商Axel Springer SE,以使用其新聞文章的權利。這家初創公司還與時代、CNN和福克斯新聞進行了許可內容的談判。儘管OpenAI在獲得許可協議方面更為活躍,大型科技公司也在尋找獲取構建引人注目人工智能工具所需的語言數據的方法。據路透社報道,谷歌已經達成了價值6000萬美元的協議,從Reddit許可數據。據紐約時報報道,Meta員工據稱討論過收購書商西蒙與舒斯特公司。科技公司還在為人工智能人才展開激烈的爭奪戰。去年某個時候,Netflix Inc.發佈了一個AI產品經理職位的廣告,薪資高達90萬美元。

更便宜的替代方案

微軟,它在推動大型語言模型狂熱方面做得比大多數公司都多,最近表示將嘗試一種不同的方法。該公司預告了三個較小的AI模型,計算量較小。微軟表示大型語言模型“仍將是解決許多複雜任務的黃金標準”,比如“高級推理、數據分析和上下文理解”。但對於某些客户和用例來説,較小的模型可能已經足夠了。其他公司,包括Sakana AI,一家由兩名前谷歌員工創立的初創公司,也在專注於較小的模型。“你並不總是需要一輛跑車,”弗雷斯特研究公司的高級分析師羅温·柯蘭説道,他專注於人工智能。“有時候你需要一輛麪包車或皮卡。並不是每個用例都需要每個人都在使用的一類模型。”然而,目前在人工智能領域的共識是,越大越好。這將是昂貴的。

微軟公司將投資17億美元在印度尼西亞建設雲計算和人工智能基礎設施,押注於東南亞最大經濟體的增長。

首席執行官薩蒂亞·納德拉在週二與印尼總統佐科·維多多會面後宣佈了這一支出,將在四年內完成。該公司還承諾幫助東南亞250萬人獲得人工智能技能培訓,其中包括印度尼西亞的84萬人。