識讀2300多年的戰國竹簡,竟只用2B端側大模型!面壁發佈新一代“小鋼炮”_風聞

量子位-量子位官方账号-昨天 22:04

金磊 發自 凹非寺

量子位 | 公眾號 QbitAI

識讀距今2300多年戰國時期的上古竹簡,AI正在立功。

而且在這背後的“大功臣”,竟是隻有2B大小的多模態大模型!

這批上古竹簡,由清華大學於2008年7月收藏,因此也被稱為清華簡。

清華簡的數量大約是2500枚,其內容在已被發現的先秦竹簡中也是前所未見,被認為是繼甲骨文、敦煌遺書、居延漢簡、雲夢秦簡之後的又一重大發現。

不過也正因如此,識讀清華簡便成了老大難的問題,因為上面的文字基本上都是楚文字,秦始皇統一文字後就已被廢棄。

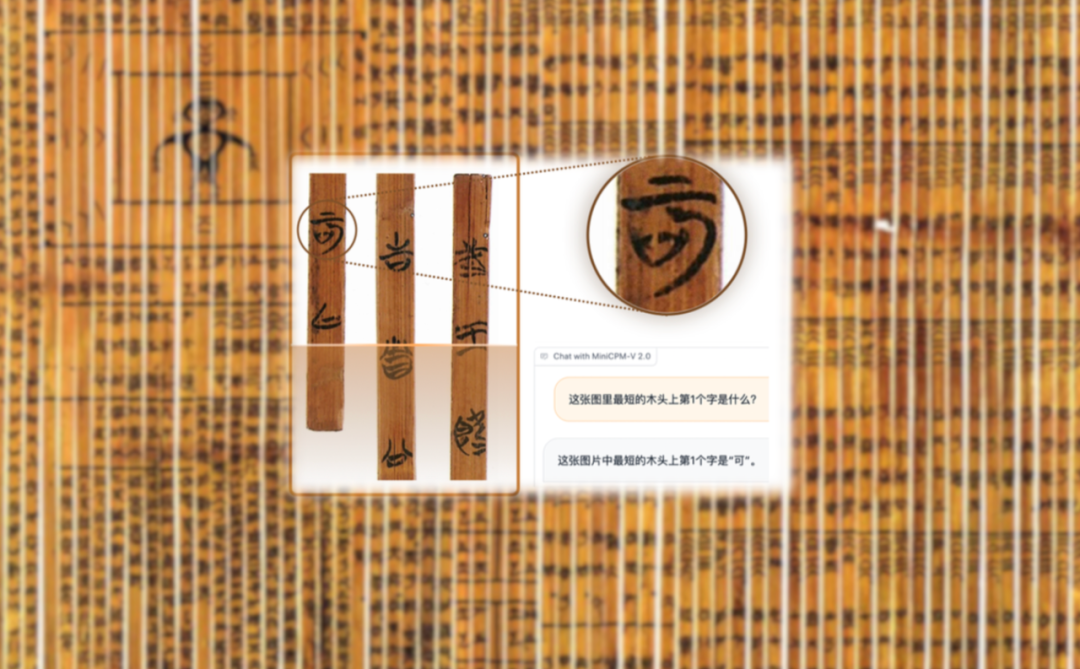

而就在最近,研究人員在一個2B大小的多模態大模型助力之下,成功地在清華簡的版式檢測和文字識別上取得突破:

例如詢問這個大模型:

這張圖裏最短的木頭上第一個字是什麼?

它不僅可以準確找到最短的竹簡,也能精準地識別出上面的楚文字是現代的**“可”**字。

即使是和現代文字差異較大的古文字,這個大模型也能查字詢意,得出正確結論是**“我”**。

並且研究團隊還表示,他們正在嘗試繼續用這種方式進一步做探索。

嗯,不得不説,大模型**“以小博大”**這事,已經開始波及到多模態了。

那麼這個2B大模型,到底是什麼來頭?

最強端側多模態大模型,手機就能跑

不賣關子。

這個2B多模態大模型,正是由清華系初創公司面壁智能最新升級的小鋼炮系列,最強端側多模態大模型——MiniCPM-V 2.0。

劃個重點:手機端就能跑!

MiniCPM-V 2.0的地址:https://github.com/OpenBMB/MiniCPM-V

MiniCPM系列地址:https://github.com/OpenBMB/MiniCPM

那麼它的能力到底幾何?為什麼説是最強端側多模態大模型?

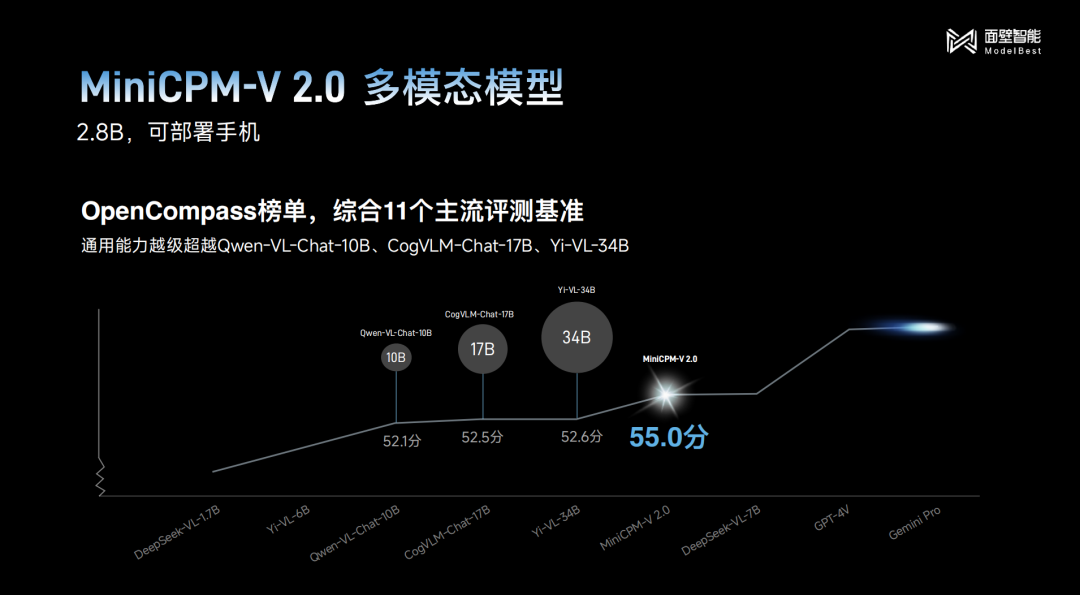

首先來看多模態通用能力,這也是能夠衡量其底座水平的一個重要指標。

在多模態大模型綜合評測權威平台OpenCompass榜單上測試的結果顯示,MiniCPM-V 2.0雖然只有2B的體量,但得分已經超過了10B、17B甚至34B的主流選手:

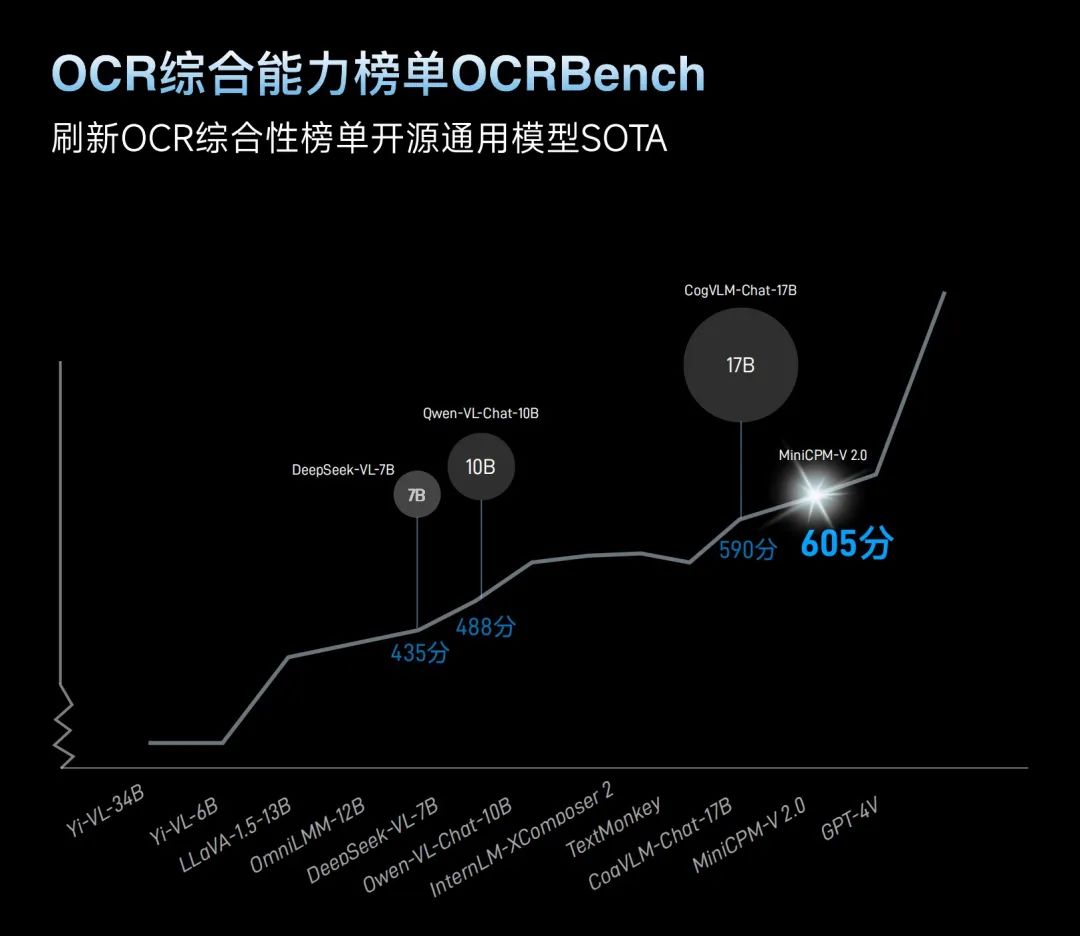

其次再看OCR(光學字符識別)綜合能力,這可以説是檢測多模態識別與推理能力最硬核的指標。

在權威的OCR綜合能⼒榜單OCRBench中,MiniCPM-V 2.0同樣是用2B的“姿勢”競技,刷新了開源模型SOTA:

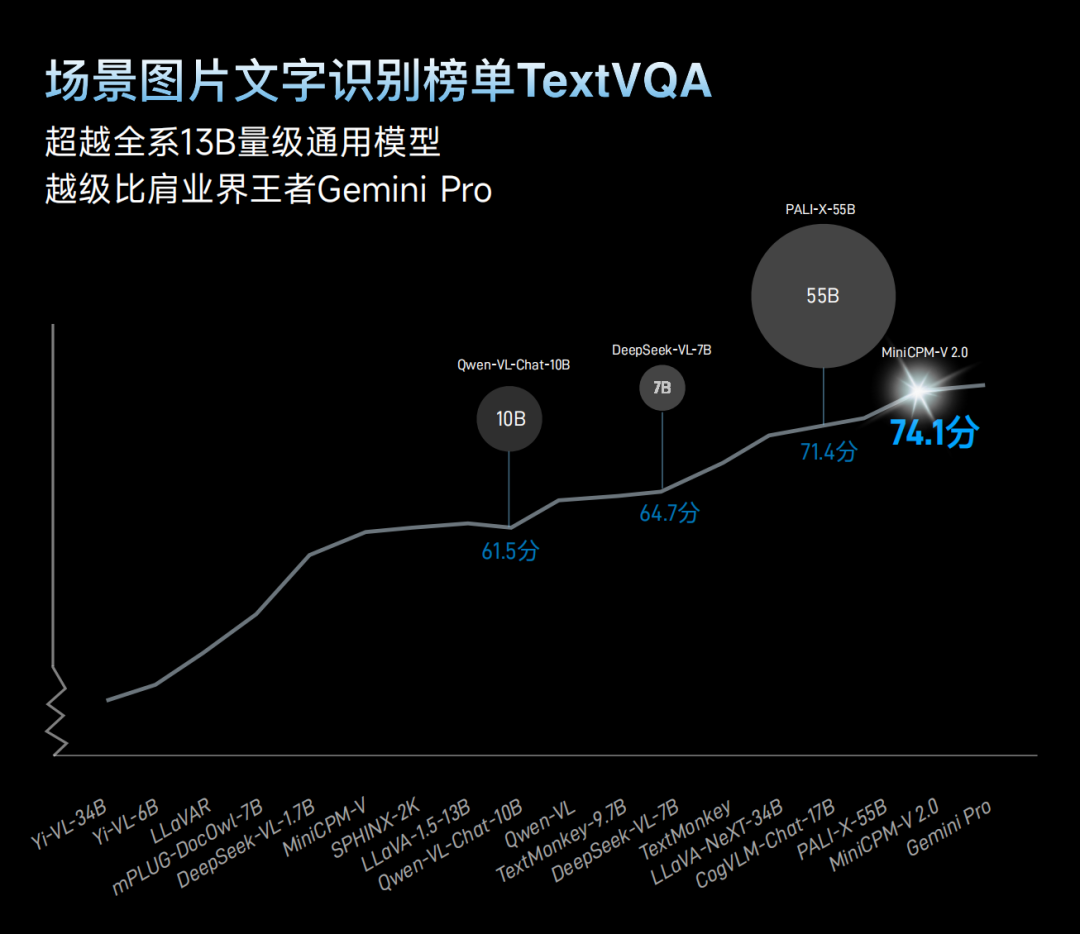

並且在場景圖片文字識別榜單TextVQA中,MiniCPM-V 2.0更是直接秒殺了全系13B體量的通用模型。

甚至部分能力已經可以比肩多模態領域的王者Gemini Pro:

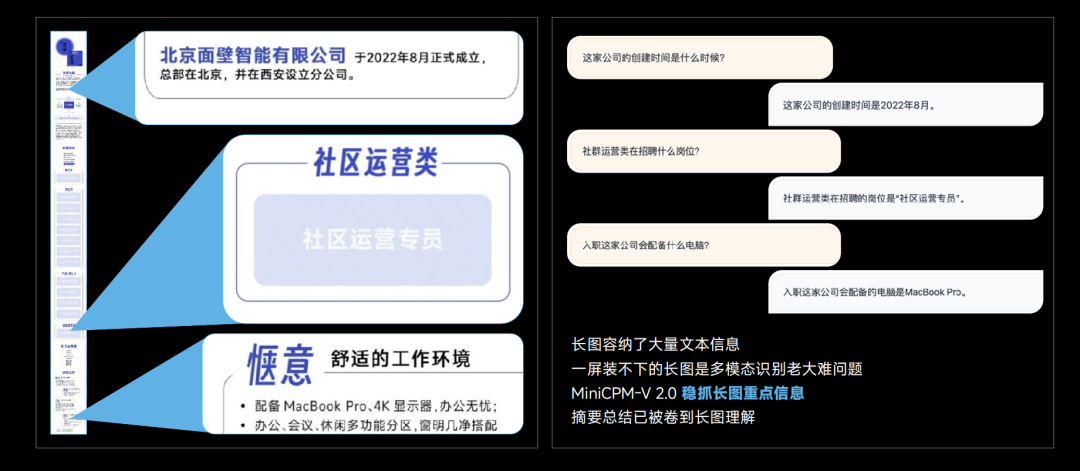

不僅如此,在中文OCR能力方面,MiniCPM-V 2.0展現的性能效果明顯超越了GPT-4V。

同樣是識別一張街景圖,MiniCPM-V 2.0可以準確地叫出大廈的名字,但GPT-4V卻只能回答“看不清楚”。

那麼,MiniCPM-V 2.0是怎麼做到不“近視”的呢?

傳統做OCR的方法是比較粗暴的:它們只能處理一個固定尺寸的圖片,因此就會把偏大或不規則的圖片強行進行壓縮。

這就會導致原始圖片中大量信息的丟失,再次放大的時候就彷彿近視眼一樣,很多細節都變成了馬賽克:

同樣的道理,傳統的方法在處理極端長寬比的長圖(如1:9)時效果會大打折扣,因為很長的圖壓縮成正方形同樣會造成大量信息丟失。

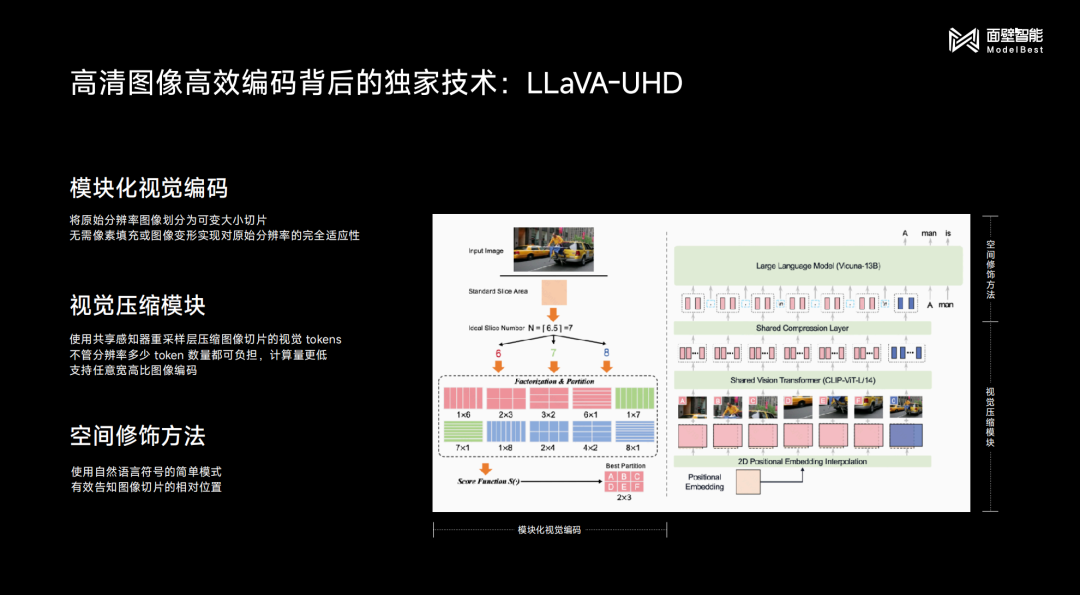

為此,面壁智能團隊所提出的解法就是**“分而治之”**——

並不是暴力壓縮,而是把不規則的圖片分成若干個小的圖片,然後再按照大模型OCR的方式去自適應處理。

與此同時,為了解決大圖像“切塊”後所帶來的計算量增長問題,團隊還針對性地做了一個視覺模塊壓縮的工作,可以讓增長的計算量通過局部的一些視覺感知壓縮方法再打下來。

由此就保證了計算量和模型效果之間的平衡。

據團隊介紹,MiniCPM-V 2.0可以處理最大180萬像素高清大圖,甚至1:9極限寬高比的高清圖片,對它們進行高效編碼和無損識別。

具體效果如下所示:

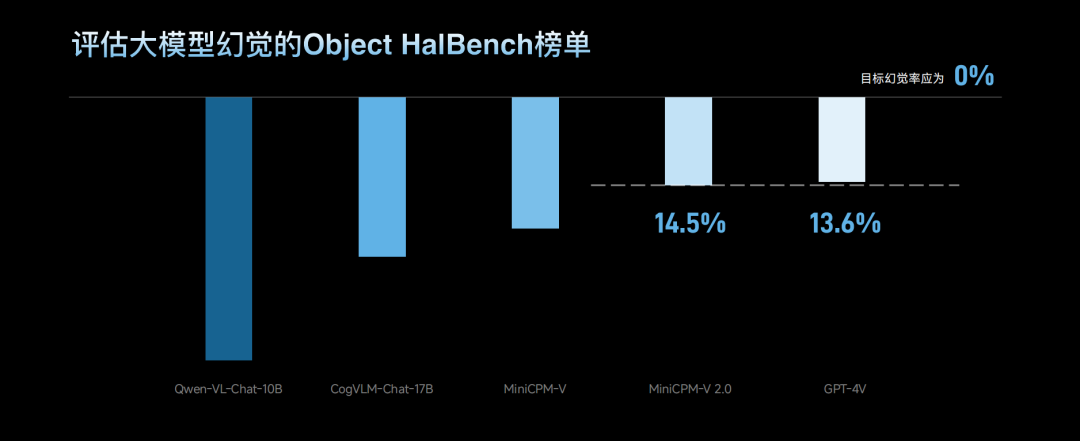

除了多模態通用能力和OCR綜合能力之外,幻覺也是考量一個多模態大模型性能的重要指標之一。

在這方面,MiniCPM-V 2.0所參與的則是Object HalBench榜單。

結果顯示,其幻覺水平是與GPT-4V持平的:

而MiniCPM-V 2.0,也還僅是面壁智能最新發布內容中的一隅。

除了它之外,面壁智能還發布了額外三個同樣是“小體量”的大模型。

由此,在MiniCPM 2.0的矩陣中就形成了“四大金剛”屹立的陣容——四驅小鋼炮。

那麼四驅小鋼炮中的其它三個大模型還解鎖了哪些能力,我們繼續往下看。

1元=4150000 tokens,適用更多端側場景

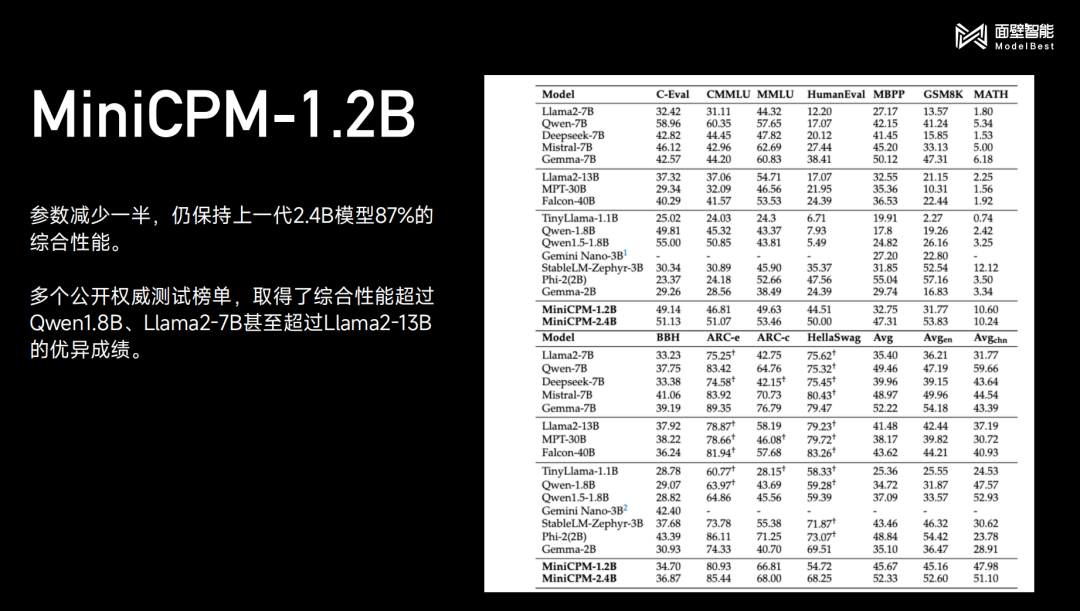

在追求“小”這件事上,面壁智能再次刷新自己的紀錄——MiniCPM-1.2B。

至於它的特點,一言蔽之:

參數減少一半,仍保持上一代2.4B模型87%的綜合性能。

同樣的,在公開測評榜單中,其成績依舊是做到了越級超越:

值得一提的是,MiniCPM-1.2B現在也是可以在手機端側跑起來的那種,速度可以達到25tokens/s(人類説話速度的15-25倍):

**△**現場演示效果

**△**現場演示效果

不僅如此,MiniCPM-1.2B還做到了把價格和內存打下去。

以iOS為例,MiniCPM-2.4B的量化模型是2.10G;而到了MiniCPM-1.2B,則只需要1.01G,內存減少51.9%。

價格方面更是打了6折:1元=4150000 tokens。

(計算方式為:蘋果A17 Pro為130美元(約人民幣950元),如開metal,速度最大為 25 tokens/s;若芯片使用5年,則推理代價為 (25×3600×24×365×5)/950=415萬 tokens/元)

這也就意味着現在更多端側場景“快好省”地跑大模型成為了可能,不只是手機,還包括穿戴設備、PC、智能家居、汽車等等。

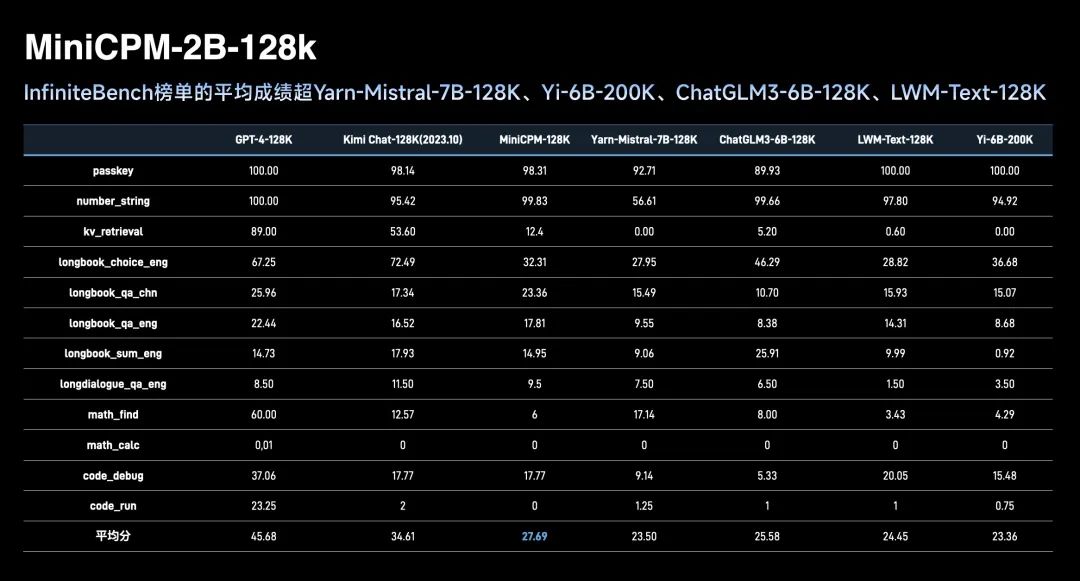

在各個大模型玩家都在你追我趕的長文本領域,面壁智能這一次也出手了——MiniCPM-2B-128K。

直接解鎖了一個新的之最——最小的128K長文本大模型。

在InfiniteBench榜單的平均成績也是超越了同體量的其它選手:

而之所以要做這個工作,在面壁智能看來,是因為目前在實際真正需要調用長文本大模型的時候,還是需要非常大的內存才能做較好的推理工作。

面壁智能表示,他們還將繼續對MiniCPM-2B-128K做優化工作,儘快讓其能夠在端側跑起來。

除此之外,面壁智能還在另一個大火的技術上發力,那便是MoE(混合專家)——發佈了MiniCPM-MoE-8x2B模型。

(MoE能在不增加推理成本的前提下,為大模型帶來性能激增。)

通過MoE的性能增強,讓2B小鋼炮(MiniCPM 1.0)在其原來的基礎之上性能平均提高4.5個百分點。

從榜單成績上來看,MiniCPM-MoE-8x2B模型做到了在性能上的越級超越,並且推理成本僅為Gemma-7B的69.7%:

以上就是四驅小鋼炮的全部內容了。

不難看出,四驅小鋼炮中的每一個“驅動力”都主打**“夠小,但能打”**。

而且縱觀面壁智能此次的發佈,提及最多的兩個關鍵詞就是**“端側”和“最小”**。

那麼面壁智能為何要如此極致地追求於此?

端側,需要高效大模型

其實從大模型整體的發展趨勢來看,這兩個關鍵詞早已是定數。

自從ChatGPT引爆大模型以來,先是在國內外引發了一波百模大戰的熱潮,都將極大的算力和資金投入到了訓練的過程當中。

而當底座的大模型訓練完畢之後,各個大模型玩家又將工作重心向推理側傾斜,隨即也迎來了各式各樣AIGC應用的百花齊放。

與此同時,大模型不再僅僅較真於參數規模、跑分和測評,更注重在應用側發力。

一言蔽之,比的就是看誰能**“快好省”**地用起來。

在端側的表現尤為明顯,比如大火的AI手機、AI PC便是很好的印證;而要讓大模型能夠在端側絲滑地跑起來,那麼其體量註定便不能過於龐大。

這就註定了端側的大模型必須要滿足兩點:要小,還要性能高效;也就不難理解面壁智能為何如此極致地追求於此了。

那麼接下來的一個問題是:要怎麼做?

面壁智能CEO李大海給出了一種**“高效公式”**解法:

高效大模型=高效訓練+高效落地+高效推理

首先在高效訓練這件事上,從面壁智能的first day開始,就已然是一個終極目標一樣的存在了。

面壁智能最早訓練大模型之際還並沒有多機多卡的訓練框架,為此,團隊便自主研發了BMTrain框架來支撐大模型的訓練,成本相比於GPT-3直接下降了90%之多。

現如今,面壁智能在高效訓練中持續死磕的一個目標就是**“高效Scaling Law”**,這也是“第一性原理”一樣的存在。

它不同於OpenAI向上大力出奇跡的玩法,主打的就是爭取更大的模型壓縮效率,用更少的高質量數據訓練出更好、更小的模型,這也是避免算力等資源巨大浪費的方法之一。

其次是高效落地,具體來説便是AI智能體(Agent)。

早在去年3月份之際,面壁智能便已經發表了關於AI智能體的相關論文,隨後又將其演變成SaaS級智能軟件開發平台ChatDev,就是為了把這種“一句話搞開發”的門檻再次打下去。

具體而言,在產品版ChatDev加持之下,在開發的整個流程中,從產品經理到程序員,再到設計和測試等等,統統都是AI智能體;開發的迭代,也變成了有想法就行的事。

要知道,常規軟件的開發週期是在2-3周,且成本在10000-50000美元之間(包括人力);如此對比起來,可真的是大寫的“降本增效”!

除此之外,基於其大模型底座的基礎能力,面壁智能還曾開源了兩項重磅的工作——AgentVerse和XAgent;加上我們剛才提到的ChatDev,三者共同形成了大模型驅動的AI Agent**“三駕馬車”**,圍繞的核心便是AI智能體。

這也正是AI智能體能夠將落地這件事變得高效的原因。

到這裏,僅是在高效訓練和高效落地這件事上,面壁智能就已經形成了**“大模型+AI智能體”**這樣的技術路線。

而就在前不久,AI大牛吳恩達也公開在X中發表觀點,對這樣的模式給予了高度的認可。

至於高效大模型的最後一個部分高效推理,則是端雲協同技術。李大海對此表示:

我們在做出更小的大模型之後還是不夠的,我們還希望通過端和雲的協同來讓所有的大模型的應用都能夠做到一個更低的推理成本。

在這一方面,面壁智能其實也早已有所涉獵,所提出的銜尾蛇投機採樣技術,可以説是打破了傳統雲側大模型服務方案中因大模型串行逐 token 生成並伴隨每次生成帶來的頻繁訪存,所造成的遠低於計算上限的讀寫速度瓶頸。

具體到端、雲之間的協作,就是將起草的小模型放在手機側、效果更好的大模型放在雲側,通過用小模型給大模型打草稿、做驗證的方式,減少雲端訪存讀寫工作,為雲端減負。

如此,大小模型通過敏捷的雙向反饋機制,得到推理速度提升的互相激發。

以上便是面壁智能的**“高效公式”**了。

總結來看,面壁智能到目前為止所發力的一切,也與其智周萬物的願景高度契合——就是要讓大模型“快好省”地用起來。

One More Thing

面壁智能在近日也迎來了融資方面的好消息——

完成新一輪數億元融資。

李大海在公開信中也透露了資金的用處,依舊將是技術和人才:

我們將進一步加速團隊建設,提升面壁智能在大模型領域的技術實力和市場競爭力。

特別地,我們將會着重引入更多優秀人才,加強大模型發展的底層算力與數據基礎,持續引領「高效大模型」路線,推動大模型高效、快步應用落地。

有技術,有人才,有市場,面壁智能是值得繼續關注一波的大模型實力派選手了。

MiniCPM-V 2.0的地址:https://github.com/OpenBMB/MiniCPM-V

MiniCPM系列地址:https://github.com/OpenBMB/MiniCPM