特斯拉放大招,自動駕駛的GPT時刻就要來了?_風聞

酷玩实验室-酷玩实验室官方账号-2小时前

今年的特斯拉,真是有點兒流年不利的感覺。

自從開年以來,其業績就一直不太給力,第一季度的表現實在“慘不忍睹”,車輛交付量才38.68萬輛,這可是自2022年第三季度以來頭一回落到40萬輛以下,同比也是下滑了9%。

更誇張的是特斯拉的股價,已經從23年中最高點的超過293美元,跌到了現在的147美元,直接腰斬。

特斯拉在2023年敗給了比亞迪,失去了全球電動車企頭把交椅,今年中國車企的降價和車型迭代節奏之快,完全不給它任何喘息的機會。2024年的特斯拉就如同開局紅藍buff都被反了的打野,下滑趨勢根本看不到任何盡頭。

於是乎,龍哥終於放出了最後的大招,宣佈在8月8日推出那個大家期待已久的無人駕駛出租車Robotaxi。

這樣的動作,無疑加大了業界對“自動駕駛”的想象。

而從特斯拉今年的表現來看,龍哥也似乎一直在有意推動着自動駕駛“GPT時刻”的到來。

就拿特斯拉最近更新的FSD V12.3版本來説,這個版本的平均無接管里程大幅提升,從100多英里一下子提升到了386.7英里,等於説你從北京開到青島,或者從上海開到合肥,中間都不用接手。並且,馬斯克要求在試駕中強制加入智駕體驗環節,甚至還宣佈美國所有特斯拉適用車型免費試用FSD一個月。

這些動作,無疑都是在為自動駕駛技術的普及和推廣做鋪墊。

而除了特斯拉之外,華為這樣的中國大廠,近期也在自動駕駛方面動作頻頻。

就在今年大年初三那天,餘大嘴在朋友圈曬出了自己從安徽老家一路自駕回深圳的過程,開的是華為的問界M9。這趟行程全程1314公里,得開15個小時。

這一路上,華為智駕的表現那是相當給力,全程基本上都靠車輛自己搞定,人工接管那是到了高速收費站才用得上。

自從去年AI大模型興起後,自動駕駛就像是打了一針強心劑,整個行業都活躍了起來。

除了特斯拉的FSD,國內的毫末智行和長城汽車共同開發自駕大模型DriveGPT,也走上了“自動標註數據”、“用模型生成罕見場景”的路子,同時把對於模糊車道線的識別能力提升到了90%以上。

那麼,這一系列新氣象,是否説明自動駕駛的“GPT時刻”真的要來了?

安全之檻

特斯拉的FSD(完全自動駕駛系統)雖然放出了要在8月正式運營的風聲,想要在市場上走得更遠,首先得過“安全”這道坎兒。

根據美國國家公路交通安全管理局(NHTSA)的數據:

自2019年以來,美國涉及特斯拉自動輔助駕駛模式有關的車禍事故,達到736起,這些意外車禍導致了17人死亡。

雖然相較於美國每年超過四萬人因為交通事故喪生來説,特斯拉輔助駕駛的事故數看起來微不足道,但民眾向來對於自動駕駛有着相比人類駕駛和輔助駕駛,更嚴苛得多的安全要求。

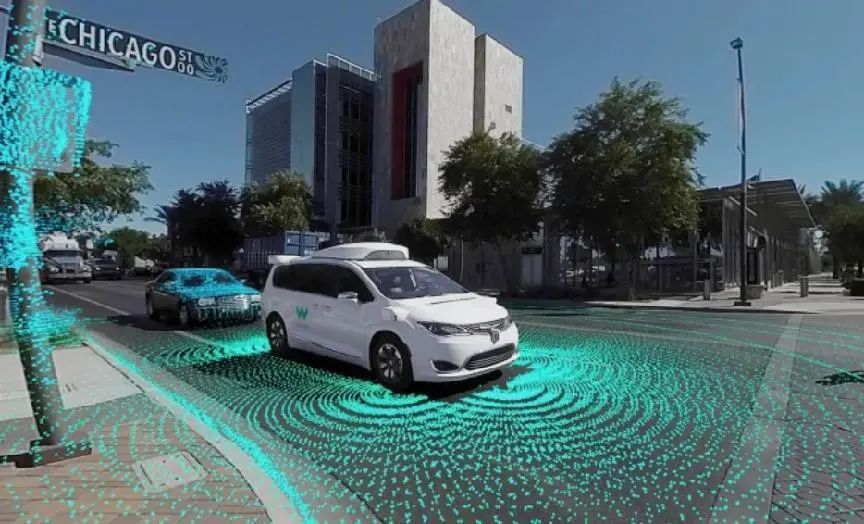

就拿已經在美國部分地區開展自動駕駛出租車業務的Waymo和Cruise為例。

根據加利福尼亞機動車輛部門的記錄,從2022年開始,Cruise報告的68起碰撞中,有14起涉及到了傷害。

其中最嚴重也是最讓人耳熟能詳的,莫過於去年10月,一名女性行人在舊金山市區街道上,被一輛人類駕駛的轎車撞到了Cruise無人駕駛出租車面前,這時候Cruise的AI出現了明顯的誤判,先是沒有識別出前面躺了一個人,直接碾壓了這位女士,然後又誤認為碾壓的顛簸來自於車輛側面碰撞,於是選擇了靠邊停車,把這位女士拖着開了6米。

而正是這起事件,導致了Cruise的無人車被停運至今。

同樣地,在今年2月初,Waymo旗下一輛Robotaxi撞上了騎自行車的人,造成輕傷,由於Waymo和Cruise並稱北美自動駕駛兩大巨頭,在Cruise拖曳行人事件後,此事無疑是火上澆油,加大了公眾對自動駕駛的成見。

在這樣濾鏡下,自動駕駛的車輛在部分民眾眼裏幾乎成了一種“邪物”,今年2月春節期間,在舊金山唐人街,一羣青少年打砸並燒燬了一輛Waymo無人駕駛汽車。

這樣的情況,不禁讓人在心中犯起了嘀咕,那就是:**自動駕駛發展到今天,已經足夠安全了嗎?**值得讓人類交出控制方向盤的權力了嗎?

要回答這個問題,就不能光看表面的事故,而要細究這些事故背後,相應的自動駕駛車輛使用的是哪種技術。

以去年拖曳行人的Cruise為例,雖然它跟Waymo同為自動駕駛巨頭,但二者具體的技術,實則是兩種不同的流派。

Waymo這一流派的做法,相當於一個拉力賽車手,在賽前先把賽道的路況、景物什麼的通過各種傳感器(攝像頭、雷達等)收集並繪製成一張精細到每個路口、每棟建築的“路線圖”。然後在真正開車時,通過不斷對照這張大地圖,提前預判接下來可能遇到的情況。

這裏姑且稱其為“規劃派”。

而以Cruise為代表的流派,就隨性多了,直接將車扔到馬路上去“闖蕩”。他們不指望提前給車加入什麼路線圖、規則,而是讓它自個兒在街頭巷尾到處亂竄,不管遇到什麼情況都靠車自己的算法和邏輯去應付。在實戰中積累數據,最終的目標,就是讓車成為一個隨機應變的神行太保。

因此這一派也可以稱為“實時派”。

從駕駛風格來説,**Cruise的流派更接近於“真人”的水平,**但難度也更大。而Waymo的辦法雖然安全、穩妥,但它在推廣中有一個致命的問題。

因為要依賴於高精度地圖,所以Waymo這種流派,往往只有在那些事先詳細映射了地圖和路線的地區,才能有較好的表現。想象一下,你下班打一個出租車,但它的覆蓋範圍不到你家,於是只能把你送到最近的地鐵站。。。

再有就是,萬一開着車,路上遇到點突發情況,例如臨時交通管制或非典型事件(如大規模集會)什麼的,Waymo這類“規劃派”,可能就有點懵逼了。

FSD的優勢

上述的兩種流派,在當今的自動駕駛領域頗具代表性。

例如百度的Apollo項目,走的就是“規劃派”的路子,在高精度地圖創建、多傳感器融合方面比較突出。

而類似特斯拉的FSD、華為的ADS、蔚來的NOP(導航輔助駕駛)技術,則更傾向於“實時派”,強調在複雜的城市環境中進行快速迭代,以增強在各種道路上的表現。

想讓車輛變得更像“真人”,具有更強的實時應變力,這本來是一個正確的方向,但Cruise這樣的車企,除了在數據規模、軟硬件整合方面與特斯拉存在較大差距外,其在技術上與後者的一個關鍵區分點,就在於是否採取了端到端的,感知決策一體化的路線。

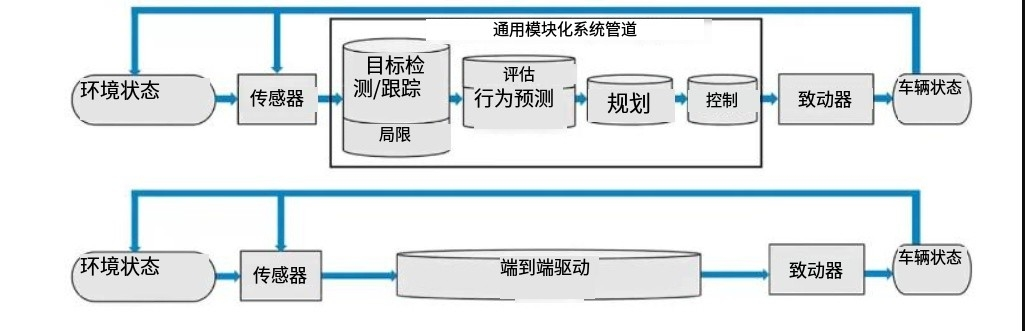

所謂端到端,簡而言之,指的就是車輛的感知和決策過程,是通過一個單一的神經網絡模型來實現的。

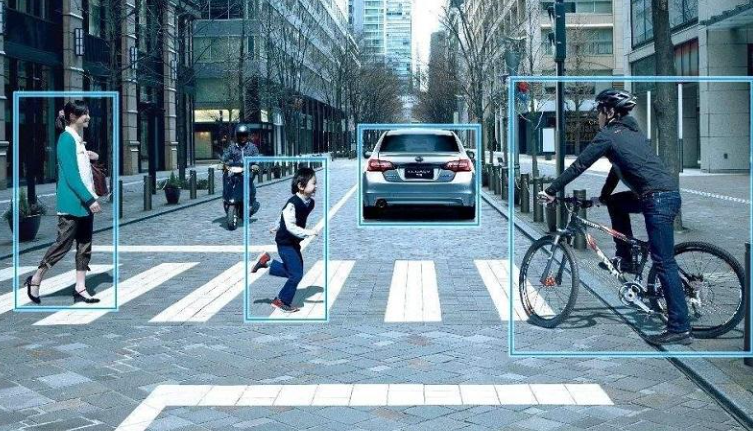

打個比方來説,傳統的自動駕駛,就跟一個老師傅帶着幾個徒弟在廚房裏做菜一樣。每個人分工明確,有專門的切菜的(感知),有專門的炒鍋的(規劃),有專門的調味的(決策)。誰要是掉了鏈子,錯誤就會一環接着一環傳下去,整鍋菜就全完了。

可端到端的自動駕駛方案就不一樣了,跟有了一箇中央廚房似的。一台“炒菜機器人”將上述步驟全都包辦了。它自個兒能看着食材(感知),想着要做什麼菜(決策),一氣呵成,從頭到尾一條龍服務。

上為傳統方案,下為端到端方案

過去因為單個AI模型的能力不夠強,車企不得不採用前者那種多個網絡拼接的方案,中間插入大量人類寫定程序進行判斷,比如在Cruise在舊金山拖行女性行人的事故中,就可能有類似“如果(if)檢測到某某震動,則(then)靠邊停車”的指令,也就是由兩個小模型分別執行路況識別和找地方停車,由人類程序員來做中間的邏輯判斷。

但問題是,人類寫死的程序必然會遺漏大量的特殊情況(corner case),就比如一個人突然躺到你車前面了這誰能想到?AI神經網絡最大的優勢就在於複雜的高維度的判斷分類,人類這一越俎代庖的行為勢必無法匹配AI的能力,從而導致事故可能性的增加。

而隨着大模型的出現,我們終於可以用一個模型來完成自動駕駛的整個過程,最大程度上減少寫死的程序,比如最新版的特斯拉FSD把原本的30多萬條代碼降低到了2000條,從而最大限度降低錯誤和事故的可能性。

但是,這端到端技術雖然聽上去不復雜,但真正能做到的車企,目前仍然是鳳毛麟角。這主要是因為,很多車企都沒有特斯拉這樣得天獨厚的條件。

首先,要想讓端到端的“大腦”(神經網絡)足夠可靠,就得先解決數據的質量和多樣性問題。

這就相當於,要想車輛像老司機那樣,眼睛看到啥,大腦立刻做出反應,那前提就得是這個司機的經驗得足夠豐富,走過的路要夠多。

在這一點上,特斯拉有個龐大的車隊在全球各地跑,實時收集數據。這車一賣出去,就成了數據收集器。就目前來看,特斯拉在全球交付了450萬輛車,行駛里程超過了50億公里(2021年),別的車企哪去收集這麼多實時數據?

而除了經驗要夠豐富外,這個老司機的“腦子”,也就是FSD背後的硬件系統,也要足夠好使,才能讓FSD快速地從各種數據中進行學習。

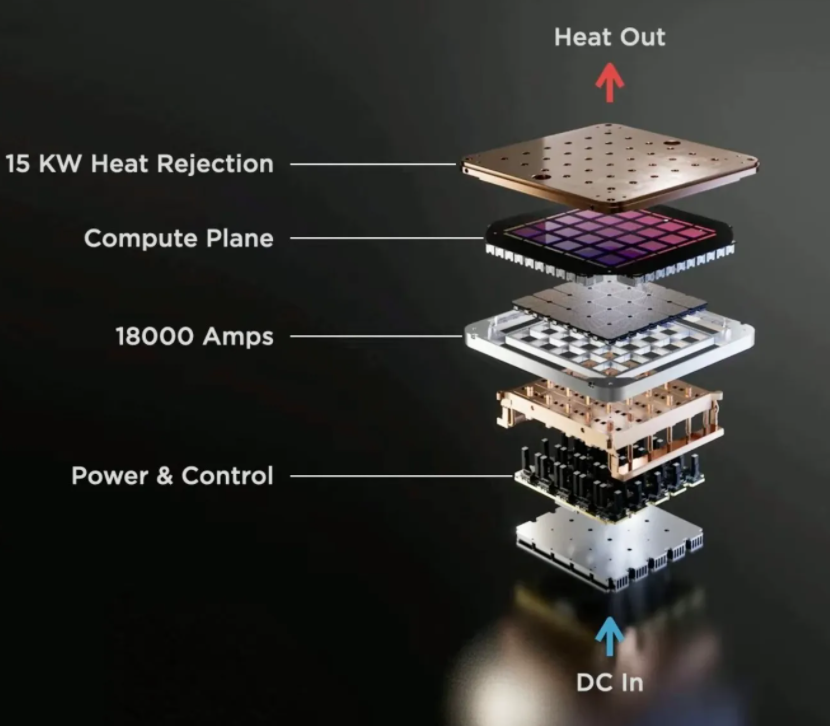

在這方面,特斯拉還自己開發了一套叫做“Dojo”的超級計算機系統,專門用來處理和訓練他們海量的駕駛數據。

Dojo的核心單元是由特斯拉自主研發的神經網絡訓練D1芯片,採用了7納米工藝製程,擁有500億個晶體管和354個訓練節點。每個Dojo由25顆D1芯片組成,可以提供高達36TB/s的帶寬和9PetaFLOPS(9千萬億次)的算力。

這使得特斯拉能在很短的時間內訓練其神經網絡,處理從全球數百萬特斯拉車輛收集來的數據。

以上兩點,是特斯拉敢於在全球大車企當中第一個發佈自動駕駛出租車的底氣所在。

端到端時代

雖然追趕特斯拉的FSD是一個不小的挑戰,但國內的諸多廠商,都已然開始了類似端到端路線的嘗試,可以説,自從FSD問世後,端到端的,感知決策一體化的“實時派”路線,已經成了自動駕駛的一種“大勢”。

例如,傳統老牌車企轉型的代表——長城汽車,在今年4月份的一次直播中,就展示了其無圖NOA(導航輔助駕駛:Navigate on Autopilot)的實戰表現。

在直播中,面對保定狹窄、混亂,突發情況較多的路況,長城的全程智駕系統零失誤,沒有緊急退出或降級,完成了各種博弈、繞行、避讓動作。

而在端到端這一大的方向下,國內的一些車企也開始嘗試用純視覺方案,而不是原先的激光雷達配合視覺方案,來實現自動駕駛了。

因為很多人認為,雖然激光雷達可以提供更加準的距離數據,但是在AI大模型的加持下,一旦便宜的純視覺方案也能實現近乎完美的自動駕駛,昂貴的激光雷達就會顯得多餘。

例如,國內的極越在今年的一月份,也展示了自身基於純視覺+OCC佔用網絡方案的輔助智駛技術。

這是當時除了特斯拉之外,**全球“唯二”**的純視覺智駛方案。

與特斯拉的純視覺方案類似,極越的純視覺技術,主要依賴於攝像頭採集的視覺圖像數據,並通過基於Transformer的BEV(Bird’s Eye View,鳥瞰圖)進行特徵提取,從而獲得當前場景中各個目標的信息。

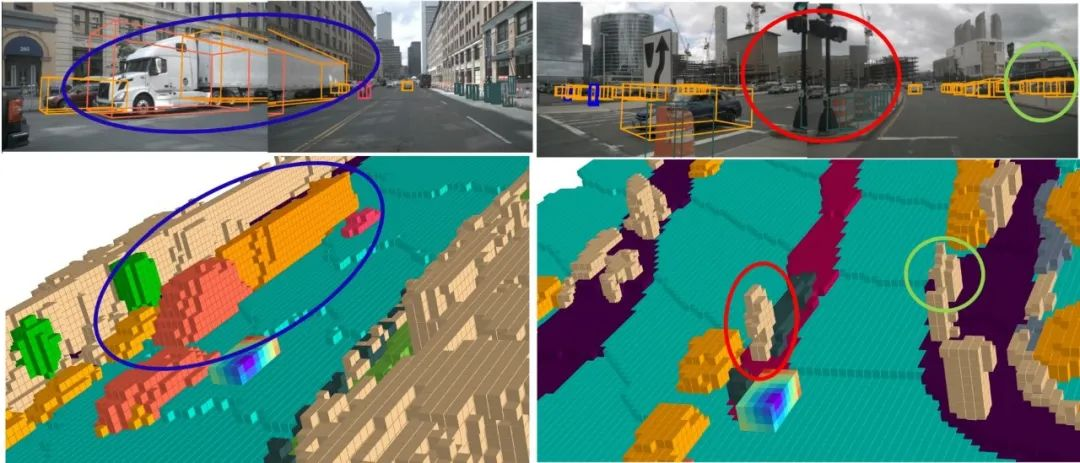

另外,極越還採用了跟特斯拉類似的**OCC(Occupancy Network,佔用網絡)**技術。

OCC佔用網絡的思路很樸實無華,把車周圍的空間用格子地劃分開,然後讓感知系統去盯着,哪個格子被啥玩意佔了就標記一下。

這種方案的好處,就是不再非得識別出那玩意具體是啥,只要知道自個的路線是不是被堵住了就行。比如前面那格子被個垃圾桶佔了,後面那幾格子正常,那它就自動繞過去,簡單高效。

而OCC網絡當初的主要目的,就是想替代掉激光雷達那些複雜的測距定位功能。

最有意思的是華為,在自己的親兒子,起售價47萬問界M9上,只搭載了一個激光雷達,而在乾兒子,起售價30萬的阿維塔11上,搭載了3個激光雷達。

共享經濟的“救命稻草”

除了上述提到的長城、極越外,今年還有不少國內車企打算在端到端這條賽道上發力。

例如,小鵬要就計劃在2024年內,在全國範圍內實現基於端到端模型的智能駕駛,在核心城區的智能駕駛體驗上,要對標谷歌旗下自動駕駛公司Waymo;

理想也奮起跟進,整合了BEV(鳥瞰圖)大模型、MPC(Model Predictive Control,模型預測控制)以及時空聯合規劃等能力。

同樣地,毫末智行也發佈了自動駕駛生成式大模型DriveGPT,可以通過將圖文和文圖的交叉特徵做匹配,再將其放到大語言模型中,針對形成於特徵空間的搜索(query)特徵。

總體來説,自動駕駛已經成為了接下里電動車的大勢,而端到端又是這大勢中的一股主流。

倘若將來端到端自動駕駛,真的帶來了顛覆性體驗,那其對現在愈發內卷的新能源車市場而言,無異於一劑及時的“解藥”。

首先如果開車、停車、找車位,這些費力的操作都幾乎不需要人進行了,那用車的體驗會變成非常舒服,會有更多的人想要去買車、用車。

更重要的是,省去了“司機”之後,**基於無人汽車的共享經濟,**就大有可為了。

因為現在很多人的私家車,實際上都太“閒”了,白天上班的時候,車子就這麼虛空放那乾等,晚上回家了頂多也就跑一個多鐘頭,剩下時間又繼續放空,這平白無故浪費了大把時光,多可惜!

但自動駕駛可就不同了,這玩意兒就是生來就是為共享而活的。你一開完就放它自個兒去跑,別人預約的時候,它自個兒就能飛奔過去接人。

到了那時,Robotaxi 便可以依靠更高的效率打敗目前的出行平台,獲得更大的利潤空間。

如此一來,共享出行這個新生事物,有可能被 AI +自動駕駛再次顛覆。

更重要的是,通過“共享無人車”這種新的體驗,過去那些猶豫着要不要買,或者買不起的客户,也得到了一次體驗自動駕駛的機會。

而這種新奇的體驗帶來的正向效應,也將有可能提高智能電動車的市場接受度,從而引領一波新的銷量。

這也是馬斯克的 Robotaxi 打的如意算盤。

畢竟,對最近股價跌成狗的特斯拉來説,繼續去卷設計卷配置卷續航卷車型迭代的速度,與中國車企競爭看不到任何的機會。

只有通過Robotaxi重新定義智能電動車,特斯拉才有機會奪回優勢地位,這也是龍哥為什麼那麼着急宣佈Robotaxi發佈時間點的原因。

但Robotaxi帶來的機會是客觀存在的,它並不獨寵特斯拉一家。

國內車企有沒有可能在自動駕駛領域後來居上,進一步擴大在新能源汽車產業上的優勢呢?

技術合力和另闢蹊徑

從技術層面上來看,國內車企要想追趕特斯拉的FSD,難點不僅僅在於數據和算力的“量”方面,更重要的,是如何形成一套從數據採集、處理,到算法研發、軟硬件整合的閉環系統。

傳感器、攝像頭,以及車載計算芯片,就像是自動駕駛汽車的五官和大腦,負責看、聽、感知周圍的一切;而軟件則是神經系統,負責制定出行駛策略,指揮車輛如何行動。

現在,你説能不能分開來,硬件找一家,軟件找另一家,像搭積木那樣組合起來?理論上是可以,但實際操作中,如果硬件和軟件不是深度集成設計,無法同步迭代更新,就無法發揮最高的效率。

所以想和特斯拉一決高下,國內車企就得從系統工程的高度,在數據、算法、硬件都打造出完備的閉環能力,而不是孤軍奮戰,只專注某一個節點。

幸運的是,中國目前還真存在一些具有這類“閉環基因”的企業。

例如華為就是其中之一。

擁有高質量、大規模的真實駕駛數據,是推動端到端模型性能提升的關鍵,而能否建立起數據採集、處理、標註、模型訓練的完整閉環,則尤為重要。

首先在數據集方面,要想趕上特斯拉數百萬輛車的數據,在真實世界裏慢慢收集是沒指望了,所以華為想了一個狠活——通過大模型,縮短自動駕駛學習週期。

這一突破,得益於盤古大模型在數字孿生空間生成複雜的場景樣本。

所謂數字孿生,就是在電腦裏構建一個虛擬的平行世界,能高度還原現實世界裏的各種環境和情況。而華為就用自己搞出來的盤古大模型,在這個數字空間裏創造出五花八門的路況場景,為自動駕駛系統提供大量標註好的訓練數據。

這樣的路子,在國內車企中可謂獨樹一幟。

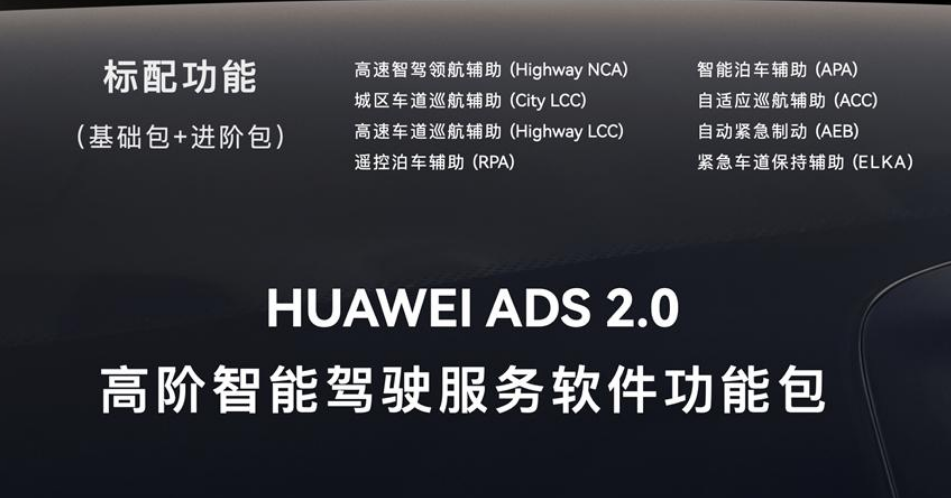

具體來説,華為的自動駕駛系統ADS2.0,學習訓練算力達2.8E FLOPS(每秒百億次浮點運算),在AI訓練集羣上每天進行1200萬+公里的仿真測試。

在此情況下,ADS2.0用海量的數據,實現了算法和場景策略的持續迭代和優化,模型更新速度每5天完成一次。每一輛搭載ADS 2.0的問界汽車,都能享受到AI持續學習的成果。

這點和特斯拉通過OTA升級,加強軟硬件融合的情況十分類似。

這樣的發展路徑,似乎表明了,大模型與自動駕駛的融合,對國內車企而言,既是一種挑戰,也是一種機遇。

大模型的出現,讓自動駕駛進入了一種更像“人”的階段,也就是通過大量數據的學習,能夠泛化出舉一反三的能力,在沒有見過的場景,或是罕見狀況時,也能通過觸類旁通的方式隨機應變,而不是根據事先預設的代碼和規則,笨拙地根據一個個路況“查缺補漏”。

在這個階段,大模型與汽車的結合才剛剛開始,而最不可思議的創新,往往正是發生在技術融合的初始階段。