AI芯片的一塊重要拼圖_風聞

半导体行业观察-半导体行业观察官方账号-专注观察全球半导体最新资讯、技术前沿、发展趋势。1小时前

因為大模型的火爆,對算力的的渴求持續攀升。過去兩年,讓我們知道了英偉達H100芯片的影響力。與之相伴隨的,高帶寬內存(HBM)、CoWos封裝等相關的技術也讓大家有所耳聞。殊不知,互聯的作用不亞於這些技術。互聯技術也是AI芯片中很重要的一塊拼圖。

AI芯片之間互聯一直是個難題,隨着近年來越來越多的加速器被集成到一起,如何高效傳輸數據成為了瓶頸。當需要連接成千上萬個加速器時,性能損耗和帶寬瓶頸就會顯現出來。這正在持續倒逼互聯的迭代加速。

可以説,當前,我們正處於重大互聯技術轉型的風口浪尖。

超越 PCIe:AI 芯片廠商自研互聯技術

由於PCIe技術的發展速度跟不上時代需求,目前主流的AI芯片廠商都已經自研了互聯技術,其中較為代表的就是英偉達的NVLink和AMD的Infinity Fabric。

英偉達的NVLink

自2014年開始,英偉達在其GPU中引入了NVLink互聯技術。NVLink 是由 Nvidia 開發的一種高帶寬、低延遲的點對點數據傳輸通道。它的主要用途是連接 Nvidia GPU,或者 GPU 與 CPU 之間的通信,允許它們以高速率共享數據。這對於那些要求高數據吞吐量和低通信延遲的應用至關重要,如深度學習、科學計算和大規模模擬。過去十年間,NVLink已成為英偉達GPU芯片的核心技術及其生態系統的重要組成部分。

讓我們再來細細回顧下NVLink這一技術的發展歷程。2014年,NVLink 1.0發佈並在P100 GPU芯片之間實現,兩個GPU之間有四個NVLink,每個鏈路由八個通道組成,每個通道的速度為20Gb/s,系2統整體雙向帶寬為160GB/s(20*8*4*2)/8=160GB/s),是PCle3x16的五倍;

2017年英偉達推出了第二代NVLink,兩個V100 GPU芯片之間通過六個NVLink 2.0連接,每個鏈路也是由八個通道組成,不過每個通道的速度提升至為25Gb/s,從而實現300GB/s的雙向系統帶寬(25*8*6*2)/8=300GB/s),幾乎是NVLink1.0的兩倍。此外,為了實現八個GPU之間的完全互連,Nvidia引入了NVSwitch技術。NVSwitch1.0有18個端口,每個端口的帶寬為50GB/s,總帶寬為900GB/s。每個NVSwitch保留兩個用於連接CPU的端口。通過使用6個NVSwitch,可以在8個GPUV100芯片之間建立一個全連接的網絡。

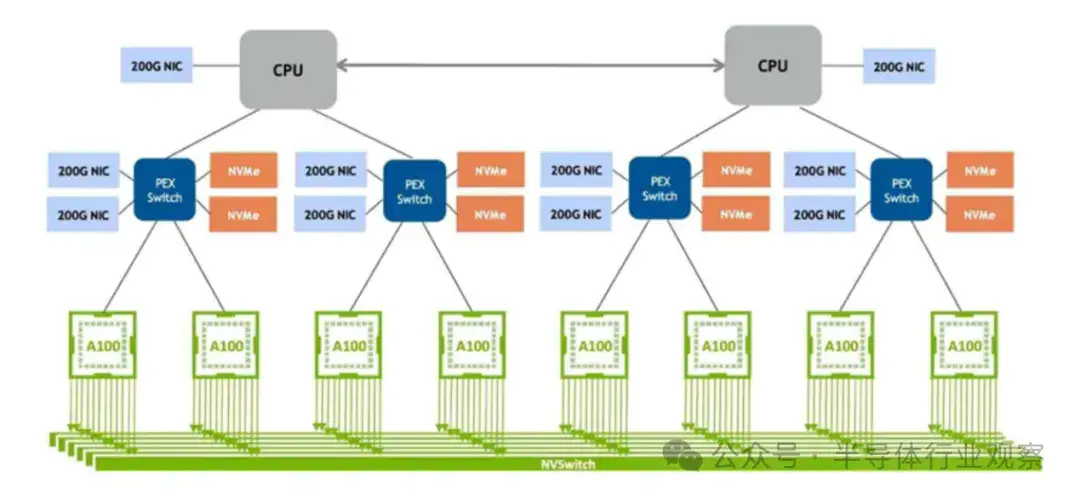

2020年,推出NVLink 3.0技術。它通過12個NVLink連接連接兩個GPU A100芯片,每個鏈路由四個通道組成。每個通道以50Gb/s的速度運行,從而產生600GB/s的雙向系統帶寬,是NVLink2.0的兩倍。隨着NVLink數量的增加,NVSwitch上的端口數量也增加到36個,每個端口的運行速度為50GB/s。

2022年,NVLink技術升級到第四代,允許兩個GPU H100芯片通過18條NVLink鏈路互連。每個鏈路由2個通道組成,每個通道支持100Gb/s(PAM4)的速度,從而使雙向總帶寬增加到900GB/s。NVSwitch也升級到了第三代,每個NVSwitch支持64個端口,每個端口的運行速度為 50GB/s。

2024年,隨着英偉達全新Blackwell架構的發佈,NVLink 5.0也隨之而來。NVLink 5.0以每秒100 GB的速度在處理器之間移動數據。每個 GPU 有 18 個 NVLink 連接,Blackwell GPU 將為其他 GPU 或 Hopper CPU 提供每秒 1.8 TB 的總帶寬,這是 NVLink 4.0 帶寬的兩倍,是行業標準 PCIe Gen5 總線帶寬的 14 倍。NVSwitch升級到了第四代,每個NVSwitch支持144個NVLink 端口,無阻塞交換容量為 14.4TB/s。

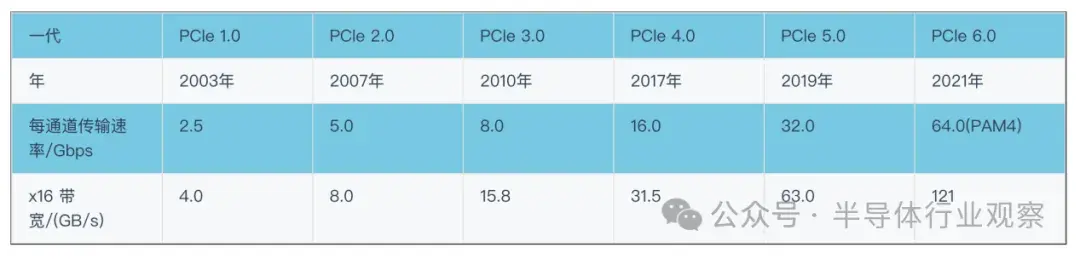

NVLink設計之初,就是為了解決傳統的PCI Express (PCIe) 總線在處理高性能計算任務時帶寬不足的問題。從下面兩幅圖的對比中,可以發現,從單通道速度的角度來看,NVLink的速度通常是同代PCle的兩倍左右。總帶寬的優勢更加明顯,NVLink提供的總帶寬約為PCle的五倍。

除了NVLink,另外一個值得一提的互聯技術是InfiniBand。英偉達收購的Mellanox在InfiniBand領域也處於佼佼者。自收購Mellanox以來,NVIDIA也開始將NVLink技術與InfiniBand(IB)技術相結合,推出新一代NVSwitch芯片和具有SHARP功能的交換機,針對外部GPU服務器網絡進行了優化。

InfiniBand是一種開放標準的網絡互連技術,具有高帶寬、低延遲、高可靠性的特點。該技術由 IBTA(InfiniBand 貿易聯盟)定義。該技術廣泛應用於超級計算機集羣領域。同時,隨着人工智能的興起,它也是GPU服務器的首選網絡互連技術。由於 RDMA(遠程直接內存訪問)等功能,InfiniBand 在人工智能等數據密集型任務中通常優於以太網。據Dell’Oro 估計,約90%的AI部署都是使用Nvidia/Mellanox的InfiniBand,而不是以太網。這些部署將 Nvidia 的網絡收入推至每年100億美元。

近日傳奇CPU設計師兼Tenstorrent首席執行官 Jim Keller是開放標準的堅定支持者,他建議 Nvidia應該在基於 Blackwell 的GB200 GPU 中使用以太網協議芯片到芯片連接,而不是專有的NVLink,背後的主要原因是,這可能會使軟件移植到其他硬件平台變得更加複雜。而凱勒認為,使用以太網協議可以為英偉達及其硬件用户節省大量資金。

AMD的Infinity Fabric

與英偉達的NVLink相似,AMD則推出了其Infinity Fabric技術,支持芯片間、芯片對芯片,以及即將推出的節點對節點的數據傳輸。Infinity Fabric是AMD在其“Zen”微架構中引入的一個關鍵特性,旨在提高整體系統性能,特別是在多核心處理器和數據中心環境中。

Infinity Fabric由兩部分組成:數據佈線(Data Fabric)和控制佈線(Control Fabric)。數據佈線用於處理器內部和處理器之間的數據傳輸,而控制佈線則負責處理器的功耗、時鐘和安全性等方面的管理。Infinity Fabric的主要特點包括:1)高效率:Infinity Fabric設計用於提供高效率的數據傳輸,支持多個設備之間的高速通信;2)模塊化:Infinity Fabric支持AMD的小芯片(chiplet)架構,允許不同功能的芯片模塊通過高速互連進行組合;3)內存共享:Infinity Fabric支持CPU和GPU之間的內存共享,有助於提高異構計算的效率;4)擴展性:Infinity Fabric的設計允許它隨着技術進步和需求增長而擴展。

視頻鏈接請點擊:

AMD最新的AI加速器Instinct MI300X 平台,就通過第四代AMD Infinity Fabric鏈路將 8 個完全連接的 MI300X GPU OAM 模塊集成到行業標準 OCP 設計中,為低延遲 AI 處理提供高達 1.5TB HBM3 容量。第四代 Infinity Fabric支持每通道高達 32Gbps,每鏈路產生 128GB/s 的雙向帶寬。

不同於英偉達NVLink僅限於內部使用,AMD已經開始向新合作伙伴開放其 Infinity Fabric 生態系統。在去年年末AMD MI3000的發佈會上,Broadcom宣佈其下一代PCIe交換機將支持XGMI/Infinity Fabric。不僅如此,AMD還希望Arista、博通、Cisco等合作伙伴能推出適用於 Infinity Fabric 等產品的交換機,能夠方便MI3000在單一系統外實現芯片間通信。這類似於英偉達的NVSwitch。

英特爾:以太網的堅實擁護者

英特爾的用於生成式AI的Gaudi AI芯片則一直沿用傳統的以太網互聯技術。Gaudi 2 每個芯片使用了24 個 100Gb以太網鏈路;Gaudi 3也使用了24 個 200 Gbps 以太網 RDMA NIC,但是他們將這些鏈路的帶寬增加了一倍,達到 200Gb/秒,使芯片的外部以太網 I/O 總帶寬達到 8.4TB/秒。

在近日的intel vision峯會上,英特爾還宣佈正在開發一款用於超以太網聯盟(UEC)兼容網絡的 AI NIC ASIC 以及一款 AI NIC 小芯片,這些創新的AI高速互聯技術(AI Fabrics)將用於其未來的 XPU 和 Gaudi 3 處理器。這些創新旨在革新可大規模縱向(scale-up)和橫向(scale-out)擴展的AI高速互聯技術。

一直以來,英特爾都希望通過採用純以太網交換機來贏得那些不想投資 InfiniBand 等專有/替代互連技術的客户。InfiniBand非常適合那些運行少量非常大的工作負載(例如 GPT3 或數字孿生)的用户。但在更加動態的超大規模和雲環境中,以太網通常是首選。Nvidia 最新的 Quantum InfiniBand 交換機的最高速度為 51.2 Tb/s,端口為 400 Gb/s。相比之下,以太網交換在近兩年前就達到了 51.2 Tb/s,並可支持 800 Gb/s 的端口速度。

雖然InfiniBand在很多情況下表現都不錯,但它也有缺點,比如只能在特定範圍內使用,而且成本也不低,將整個網絡升級到 InfiniBand 需要大量投資。相比之下,以太網因為兼容性強,成本適中,以及能夠勝任大多數工作負載,所以在網絡技術領域裏一直很受歡迎,建立了一個龐大的“以太網生態”。

Dell’Oro 預計 InfiniBand將在可預見的未來保持其在 AI 交換領域的領先地位,但該集團預測在雲和超大規模數據中心運營商的推動下,以太網將取得大幅增長,到2027 年大約將佔據20%的市場份額。

不僅是英特爾,在2023年的AI Day上,AMD也表示將重點支持以太網,特別是超級以太網聯盟。雖然 Infinity Fabric提供了GPU之間的一致互連,但AMD正在推廣以太網作為其首選的 GPU 到 GPU網絡。

此外,英特爾還提出了一種開放性互聯協議Compute Express Link(CXL)。關於CXL互聯技術,業界看法不一。英偉達的GPU一向單打獨鬥,並不支持CXL;AMD透露其MI300A會支持CXL。目前來看,像三星、SK海力士、美光等存儲廠商更加青睞於CXL。

AI互聯的下一步:邁向光互聯時代

誠然,這些互聯技術都已是目前最好的互聯技術,但是一個不爭的事實是,隨着計算數據的爆炸式增長、神經網絡的複雜性不斷增加,以及新的人工智能和圖形工作負載和工作流程以及傳統科學模擬的出現,對更高帶寬的需求還在繼續增長。這些互聯技術將不可避免的存在性能瓶頸。例如Nvidia 的 NVLink 雖然速度很快,但是功耗也相當高;而 AMD的Infinity Fabric則適合於芯片內部的連接,對於芯片之間的互聯效率並不理想。

是時候進行範式轉變了。光互聯憑藉高帶寬、低功耗等優勢,幾乎成為公認的未來 AI 互聯技術的發展方向。Nvidia 數據中心產品首席平台架構師 Rob Ober 在媒體諮詢中表示:“在過去的十年中,Nvidia 加速計算在人工智能方面實現了數百萬倍的加速。” “下一個百萬將需要光學I/O等新的先進技術來支持未來 AI 和 ML 工作負載和系統架構的帶寬、功率和規模要求。”

在光互聯之路上,谷歌的TPU芯片已經率先起了個好頭兒。作為AI芯片的重要玩家,谷歌的TPU一直可圈可點。過去幾年時間,谷歌一直在悄悄地檢修其數據中心,它被稱為“阿波羅任務”,主要是用光代替電子,並用光路交換機(OCS)取代傳統的網絡交換機。

自TPU v4開始,谷歌引入了其內部研發的創新的互聯技術:光路交換機 (OCS)。TPU v4是第一台部署可重新配置 OCS 的超級計算機,它內部的4096個芯片通過OCS互連,能夠提供百億億次的機器學習性能。OCS可以動態地重新配置其互連拓撲,以提高規模、可用性、利用率、模塊化、部署、安全性、功耗和性能。

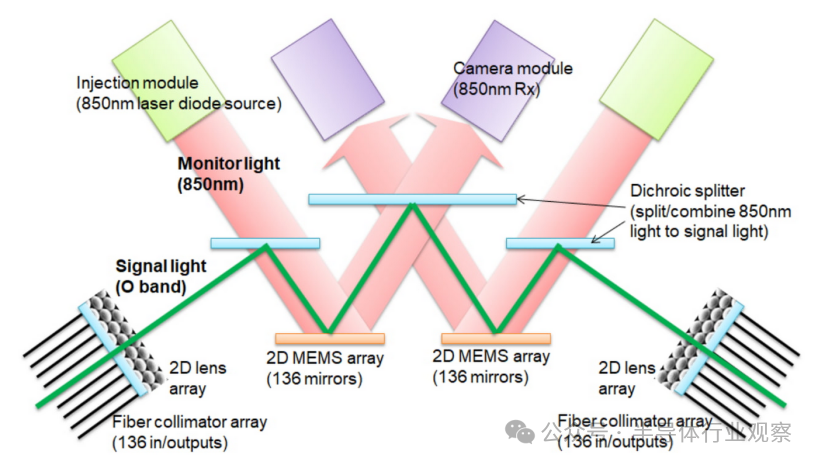

據谷歌聲稱,OCS比Infiniband更便宜、功耗更低且速度更快,OCS和底層光學組件的成本和功耗只佔TPU v4系統的一小部分,不到5%。下圖顯示了 OCS 如何使用兩個 MEM 陣列工作。無需光到電到光轉換或耗電的網絡數據包交換機,從而節省電力。谷歌表示,TPU 超級計算機的性能、可擴展性和可用性使其成為 LaMDA、MUM 和 PaLM 等大型語言模型的主力。Midjourney一直在使用 Cloud TPU v4 來訓練他們最先進的模型。

Broadcom、Marvell、思科等廠商則在光電共封交換機領域發力。其中博通和Marvell都已經推出了51.2Tbps的交換機。關於光電共封的更多知識,可以翻看《芯片巨頭的“新”戰場》一文。

博通表示,光學互連對於大規模生成式AI集羣中的前端和後端網絡都至關重要。如今,可插拔光收發器消耗大約50%的系統功耗,佔傳統交換機系統成本的50%以上。新一代GPU不斷增長的帶寬需求,加上AI集羣規模的不斷增大,需要顛覆性的節能且經濟高效的光學互連,超越分立解決方案。

2024年3月14日,博通已向客户交付業界首款 51.2 Tbps共封裝光學 (CPO) 以太網交換機Bailly。該產品集成了八個基於硅光子的6.4-Tbps光學引擎和 Broadcom 的 StrataXGS Tomahawk5交換芯片。與可插拔收發器解決方案相比,Bailly 使光學互連的運行功耗降低了 70%,並將硅片面積效率提高了 8 倍。

初創公司在硅光子互聯領域大展身手

在硅光互聯這個新技術領域,得益於技術創新和商業模式的靈活性,初創公司在硅光子互聯領域取得了突破性進展,為這個市場帶來了更多的活力。

Celestial AI是這一領域的一個重要參與者,其Photonic Fabric(光子交換機)技術可以將AI計算和內存解耦,旨在通過光傳輸的方式來連接不同的 AI 處理單元。這種技術已吸引了包括AMD Ventures在內的多個投資者。

Celestial的技術主要包括三大類:chiplets、interposers和一種基於英特爾 EMIB 或台積電 CoWoS的稱為OMIB的光學解決方案。其中chiplet是最為核心的部件,可以作為額外的內存擴展卡,也可以作為一個芯片與芯片之間的高速互聯通道,有點類似於光學版的 NVLink 或 Infinity Fabric。據該公司稱,單個 chiplet 的尺寸略小於一個 HBM 存儲器堆棧,可以提供高達 14.4 Tb/s 的光電互聯速率,當然這不是上限,只是現有芯片架構能夠處理的結果。具體而言,Celestial 的第一代技術每平方毫米可支持約 1.8 Tb/秒。第二代 Photonic 結構將從 56 Gb/秒提高到 112 Gb/秒 PAM4 SerDes,並將通道數量從 4 個增加到 8 個,從而有效地將帶寬增加到四倍。

Celestial AI宣稱,這種方案的內存事務能量開銷約為每比特 6.2 皮焦,相比於 NVLink、NVSwitch大約62.5 皮焦的方案降低了 90% 以上,同時延遲也控制在了可接受的範圍內。Celestial AI公司預計將在 2025 年下半年開始向客户提供光子交換機芯片樣品,並預計在 2027年左右實現量產。

除了 Celestial AI 之外,還有其他幾家創業公司也在研發光子互聯技術。

Ayar Labs是一家得到英特爾投資支持的光子學初創公司,它已經將其光子互連集成到原型加速器中,實現了小規模量產和出貨。Ayar Labs CEO在2024 OFC(光纖通信大會)上表示:“如果想最終改變計算行業,就需要實現電IO 到光學 IO的巨大的提升。”早在2022年,英偉達還與之合作開發光互聯技術,與 Nvidia 的合作將側重於集成 Ayar Labs 的 IP,為未來的 Nvidia 產品開發通過高帶寬、低延遲和超低功耗基於光學的互連實現的橫向擴展架構。

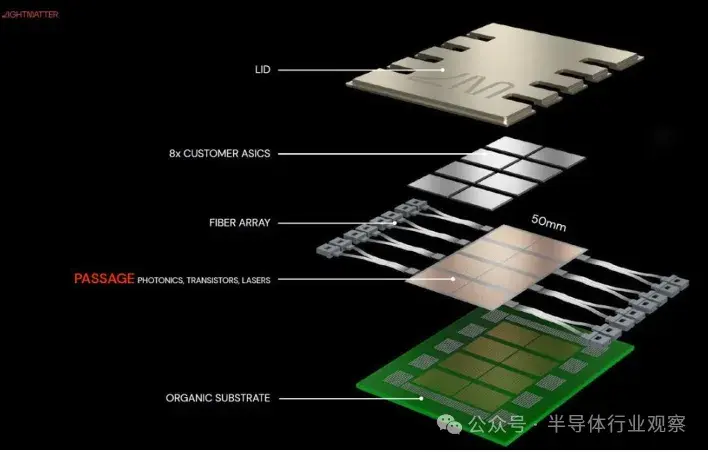

然後是 Lightmatter,該公司在12月份獲得了1.55億美元的C輪融資,估值高達12億美元。Lightmatter 的技術被稱為Passage,他們提供一個功能類似於OCS(光路交換機)的通信層,該層位於基本和ASIC之間,幾乎可以實現全方位通信,這個通信層可以進行動態的配置。通過採用硅內置光學(或光子)互連的形式,使其硬件能夠直接與 GPU 等硅芯片上的晶體管連接,這使得在芯片之間傳輸數據的帶寬是普通帶寬的 100 倍。該公司聲稱,Passage 將於2026年上市。

(圖源:Lightmatter)

Coherent在2024 OFC的上推出了一款支持高密度人工智能集羣的光路交換機(OCS)。該設備預計明年批量發貨,具有 300 個輸入端口和 300 個輸出端口。在 OCS 中,數據信號在傳輸交換機時保留在光域中;消除 OEO 轉換可以顯着節省成本和功耗。此外,與傳統交換機不同的是,當下一代AI集羣配備更高速的連接時,OCS不需要升級。對於數據中心來説,這顯着提高了資本支出回報率。

成立於2020年Nubis Communications也是一個不容小覷的初創公司,該公司在2023年2月份發佈其基於硅光芯片的1.6T光引擎XT1600,單通道速率為112Gbps, 功耗達到4.9pJ/bit,帶寬密度達到250Gbps/mm。XT1600通過新穎的2D光纖陣列和高度集成的高速硅光子學實現。Nubis的突破基於重新思考光學設計,大幅降低光學DSP所需的性能和功耗,甚至完全消除它。據其稱,與傳統光學解決方案相比,人工智能加速器或類似的大型 ASIC可以在數據中心內實現全帶寬連接,而功耗僅為傳統光學解決方案的一小部分。XT1600光學引擎的樣品現已提供給客户。而且這種光互連非常適合新興的盒式架構以及本地chiplet實施,以便在未來實現更緊密的集成。

國內在這一領域,曦智科技發力於光子計算和光子網絡兩大產品線。2023年,曦智科技發佈了首個計算光互連產品Photowave、以及首款片上光網絡(oNOC)AI處理器OptiHummingbird。Photowave通過光學器件實現CXL 2.0/PCIe Gen 5的連接,可配置x16、x8、x4、x2等不同通道數,覆蓋多種部署場景。

結語

總體來看,在眾多廠商的參與下,互聯技術將會迎來重大的發展。尤其是圍繞光電共封裝和硅光子中繼層技術的光互連,正在成為AI領域熱門賽道。

行業分析公司 LightCounting 首席執行官 Vlad Kozlov 證實:“800G 及以上的數據中心光學器件將繼續強勁增長,到 2027 年,可插拔收發器、有源光纜和共封裝光學器件的總價值將達到 84 億美元。未來五年,將有大量全新的光學產品問世。"

1、《Unveiling The Evolution of NVLink》,naddod

2、Jim Keller suggests Nvidia should have used Ethernet to stitch together Blackwell GPUs — Nvidia could have saved billions,tomshardware