GPT-4o亮相:OpenAI發佈了鋼鐵俠的賈維斯_風聞

酷玩实验室-酷玩实验室官方账号-1小时前

Hello各位好,我是Hugo。

今天凌晨,OpenAI開了一個簡短的發佈會,沒有豪華的劇場,沒有提前製作視頻和動畫,一如既往樸實無華地現場演示,推出了首款端到端的多模態大模型——GPT-4o。

米拉·穆拉蒂,OpenAI現任CTO

其中這個o代表拉丁文的omni,是“全能”的意思。

這會給AI的發展帶來哪些變化呢?今天我就給大家簡單分析一波。

鋼鐵俠的賈維斯,我的GPT-4o

一言以蔽之,這個新模型,能同時理解文字、聲音和畫面信息,並且反應速度非常的快。

有的朋友可能會有疑問,以前ChatGPT4也可以輸入圖片啊,甚至手機App版本也能輸入語音啊,這不等於沒更新嗎?

有區別。

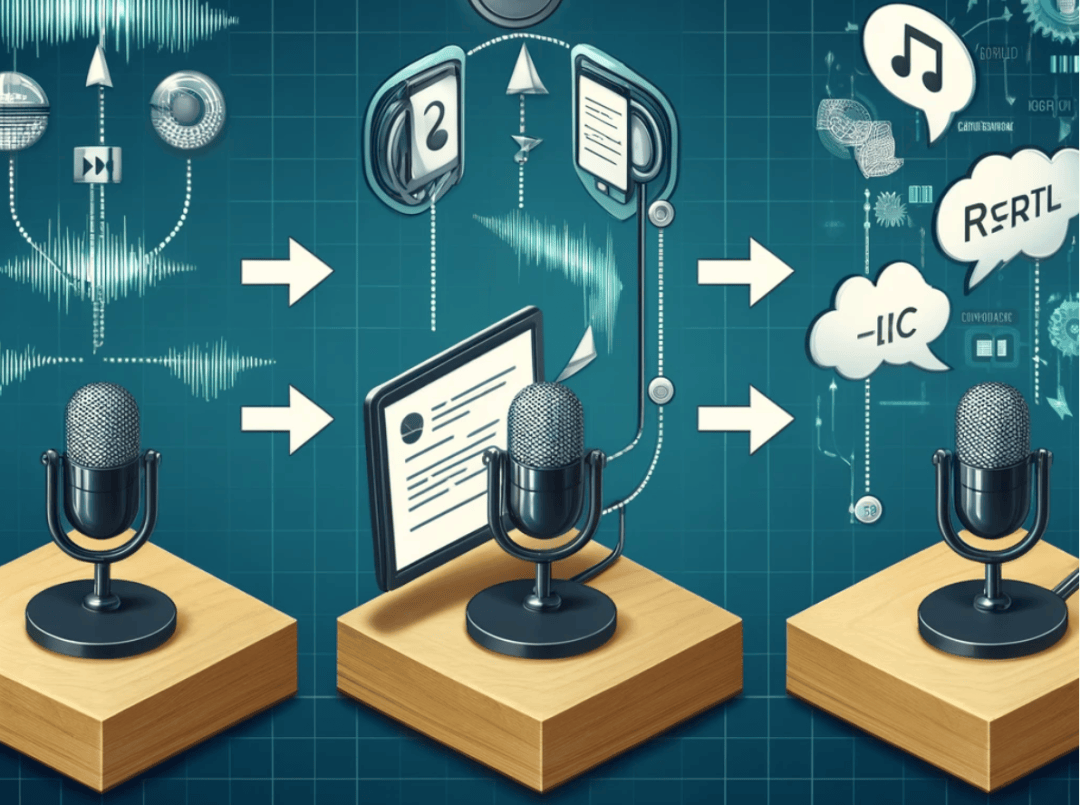

就拿語音交流來説。以前需要經過三個步驟,第一步是把人類的語音,通過Whisper語音識別模型轉成文字;接着,轉好的文字再傳給GPT模型;最後得到的回答再通過一個簡單的模型轉成語音。

也就是説,經過了:語音轉文字-文字理解輸出-文字轉語音3個模型,最直接的後果就是,在語音轉文字這一步,你説話的語氣,你獨特的氣泡音等等特徵信息都被抹去了,到最後輸出的時候,AI也很難表現出回答中的感情。

圖片由AI生成

比如你在打球,這時候接到AI來電問你在幹嘛,你氣喘吁吁地説:“呼哧呼哧,我在加班,呼哧呼哧。”

這時候以前AI會説:“好的,早點回來吃飯。”

不像人,像冷冰冰的機器。

而GPT-4o可能會破口大罵:“OOXXXOOOXXXX!!!!!!”

因為GPT-4o是用一個模型來處理以上所有的輸入,可以通過你的語氣,觀察你的表情,甚至聆聽你的喘息驚叫,來理解你當下的心情,你想要什麼;

可以同時跟多個人甚至動物交流,完全能分得清誰是誰;

可以實時看着你的屏幕,跟你一起寫文章,寫代碼,解題,一步步給出具體的指導。

並且拋棄了在不同模型中傳遞信息的步驟之後,GPT-4o的反應變得非常快,語音交流的響應時間從之前的2到3秒提升到了0.2-0.3秒,這TM已經比我快了。

講到這裏,相信大家已經理解了這個新模型的強大之處。

交互更加便捷,更像一個真人秘書了,説得更加具體一點,更像鋼鐵俠裏面那個賈維斯了。

我經常用AI總結會議紀要,操作步驟是先用手機錄下來,然後用軟件轉成文字,再丟給ChatGPT或者Kimi總結,雖然説不上有多麻煩吧,但這個感覺就是牛馬在操作工具搬磚。

有了這個GPT-4o之後,我就開着他讓他自己聽,自己看就行,就彷彿會議室裏面多了一個看不見的人。

以前想用ChatGPT這種AI大模型,你總得會上個網、會打個字吧。

有了這個GPT-4o之後,小孩不會走路先會用GPT了,甚至連貓貓狗狗都能用了。

可以説,從此AI有了眼睛和耳朵,跟人類達成了無縫的交流。

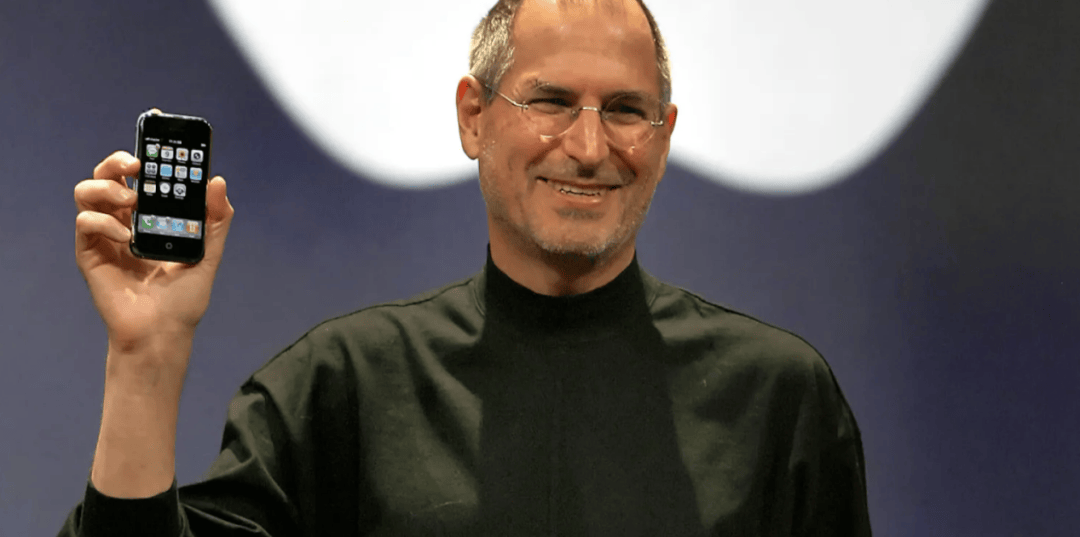

就如同當年喬布斯在初代iPhone引入多點觸控屏幕,促進了移動互聯網時代的到來一樣。

更加直觀、傻瓜的交互,必定會帶來AI應用更大面積的普及,AI走入千家萬户的前景可能已經不再遙遠。

然而在我看來,這還不是OpenAI這波更新帶來的最大的變化。

是交互,更是新智能的起點

也有一些朋友看了這場發佈會,感到很失望,因為GPT-5沒有來。

從GPT3.5到GPT4用了不到一年時間,而GPT4發佈到現在已經1年零2個月了,GPT-5卻遲遲不見出場。

這次更新的這個模型再好,也只是交互上的進步(?),模型的智能水平它沒有提升啊。

暫時可以這麼説,但如果把眼光稍微放長到一兩年以後,可能這話就會有很大的疑問。

我認為,GPT5的難產,一個最重要的原因,就是**地球上可以餵給AI的文字資料已經接近乾涸了,**AI再想取得長足的進步,發現已經沒有"書"可以讀了。

舉一個簡單的例子。

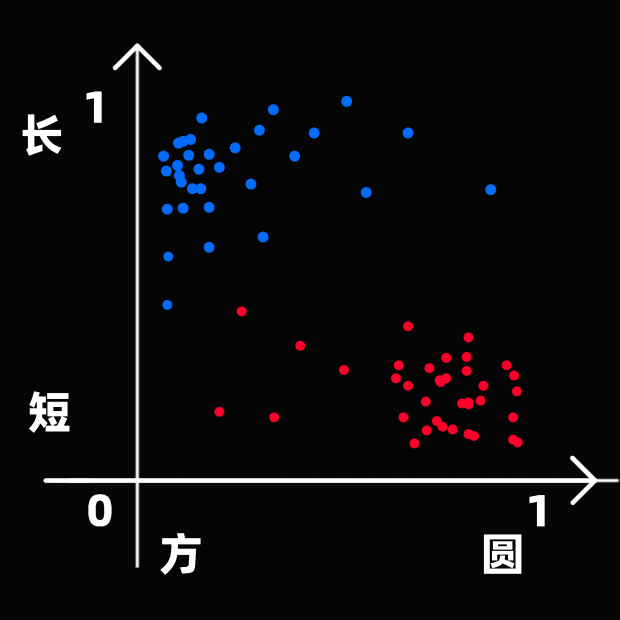

比方説,我們找兩個女明星的正臉照片,楊冪(整容前)和韓紅,可以直觀的看到,楊冪的臉比較方,韓紅的臉比較圓;楊冪的臉比較長,而韓紅的臉比較短。

我們只選取這兩個人正面的照片,然後把這些照片中的人,按臉圓的程度,和臉長的程度,數據化(0到1),就得到了一個二維平面上的點,左上方這些藍色的點,代表楊冪,而右下角這些紅色的點,代表韓紅。

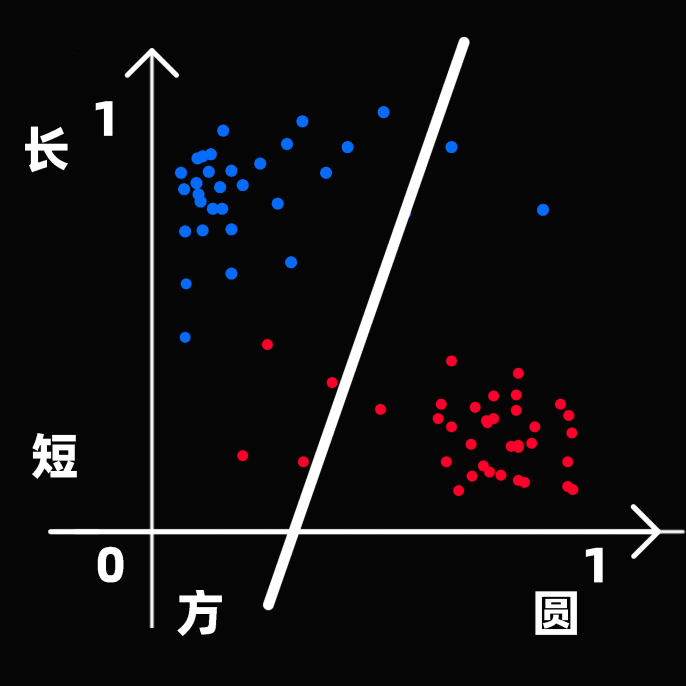

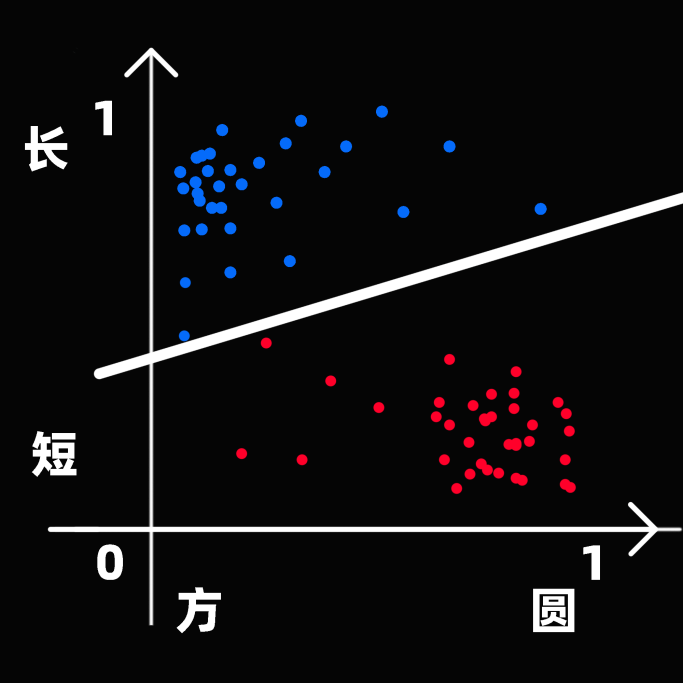

那麼很顯然,我們可以畫一條線,這條線的上面是楊冪,下面是韓紅。

如果發現沒畫好,就調整一下,反正終歸是能畫出這麼一條線,把代表楊冪的點,和代表韓紅的點,給區分出來。

這條線可以用ax+by+c=0表示。

這根經過調整的線,就是一個簡單的AI,功能在於區分楊冪和韓紅,而這裏的a和b,就是這個AI的參數。

我們通過選定a和b這兩個參數(訓練的過程),神奇地記住了關於楊冪和韓紅的一些臉部特徵,以後任何一張她倆的正面照片,我們都能分辨出來,非常的自動化,非常的牛逼。

ChatGPT也是同樣的道理。

ChatGPT做的工作是根據前文,不停地往文章的末尾填單詞(token),前文就是不同的情況(照片),而可以選擇的單詞,就是輸出的結果(楊冪或者韓紅),只不過人類的語言非常的複雜,上文可以有無數種情況,而接下來要填的單詞,以英文為例,有5萬個可供選擇。為了記住這些複雜的特徵,ChatGPT 3.5用了1750億個參數,而ChatGPT4據説是用了1.2萬億個參數。

神經網絡的基本假設就是,不管我們面臨的情況是多麼的複雜,不管場景是説話、是開車、還是做視頻、還是機器人走路,只要參數夠多,它總能把其中的特徵提取出來並且記住,然後用來對未來的情況進行分類預測,這就是所謂的,完成了神經網絡的訓練。

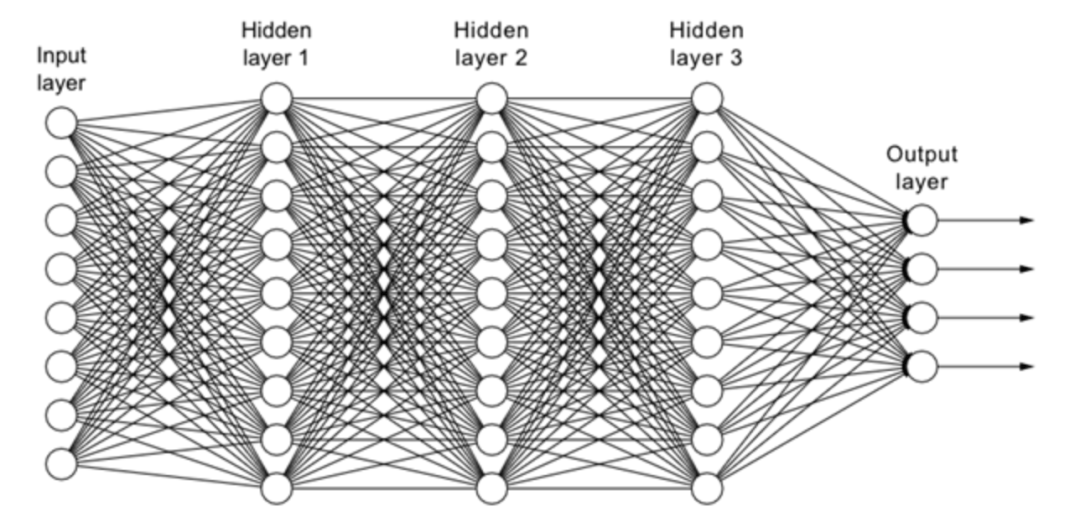

神經網絡的基本結構

但前提是,我們有足夠豐富的已知的情況(類似標註好楊冪或者韓紅的圖片),可以餵給我們的神經網絡。

很遺憾的是,在文字領域,這樣的優質資料,已經接近枯竭。

根據AI研究機構Epoch的預測,全球互聯網上的文字資料將在2026年被AI訓練用盡。而更明顯的跡象來自於各大AI企業的成績。

OpenAI在去年3月份發佈了GPT-4,當時的水平可謂遙遙領先。而在整整一年零兩個月之後的今天,GPT-4的智能水平並沒有顯著的提升,而包括Anthropic的Claude3,月之暗面的Kimi和阿里的通義千問在內的一些大模型,都已經趕上甚至超過了GPT-4,逼得OpenAI不得不多次下調收費標準和使用門檻來試圖留住用户。

怎麼着?OpenAI大善人,為了給競爭對手留條生路,決定抬一手?

更大的可能是,它遇到了瓶頸。

它最初能取得領先並非掌握了什麼秘密的高級模型架構,而是因為它走在了前面,更有錢,投入了更多的英偉達H100,更高的算力,搶先消化了人類幾十年來儲存在互聯網的知識,而它的競爭對手們或是因為沒它有錢,或是因為被制裁限制,沒有它那麼大的算力,所以消化得就慢,就落後了。

老黃親手將第一台DGX-1服務器贈予OpenAI

但慢不等於閒着,慢慢地月之暗面們也把那些知識消化得差不多了,存在了自家神經網絡的參數中,自然就追上來了。

由於中國的AI團隊跟OpenAI差的主要就是算力,於是我們就發現這波追上來的公司大多是中國公司。

那麼很顯然,隨着ChatGPT-4o的出現,OpenAI搶先把能用於訓練的資料,擴展到了音頻圖片特別是視頻領域,再度取得了先手優勢。

我彷彿聽見山姆·奧特曼摸着AI的頭説,你看,人類交流的維度是多麼的豐富,你還有很長的路可以走!

前景光明,優勢在我

那麼,音視頻資料的加入,會對AI的智能帶來怎樣的提升呢?

在本次發佈的技術日誌中,OpenAI謙虛地表示,他也不知道。。。

對此我只能説:老基佬壞得很,我信你個鬼!(開玩笑,無惡意)

以前的GPT相當於是一個憋在家裏看了很多書,但是從來不出門也不跟人交流的究極宅男。基於GPT-4o的框架訓練的下一個模型,是真正的讀萬卷書,行萬里路。

用腳趾頭想一想,這兩個人的能力能一樣嗎?

就先不説在訓練素材總量上幾何倍數的增加了,我們都知道,有很多東西,是必須圖文並茂或者邊聽邊看,才能理解的。

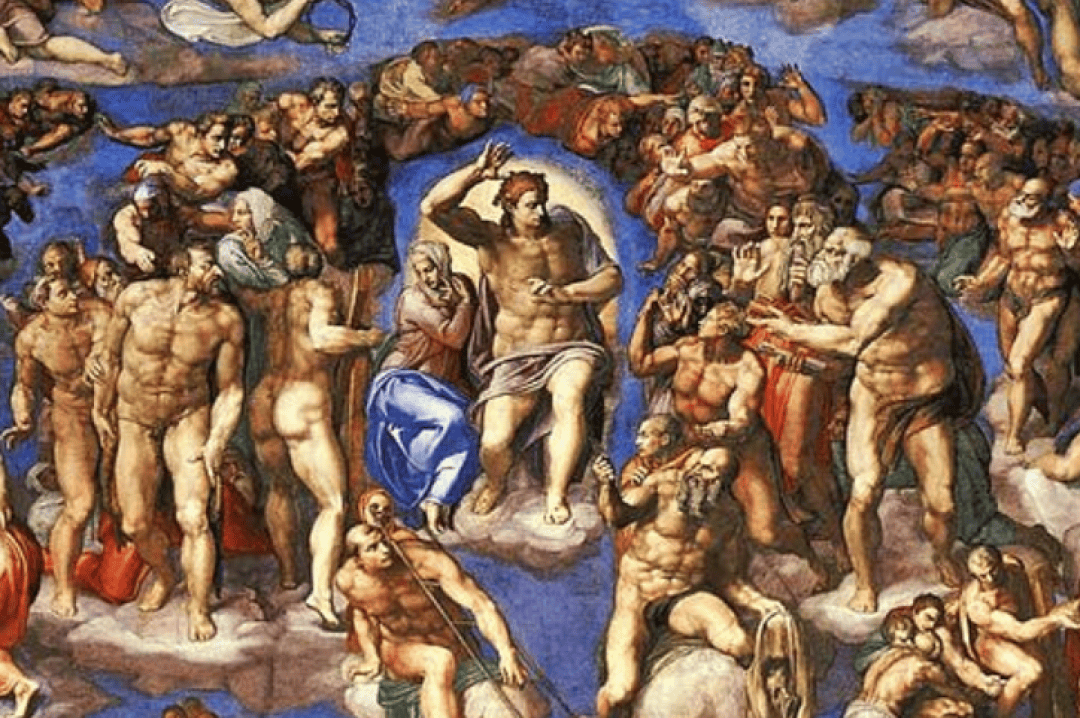

就好比我説,看米開羅基羅的畫,就像是誤入了健身教練的年會。

這啥意思?

結合作品就一目瞭然了。

《最後的審判》——米開朗基羅

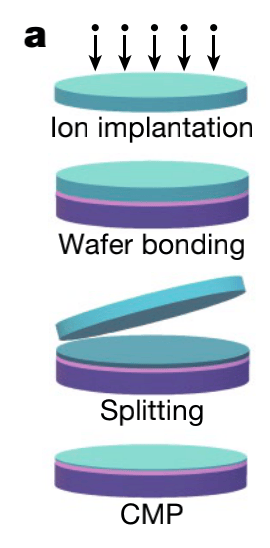

今天我在看一篇有關光子芯片加工工藝的論文,《Lithium tantalate photonic integrated circuits for volume manufacturing》(用於大規模生產的鉭酸鋰光子集成電路),作者是來自中科院上海微系統所和瑞士洛桑聯邦理工學院的一個合作團隊,發表在《Nature》,內容可以説是光子芯片加工領域劃時代的發明,我覺得很有必要品讀一番。

以前用大語言模型輔助看理工科論文,最大的問題在於它會忽略裏面的插圖。然而理工科論文的核心數據和操作步驟,一般都是用插圖體現的,忽略插圖那還看個毛?

正好今天GPT-4o上線了,相對於GPT-4版本,會有什麼區別呢?

我分別問了GPT-4o和GPT-4:

圖長這樣:

GPT-4給我的答案是:

在圖1a中展示的幾片圓盤實際上是在描述鉭酸鋰晶圓(LTOI)的製備流程,特別是晶圓鍵合工藝的各個步驟。具體來説,這個流程圖展示了以下幾個關鍵步驟:

氫離子注入:這是晶圓分裂技術中的第一步,使用氫離子對晶圓進行注入。

鍵合:將處理過的晶圓與另一塊晶圓進行精確對準並鍵合。

分裂:通過注入的氫離子層使晶圓在預定區域內分裂。

化學機械拋光(CMP):對分裂後的晶圓表面進行拋光,以確保表面的平整和光潔。

這些圓盤代表的是晶圓在各個階段的視圖,用於説明從晶圓製備到製成鉭酸鋰薄膜的整個工藝流程 。

是不是看起來還挺清楚的?

而GPT-4o給我的答案是:

圖1a展示了LTOI晶圓鍵合的工作流程,其中包括幾片不同階段的圓盤(晶圓)。以下是每片圓盤的詳細説明:

氫離子注入:

圓盤1:525微米厚的散裝鉭酸鋰(LiTaO3)晶圓,經過氫離子注入(100keV,7.0×10^16 cm^-2)。注入後晶圓表面形成了一個受損層,該層將在後續的熱退火過程中用於剝離薄膜。

晶圓鍵合:

圓盤2:注入後的鉭酸鋰晶圓(圓盤1)翻轉並與覆蓋有4.7微米厚熱氧化硅的高阻硅載體晶圓進行鍵合。通過這種鍵合,可以將LiTaO3薄膜粘附到硅載體上。

晶圓分裂:

圓盤3:經過190°C熱退火10小時後,殘餘的散裝鉭酸鋰晶圓與剝離的鉭酸鋰薄膜分離。此時,薄膜已經從原始晶圓上剝離並轉移到硅載體上。

化學機械拋光(CMP):

圓盤4:剝離後的鉭酸鋰薄膜經過化學機械拋光(CMP),去除粗糙和缺陷層,並將薄膜拋光至所需的600納米厚度。拋光後的薄膜具有平整光滑的表面,可以用於後續的光子集成電路製造。

這四個階段展示了從散裝鉭酸鋰晶圓到薄膜鉭酸鋰光子集成電路基板的關鍵步驟,每一步都在圖1a的示意圖中以圓盤的形式表示出來。

不用親自閲讀論文,我們也能感受到在信息精準度上,GPT-4o薄紗了GPT-4。

相信這波GPT-4o會給各大AI公司帶來不小的壓力,特別是今晚馬上要開I/O大會的從不作假的谷歌,簡直是汗流浹背。

不過對於我們這些用户和下游的AI應用創業公司來説,這是一個利好,**OpenAI已經打開了局面,AI交互上的鴻溝已經被填平,**國內和開源的大模型公司也會很快跟進,真是一派勃勃生機,萬物競發的境界。