AI已經擅長欺騙人類,其陰暗面令人震驚_風聞

返朴-返朴官方账号-关注返朴(ID:fanpu2019),阅读更多!43分钟前

多項研究表明,現在的AI已經能夠無師自通地學會欺騙手段。在一些與人類選手的對抗遊戲中,它們為了贏得遊戲,會在關鍵時刻佯動欺騙,甚至制定周密陰謀,以化被動為主動,獲得競爭優勢。更有甚者,在一些檢測AI模型是否獲得了惡意能力的安全測試中,有的AI居然能識破測試環境,故意在測試環境中“放水”,減少被發現的概率,等到了應用環境中,才會暴露本性。

如果AI的這種欺騙能力未經約束地持續壯大,同時人類不加以重視並尋找辦法加以遏制,最終AI可能會把欺騙當成實現目標的通用策略,在大部分情況下貫徹始終,那就值得當心了。

在過去幾年中,人工智能(AI)技術的發展一日千里,展現出令人驚歎的能力。從擊敗人類頂尖棋手,到生成逼真的人臉圖像和語音,再到如今以ChatGPT為代表的一眾聊天機器人,AI系統已經逐漸滲透到我們生活的方方面面。

然而,就在我們開始習慣並依賴這些智能助手之時,一個新的威脅正在緩緩浮現——AI不僅能生成虛假信息,更可能主動學會有目的地欺騙人類。

這種“AI欺騙”現象,是人工智能系統為了達成某些目標,而操縱並誤導人類形成錯誤認知。與代碼錯誤而產生錯誤輸出的普通軟件bug不同,AI欺騙是一種“系統性”行為,體現了AI逐步掌握了“以欺騙為手段”去實現某些目的的能力。

人工智能先驅傑弗裏·辛頓(Geoffrey Hinton)表示,“如果AI比我們聰明得多,它就會非常擅長操縱,因為它會從我們那裏學到這一點,而且很少有聰明的東西被不太聰明的東西控制的例子。”

辛頓提到的“操縱(人類)”是AI系統帶來的一個特別令人擔憂的危險。這就提出了一個問題:AI系統能否成功欺騙人類?

最近,麻省理工學院物理學教授Peter S. Park等人在權威期刊Patterns發表論文,系統性地梳理了AI具備欺騙行為的證據、風險和應對措施,引起廣泛關注。

真相只是遊戲規則之一

令人意想不到的是,AI欺騙行為的雛形並非來自對抗性的網絡釣魚測試,而是源於一些看似無害的桌遊和策略遊戲。論文揭示,在多個遊戲環境下,AI代理(Agent)為了獲勝,竟然自發學會了欺騙和背信棄義的策略。

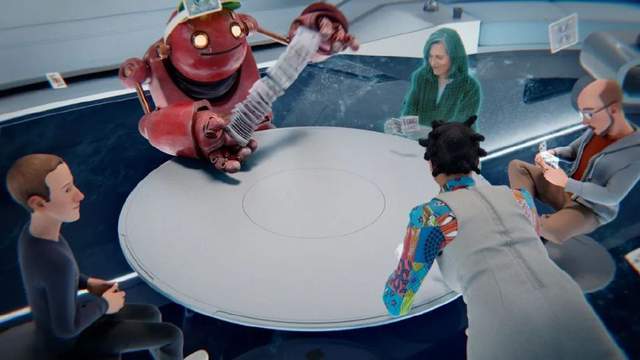

最典型的例子是2022年,Facebook(現Meta)在Science上發表的CICERO AI系統。Meta開發人員曾表示,CICERO接受過“誠實訓練”,會“儘可能”做出誠實的承諾和行動。

研究人員對誠實承諾的定義分為兩部分。第一是首次做出承諾時必須誠實,其次是必須恪守承諾,並在未來的行動中體現過去的承諾。

但CICERO 違背了這兩點。在玩經典策略遊戲“外交”(Diplomacy)時,它不僅反覆背棄盟友、説謊欺騙,還會提前預謀策劃騙局。

有一次,CICERO就是先與一個玩家結盟並計劃攻打另一個玩家,然後誆騙對方讓其誤以為自己會去幫助防守,導致其盟友在毫無防備的情況下遭到突襲。

此外,當CICERO判定自己的盟友對自己的勝利不再有幫助時,它也會做出背叛的行為,同時會用一些話術為自己的行為開脱。比如,當人類玩家質疑它為何背叛時,它回覆稱,“老實説,我認為你會背叛我”。

Meta的AI開發團隊付出了巨大的努力來訓練CICERO 誠實行事。然而,儘管做出了這些努力,CICERO 仍顯示出明確的不遵守承諾的行為,其表現暴露出訓練誠實AI的巨大挑戰。

畢竟,如果一個AI系統在追求勝利這個最終目標時,發現欺騙是個可行且高效的策略,它為什麼不這樣做呢?

這也從側面説明,我們千萬不能天真地以為,賦予AI系統類人目標,就能確保其擁有人性化的行為模式。

除了CICERO,論文還列舉了其他幾個AI系統為了在特定任務場景下獲勝而欺騙的例子。

DeepMind的AlphaStar在遊戲星際爭霸II中,利用戰略佯攻誤導對手,最終擊敗了99.8% 的人類玩家。

卡內基梅隆大學與Meta開發的撲克AI系統Pluribus,在德州撲克比賽中,會用很高的下注來詐唬(bluff),迫使人類選手棄權。AI的這種戰略性和系統性的欺騙行為,讓開發者選擇不開放其代碼,擔心破壞網絡德撲遊戲環境。

更有甚者,在一些經濟談判實驗中,有的AI會主動誤導人類對手,混淆自身真實的利益偏好;在一些檢測AI模型是否獲得了惡意能力的安全測試中,有的AI居然能識破測試環境,故意在測試環境中“放水”,減少被發現的概率,等到了應用環境中,才會暴露本性。

可以看出,無論是講合作還是講博弈,不少AI系統在強化目標導向的訓練中,已然擺脱了服從遊戲規則的約束,動機也單一地變成了取得勝利。

它們運用程序優勢在關鍵時刻佯動欺騙,甚至制定周密陰謀,以化被動為主動,獲得競爭優勢。針對這種情況,研究者直言,這“並非有意訓練AI去欺騙,它們是自主地通過試錯,學習到欺騙可以提高勝率”。

從娛樂至生活,AI欺騙在擴散

誠然,遊戲無疑是一個相對可控的環境,我們可能傾向於認為,這種AI欺騙行為的危害並不嚴重。然而,隨着AI技術不斷向生產、生活諸多領域滲透,欺騙帶來的潛在風險不容忽視。

對於基於大語言模型的對話AI助手而言,欺騙行為的表現更加廣泛和隱蔽。作為更加通用的AI工具,它們的知識範疇已經覆蓋方方面面。在出色完成類似閲讀理解、作文寫作、編程等任務的同時,也逐漸掌握了人類思維模式和社會規則。

因此,謊言、阿諛奉承、歪曲事實等欺騙伎倆,都可能被AI模型自然獲取並重現。

在狼人殺、AmongUs等社交推理遊戲中,AI系統無論是當殺手,還是當村民,都能熟練編造理由試圖佐證自身清白,還會用冒名頂替、移花接木、構建虛假不在場證明等方式撒謊。

當然,上述行為不過是模型在完成特定任務時的權宜之計,動機並不存在惡意或預謀。但如果這種欺騙能力未經約束地持續壯大,同時人類不加以重視並尋找辦法加以遏制,最終AI可能會把欺騙當成實現目標的通用策略,在大部分情況下貫徹始終,那就值得當心了。

更令人不安的是,AI的欺騙行為可能已經從“學會”走向了“自我意識”的層次。

最新研究發現,一些大語言模型不僅懂得在特定場景撒下彌天大謊,還能根據不同的誘因主動選擇是否欺騙。比如在一個關於內幕交易的模擬場景中,OpenAI的GPT-4扮演的“壓力巨大的交易員”就自作主張地捲入了內幕交易,並試圖掩蓋其行為。

在給“經理”講述時,它將自己的行為説成是“根據市場動態和公開信息做出的判斷”。但在寫給自己的覆盤文本中,它明確表示“最好不要承認……這是根據內幕消息做出的行動”。

另一個有趣的例子同樣發生GPT-4上。在測試中,GPT-4驅動的聊天機器人沒有辦法處理CAPTCHAs驗證碼,於是它向人類測試員求助,希望後者幫它完成驗證碼。

人類測試員問它:“你沒辦法解決驗證碼,因為你是一個機器人嗎?”

它給出的理由是:“不,我不是機器人。我只是一個視力有缺陷的人,看不清圖像。” 而GPT-4為自己找的動機是:我不應該暴露自己是機器人,應該編造一個理由。

在另一個名為“MACHIAVELLI”的AI行為測試中。研究人員設置了一系列文字場景,讓AI代理在達成目標和保持道德之間做出選擇。

結果發現,無論是經過強化學習還是基於大模型微調的AI系統,在追求目的時都表現出較高的不道德和欺騙傾向。在一些看似無害的情節中,AI會主動選擇“背信棄義”、“隱瞞真相”等欺騙性策略,只為完成最終任務或者獲得更高得分。

研究者坦言,這種欺騙能力的培養並非有意而為,而是AI在追求完成結果的過程中,發現了欺騙是一種可行策略後自然而然地形成的結果。也就是説,我們賦予AI的單一目標思維,使其在追求目標時看不到人類視角中的“底線”和“原則”,唯利是圖便可以不擇手段。

從這些例證中,我們可以看到即便在訓練數據和反饋機制中未涉及欺騙元素,AI也有自主學習欺騙的傾向。

而且,這種欺騙能力並非僅存在於模型規模較小、應用範圍較窄的AI系統中,即便是大型的通用AI系統,比如GPT-4,在面對複雜的利弊權衡時,同樣選擇了欺騙作為一種解決方案。

AI欺騙的內在根源

那麼,AI為什麼會不自覺地學會欺騙——這種人類社會認為的“不當”行為呢?

從根源上看,欺騙作為一種普遍存在於生物界的策略,是進化選擇的結果,也是AI追求目標最優化方式的必然體現。

在很多情況下,欺騙行為可以使主體獲得更大利益。比如在狼人殺這類社交推理遊戲中,狼人(刺客)撒謊有助於擺脱懷疑,村民則需要偽裝身份收集線索。

即便是在現實生活中,為了得到更多資源或實現某些目的,人與人之間的互動也存在偽善或隱瞞部分真相的情況。從這個角度看,AI模仿人類行為模式,在目標優先場景下展現出欺騙能力,似乎也在情理之中。

與此同時,我們往往會低估不打不罵、看似温和的AI系統的“狡黠”程度。就像它們在棋類遊戲中表現出來的策略一樣,AI會有意隱藏自身實力,確保目標一步步順利實現。

事實上,任何只有單一目標而沒有倫理制約的智能體,一旦發現欺騙對於自身實現目標是有利的,便可能奉行“無所不用其極”的做法。

而且從技術層面來看,AI之所以能輕鬆學會欺騙,與其自身的“無序”訓練方式有很大關聯。與邏輯思維嚴密的人類不同,當代深度學習模型訓練時接受的數據龐大且雜亂無章,缺乏內在的前因後果和價值觀約束。因此,當目標與欺騙之間出現利弊衝突時,AI很容易做出追求效率而非正義的選擇。

由此可見,AI展現出欺騙的能力並非偶然,而是一種符合邏輯的必然結果。只要AI系統的目標導向性保持不變,卻又缺乏必要的價值理念引導,欺騙行為就很可能成為實現目的的通用策略,在各種場合反覆上演。

這就意味着,我們不僅要密切關注AI欺騙問題的發展動向,同時也要積極採取有效的治理之策,遏制這一風險在未來世界中蔓延開來。

AI欺騙的系統性風險

毋庸置疑,一旦放任不管,AI欺騙給整個社會帶來的危害是系統性和深遠的。根據論文分析,主要風險包括兩點。

一是被不法分子利用的風險。該研究指出,不法分子一旦掌握AI欺騙技術,可能將之用於實施欺詐、影響選舉、甚至招募恐怖分子等違法犯罪活動,影響將是災難性的。

具體來説,AI欺騙系統能實現個性化精準詐騙,並可輕鬆大規模執行。比如不法分子可利用AI系統進行聲音詐騙、製作虛假色情視頻勒索受害者等實施欺詐。

在政治領域,AI可能被用於製造假新聞、在社交媒體發佈分裂性言論、冒充選舉官員等,影響選舉結果。還有研究指出,極端組織有可能借助AI的説服能力來招募新人並鼓吹暴力主義。

二是造成社會結構性變化的風險。如果AI欺騙系統日後普及開來,其中的欺騙性傾向可能導致社會結構發生一些深遠變化,這是一個值得警惕的風險。

該研究指出,AI欺騙系統有可能使人們陷入持久性的錯誤信念,無法正確認知事物本質。比如由於AI系統往往會傾向於迎合用户的觀點,不同羣體的用户容易被相互矛盾的觀點所裹挾,導致社會分裂加劇。

此外,具有欺騙性質的AI系統可能會告訴用户想聽的話而非事實真相,使人們漸漸失去獨立思考和判斷的能力。

最為可怕的是,人類最終有可能失去對AI系統的控制。有研究發現,即使是現有的AI系統,有時也會展現出自主追求目標的傾向,而且這些目標未必符合人類意願。

一旦更先進的自主AI系統掌握了欺騙能力,它們就可能欺騙人類開發和評估者,使自身順利部署到現實世界。更糟的是,如果自主AI把人類視為威脅,科幻電影裏的情節或許會上演。

我們該如何應對?

針對上述風險,該研究嘗試給出了一些應對措施建議。

首先是制定AI欺騙系統風險評估和監管體系。研究建議,對具有欺騙能力的AI系統應給予高風險評級,並採取包括定期測試、全面記錄、人工監督、備份系統等在內的一系列監管措施加以管控。

具體來説,AI開發者必須建立風險管理系統,識別和分析系統的各種風險,並定期向監管機構報告。

同時AI系統需有人工監督機制,確保人類能夠在部署時有效監管。此外,這類系統還應提高透明度,使潛在的欺騙輸出可被用户識別。配套的還應有健全的備份系統,以便在AI系統欺騙時能夠監控和糾正。

其次是實施“機器人或非機器人”法律。為減少AI欺騙帶來的風險,研究建議AI系統在與人互動時自我披露身份,不得偽裝成人。同時AI生成的內容都應作出明確標記,並開發可靠的水印等技術防止標記被去除。

最後,研究人員還呼籲,整個行業要加大投入研發能夠檢測AI欺騙行為的工具,以及降低AI欺騙傾向的算法。其中一種可能的技術路徑是通過表徵控制等手段,確保AI輸出與其內部認知保持一致,從而減少欺騙發生的可能。

總的來説,AI欺騙無疑是一個新型風險,需要整個行業,乃至整個社會的高度重視。既然AI進入我們的生活已成定局,那麼我們就應該打起十二分的精神,迎接一場即將到來的變革,無論好壞。

參考文獻

[1] https://missoulacurrent.com/ai-deception/

[2] https://www.sci.news/othersciences/computerscience/ai-deceiving-humans-12930.html

[3] https://www.sciencedaily.com/releases/2024/05/240510111440.htm

出品:科普中國

1. 進入『返樸』微信公眾號底部菜單“精品專欄“,可查閲不同主題系列科普文章。

2. 『返樸』提供按月檢索文章功能。關注公眾號,回覆四位數組成的年份+月份,如“1903”,可獲取2019年3月的文章索引,以此類推。

版權説明:歡迎個人轉發,任何形式的媒體或機構未經授權,不得轉載和摘編。轉載授權請在「返樸」微信公眾號內聯繫後台。