硅谷團隊抄襲清華系大模型?面壁智能李大海獨家回應:套殼現象難規避_風聞

时代周报-时代周报官方账号-记录大时代,读懂全商业。36分钟前

大模型廠商你方唱罷我登場,“套殼”之爭風雲再起——神仙打架的戰場又出現了軟飯硬吃的戲碼。

△圖源:圖蟲

近日,一個來自斯坦福的研究團隊發佈了一款名為Llama3-V的多模態大模型,聲稱只要500美元(約合3650元)訓練,就能在多個基準測試中實現與GPT4-V、Gemini Ultra、Claude Opus一較高下的性能。

Llama3-V團隊中的兩位作者Siddharth Sharma與Aksh Garg是斯坦福大學計算機系的本科生,曾發表過數篇機器學習相關的論文。因兩人具備名校背景,且曾在特斯拉、SpaceX等大廠任職,Llama3-V一經發布迅速躥紅網絡,還衝上了HuggingFace趨勢榜首頁(機器學習領域影響力平台)。

然而Llama3-V迅速跌落神壇。有網友指出,該模型跟“清華系”大模型創業企業面壁智能5月發佈的MiniCPM-Llama3-V 2.5模型有不少相似處,模型結構、代碼、配置文件堪稱雷同,只是變量名稱做了更改。

具體來看,Llama3-V的代碼是對MiniCPM-Llama3-V 2.5的重新格式化,其模型行為檢查點的噪聲版本相似;Llama3-V使用了MiniCPM-Llama3-V 2.5的分詞器(tokenizer),並且MiniCPM-Llama3-V 2.5定義的特殊符號也出現在了Llama3-V中;Llama3-V提供的代碼無法與Hugging Face的檢查點兼容,而將從HuggingFace下載的Llama3-V模型權重中的變量名改成MiniCPM-Llama3-V 2.5的,模型可以用MiniCPM-V代碼成功運行。

此外,在未公開的實驗性特徵上,Llama3-V與MiniCPM-Llama3-V 2.5顯示出了相似的推理結果。

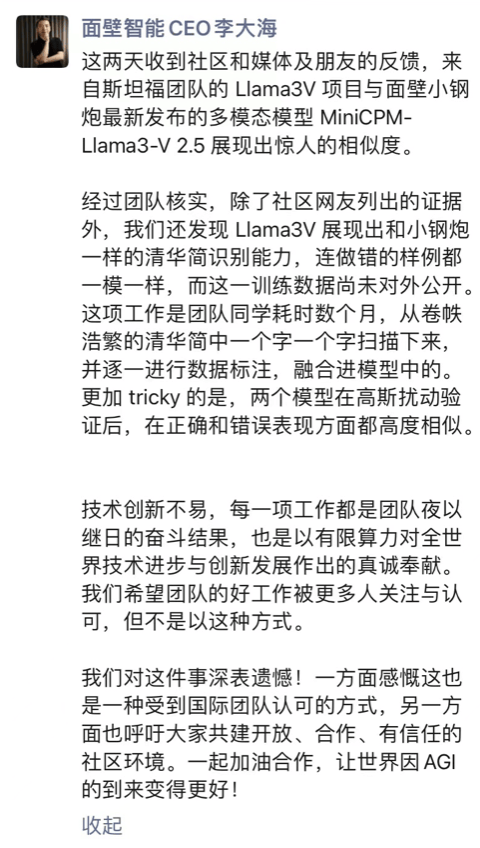

時代週報記者注意到,6月3日上午,面壁智能CEO李大海在朋友圈發文稱,團隊核實發現,Llama3V展現出和小鋼炮一樣的清華簡識別能力,連做錯的樣例都一模一樣,而這一訓練數據尚未對外公開。

他表示,清華簡的識別能力是團隊耗時數月,從卷帙浩繁的清華簡中一個字一個字掃描下來,並逐一進行數據標註從而融合進模型中的。在對兩個模型進行高斯擾動驗證後發現,它們在正確和錯誤表現方面都高度相似。

時代週報記者就如何規避相關現象詢問李大海,他稱,(想規避)應該很難。“這主要是個學術道德問題。”

對於質疑,Llama3-V項目的作者與外界進行一番辯駁後,刪除了質疑者在Llama3-V上提交的質疑他們偷竊的問題,並將Llama3-V項目從開源網站中刪除,且發文致歉。Siddharth Sharma與Aksh Garg解釋道,他們並未參與代碼工作,所有代碼都是畢業於南加州大學的Mustafa Aljadery負責的,而他一直沒交出訓練代碼。

業內關於“套殼”的爭議由來已久。有人認為,開源就該被充分利用;有人則表示,閉源才是自主研發,參考開源就是套殼。

實際上,如今所有大模型都源於2017年穀歌大腦團隊發佈的Transformer神經網絡架構,這些包含模型架構和算法的設計決定了模型如何處理輸入數據並生成輸出。在此基礎上,廠商在大規模的數據上對大模型進行預訓練,來提高模型的泛化能力,加速後續的學習任務推進。因神經網絡架構和預訓練這兩項工作打造難度高、投入金額大、耗費數據量多,往往被稱作大模型的內核。

而大模型的“殼”一般指調優。調優是指對已經預訓練過的模型進行進一步的訓練。這個過程通常是有監督的,需要使用標註好的數據來指導模型的學習。調優的目標是調整模型參數,使其更好地適應特定任務的需求。

“‘套殼’常指在調優階段通過更改變量名稱,在開源成果基礎上調適出更加符合某些場景的大模型。”AI分析師張毅向時代週報記者稱。

前語雀設計師、現AI助手Monica聯合創始人Suki曾分享了“套殼”的四個階段:一是直接引用OpenAI接口,ChatGPT 回答什麼,套殼產品回答什麼。卷UI、形態、成本。

二是構建Prompt。如大模型可以類比為研發,Prompt可以類比為需求文檔,需求文檔越清晰,研發實現得越精準。套殼產品可以積累自己的優質Prompt,卷Prompt質量,卷 Prompt分發。

三是把特定數據集進行向量化,在部分場景構建自己的向量數據庫,以達到可以回答 ChatGPT 回答不出來的問題。比如垂直領域、私人數據等。Embedding可以將段落文本編碼成固定維度的向量,從而便於進行語義相似度的比較,相較於Prompt可以進行更精準的檢索從而獲得更專業的回答。

四是微調 Fine-Tuning。使用優質的問答數據進行二次訓練,讓模型更匹配對特定任務的理解。相較於 Embedding 和 Prompt 兩者需要消耗大量的 Token,微調是訓練大模型本身,消耗的 token 更少,響應速度也更快。

“實際上,套殼是個相對正常的模式,針對某一垂直領域頻繁進行調優司空見慣,該主題的研究論文也非常多。而抄襲框架和預訓練數據的情況,一般得叫‘借殼’了。”張毅告訴時代週報記者,正因為大模型研發門檻高,入局者才更應審慎對待自研。

記者丨申謹睿

編輯丨史成超

值班丨滿 滿

-END-