首個國產全功能GPU的萬卡集羣來了!“中國英偉達”出品_風聞

量子位-量子位官方账号-24分钟前

金磊 發自 凹非寺

量子位 | 公眾號 QbitAI

純國產GPU的萬卡集羣,它來了!

而且還是國內首個全功能GPU,兼容CUDA的那種。

這個集結了超過10000張高性能GPU的超複雜工程,它的算力有多大?

不賣關子,直接揭曉答案——

總算力超萬P,專為萬億參數級別的複雜大模型訓練而設計。

規模還只是它的特點之一,其它亮眼的地方還包括:

有效計算效率(MFU)目標最高達60%,可達到國際水平

周均訓練有效率目標最高可達99%以上,平均無故障運行15天以上,也是對標業界最高標準

通用場景設計,加速一切大模型

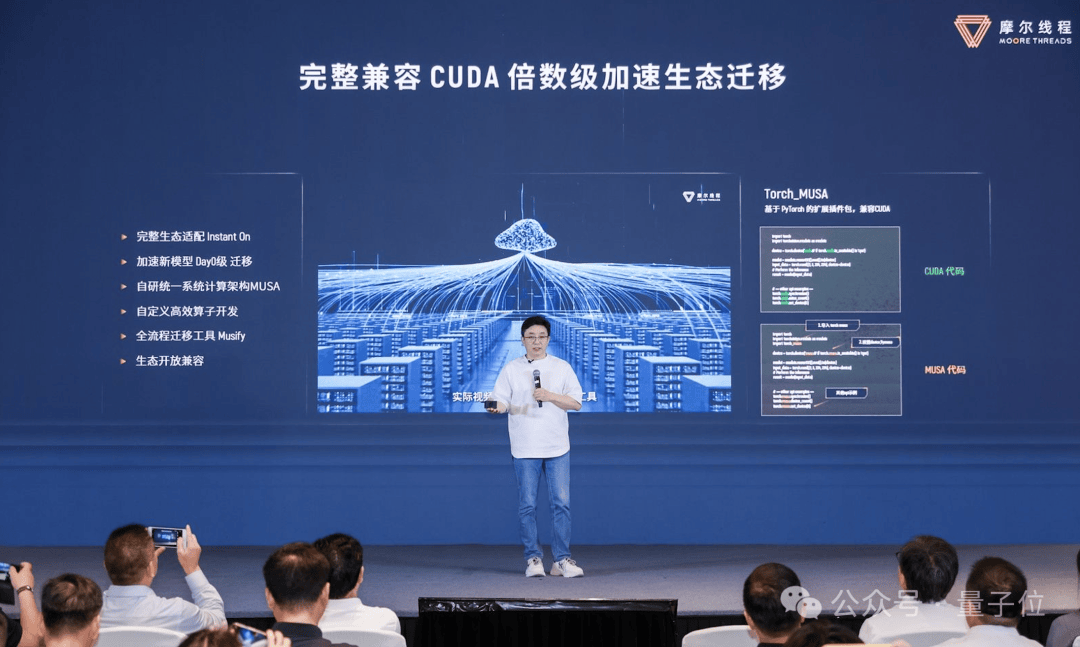

生態Day0級快速遷移,與CUDA兼容

這便是江湖人稱“中國版英偉達”的摩爾線程,對自家智算中心全棧解決方案誇娥(KUAE)升級後的最新 “打開方式”。

而縱觀國內算力的發展進程,僅是今年上半年便陸陸續續有不少“頭部玩家”先後宣佈佈局萬卡集羣,**“打羣架”**之勢,好不熱鬧。

但,萬卡國產GPU,確實很少見。

加之以生成式AI為主旋律的大模型熱潮當道,Scaling Law的“魔法”仍在持續奏效,訓練GPT-4所需要的GPU數量便已經達到了25000個。

以及在大模型架構方面也不只是圍繞Transformer,而是呈現出多元化的趨勢;與此同時,AI、3D和HPC跨技術與跨領域融合不斷加速……

因此,當下的技術給算力提出了更高、更復雜、更多樣化的要求——

萬卡集羣已然成為大模型玩家的最低標配,更是促使國產GPU大步邁入**“萬卡時代”**。

正如摩爾線程創始人兼CEO張建中所述:

當前,我們正處在生成式人工智能的黃金時代,技術交織催動智能湧現,GPU成為加速新技術浪潮來臨的創新引擎。

誇娥萬卡智算集羣作為摩爾線程全棧AI戰略的一塊重要拼圖,可為各行各業數智化轉型提供澎湃算力。

摩爾線程希望做的事情是解決最難做的事情,幫助國家、幫助行業解決缺少大算力的問題。

那麼前不久剛官宣完千卡集羣的摩爾線程,又是如何在這麼短的時間內率先跨入“萬卡俱樂部”的呢?

國產GPU萬卡集羣,是怎麼“煉”成的?

在回答怎麼“煉”之前,必須要確認的一點便是目標——什麼樣的萬卡集羣才算是好用的。

對此,張建中基於剛才種種的現狀分析,給出了一個符合當下算力需求的**“好用公式”**:

好用=規模夠大+計算通用+生態兼容

而這也正是最新誇娥(KUAE)萬卡集羣所具備的五大特點。

展開來看,首先便是萬卡萬P的超大算力。

具體而言,升級後的誇娥(KUAE)已經實現了單集羣規模超萬卡,浮點運算能力達到10Exa-Flops。

與此同時,在GPU顯存和傳輸帶寬方面,顯存容量達到了PB級,卡間互聯總帶寬和節點互聯總帶寬同樣也達到了PB級,實現算力、顯存和帶寬的系統性協同優化,全面提升集羣計算性能。

在大算力之後,便來到了好用的第二個關鍵因素——有效計算效率(MFU)。

MFU作為衡量大型模型訓練效率的標準指標,能夠直觀地反映整個集羣訓練過程的效率。

誇娥(KUAE)萬卡集羣通過在系統軟件、框架和算法等多個層面進行深入優化,可以成功實現對大型模型的高效訓練,MFU值最高可達60%。

具體來説,在系統軟件層面,通過採用計算與通信效率的極致優化技術,顯著提升了集羣的執行效率和性能。

在框架和算法層面,該集羣能夠支持多種自適應的混合並行策略和高效的顯存優化技術,能夠根據具體的應用需求自動選擇並配置最佳的並行策略,從而顯著提高訓練效率和顯存的利用率。

此外,針對處理超長序列的大型模型,誇娥(KUAE)萬卡集羣利用CP並行技術和環形注意力機制等優化手段,有效減少了計算時間和顯存使用,進一步提升了集羣的訓練效率。

對於一個好用的集羣而言,穩定性是最不可忽視的。

在這方面,正如剛才我們提到的,誇娥(KUAE)萬卡集羣平均無故障運行時間可超過15天,最長可實現大模型穩定訓練30天以上,周均訓練有效率目標為99%。

之所以把目標定得那麼高,得益於摩爾線程自主研發的一系列可預測、可診斷的多級可靠機制,包括:

軟硬件故障的自動定位與診斷預測實現分鐘級的故障定位

Checkpoint多級存儲機制實現內存秒級存儲和訓練任務分鐘級恢復

高容錯高效能的萬卡集羣管理平台實現秒級納管分配與作業調度等

至於最後一個最重要的保障,就在於通用性和生態友好。

據瞭解,誇娥(KUAE)萬卡集羣專為通用計算場景量身定製,能夠為LLM、MoE、多模態和Mamba等多樣化的架構和模態的大型模型提供加速支持。

此外,這個集羣還採用了高效且用户友好的MUSA編程語言,並且完全兼容CUDA,配合自動化遷移工具Musify,能夠實現新模型的即時”Day0”級遷移,確保了生態系統的即時適配性,從而幫助客户迅速部署其業務。

不過有一説一,雖然摩爾線程已經解鎖了萬卡集羣這一大關,但這個過程並非是將GPU堆疊這麼簡單,用張建中的話來説就是:

雖然從千卡到萬卡在數字上只是多了一個0,但難度上了卻增加了一個指數級,比攀登喜馬拉雅山都難。

例如,單是在超大規模組網互聯這個問題上,超萬卡集羣網絡便會涉及參數面網絡、數據面網絡、業務面網絡、管理面網絡等。

不同的網絡需要採取不同的組網部署方式,其中,超萬卡集羣對參數面網絡方面的要求是最高。

再如集羣有效計算效率方面,大量實踐表明,集羣規模的線性提升無法直接帶來集羣有效算力的線性提升,受限於芯片計算性能(芯片及算子使用效率)、GPU顯存的訪問性能(內存和I/O訪問瓶頸)、卡間互聯帶寬、有效的分佈式並行策略等,集羣有效計算。

除此之外,還會涉及訓練高穩定與高可用、故障快速定位與可診斷工具、生態快速遷移、未來場景通用計算等種種問題。

總而言之,是有一種牽一髮而動全身的感覺。

這就不免讓人發出疑問:摩爾線程為什麼非要啃下這塊硬骨頭?

萬卡很難,但也很必要

千卡集羣,不夠用,根本不夠用。

沒錯,這正是當下隨着大模型以“AI一日,人間一年”的速度迭代更新之下,算力所面臨的最根本問題。

也正因如此,主流的大模型玩家基本上都是配備了萬卡集羣,例如:

OpenAI:單集羣GPU數量50000+

谷歌:單集羣GPU數量25000+

Meta:單集羣GPU數量24500+

字節跳動:單集羣GPU數量12888

……

而大模型玩家們要想保持在業界的領先性,那麼自家的大模型的更新迭代的速度就不能太慢,兩週更新一次似乎也是成為了當下的常態。

因此,摩爾線程要做的事情,就是用萬卡集羣、全棧方式,打造一個大模型訓練超級加工廠,可以在算力上匹配當下大模型如此快速更迭的速度。

所以摩爾線程為什麼要啃下這塊硬骨頭,就不難理解了。

那麼隨之而來的另一個問題便是:為什麼摩爾線程能夠做到?

其實這並非是一蹴而就的事情。

其實早在2022年的時候,團隊便已經設定了建集羣的大方向與策略,這是因為當時A100算力也是處於緊缺的狀態,國內市場急需能夠替代它的產品。

從GPU功能情況來看,摩爾線程是在唯一可以從功能上對標英偉達的國產GPU企業。

隨着2023年大模型的火爆,這種GPU集羣式的方向就顯得更加正確,畢竟黃仁勳在發佈B200之際就表示“我們需要更大的GPU,如果不能更大,就把更多GPU組合在一起,變成更大的虛擬GPU”。

而摩爾線程更是為此狠狠做了一番準備,所以現在看來,摩爾線程當時的策略和決定,確實是具備前瞻性的。

那麼最後的最後,便是市場認可度的問題了,對此,在這次活動中的一張圖便可以解釋一切:

總而言之,細數摩爾線程在走來的這一路,似乎總是前瞻性地、開創性地推動着國產GPU的發展;而這一次,也是毫不意外地再拿下“國內首個”的頭銜。

至於這個新升級的萬卡方案是否能把握住高端算力的空窗期,答案就交給市場來回答了。