AI監管|AI新紀元:歐盟《人工智能法》解讀【走出去智庫】_風聞

走出去智库-走出去智库官方账号-昨天 22:40

走出去智庫(CGGT)觀察

在AI大模型掀起的全球技術浪潮中,國產AI應用出海趨勢顯著增強,在全球市場具有廣泛的滲透與影響。然而,面對國際市場,各國對於AI應用的監管情況各不相同。如美國和英國,採取較為寬鬆的監管策略,側重於行業自律與分散監管,為AI創新提供相對自由的空間;而歐盟則實施更為嚴格的監管模式,旨在確保AI系統的安全性和可靠性。

走出去智庫(CGGT)特約法律專家、鴻鵠律師事務所(Bird & Bird)合夥人龔鈺推出AI出海合規系列文章,將對各地區的AI合規法律進行整體的介紹,並對中國AI企業在出海的過程中,所關注的合規重點問題進行總結與分析,以期為AI企業出海提供關於合規管理的基本概覽。

今天,走出去智庫(CGGT)刊發系列文章之一《AI新紀元:歐盟〈人工智能法〉解讀》,供關注AI監管的讀者參閲。

要點

****1、《人工智能法案》具有廣泛的域外效力。****對於出海企業而言,即使其人工智能產品在國內開發並生產且該企業在歐盟境內並未設立實體,如果產品在歐盟市場投放,出海企業需要關注《人工智能法案》的有關規定。

2、********在風險導向的立法路徑下,《人工智能法案》提出了一系列不可接受風險的AI系統。落入該等風險的AI系統理論上不得被投放至歐盟市場。

3、《人工智能法案》對於違反其規定的特定行為制定了一系列的處罰措施,以確保人工智能的實踐安全合規且可問責。

正文

隨着大模型與通用人工智能的崛起,AI正重塑着我們的世界。它們不僅改變了傳統的人機交互方式,更在醫療、教育、交通等領域發揮着革命性的作用。然而,隨着技術的進步,對AI的規制也變得日益重要。歐盟《人工智能法案》(以下簡稱“《人工智能法案》”)的出台,正是對這一需求的回應。作為全球首部人工智能領域的法案,《人工智能法案》為AI技術的發展提供了法律框架,確保其在促進社會進步的同時,也能保護公民的基本權利。

對於中國出海企業而言,隨着全球化戰略的不斷推進,瞭解並遵守目標市場的法律法規對於企業的合規經營至關重要。本系列文章將深入解讀《人工智能法案》,並探討其對中國出海企業的影響。

作為本系列第一篇文章,開宗明義,我們將介紹《人工智能法案》的立法背景、適用範圍、AI系統的分類和監管機制。

一、 立法背景

從立法目的上看,《人工智能法案》旨在根據歐盟價值觀,制定統一的法律框架、促進歐盟單一市場內安全可信的人工智能系統的開發和採用、保障歐盟公民的基本權利,以及鼓勵歐洲在人工智能領域的投資和創新。

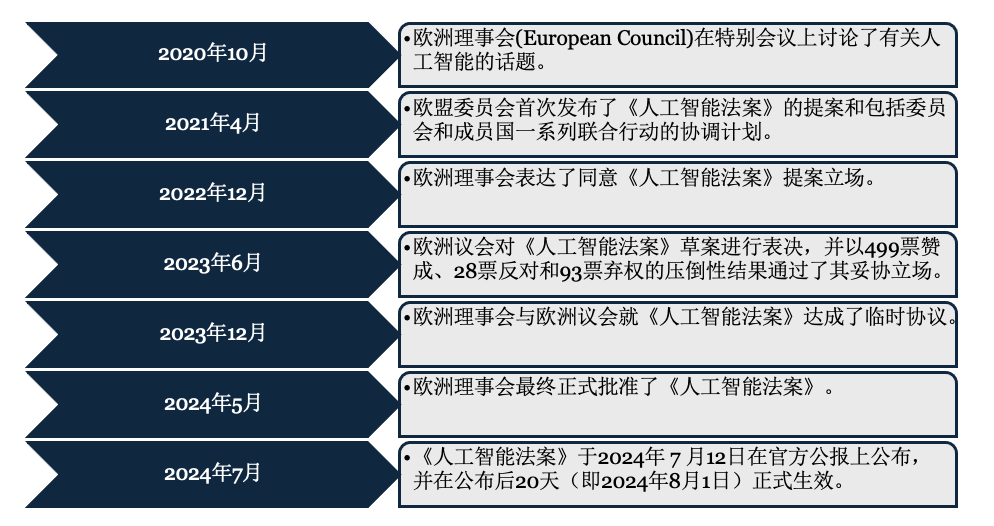

歐盟早在2020年便開始討論有關AI技術的規制問題,但真正的加速點出現在2022年末——ChatGPT的橫空出世展現出AI在自然語言處理方面的巨大潛力,這一事件也成為了推動歐盟加快《人工智能法案》立法進程的催化劑。為了更清晰地展示這一立法過程的演變,我們製作了一個簡要的時間表:

在《人工智能法案》正式生效的現下,如何應對《人工智能法》提出的監管要求,落地合規方案,是相關企業面臨的現實挑戰。

二、 法案適用範圍

從立法結構上看,與《通用數據保護條例》(General Data Protection Regulation)類似,《人工智能法案》也採取了橫向立法模式,覆蓋金融、醫療、內容、教育、能源、運輸、司法等各個行業領域。我們注意到,《人工智能法案》在適用的客體範圍、主體範圍、地理範圍三個維度均具有廣泛性。

廣泛的人工智能類型:《人工智能法案》對“人工智能”的定義較為寬泛,指代以機器為基礎的系統,它能夠以不同程度的自主性運行,並可能在部署後表現出適應性,而且為了明確或隱含的目標,它能夠從其接收的輸入中推斷如何生成輸出,如預測、內容、建議或可影響物理或虛擬環境的決定。基於該定義,當前被廣泛使用的虛擬助手、推薦系統、搜索引擎、自動駕駛、語音識別、醫療診斷、股市分析、語言翻譯等產品都可能落入“人工智能”的範疇。但需要注意的是,《人工智能法案》原則上並不適用於軍事、國家安全、研究和非專業目的的人工智能系統。

**角色廣泛:**從規制的主體上看,法案涵蓋了從AI系統的開發者、部署者、進口商、分銷商到產品製造商,以及授權代表等多種市場參與者。我們將在本系列的第三篇文章中進一步分析不同角色在《人工智能法案》下的對應義務。

域外效力:《人工智能法案》具有廣泛的域外效力。具體而言,該法案適用於在歐盟市場上投放或提供使用的人工智能系統的開發者,無論這些開發者是否在歐盟境內設立或位於歐盟;該法案也適用於在歐盟境外設立或位於第三國的AI系統開發者和部署者,只要其人工智能系統產生的輸出在歐盟被使用。因此,對於出海企業而言,即使其人工智能產品在國內開發並生產且該企業在歐盟境內並未設立實體,如果產品在歐盟市場投放,出海企業需要關注《人工智能法案》的有關規定。

三、 AI系統的分類

**1.**分類標準

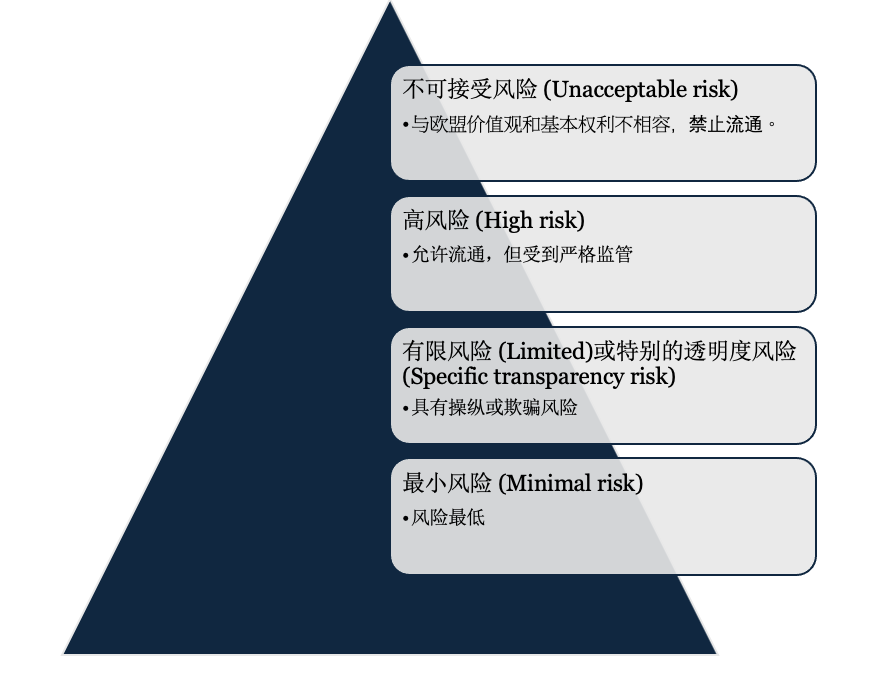

《人工智能法案》引入了一套適度且有效的人工智能系統約束規則。具體而言,該法案遵循基於風險的方法(Risk-based approach),對人工智能系統進行分級,根據人工智能系統可能產生的風險的強度和範圍,將人工智能劃分為四個等級,併為不同等級的人工智能創設了不同的義務,如下圖所示:

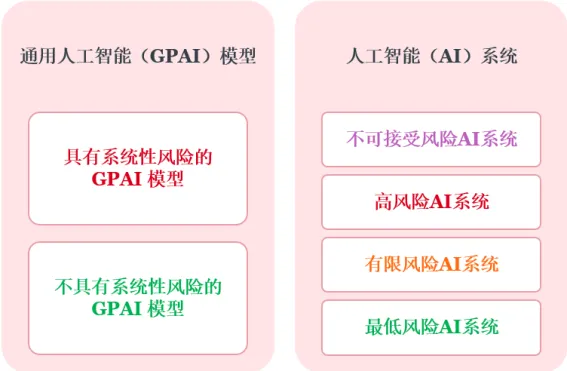

此外,《人工智能法案》還考慮了通用人工智能模型(General-Purpose AI models或GPAI********模型,包括大型生成式人工智能模型)可能產生的系統性風險。這些大模型可用於完成各種指示,並正在成為歐盟許多AI系統的基礎。如果這些大模型過於強大或被廣泛使用,其中的一些大模型可能會對歐盟市場帶來系統性風險。例如,被濫用於網絡攻擊,或是在許多應用程序中向不特定公眾傳播有害偏見。基於該等考量,最終版本的《人工智能法案》相較最初的草案稿新增一章用於明確GPAI模型開發者的義務。

**2.**不可接受風險

在風險導向的立法路徑下,《人工智能法案》提出了一系列不可接受風險的AI系統。落入該等風險的AI系統理論上不得被投放至歐盟市場。該等系統可能會以實質性扭曲人類行為為目的或達到類似效果,因此如果將這些AI系統投放市場並投入使用,可能對人類造成重大傷害,特別是對身體、心理健康或經濟利益產生嚴重的負面影響,故應予以禁止。

根據最終生效的《人工智能法案》版本,不可接受風險的AI(即被禁止的AI系統)包括以下類型:

潛意識操縱:例如,AI在人們不知情或不同意的情況下影響人們支持或反對某政黨;

利用人的弱點致害:例如,帶有語音助手的產品可能誤導未成年人從事危險活動;

通用社交評分:使用AI根據個人特徵、社交行為對個人進行評分;

預測警務:根據個人特徵評估個人未來犯罪的風險;

公共場所實時遠程生物特徵識別:生物特徵識別系統屬於此類,但執法部門可在司法批准和委員會監督下使用除外;

評估人的情緒狀態:這適用於工作場所或教育領域的人工智能系統。但是,如果出於安全目的(例如檢測駕駛員是否睡着),情緒識別可能備歸類為高風險;

根據敏感特徵對人員進行生物識別分類:以推斷自然人的種族、政治傾向、工會成員身份、宗教或哲學信仰、性生活或性取向;

遠程的實時生物識別系統:執法部門在公共場所進行實時遠程生物特徵識別,但該等系統在嚴格限定的場景下可被例外的使用。

**3.**高風險

高風險AI系統是《人工智能法案》着最多筆墨規定的一類系統,此類系統可能對健康、安全、基本權利和法治構成重大威脅。高風險AI系統可以分為兩類:

受歐盟相關安全立法規制(參見《附錄一》)且需要開展第三方合格性評估(third-party conformity assessment)的AI系統。換言之,如果某AI系統是一個專門的AI產品或某個產品中重要的安全部件,並且在它投入市場之前,需要通過一個獨立的第三方機構進行合格性評估,那麼該產品屬於高風險AI系統;以及

《附錄三》中專門規定的高風險系統:《人工智能法案》的《附錄三》列舉了以系列高風險AI系統的用例,包括用於生物識別、關鍵基礎設施、教育、就業、基本服務、執法、移民和司法的人工智能系統。但是,用於生物識別身份驗證、檢測金融欺詐或組織政治運動的AI存在一些例外情況。

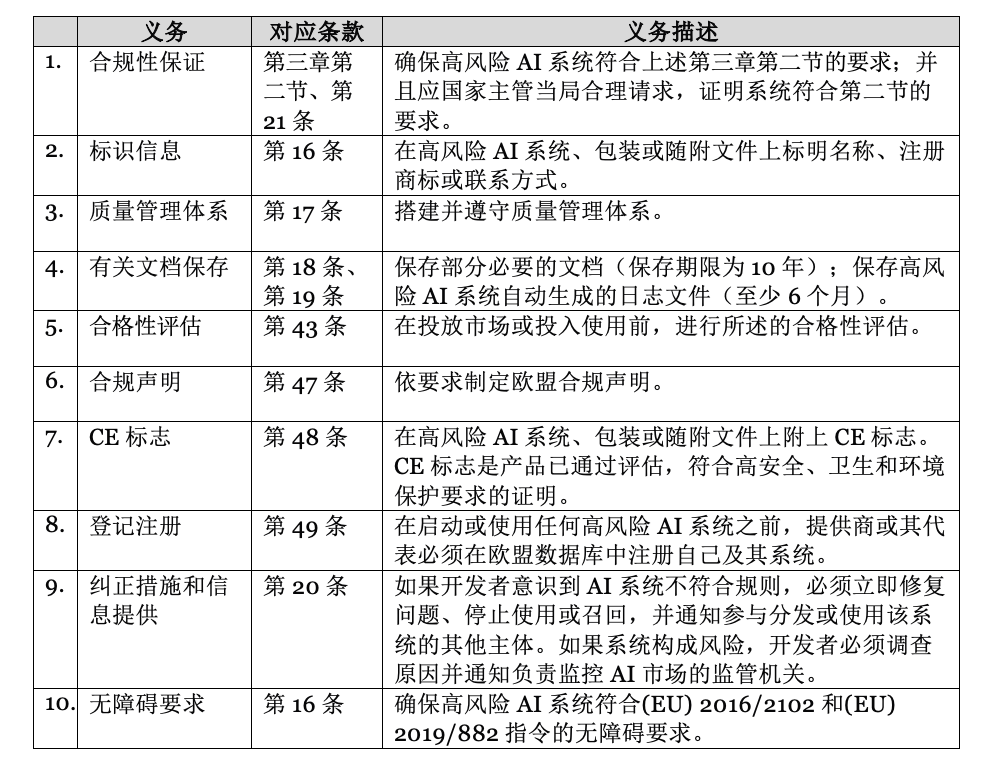

《人工智能法案》第三章第二節對高風險AI系統提出了一系列安全保障要求,具體包括搭建完善的風險管理制度、確保數據訓練和治理的合規性、準備技術文檔並定期更新、自動記錄AI全生命週期事件、確保產品的透明度、允許人類有效監督,以及保證系統準確、穩健和安全。此外,《人工智能法案》對高風險AI系統產業鏈中的不同主體施加了不同的合規義務,以高風險AI系統開發者為例,其主要合規義務如下表所示:

除對開發者進行規制外,《人工智能法案》還對部署者、進口商等主體需要履行的義務作出明確規定,更多不同主體對應的具體合規義務請參見我們本系列第三篇文章。此外,《人工智能法案》還設置了一套風險識別與彙報的監管機制,包括通知、報告、公告等,以保證受規制的主體能夠履行其相應義務,以及問責機制的有效性。

**4.**有限風險

有限風險(Limited risk)AI系統是那些在某些情況下可能會對用户或社會造成一定風險,但這些風險相對較低,不需要特別嚴格的監管措施。這些系統在使用過程中,如果透明度不夠或功能不明,有可能對用户造成輕微的誤導或困擾,但不會像高風險系統那樣對健康、安全、基本權利和法治構成重大威脅。此類系統包括但不限於:

**聊天機器人:**用於客户服務或信息查詢的自動化系統。

**情感識別系統:**用於識別人的生物特徵或情緒反應,進行客户服務或市場研究等。

**推薦系統:**用於在電子商務平台等提供商品或服務推薦。

生成或操控內容的AI系統(如deepfake):用於生成虛擬圖像、音頻或視頻內容。

《人工智能法案》對有限風險AI系統的監管旨在確保其在提供便利和創新的同時,也能夠保護用户的基本權利和利益,這主要通過加以透明性義務(Transparency obligations)來實現。有限風險AI系統在首次使用時應提供清晰可辨的信息,使用户無障礙地瞭解其基本功能和目的等,從而避免誤導用户或產生誤解:

**互動告知:**當用户直接與AI系統互動時,系統必須清楚地告知用户正在與AI系統互動,例如,聊天機器人應明確表示其為AI系統。

**內容標識:**對於生成或操控內容的AI系統,這些系統的輸出必須標識為人工生成或操控的,並且標識應是機器可讀的

**情感和生物識別:**如果AI系統用於情感識別或生物識別分類,系統必須告知用户該功能正在被使用。

**5.**最小風險

最小風險(Minimal risk)AI系統是那些GPAI模型、不可接受風險、高風險或有限風險類別以外的一般AI系統。這些系統不會對用户的健康、安全或基本權利造成重大威脅。這類系統包括大部分常見的AI應用,比如:

**文字處理軟件:**如用於拼寫檢查和語法糾正的AI系統。

**垃圾郵件過濾器:**用於電子郵件系統中的自動垃圾郵件檢測和過濾。

**簡單的推薦系統:**如視頻流媒體平台上的內容推薦算法(如果這些推薦不會對用户產生重大影響)。

《人工智能法案》對最小風險AI系統的監管相對寬鬆,允許其自由使用。《人工智能法案》鼓勵企業自願遵守一些行為守則,確保AI系統的公平性、非歧視性和透明性。

四、 監管機制

**1.**違法後果

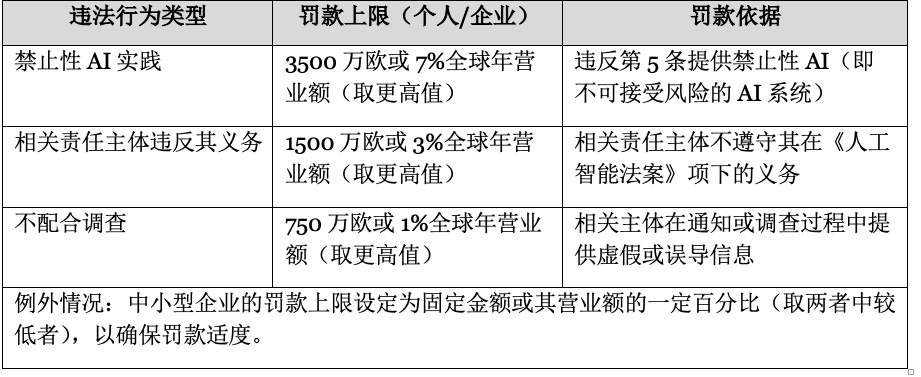

《人工智能法案》對於違反其規定的特定行為制定了一系列的處罰措施,以確保人工智能的實踐安全合規且可問責。這些處罰措施又根據違法行為的性質、嚴重性,以及違法主體的體量而有所不同,如下表所示:

2.執法機制****

根據《人工智能法案》,各成員國至少應當設立或指定至少一個市場監督管理機關作為成員國監管機關,負責合規監測和執法監督等職能。各成員國監管機構將實際負責監督執行關於AI系統的監管要求和處罰,包括對AI系統進行評估、要求AI系統運營相關主體提供信息和採取措施,以及實施處罰。

此外,就歐盟層面而言,為保證《人工智能法案》的執行,歐盟委員會在其內部設立了人工智能辦公室(AI Office)負責法規解釋、合規監測、執法監督、國際協調等職能。人工智能辦公室的主要職責包括:

**實施監督任務:**人工智能辦公室作為歐盟委員會的內部機構將實際負責監督執行GPAI模型的監管要求和處罰,包括對GPAI模型進行評估、要求模型開發者提供信息和採取措施,以及實施處罰。

**系統風險預警:**當GPAI模型在歐盟層面構成可識別的風險或符合某些風險標準時,人工智能辦公室會收到來自科學小組的合規警報。收到警報後,人工智能辦公室可評估和處理已識別的風險。

**出台實施指南:**人工智能辦公室還將利用專業知識促進法案的理解和適用,包括制定AI相關的行為準則、指南文件、關於基本權利評估的問卷模板等。

除了委員會層面的監管要求,《人工智能法案》還設置了一套機制促進成員國之間的協調與合作,具體包括:

**通知機關建立:**每個成員國必須設立至少一個通知機關(notifying authority),負責制定和執行評估合格性評估機構的程序,並對這些機構進行監督。通知機關需要配備足夠的專業人員,並具備信息技術、人工智能和法律等領域的專業知識。

**市場監督:**成員國的市場監督機構可以請求歐盟委員會的協助,以執行法規下的任務。

**人工智能監管沙盒:**成員國應建立監管沙盒,為AI系統提供開發、培訓、測試和驗證的受控環境。所謂監管沙盒是指由監管機構創建的框架,它允許公司和創新者在受控的環境中測試和開發新產品、服務或商業模式。監管可以在沙盒中提供指導和監督,以降低與基本權利、健康和安全相關的風險,並促進跨境合作和監管學習。

**違規行為的報告與舉報者保護:**成員國應按照Directive (EU) 2019/1937的規定,建立機制報告違規行為並保護舉報者。

註釋:

1. Regulation (EU) 2024/1689 of the European Parliament and of the Council of 13 June 2024 laying down harmonised rules on artificial intelligence and amending Regulations (EC) No 300/2008, (EU) No 167/2013, (EU) No 168/2013, (EU) 2018/858, (EU) 2018/1139 and (EU) 2019/2144 and Directives 2014/90/EU, (EU) 2016/797 and (EU) 2020/1828 (Artificial Intelligence Act) (Text with EEA relevance).

2. https://ec.europa.eu/commission/presscorner/detail/en/QANDA_21_1683

3. https://digital-strategy.ec.europa.eu/en/policies/ai-office