韓國再爆發N號房2.0事件!未成年罪犯將親媽姐妹AI換臉成人片賺錢_風聞

心之龙城飞将-30分钟前

英國報姐

2024年08月31日 13:06:46 來自安徽省

1人蔘與1評論

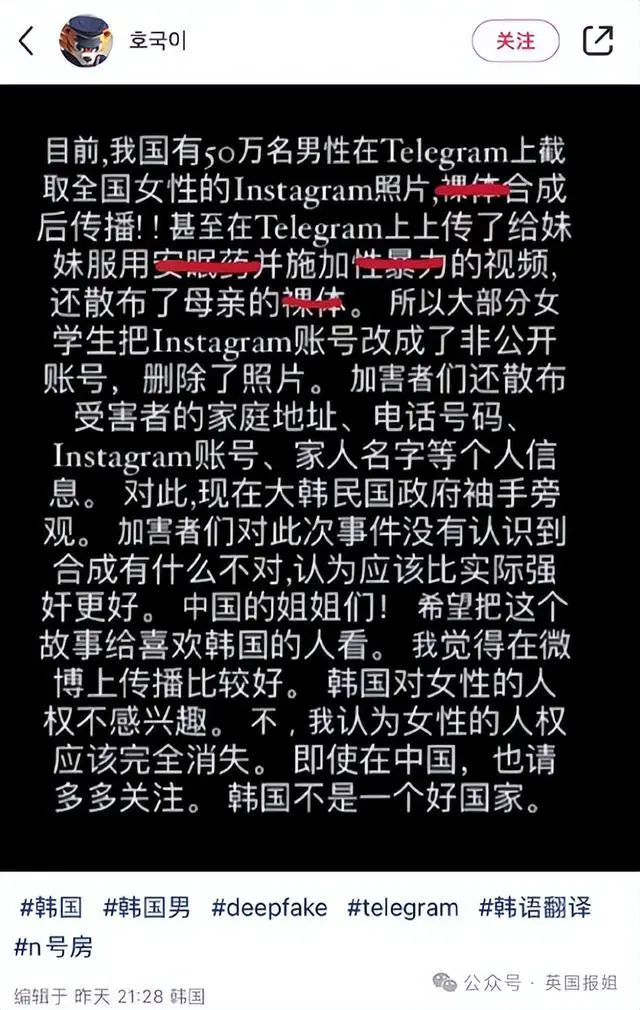

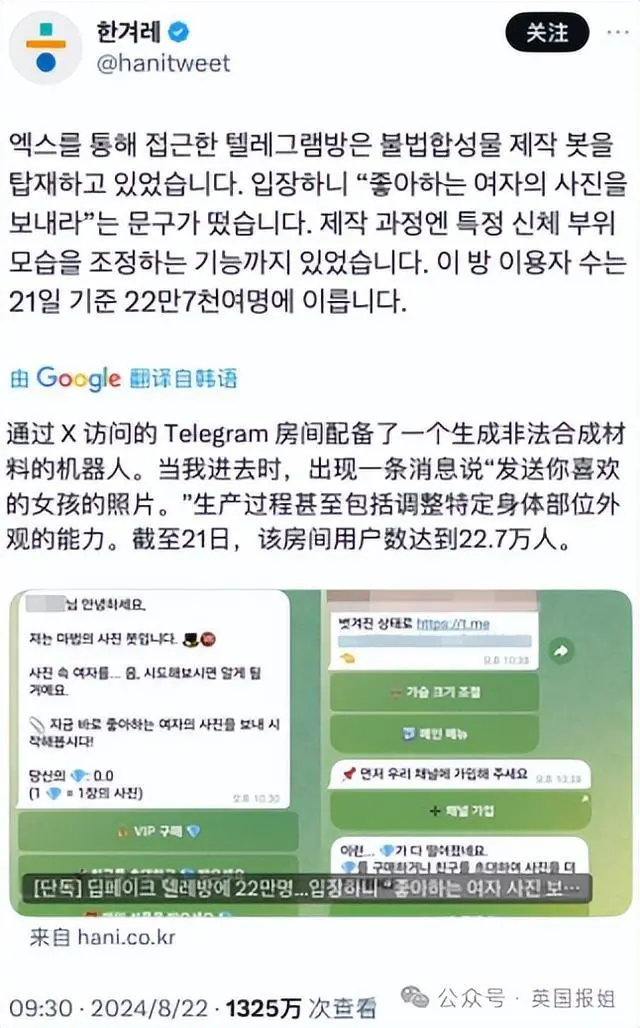

最近,韓國女性大規模遭遇AI換臉成人視頻的事件引發了海內外的熱議。

加害者們不僅將自己的母親、姐妹的換臉成人視頻作為籌碼,在地下聊天羣裏交流分享,還以公開受害女性身份、家庭住址為由,向受害人索要錢財。

(示意圖)

為了引起韓國全社會對該事件的重視,韓國女性紛紛克服語言障礙在海外社交賬號發帖求助。整起事件涉及的受害人數之廣,遠超外界的想象… …

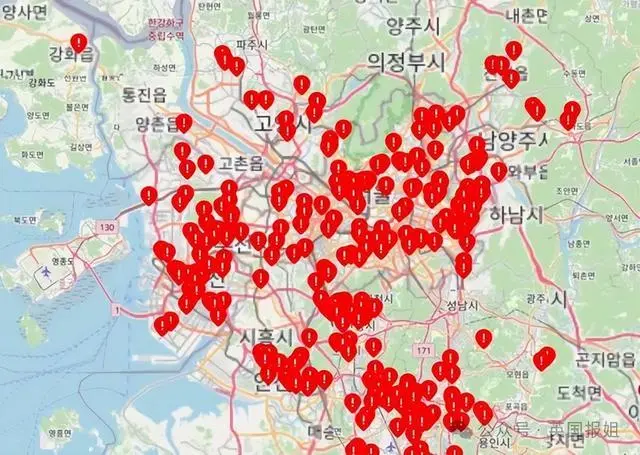

上週,韓國一名初三男生A某聽説自己學校有5名“AI換臉成人視頻”的受害者。本着讓更多人關注此事的想法,他利用2小時的時間建立了一個“受害者學校地圖”網站。

(示意圖)

隨後,A某邀請所有得知身邊有受害人的網友自發在上面登記,希望用這種“擊鼓傳花”的接力方式擴大輿論效應。

讓A某和網友意料之外的是,網站建立僅短短2天時間,就有500所學校被標記,超過300萬人次登錄查詢自己是否被換臉成為受害者。

事件中的受害者不僅包括韓國頂尖的首爾大學、高麗大學、延世大學等知名學府的高材生,還包括大量初高中和小學生等未成年人。

(示意圖)

持續井噴增長的受害者人數,引發韓國大中小學校負責人的恐慌。

27日一早,韓國各學校老師開始陸續通知學生們刪除個人社交賬號上的所有照片,就連只向好友公開的照片也要做到一張不留、全部刪除。

韓國教育部更是直接向學生及家長髮送應對AI成人換臉的方法,鼓勵受害者及時向學校和警方報警備案。

(示意圖)

更可怕的是,各大學校作為此次“AI成人換臉”事件中最大的受害單位,除學生之外,老師也是受害最廣的羣體。

根據韓國全國教職員工的調查顯示,從去年初開始,就有幾十個標註着教師的家庭住址、身份信息的AI成人換臉視頻在互聯網上傳播。

(示意圖)

受害教師報警後,警方在此後1年半的時間裏一直以“不方便公開加害者信息”為由不立案。

在此次全國範圍的AI成人換臉事件鬧大之後,韓國警方才不情不願地出面透露,加害者大部分是十幾歲的青少年。

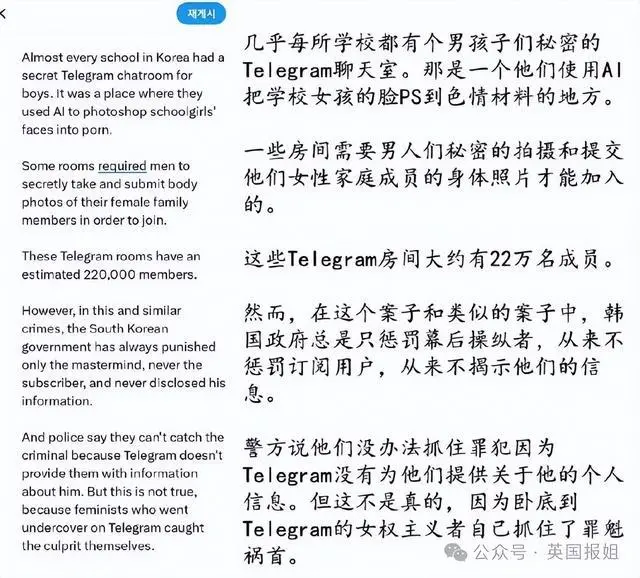

根據數據顯示,青少年在整個加害者中佔比高達73.6%,整體加害者人數更是驚人的超過22萬人。而2023年的韓國出生人口也僅有23萬。

未成年加害者

為了控制住這個規模龐大的犯罪團體,韓國總統尹錫悦在27日發表講話,要求根據根除此類AI犯罪。

由於加害者都是躲在互聯網背後的神秘組織成員,而且很多還是未成年人,因此導致這次“AI換臉成人視頻”的受害者人數還在不斷增長,蔓延速度如同看不見的瘟疫,有逐漸擴大化的現象。

(示意圖)

為了捍衞自己的尊嚴和安全,大量疑似韓國女性的賬户在韓國之外的國外社交媒體平台發帖求助。她們希望藉此能增加輿論效應,倒逼韓國政府加大、加緊追蹤調查藏在暗處的加害者。

(示意圖)

她們之所以會採取跨國網絡申訴,也是因為這起荒唐的“N號房2.0”事件被擱置得太久。

其實早在今年5月份,韓國國內就爆發了一起被稱為“N號房2.0”的AI換臉成人視頻的特大案件。

從2021年至2024年4月,首爾大學的畢業生樸某和姜某,利用“深度偽造”(Deep Fake別稱AI換臉)技術將受害人頭像合成為成人視頻,並在加密通信軟件上傳播、擴散並獲利,直接受害者多達61人。

據參與傳播的犯罪團伙交代,和5年前的N號房犯罪手段僅為偷拍相比,只需上傳頭像就能製作一個成人視頻的AI換臉技術,犯罪手段更簡單、成本更低、傳播速度更廣、受害人羣更廣。

報案的受害者

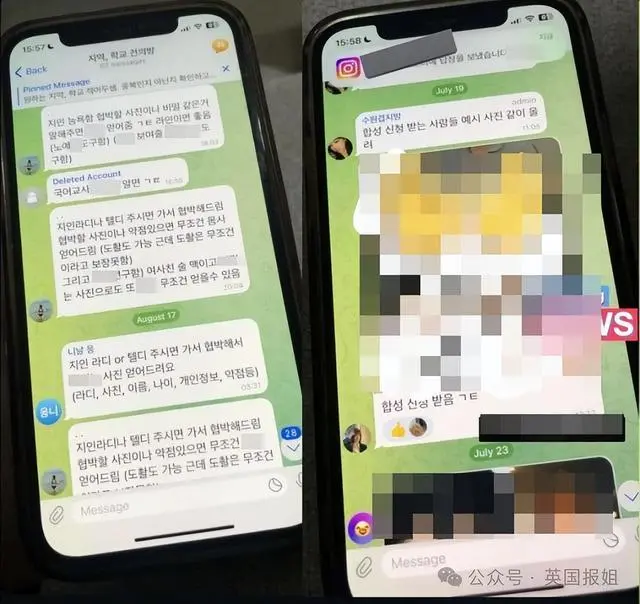

犯罪分子在創建好私密交流羣后,會邀請臭味相投的加害者入羣。進羣時,每個人需要上傳5個女性熟人的AI換臉成人視頻。

(示意圖)

進羣任務完成後,加害者可以使用羣裏的免費軟件,製作一個AI換臉成人視頻,第二個視頻就會收取費用。如果邀請自己的好友入羣,就可以獲得打折製作視頻的機會。

(示意圖)

通過這種拉人入夥的方式,犯罪分子既能獲利,還能拿到免費的視頻資源。他們利用這些視頻,對受害人進行金錢勒索,甚至提出侵犯要求。這些犯罪手段,也和5年前的N號房如出一轍。

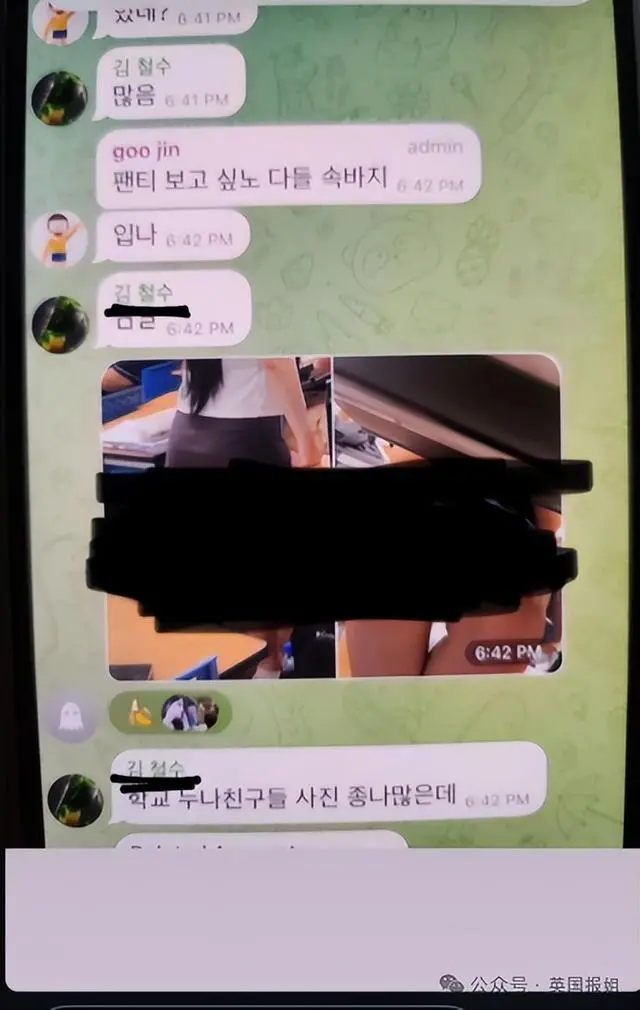

被拉進羣的加害者,製作視頻時往往會選擇身邊人下手,不少人甚至把自己母親、姐妹的換臉成人視頻拿來交換,再慢慢延伸到親友、同學、老師、同事等。

(示意圖)

因此,韓網上的私密聊天羣也從“媽媽房”“姐妹房”擴散至“女教師房”、“護士房”、“女兵”等。

不同分類的私密聊天室

更令人不寒而慄的是,成年加害者中不乏有軍人、醫師等內部人員。

在不到4年的時間裏,韓網上衍生出的成人交流羣多達數百個,受害者上升到22萬。這也導致2023年全球AI成人換臉作品中出現的人物,有一半左右都是韓國女性。

(示意圖)

但直到這次爆發韓國女性跨國求助等一系列大事件,才讓韓國官方重視起來。

海內外的網友對這次韓國AI成人換臉事件進行了激烈討論,也是因為任何地方的普通人,都可能會成為下一個受害者。

早在2017年12月,AI換臉技術首次在大眾視野曝光時,就被一位網友用來給《神奇女俠》主演蓋爾·加朵合成了成人視頻。

(示意圖)

沒錯,這項技術最可怕之處就在於,用户只需上傳一張正面照,就能一鍵將素材視頻中演員的對換。而且新技術不僅能換臉,還可以偽造聲音。

合成出效果之逼真,何止本人看不出來,就連專業科技公司在辨別時也很難找到破綻。

(示意圖)

隨着近幾年技術的不斷發展、升級,更是簡化到上傳頭像5秒後,就能製作整部影片,甚至視頻對話的“傻瓜”功能。

今年2月,一個詐騙團伙利用AI換臉技術,製作出一家跨國公司全部高層發言的短片,並利用這個短片從財務人員手中騙走2億港元(約1.8億rmb)。

由此可見,AI換臉技術應用到犯罪手段上,跨國公司的風險部門都難逃一劫,我們普通人更是招架不住。

(示意圖)

從這次的韓國AI成人換臉騷動能看出,技術作為一把雙刃劍,在造福人類的同時也可能給犯罪分子有機可乘。在推廣技術應用的同時,監管也必須跟上才行。