臉被人偷走,用來造謠和報復?AI假照片是新的霸凌手段,但還要靠AI解決問題……_風聞

把科学带回家-把科学带回家官方账号-专注于孩子的科普教育54分钟前

撰文 | Skin

審校|Ziv

西班牙的米麗亞姆·阿迪布的女兒今年14歲,有一天,女兒告訴她自己被“霸凌”了,她拿出手機,向阿迪布展示了一張不屬於自己,但卻有自己的臉的露骨照片。

作為婦科醫生的阿迪布提到,若不是她足夠了解女兒的身體,真的會以為這張照片是真的。而這張以假亂真的照片已經在當地的社交媒體羣組裏不斷傳播。

自己的臉忽然出現在其他“身體”上,但看起來像是真的?|圖源網絡

近一個月,相同的事情也發生在英國和韓國。韓國女孩Heejin(化名)在社交媒體上發現,她居然有一個專屬於自己的“聊天室”,在裏面,許多張她幾年前拍的,還是學生時的照片上的臉,被放在不屬於自己的假的露骨照片上。

Deepfakes是一個近些年來才出現的詞,它由“深度學習(deep learning)”和“虛假(fake)”兩個詞合成,顧名思義,就是用AI工具來做出的假的圖像、視頻或音頻。在AI的幫助下,這些假照片越來越逼真了!

你也許早已在社交媒體上見過許許多多的假照片,比如各種名人做着他們“其實從未做過的事”。2017年,有人想看演員尼古拉斯·凱奇主演的經典電影,便將他的臉換到各種知名電影片段中;2018年,這種換臉的門檻變得越來越低,在deepfake網站或手機APP上,你就算完全不懂AI,也能很快做出一張虛假照片。

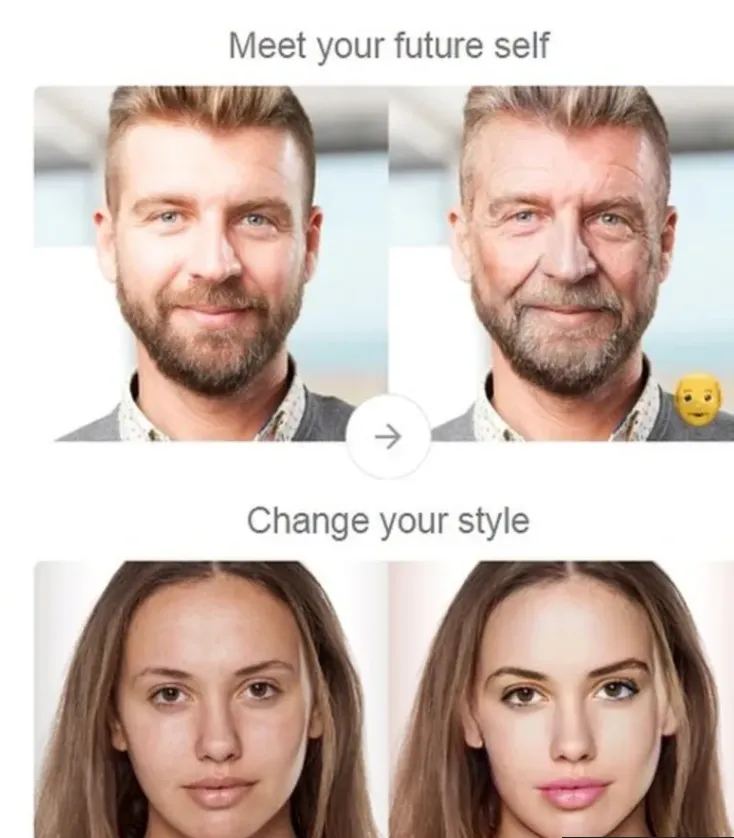

有許多網站可以讓你看到“假”照片。但是當你上傳照片想看看老去的自己時,是否閲讀過此網站的隱私聲明?你的臉也有可能遭到隱私泄露|FaceApp

而不需要門檻的造假技術很快就滋生了一系列具有威脅性和犯罪的行為:假新聞、金融欺詐,以及越來越頻繁發生的青少年、兒童和女性遭遇到的露骨照片惡性事件。

面對沒有門檻的造假技術,我們需要的,可能是沒有門檻的抵抗它的技術。網絡上一起傳播廣泛的deepfake性犯罪事件被揭露後,中國科學院自動化所的研究團隊VisionRush就宣佈開源他們的AI打假工具。

AI工具可以辨別真實照片和deepfake照片之間的那些細微差別。|pixabay

而這種對抗AI造假的技術,其實也是通過AI來實現的。在前期,AI將學習各種AI生成圖片的特徵,也就是成為“造假圖片專家”,因此在識別階段,就能拿着一些特殊的“放大鏡”,用不同的角度來檢查照片中的像素,並且根據學到的內容,來特別提取這些照片中容易出錯的“特徵”,比如説紋理,光照,表情和邊緣的細節。

AI造假技術需要靠AI的分析來辨別。|Pixabay

這項技術參與了一個月前舉辦的外灘大會AI創新賽·全球Deepfake攻防挑戰賽。而在8月30日,這項比賽的組委會就倡議大家,可以將參賽的模型開源。而比賽中獲獎的VisionRush和JTGroup便很快宣佈將自己的模型開源。

而這也是希望技術人員能夠合力做出更加完善的模型,並且做成網站、APP,讓普通人也能輕輕鬆鬆地使用對抗deepfake犯罪的工具。

而在另一個方面,最近互聯網巨頭微軟的Bing也做出了對抗Deepfake的動作。9月初,Bing宣佈和StopNCII合作,希望能幫助到deepfake受害者。

StopNCII或許可以幫助到受害者。|StopNCII

StopNCII是一個幫助受害者保護自己的免費數據庫。在網絡上,如果一張照片借用了受害者的臉,不管它如何處理,那張臉的“代碼”都是一樣的。

當受害者發現自己的照片可能已經被泄露,甚至有被造假的風險後,他們可以給自己的臉申請一個獨特的“數字指紋”。而StopNCII和一系列其他的社交媒體平台合作,則會同步這些指紋,在平台上搜索是否有這些“指紋”。如果有,平台上的相關影像將會被下架。

如今,已經有許多社交媒體平台和StopNCI合作,Bing是第一個和它合作的搜索引擎,除此之外還有reddit,TikTok,Instagram,Snap等。

而谷歌的搜索引擎也宣佈將會降低搜索內容中露骨和AI合成內容的權重,未來也將幫受害者刪除那些非自願的偽造內容。

從檢測假照片,到刪除假照片,目前也許都有了一些解決方案,如今也希望能更加完善。而作為互聯網的用户,我們如今還是不得不從源頭上保護我們的個人隱私,比如,儘量少在互聯網上分享兒童和青少年影片,警惕偷拍行為,以及查看APP對你個人信息的訪問權限等。

參考資料:

[1]https://www.theguardian.com/world/article/2024/jul/09/spain-sentences-15-school-children-over-ai-generated-naked-images

[2]https://www.bbc.com/news/articles/cpdlpj9zn9go

[3]https://stopncii.org/

[4]https://blogs.microsoft.com/on-the-issues/2024/09/05/an-update-on-our-approach-to-tackling-intimate-image-abuse/