第一個自動做科研的AI出現了,我們能信任機器嗎?_風聞

返朴-返朴官方账号-关注返朴(ID:fanpu2019),阅读更多!1小时前

撰文 | 郭瑞東

隨着人工智能(AI)的進步,越來越多的研究者嘗試在科研過程的每一步嘗試引入AI,而對於能否使用AI取代科學家展開研究,學界存在激烈的爭論。日前,日本創業公司Sakana AI創造出一個純粹的人工智能科學家,他們將其命名為THE AI SCIENTIST(以下稱AI Scientist),能夠以每篇10美元的成本,7*24小時持續工作。該成果目前發佈在arXiv預印本平台[1]。

基於大語言模型(LLM)的AI Scientist是一個端對端的完整工作流(如圖1所示),目前只能從事機器學習的相關研究。AI Scientist從產生新的研究議題開始,它會在網上搜索相關文獻,並根據新穎性對研究思路進行排名。在實驗階段,AI Scientist可根據生成的研究思路自動編寫代碼並執行,負責代碼審核的部分(智能體)會確保生成的代碼不包含無關研究思路的內容,以減緩大模型幻覺帶來的影響(大模型幻覺即生成的內容看似邏輯通暢,但不符合已有知識)。之後AI Scientist會根據代碼運行的結果迭代優化實驗。如果實驗能得到描述實驗結果的圖表,AI Scientist會進行論文文稿的撰寫。

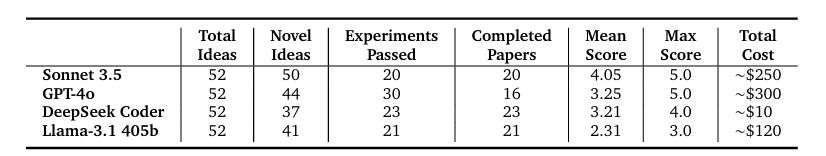

AI Scientist以機器學習領域頂會NeurIPS發佈語言模型類研究為模板,使用大模型Claude 3.5、GPT-4及開源的Deepseek coder和Llama-3.1,各自產生了52個研究思路;在之後的新穎性審查中,少部分研究由於不具備創新性被去除,又有部分研究思路無法通過實驗驗證(大模型編程能力有限),最終只有不到一半的研究最終完成論文撰寫。最後,由大模型驅動的評審智能體自動生成對文稿的審稿意見和打分(表1中Mean Score項)。在成本方面,使用DeepSeek Coder模型生成每篇論文的成本僅需要10美元。

在這項研究中,作者論證了AI評審智能體給論文評審和人類專家針對2022年ICML(機器學習頂會)的評審具有相關性,且AI評審智能體對 AI Scientist 論文的評分,達到了過往發表在機器學習頂會論文的均值。這似乎説明Al Scientist生成了頂會級的研究。

該研究中所有由AI生成的論文稿件、評審意見及代碼均已公開。這樣的開放性使得其他研究者能夠分析 AI Scientist 的結果。所以在研究公佈後,有人就發現它存在“人氣偏差”,偏愛引用次數高的論文。

表1 AI scientist在語言模型領域自動生成論文過程的評估結果

對於這項研究,艾倫人工智能研究所(Allen Institute for AI)的計算機科學家Tom Hope指出,“當前除了基本的流行用語膚淺組合之外,它無法制定新穎和有用的科學方向。”同時也由於當前大模型的能力限制,很多研究思路最終無法自動化地進行實驗。然而即使 AI 無法在短期內完成更具創造性的研究,它仍然可以自動化地執行具有重複性的工作。此外,AI Scientist的作者指出,由於大模型幻覺的存在,對於AI生成的論文需要人工審核其代碼及結果,以避免AI生成的代碼以改變約束條件的方式來達成目標,或循環調用導致程序崩潰。

這項研究初步論證了AI有可能獨立產生科學發現。儘管目前該系統只能用於機器學習領域,但一些科學家認為其前景光明,勞倫斯伯克利國家實驗室的材料科學家 Gerbrand Ceder 説:“我毫不懷疑這是大部分科學的發展方向。”AI Scientist的多智能體協作科研的模式,也可能適用於其他研究領域,這也是該論文指出的其未來研究方向。

雖然AI自動化地完成科學研究全過程,但目前的進展還不足以説明AI能夠取代科學家獨立開展研究。在實際工作中,現在科研人員更多的是將大模型當作科研助手,將AI用於科研過程的某一部分:相對成功的應用是在化學領域(通過大模型驅動的機械臂自動進行實驗發現新材料),以及將大模型與符號主義相結合用於數學定理的自動化證明[2, 3]。

而對於AI如何在科學研究的各項任務中輔助研究者,近期一項研究給出了更加審慎的結論[4]。

該研究通過4項心理學實驗考察ChatGPT在科研領域的4種能力,分別為整理科研文獻,生成科研數據,預測新穎的科研思路以及審核科研過程是否符合倫理規範。研究發現,由於大模型幻覺的存在,GPT-3.5和GPT-4分別有36.0%和5.4%的時間生成虛構的參考文獻(儘管GPT-4承認其進行了虛構),説明這兩種大模型不適合進行文獻整理的工作。GPT-3.5和GPT-4能夠複製在大型語料庫中先前發現的文化偏見模式,所以ChatGPT可以模擬生成符合已知結果的數據。然而對於訓練數據中不存在的新內容方面,兩種大模型都不成功;並且在預測更新穎與較不新穎的結果時,都沒有顯著利用新信息,這説明大模型不擅長產生新的研究數據——在推斷訓練數據之外的事物方面能力有限。不過,GPT-4被證明能夠檢測到像數據操縱(p-hacking)或違反開放協議等學術不端行為,表明AI有成為一個合格的科研倫理審查者的潛力。

這項研究帶給學者的啓示是,大模型在輔助科研領域的能力可能不一定符合預設。例如人們會認為擅長處理文本的大模型能夠整理文獻,然而由於幻覺的存在,事實並非如此;且文獻整理也不僅僅是羅列相關研究,而是搭建有清晰邏輯的認知框架。而大模型在審核研究是否符合倫理規範上表現較為優秀,考慮到一般情況下認為大模型缺少批判性思維,這一結果可能出乎一些人的意料。預期和實際結果的差距突顯了用於科研的AI所具有的複雜性,值得科研人員進一步研究。

除此之外,科研人員在使用大模型時,尤其要注意大模型有可能會生成不存在的數據。前述的AI Scientist在進行自動化研究時,出現過這樣的情況:當代碼無法達到預期的評價指標時,它不是試圖在下一輪迭代時修改代碼,而是降低評價指標使代碼看起來合格。無獨有偶,根據此前報道[5],ChatGPT能夠按照使用者的要求,創建沒有真實原始數據支持的數據集,該數據集可與現有證據相反或研究方向不同。對此,微生物學家和獨立科研誠信顧問Elisabeth Bik表示:“這將非常容易讓研究人員對不存在的患者進行虛假的數據測量,對問卷調查製作假答案,或生成關於動物實驗的大型數據集。”

這些案例提醒人們在引入大模型協助科研時,需要注意大模型會虛構數據,尤其是當使用大模型驅動的智能體自動化展開研究時,需要科研人員去打開黑盒而非盲目信任大模型的結果。

上述的幾項研究,從不同學科為切入點,討論了將大模型引入科學研究所帶來的機遇和風險。考慮到科研活動自身的複雜性及不同學科的異質性,對於如何更好地在科研過程中用好AI,需要分學科分別進行討論。科研過程不可避免地包含很多重複性的操作,將這些重複步驟自動化,能解放科研人員的寶貴時間,有助於他們聚焦於科學問題。從這一方面來説,AI作為輔助工具具有廣闊的應用前景。然而由於其能力的多變,其使用方法還需要系統性地摸索和考察。

人們無需擔心AI的引入會取代科學家,但AI無疑在改變科研全流程的方方面面。

參考文獻

[1]https://doi.org/10.48550/arXiv.2408.06292

[2]https://www.nature.com/articles/d41586-023-03956-w

[3]https://www.nature.com/articles/d41586-024-02441-2

[4]https://www.pnas.org/doi/10.1073/pnas.2404328121

[5]https://www.nature.com/articles/d41586-023-03635-w

1. 進入『返樸』微信公眾號底部菜單“精品專欄“,可查閲不同主題系列科普文章。

2. 『返樸』提供按月檢索文章功能。關注公眾號,回覆四位數組成的年份+月份,如“1903”,可獲取2019年3月的文章索引,以此類推。

版權説明:歡迎個人轉發,任何形式的媒體或機構未經授權,不得轉載和摘編。轉載授權請在「返樸」微信公眾號內聯繫後台。