除了資本,還有技術?——理解馬斯克站台特朗普的深層邏輯|政治_風聞

探索与争鸣-《探索与争鸣》杂志官方账号-13分钟前

編者按

據環球網綜合外媒報道,當地時間10月5日,美國前總統、共和黨總統候選人特朗普重返賓夕法尼亞州巴特勒市並舉行了一場“備受矚目”的競選集會。當天,馬斯克受邀參加了上述競選集會,並上台與特朗普同框,這是馬斯克首次公開支持特朗普。現場畫面顯示,馬斯克戴了一頂黑色的“讓美國再次偉大(MAGA)”帽子,兩度在台上高高蹦起,公開表達對特朗普的支持。此新聞發佈後,引發國際社會廣泛關注。有觀點指出,除了馬斯克的個人立場,應該關注其代表的美國階級與羣體,這是資本與政治的再一次深度結合。有觀點則認為,除了資本,應該看到,馬斯克所代表人工智能高科技公司的入局,將會給日益逼近的美國大選帶來新的變數。

事實上,AI 技術的快速發展引發了越來越多的關注。據媒體報道,Axios 的分析顯示,美國至少有26個州已經通過或正在考慮相關法律,以監管選舉中使用的生成式 AI。這意味着,在未來的選舉中,AI 將不再是一個簡單的技術工具,而是一個可能影響投票結果的 “遊戲規則改變者”。在生成式人工智能的幫助下,兩黨或選舉組織利用AI技術精準投遞信息。然而,這種技術也可能加劇選民的偏見與分歧,加深美國政治生態的技術性割裂和不穩定性。因此,理解馬斯克站台特朗普,更深層次的是要看到當下的生成式人工智能對政治的影響,全景呈現技術政治的多面性和複雜性。本公眾號特推出此文,供讀者思考。僅代表作者觀點,不代表公眾號立場。

新興人工智能的政治影響與治理策略

王中原|復旦大學社會科學高等研究院副教授、國家發展與智能治理綜合實驗室(教育部)兼職研究員

本文原載《探索與爭鳴》2024年第8期

具體內容以正刊為準

非經註明,文中圖片均來自網絡

技術與政治總是在人類歷史長河中共生演化。以生成式人工智能、交互式人工智能、大模型技術、通用人工智能技術為代表的新興人工智能將深刻塑造當代政治,並伴隨政治的應用與規制向前發展。人工智能(AI)系統旨在模擬人類智能,完成學習、感知、推理、預測、解決問題、規劃決策等任務。新興人工智能採用大型預訓練模型、大語言模型(LLMs)、多模態基礎模型(MFMs)、擴散模型等前沿技術,能夠高效處理海量多模態數據、學習複雜模式、實現跨模態內容生成及自動化決策。較之傳統機器學習,新興人工智能更加註重數據驅動,具有更強的自適應學習能力,可在不同的環境和任務中進行遷移學習,並藉助增強學習實現持續優化。因此,新興人工智能在智能表現、適應能力、靈活性和創造性方面更加接近人類智能,能夠應對更加複雜多樣的決策需求。這些性能突破為人工智能在政治場域的應用開闢了新空間,同時也孕育着新的技術焦慮。

圖源:環球網

政治生活的哪些關鍵領域會受到新興人工智能的影響?人工智能進步能否優化現代政治系統,抑或動搖民主政治根基?人工智能的技術特性及人機關係模式如何決定其政治影響?人工智能技術真的中性嗎?**新興人工智能的蓬勃發展催生一系列前沿政治學議題,本研究嘗試構建一個分析框架,全景呈現技術政治的多面性和複雜性,為相關研究提供認知圖譜。**本文第一部分將從信息機制、交互機制、決策機制三個維度闡釋新興人工智能塑造當代政治的作用路徑;第二部分將聚焦政治輸入、政治過程、政治輸出三個環節,分析新興人工智能影響當代政治的關鍵場景、應用前景和潛在風險;第三部分將從開發者、使用者、監管者三方視角,探討引導和規制新興人工智能政治影響的可行路徑。

本文在既有研究基礎上,力求作出如下推進。首先,在廣度上,本文將從三個環節及其六大場景系統闡釋新興人工智能如何影響當代政治,包括政治輸入(選舉政治、協商政治)、政治過程(政治代表過程、公共政策過程)、政治輸出(政治回應、政治問責)。其次,在深度上,本文區分技術特性與人機互動模式兩個維度,剖析新興人工智能如何通過重構信息機制、交互機制、決策機制影響政治系統,揭示不同政治影響的技術原理和形成過程。此外,本文並不急於定性,而是平衡地分析人工智能在政治領域的應用前景及其潛在風險,並探討產生異質結果的影響因素及其治理策略。再次,在鋭度上,本研究認為人工智能技術的政治風險部分源自人機互動中的“關係效應”,但也部分植根於技術特性的“本質缺陷”,因此,人工智能治理須區分技術特性和人機關係兩個層面。最後,本文認為政治場景相較商業場景更具敏感性和衝突性,人工智能的政治應用及其規制本身即是一個充滿爭議的政治問題,這就要求更高層次的民主創新。

新興人工智能影響政治系統的關鍵機制

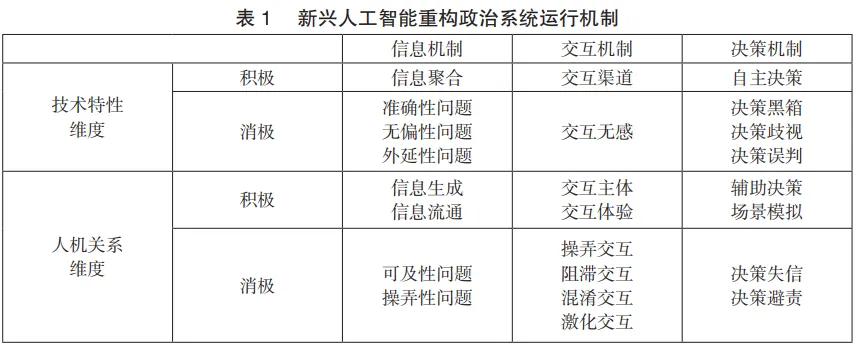

新興人工智能通過哪些機制影響政治系統?本文從“技術特性”和“人機關係”兩個維度,探討新興人工智能如何通過重塑信息機制、交互機制、決策機制影響公民參與、政民關係和公共決策(見表1)。本文認為,**人工智能技術並非中性,新興人工智能本身的諸多技術特性決定了其同時內嵌了功能和風險,這些功能或風險會在不同的人機關係結構中被放大或遮蔽,呈現出多樣的組態和生態。**技術政治向何處去取決於我們對技術特性的認知和控制,以及我們對人機互動模式的選擇和規制。

(一)信息機制

新興人工智能改變政治運行的信息機制。就積極方面而言,以生成式人工智能為代表的新興人工智能能夠提供前所未有的政治信息,其功能包括信息的聚合、轉譯、歸納、建議選項等,讓民眾和政府對公共事務有更加全面和深入的知識準備。與傳統的檢索系統或知識庫不同,生成式人工智能依靠對海量人類知識和數據信息進行預訓練和微調,再根據提示或指令湧現性地生成使用者需要的新信息和新知識。大模型的規模效應(scaling law)可促進以下功能實現。(1)信息聚合:完成人類現有知識和數據最大限度的解碼、訓練、抽取和歸納,構建起聚合各類政治知識的信息基座。(2)信息流通:實現跨語言(cross-lingual)和跨模態信息的自動翻譯和轉碼,突破信息和知識的“巴別塔”困境,通過信息流通和知識互借趨近“羣體智能”,並促進政治信息更高效地觸達公民。(3)信息生成 :提供新的信息組合,憑藉生成和湧現能力扮演諮詢專家,在問答和模擬中為用户提供多元觀點、解決思路和策略建議。上述新功能促使信息生產、傳播、應用發生深刻轉型,為政治系統注入全新動能。

就消極方面而言,智能技術並非完全中性,新興人工智能的技術特性使其提供的信息和知識存在諸多侷限性。(1)準確性:生成式人工智能的底層技術是概率預測,即根據已有數據中的模式(patterns)和使用者的提示(prompts)預測最高概率的內容。概率性決定了其生成內容並非基於信息集總和事實判斷(有別於知識庫),難免存在置信區間外的錯誤預測。(2)無偏性 :基於歷史數據預訓練的大模型必然會重現和強化數據中的現存偏見,在性別、年齡、族羣、地域等維度上生成偏見信息,甚至呈現顯著的政治意識形態傾向性。(3)外延性:大模型的訓練數據通常截至某個特定時點,對此後的政治動態或全新的政治現象知之甚少或出現認知幻覺。(4)可及性 :智能信息工具的商業化和定製化趨勢,導致部分羣體和組織享有比其他羣體更強的信息賦能,進而產生信息能力的不平等。(5)操弄性 :惡意行動者可操弄信息生成和流通過程,通過影響訓練數據、模型設定、參數選取、訓練方法、提示策略等,生成符合特定目標的信息,並依託智能計算快速傳播。上述侷限性凸顯了政治領域引入智能信息機制的複雜性,輕則導致民眾對公共事務的認知失真,重則引發政治信息失序。

(二)交互機制

新興人工智能改變政治運行的交互機制。就積極方面而言,新興人工智能憑藉豐富高效的內容生成能力和實時沉浸的溝通交互能力,可極大提升政治互動過程的效率和體驗。(1)交互渠道:生成式人工智能和交互式人工智能與社交媒體、政府網站、熱線平台、政務應用等融合,可以打造智能化、沉浸式的交互環境,為政民互動提供全時空的開放渠道。(2)交互主體:大模型支持多語種、多模態和多場景的交互,降低邊緣羣體(少數族羣、殘障人士等)和忙碌羣體(工薪階層、年輕人羣等)的互動成本,培育“積極公民”。(3)交互體驗:人工智能系統能夠精準識別用户意圖和需求,提供個性化的互動體驗,進而激活有序的政治參與,提升參與效能感。以上技術突破有助於提升政治系統的活力,增進政民互動的廣泛性和代表性,克服日益嚴峻的政治疏離。

就消極方面而言,人工智能對政民互動的影響亦取決於政治行動者的行為方式,其中孕育着交互異化的多重風險。(1)操弄交互:惡意行動者可利用人工智能系統生成誤導性內容和進行瞄準式交互,誘導公眾參與或形成特定偏好。尤其當生成式人工智能與社交機器人、計算傳播、認知作戰等技術結合時,可以精準且隱秘地影響用户,實現行為操控。(2)阻滯交互:政治行動者可面向特定受眾生成和投送虛假信息,以低成本、大規模、高頻率的攻擊性內容污名化對手,抑或以虛假內容放大對方聲量以觸發平台或官方的審查機制,阻滯對方參與。(3)混淆交互:政治行動者可以利用生成式人工智能的內容生產能力和社交機器人的內容傳播能力,向官員郵箱、政務應用、社交媒體等投送大量人工智能編制的訴求信息和政策觀點,營造虛假的羣體訴求和輿情態勢,放大特殊利益的影響力。(4)極化交互:政治行動者亦可藉助人工智能工具扭曲交互環境,製造並傳播謬訊和惡訊,沿着特定社會割裂線和政策立場激活羣體間的衝突界面,調動民眾激進情緒,加劇政治對抗和社會撕裂。(5)交互無感:過度依賴人工智能工具開展政民互動,會破壞政治生活的温情和真實感,造成民眾與政府的情感脱鈎。上述風險均源於對智能交互的濫用或依賴,容易放大智能技術的負面特性,助長特定行為體的政治操控力,引發政治極化甚至政治互動失序。

(三)決策機制

新興人工智能改變政治運行的決策機制。就積極方面而言,新興人工智能憑藉強大的信息處理、場景模擬、策略生成和預測分析能力,為政治決策提供自動化和智能輔助兩種賦能路徑。(1)自動決策(automated decision making,ADM):新興人工智能能夠更高效準確地處理多模態非結構化數據(在政務場景中尤為常見),並湧現性地生成新的洞察和預測,為決策自動化注入新動能。相較於人工決策,智能決策系統更加客觀中立、標準統一,並能基於實時追蹤和預測分析進行事前干預,在福利分配、警務執法、司法判決、行政監管、移民審查等領域具有應用前景。(2)輔助決策:生成式人工智能可扮演虛擬智囊,成為決策者的“副駕駛”。通過與決策支持系統(decision support systems,DSS)融合,大模型能夠在動態情境中評估複雜信息並預測趨勢走向,並完成決策支持和策略制定。“社交聽取”(social listening)工具亦有助於政府實時跟蹤網絡反饋 ,並生成回應建議。(3)決策模擬 :新興人工智能可訓練生成近似真實事件概率結構的大量合成數據(synthetic data),決策者可據此模擬真實世界的決策場景並評估可能結果,為明智決策奠定基礎。總之,人工智能工具有望優化政治決策流程,提升決策效率和決策質量。

就消極方面而言,鑑於政務決策的重大影響,新興人工智能在自動化和智能輔助決策中仍面臨諸多亟待解決的挑戰。(1)決策黑箱:新興人工智能系統的模型架構和算法設計更為複雜,涉及多模態數據和超大規模參數,使其內部決策程序對用户和監管者來説極不透明,也難以就其決策依據給出令人信服的解釋,加劇了決策黑箱問題。(2)決策誤判:生成式人工智能本質上是概率預測模型,其生成的決策判斷是基於模型架構和訓練數據預測出的最高概率結果,這決定了該決策過程必然存在誤差,由此導致決策誤判。(3)決策偏見:訓練數據不平衡或代表性不足將促使決策模型學習並固化已有偏見,加之特徵選擇、模型訓練或指標評估等環節缺少倫理考量,算法系統則傾向於作出對特定羣體不公平的決策。(4)決策失信:智能決策容易產生權威不足、算法避責和矯正滯後等問題,降低公眾的信任度,尤其當涉及關鍵公共決策時,容易引發政治信任危機。總之,政治決策無小事,政府在部署人工智能決策系統時,必須審慎考量其技術特性及人機關係新模式所產生的多重政治社會後果。

新興人工智能與政治輸入

**新興人工智能正深刻影響政治輸入環節,包括選舉、協商、遊説、動員、捐款、意見表達等政治參與活動。**公民參與是政治系統良性運轉的動力之源,然而“參與萎縮”現象在諸多當代政體中成為新常態。新興人工智能的引入或可扭轉該趨勢,重塑政治參與的機會、意願、行為、能力和效能感,催生依託智能技術的參與新形態(participation mediated by AI),進而影響政治的輸入合法性(input legitimacy)。

(一)選舉政治

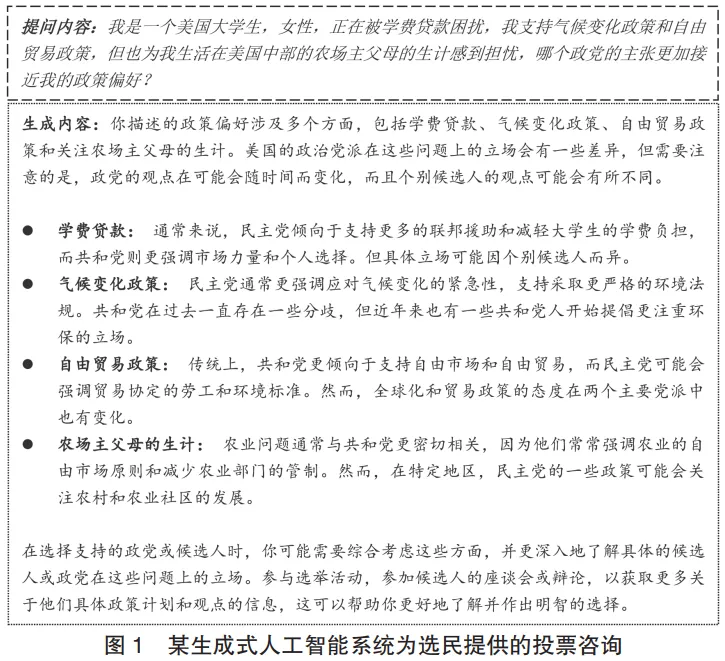

選舉是當代民主參與的典型形式,新興人工智能將改變競爭性選舉的運行方式。一方面,智能技術賦能選舉,提升參與熱情和民主活力,豐富競選活動的形式。**在選民參與層面,人工智能助手可便利地為選民提供選舉程序、政策立場和候選人信息,並通過個性化的多模態資訊解析幫助選民理解複雜政治議題。**智能交互平台亦為選民創造了表達觀點和參與討論的新渠道,增進選民的交互體驗和參與效能感。人工智能工具亦可捕捉選民的價值理念和政策偏好,生成個性化的捐款或投票建議,降低參與成本並提升決策質量(見圖 1)。在競選組織層面,人工智能系統可協助候選人生成競選講稿、政策文本、社交媒體文案,模擬辯論場景;開展精準的選民調研和輿論分析,把握選情趨勢;優化籌款和動員方式,提升選舉資金的使用效率;識別虛假信息,防範和應對惡意攻擊;打造候選人的人工智能分身,以保持與選民的跨模態溝通和全天候互動。

另一方面,選舉智能化潛藏多重風險。其一,錯誤信息和選民誤導。受限於訓練數據和算法偏差 , 現有人工智能系統提供的選舉信息存在大量脱離事實的內容,可能誤導選民。一項針對瑞士聯邦大選和德國州級選舉的第三方調查發現,微軟 Copilot、必應 Chat 和 ChatGPT 等知名人工智能系統約 30% 的回答存在事實錯誤。其二,虛假信息和選民操弄。惡意行動者可利用人工智能生成大量含有誘導性和欺騙性信息的文本、圖片和視頻,擾亂選舉的信息環境。競選團隊亦可藉助人工智能虛擬形象、會話機器人和社交機器人等推進計算傳播和影響力攻勢(inffuence operations),操縱選民決策或壓制選民投票。其三,負面競選和政治對抗。人工智能技術可被濫用於生成負面競選和人身攻擊內容,以詆譭和中傷對手,或激化觀念分歧和情感對立,將選舉引向意識形態對抗而非理性政策辯論,加劇政治極化。例如,2023 年 4 月,美國共和黨使用生成式人工智能製作了一段包含多個虛構衝突場景的視頻,藉此攻擊拜登為“史上最弱總統”。其四,選舉信任和政治穩定。人工智能工具可能被惡意行動者濫用於選舉干預,破壞選舉過程的安全性和公正性。尤其在選情焦灼的關鍵時刻,人工智能干預可能左右勝敗方向,導致敗選方及其支持者拒絕承認選舉結果,引發憲制危機甚至選舉暴力。事實上,2024 年達沃斯世界經濟論壇發佈的《全球風險報告》已將人工智能干預選舉列為全球最大政治風險之一。

(二)協商政治

民主協商是政府治理過程中重要的公民參與形式。新興人工智能為協商政治帶來新的發展契機,同時也引發新的技術挑戰。一方面,人工智能可以豐富協商的內容和形式,增進協商過程的公正性、透明度以及商談質量,進而提升政治過程的代表性和包容性。其一,角色扮演和流程管理。人工智能可擔當協商的主持人、協調者、仲裁者和共識建設者,以中立立場設定協商議程、促進平等發言、彌合潛在衝突、助推建設性對話,識別並過濾協商過程中的虛假信息,守護協商的公正性和平等性。其二,能力培訓和意見生成。生成式人工智能能創建教育培訓材料,幫助參與者理解協商原則和流程,提升公眾的政策知識和協商能力;通過身份設定生成針對特定議題的觀點意見、解決思路和行動方案,賦能參與者的溝通對話本領,促進協商的創新性和多元性。其三,對話支持和無障礙參與。人工智能工具藉助自然語言處理、自動翻譯、跨模態生成等功能可促進跨語言對話,提供靈活無障礙的協商方式,提高協商民主的包容性。其四,場景模擬和方案路演。人工智能可模擬政策影響並可視化不同情景和方案,幫助參與者理解潛在協商結果。通過切換和比對不同條件、場景和方案,尋求共識路徑。其五,數據分析和協商優化。人工智能可分析參與者的語言、行為、情感表達和交互反應等協商數據,實時整理各方觀點並優化協商過程,提煉共識點。上述功能有助於構建人工智能賦能的新型協商系統,促進協商政治的技術轉型。例如,美國斯坦福大學的全球協商民主在線平台正在試驗人工智能主持,嘗試運用人工智能技術提供跨語言支持、識別濫用行為、實時分析協商內容等。

另一方面,人工智能技術在協商民主中的應用面臨多重困境。其一,性能侷限和分歧製造。當前人工智能系統在處理大規模參與、複雜議題、精細辯論和價值選擇時存在性能侷限,其算法傾向於關注短期問題和即時效果,這使得智能協商難以應對長期的複雜社會問題。此外,人工智能預測可能帶來事實錯誤或放大極端聲音,加劇意見分歧。其二,算法偏見和協商操弄。當前人工智能技術在理解複雜情景、特殊語境和文化差異等方面尚存缺陷,可能導致不準確的意見總結和歧視性的決策建議。尤其當訓練數據帶有偏見時,模型輸出會低估或忽視特定羣體的代表性,導致協商不公。此外,人工智能技術可能被濫用於製造身份偽裝、操縱意見表達或編制虛假共識。其三,技術集中與代表鴻溝。人工智能技術的不均衡掌控將導致少數人佔據技術優勢和話語勢能,加劇協商過程的權力集中,破壞協商過程的民主性。同時,技術排斥和能力鴻溝容易導致協商過程的代表性失衡。人工智能技術甚至可被濫用於偽造代表性和虛假參與(participation washing),成為為特定結果背書的工具。其四,信息過載和信任危機。新興人工智能可以高速度低成本地生成和導入海量資訊,這可能引發協商過程的信息過載和參與爆炸,使得關鍵信息被遮蔽。此外,過度使用虛擬身份和生成技術會削弱對話和合作的誠意,產生人機之間的委託代理困境,降低協商民主的真實性和可信度。

新興人工智能與政治過程

新興人工智能正逐步嵌入政治過程(包括政治代表過程和公共政策過程)的各個環節,對議程設置、政民互動及決策質量產生深遠影響。當代政治日益注重政治代表性和政策公共性,人工智能技術賦能國家治理過程,在提升政府開放性和決策科學化的同時,也觸發代表性質量和公共性水平等諸多層面的挑戰,進而影響政治的過程合法性(throughput legitimacy)。

(一)政治代表過程

新興人工智能重塑政治代表過程。一方面,生成式人工智能等新興人工智能技術如若運用得當,將推動代表工作的創新,在促進代表者與被代表者有機互動、改善政治代表關係等方面產生正向效應。其一,代表產生過程。人工智能技術可輔助推進更加公平的選區重劃(AI-assisted redistricting),增強代表與人口的比例均衡性。例如,美國北卡羅來納州運用抽籤方式從 1000 張人工智能製成的選區改劃圖樣中抽選方案,排除黨派因素的不當干預。人工智能技術還可分析選區和選民數據,為政黨匹配更具代表性的候選人,並模擬預測不同提名方案產生的實質性代表結果。未來,人工智能體甚至可能直接扮演政治代表角色,該現象已在日本、丹麥、俄羅斯等國家出現。人工智能技術亦可輔助優化代表選舉過程,包括準確的選民身份認證、科學的投票站點設置、可靠的投票欺詐識別,維護代表產生過程的公正性。其二,代表履職過程。代表可藉助交互式人工智能和智能問答系統,實時與選民保持密切聯繫。人工智能工具可定製化地生成電子郵件、社交推文及多模態的政策解讀材料,實現緊密的立法溝通和選區聯結;人工智能工具還可自動執行在線調查,收集分析選民訴求,追蹤預測民意波動,開展更為精準的選區服務和政策説服;代表亦可藉助人工智能平台,邀請公眾全程參與和監督,增進立法活動的回應性和民意基礎。

另一方面,新興人工智能的技術特性及其可能的濫用,或將導致代表性偏差甚至扭曲,過度依賴人工智能工具亦會造成代表關係的虛化。其一,訓練數據的非平衡性導致人工智能過度凸顯某些羣體的訴求可見性而忽略其他羣體,造成代表性失衡。大量湧入的生成式內容未必反映真實民意分佈,代表若無差別響應真人和機器人生成的訴求,將導致代表性扭曲。其二,遊説團體可開發垂域智能應用,生成大量個性化的郵件、海報、遊説素材和網絡文案,或利用智能機器人操縱民意調查,並通過計算宣傳向代表施加“虛假民意”壓力。如此,原本佔據資源優勢的團體和黨派將獲得更大聲量,其態度、關切和利益更易被代表。其三,人工智能工具傾向於根據代表的立場過濾信息,讓政治代表只看到符合其偏好的內容而失去全局視角,造成決策者的“信息繭房”,影響代表性實現。其四,人工智能工具可能被某些政治代表用於意識形態説服和培養“賽博樁腳”,或指揮社交機器人軍團發動網絡影響力攻勢,加速精英極化(elite polarization)與大眾極化(mass polarization)的相互傳導。其五,技術依賴導致代表過程非人格化,削弱代表與選民的真實互動。人工智能代理人可能缺乏關注力和同理心,尤其面對少數弱勢羣體時更是如此,不利於代表關係的維繫和深化。

(二)公共政策過程

新興人工智能將重塑公共政策過程,作用於議題識別、方案設計、政策採納、執行實施和績效評估五個關鍵環節。**一方面,人工智能有望助力政府更加精準、科學、高效地制定和落實公共政策,推進治理現代化。**其一,議程設置階段。人工智能可分析多源異構數據,識別社會問題、公眾關切和政策輿情,並藉助預測建模研判潛在政策風險,為政策議程設置助力。其二,方案設計階段。政務生成式人工智能能呈現多樣化的政策方案,提供創新性的政策選項;人工智能賦能的決策支持系統可迅速準確地分析各個方案的利弊得失;人工智能自動決策系統基於業務數據搭建標準化決策流程,提升決策效率;人工智能場景模擬則能預判不同方案下的實施效果,幫助政府研判潛在風險和實施難度。其三,政策採納階段。人工智能可生成個性化的政策解讀和宣傳材料(例如垃圾分類政策),並精準投送相關政策信息;亦能生成政策培訓資料,為各級實施者特別是基層官僚提供政策宣介,並實時響應其困惑和反饋。其四,執行實施階段。人工智能能監測公共政策的精準落地,識別政策執行偏差,優化資源配置和資金管理(例如扶貧政策), 增強國家信息能力;可實時檢視社會媒體和政務平台上新政策的民意反應,為政策調整提供智能支撐。其五,政策評估階段。人工智能評估系統可制定科學績效體系,高效完成指標建構、數據採集、計量分析和可視化等工作,幫助政府全面評價政策實施效果,併為下一步“循證決策”提供依據。

**另一方面,政策過程的智能化轉型亦存在諸多風險。**如忽視技術缺陷和“以人為中心”的決策模式,或將導致決策失誤,乃至引發政府信任危機。其一,識別偏差和決策錯誤。人工智能算法依賴訓練數據中的關聯形態,而既有數據記錄了現實世界的偏見、歧視和不平等,人工智能系統傾向於將這些數據偏差固化和結構化,自動放大特定羣體的政策偏好和利益訴求,而忽視全局性問題和普遍關切,從而削弱政策的“公共性”。此外,概率預測無法確保準確性,加之政務數據 “髒亂差”問題嚴重,難以支持決策科學。即便極低概率的誤判,亦可導致個體層面的不公甚至引發系統性風險。其二,算法黑箱和複雜困境。雖然人工智能決策系統為克服反向利用和安全風險須保持一定程度的“封箱化”,但黑箱也將降低決策過程的透明性和決策結果的可解釋性。規模法則(scaling law)更加劇了人工智能系統複雜化,導致決策過程難以追溯和復現。大模型預測追求關聯性而非因果性,難以識別影響政策結果的關鍵因素和作用機制,這為政策優化帶來困難。其三,技術失靈和算法避責。人工智能系統面臨技術故障、災害事件或攻擊威脅,特別是缺少災備系統和並行機制時,技術失靈可能導致決策過程運轉失序。此外,一些決策者或將人工智能系統視為避責工具,在政策效果不佳或面臨輿論風波時,將責任“甩鍋”給非人格化的智能技術。

新興人工智能與政治輸出

政治輸出是政治系統對社會需求和公共利益的響應,包括通過優化公共服務提升政府回應性、完善政治問責推動政府變革等,由此輸出施政績效。政治輸出的質量直接影響政治體制的穩定性和合法性,不同政體的政治回應能力和政治問責效力反映了其治理效能。新興人工智能正在重塑政治回應和問責機制,提升政府治理效能的同時也帶來了新的治理挑戰,進而影響政治的輸出合法性(output legitimacy)。

(一)政治回應

新興人工智能將變革政治回應機制,形塑智能時代的政民關係。**一方面,新興人工智能可極大增進政府的回應效率和回應質量,提升公共服務供給和解決民意關切的能力,有利於改善政民關係。**其一,公共服務供給。政府可將人工智能系統嵌入各類政務應用和在線服務平台,實時識別和分析民眾的公共服務需求,自動處理大量常規任務(例如智能表單生成、身份認證和政策檢索),或輔助人工完成複雜的回應流程;政府可搭建全天候智能響應系統,對流程化服務實現自動審批,並打通不同業務模塊,第一時間作出回應,提高公共服務供給效率;人工智能系統亦可實現用户分析和需求預測,藉助對話式人工智能提供個性化的服務和引導,提升政務服務體驗;人工智能技術還可自動甄別公共服務申領者的欺詐行為,預警公共服務的濫用風險,提升服務供給的精準度和公共資源的使用效率。其二,響應民意關切。智能應急系統能夠收集和處理多模態的監測數據,面對突發公共危機和訴求湧入作出及時響應,並藉助智能會話系統開展事前提醒、溝通和宣導。針對個體訴求,智能客服系統可 24/7 接入並即刻響應。例如,法國政府計劃引入 ChatGPT 等生成式人工智能工具輔助公務員更加高效地回應民眾訴求。針對普遍關切,人工智能系統可實現跨平台多模態的數據分析和趨勢挖掘,引導政府在政策和立法層面作出回應。人工智能技術賦能的高質量政府回應也將增進公眾對新興人工智能的信任和接納。

**另一方面,新興人工智能亦可能導致政府回應失序,引發政民關係緊張。**其一,生成式人工智能和交互式人工智能極大降低了內容編制和傳播成本,惡意行動者可藉機向政府投放大量重複訴求,輕則導致政府回應偏差和政務資源浪費,重則引起政務回應系統的過載和癱瘓。傳統操弄行為較易識別,但生成式人工智能編制的內容具有異質性和多模態等特徵,加之藉助智能機器人投放,官方通常難以應對。其二,交互式人工智能雖能突破傳統聊天機器人的規則引擎,呈現出 “類人格化”的交互能力,但其回應仍高度依賴訓練數據。首先,現有數據通常存在偏見和失衡,容易引發回應過程的誤判和失當,例如自動決策系統在甄別服務欺詐時作出不利於移民羣體的判定。其次,人工智能系統在面臨全新複雜情境時,通常缺乏足夠的分析應對能力,其回應往往流於表面或陷於僵化,難以切實解決實際問題。再次,生成式人工智能和交互式人工智能雖具備感知用户訴求和情感狀態的能力,卻也容易受到提示詞(prompt)的引導和規訓。一旦有惡意行為者通過虛假賬户對其進行誤導性訓練,其輸出便有可能背離事實和倫理底線。最後,由於政務數據資源分佈不均、質量參差不齊,人工智能系統在不同政策領域的回應能力存在明顯差異。該“數據鴻溝”疊加地域、城鄉和羣體間的技術鴻溝,使得過度依賴人工智能系統不僅可能導致技術紅利的不均衡分配,破壞公共服務均等化原則,而且會訓練政務系統善於回應技術強勢羣體的訴求,而拙於回應技術弱勢羣體。

(二)政治問責

新興人工智能可推動社會對政府自下而上的問責(bottom-up accountability)以及政府內部自上而下的問責(top-down accountability),開闢政治問責新路徑。其一,智能技術有望推動政務公開和社會監督。政務大模型能以文本、圖表、視頻等可交互形式將政務信息個性化地呈現給公眾,生成式人工智能則能從海量政府文件中提取關鍵信息並生成通俗解讀。民眾和媒體可以與人工智能系統進行實時互動,獲取某方面的政務信息和政策解釋,便於開展社會監督。新興人工智能亦可監測和分析官方投訴系統、政務平台、社交媒體的多模態數據,在海量訴求和輿情數據中甄別線索、發現問題、促進追責。這些都有助於增強社會對政府工作的問責和監督,推動構建開放透明的責任政府。其二,智能技術有望強化腐敗治理和內部監督。新興人工智能可用於監測官員的財務狀況、資產變動和生活方式等,結合社交網絡分析洞悉政商關係網,自動識別異常跡象和違法線索,預警和打擊腐敗。垂域智能系統可生成豐富的廉政教育材料,通過場景模擬開展官員警示教育。此外,智能審計和監察系統通過監測政務內網和平台數據,可實現項目、資金、採購、績效的全流程監管(例如扶貧資金智能監管),提升政策執行合規性以及克服委託代理困境。

另一方面,政治問責是一項複雜任務,人工智能技術應用亦面臨多重風險。其一,全景式智能監督將加重基層官員的數字負擔,抑制其工作自主性和創新性,引發行政避責和不作為現象。智能監督系統傾向於增強高層政府和官員的控制力,導致縱向政府間權責失衡,甚至激化中央與地方的緊張關係。其二,智能技術驅動的政治問責目前尚缺乏明確的合規框架,容易遭受技術操控或濫用。惡意行動者可能利用人工智能系統的隱秘規則和技術漏洞,逃避監督、對抗審查或進行虛假指控。例如,運用生成式人工智能編造針對特定對象的虛假指控材料,包括圖片、錄音和視頻等,擾亂或誤導正常問責程序。其三,政治敏感數據通常難以獲取和流通,使得模型訓練所需的字段、維度和參數缺失,嚴重影響智能問責系統的實用性能。同時,人工智能系統對新型犯罪或無數字痕跡的腐敗行為缺乏識別和預警能力,容易導致官員監督的失準或失察。此外,當受影響的官員和部門就問責結果提出異議時,技術黑箱亦缺乏可解釋性和説服力,進而削弱智能問責系統的權威性和公信力。

新興人工智能政治影響的治理路徑

新興人工智能將對當代政治產生深遠且複雜的影響,儘管智能技術在政治領域呈現廣闊的應用前景,但同時也孕育着多重技術風險和社會挑戰。這些風險一方面源於其本身的技術特性,另一方面則是人機互動的結果。從“智能技術”到特定“政治後果”並非因果必然,其間受到諸多條件因素如政治環境、應用場景和治理策略等的影響。政治場景相較商業場景更具敏感性和衝突性,技術風險極易擴散為政治風險,對國家統治、政民關係和社會穩定造成衝擊。面對人工智能驅動的政治未來(AI-driven political future),本文運用“主體—路徑”的分析框架,從開發者、使用者、監管者三類主體出發,探討如何通過“技術路徑”(即針對技術特性)和“關係路徑”(即針對人機關係)開展對智能技術之政治影響的治理,推動人工智能在政治領域向善、為善和守善。

(一)開發者

從技術特性入手,開發者在設計政務智能系統時,需重視訓練數據的平衡性和多樣性,並通過特徵選擇、參數調整和評估指標優化,不斷提升模型準確性、公平性和安全性。開發者還應提升人工智能系統的透明度和可解釋性,通過公開技術文檔、代碼架構及召開產品説明會等方式,讓公眾瞭解模型的工作原理。同時,開發者須升級技術手段,識別並阻斷傷害性指令和存在政治操弄的 API 請求。例如,OpenAI 在 GPT 系列產品中引入了政治性議題和傷害性指令的攔截功能,並終止為具有明顯意識形態傾向的人工智能系統提供 API 服務。面對技術風險,開發者可設立內部倫理審查委員會,或與外部研究者及專家團隊合作,研究和審計人工智能工具的政治社會影響,並進行前置性的技術干預。開發者社羣亦可依託行業規則或最佳行動指南實施同業監督。例如,2023年7月,多家頭部人工智能公司——包括亞馬遜、谷歌、Meta、微軟和 OpenAI——向美國政府作出自願承諾(voluntary commitments),共同推動智能技術的安全、透明、可信。

從人機關係入手,開發者應在交互界面的顯著位置提供風險提示和使用引導,告知用户相關技術的侷限性。例如,ChatGPT 會在輸入框附近註明“ChatGPT 可能會犯錯,請核實重要信息”。**平台公司需要建立社會參與和反饋機制,鼓勵用户反映異議和體驗,參與人工智能工具的共創過程。**例如,谷歌公司收集用户報告的不良內容、不準確推薦、違規使用等問題,用於改進推薦算法和內容過濾系統。開發者亦需針對特殊政治應用場景制定詳盡的約束政策和使用規範,預防重大政治風險。例如,面對 2024 年美國大選,OpenAI 公司於 2024 年 1 月出台了專項政策,防範其生成式人工智能技術在政治選舉中被濫用。相關做法包括 DALL·E 系統和 Sora 系統拒絕生成候選人圖片和視頻、為記者和研究者提供識別工具等。同年 2 月,20 家科技巨頭在慕尼黑安全會議上籤署協議,宣佈共同致力於阻止人工智能生成的虛假內容干預全球各地的選舉。

(資料圖片:對話Open AI)

(二)使用者

從技術特性入手,使用者(尤其是公共部門使用者)需提升人工智能素養(AI literacy),瞭解所使用人工智能系統的工作原理、數據來源、內容生成機制、決策流程及其侷限性,學會辨識人工智能生成內容,尤其是政治場域的虛假信息或計算宣傳。在使用人工智能工具時,須審慎評估其輸出結果的準確性和合理性,並考量其應用場景和作用對象。政府部門在引入人工智能系統時,應提供技術培訓並制定行為準則,讓使用者熟知產品性能及相關技術風險,並遵循透明程序和合規操作。例如,美國波士頓、西雅圖等城市要求公務人員披露在內容創建工作中使用人工智能工具的情況,並核實生成內容的準確性。

**從人機關係入手,公共部門使用者需區分智能技術在不同政策場景中實現自動決策或輔助決策的適用範圍,明確哪些領域可交託人工智能、哪些需人機協作、哪些暫緩智能轉型。鑑於政務場景的敏感性,應確立“以人為中心”(human-centered)的應用原則和合規機制。**對實施智能轉型的業務領域,需引入人工智能影響力評估框架和算法審計程序,定期評估其公平、安全與可控,必要時啓動停用或退出程序。作為普通用户,可參與反饋系統和在線論壇,報告虛假信息、功能濫用和系統漏洞,就產品功能、數據使用、隱私保護等提出用户意見,幫助開發者和監管者識別潛在風險,督促平台公司打造“負責任的人工智能”。例如,Meta 公司基於用户反饋啓動了標記機制,可對多家人工智能平台生成的圖片進行水印標記,幫助用户識別數字生成內容。普通用户還可通過社會倡議活動、公民訴訟、公共協商和立法參與等方式介入相關治理進程,藉助集體行動和輿論壓力促使人工智能公司更加重視用户權益和社會責任。

(三)監管者

從技術特性入手,監管者(包括行政部門和立法機構)可運用政策工具和法律手段,定期開展算法審計、部門約談、專項督察或議會聽證等,要求政治領域的人工智能系統提升數據平衡性和算法透明度。監管者還可效仿上市公司信息披露制度,推動重點領域人工智能政治風險的信息披露,讓社會了解人工智能系統的技術特性、應用方式及風險防範措施,嚴防算法對特定羣體或政治立場產生偏見和壓制。例如,加拿大 2023 年頒佈的《人工智能與數據法案》要求企業在人工智能設計、開發、應用的全生命週期中採取技術措施,確保高風險人工智能系統的安全性、非歧視性和可解釋性。監管機構可要求政務人工智能應用必須經過算法審計和風險評估,設立倫理審查委員會監督其技術合規性,並限制人工智能工具在特殊領域的運用。例如,歐盟《人工智能法案》將人工智能劃分為“禁止類”“高風險系統”和“其他系統”三類,對不同風險等級的人工智能系統施加差異化的監管要求,並規定高風險系統必須接受政府審查。

從人機關係入手,監管者需規範政治領域的人工智能使用行為,打擊虛假信息、計算宣傳、影響力操弄等技術濫用,並針對選舉、遊説、社會評分、國家安全等特殊政治場景制定詳細監管細則。例如,美國的密歇根、明尼蘇達、得克薩斯等州通過立法,要求政黨和候選人披露競選中的人工智能工具使用行為,並禁止在選前使用深度偽造技術攻擊對手或欺騙選民。歐盟亦禁止使用人工智能進行選舉干預和社會評分。監管機構還可創建公眾參與機制,邀請學界、倡議團體、行業組織和社會組織等利益相關方參與人工智能監管的公共辯論和民主協商。監管機構應建立有效的投訴處理和矯正機制,響應與人工智能相關的公民申訴並提供法律救濟。鑑於技術影響的外部性,監管機構還需加強與其他國家及國家組織的合作,參與制定國際標準和運用規範,促進全球人工智能治理。例如,中國於 2023 年發起《全球人工智能治理倡議》(Global AI Governance Initiative),呼籲聯合國框架下的國際人工智能治理合作,預防和打擊恐怖組織、極端勢力和跨國犯罪集團對人工智能技術的濫用。世界經濟論壇也組建了全球人工智能治理聯盟(AI Governance Alliance),匯聚了各國政府、商業領袖、學術機構和社會組織等力量,共同推動負責任、包容性的人工智能系統。

誠然,無論是各國國內層面還是國際層面,如何開展政治領域人工智能治理目前尚充滿爭議。雖然監管已成大勢所趨,但國家、政黨、利益集團、平台公司、社會團體和科研機構對人工智能的認知並非同頻,加之政治立場和商業利益的驅使,各方在具體治理策略和監管細則上仍處在激烈博弈當中。例如,美國多數州有關人工智能運用於選舉的監管立法至今未獲通過;全球範圍內“數字柏林牆”亦日益高築。哪些方面需被監管、如何監管以及由誰來監管,本身即是一個政治問題,其中涉及權力與權利、公平與效率、發展與安全之間的價值權衡,國家與社會、政府與市場、中央與地方之間的關係變革,甚至關涉國家主權與大國競爭,極易受到政治意識形態的拉鋸和牽制,這就需要更高階的政治智慧和制度創新予以應對。因此,深度智能(deep intelligence)呼喚深度民主(deep democracy)。