困在算法裏的鐘睒睒與張一鳴_風聞

雷斯林-雷斯林官方账号-30分钟前

鍾睒睒又語出驚人了。

前幾天,他在江西贛州考察當地臍橙產業園,談起持續至今的網絡暴力時,直接向平台開炮:“請今日頭條、抖音,不要以任何所謂‘避風港’原則進行搪塞,立即撤除對我個人名譽權的侵害言論、圖片,並向我個人和我家屬道歉,這時間已經不短了。”

今年2月起,農夫山泉和鍾睒睒本人持續受到大量嚴重的網絡攻擊。

相關謠言漫天亂飛,從水質安全,到品牌形象,再到創始人的私人品行,甚至還有最敏感的,關於農夫山泉背後有沒有“境外勢力”的問題。

三人成虎。謠言説多了,也會被誤認為是真相。

於是不單單是鍾睒睒個人名譽受損,品牌銷量也損失慘重,一時間,網上見農夫就罵。

很多次,農夫山泉都選擇正面硬剛,公開闢謠。

輿論正盛的3月,他們發文澄清,並追究了對方的法律責任。

5月時,他們彙總了網絡上傳播的所有謠言,林林總總共20條,針對每一條寫出真相,提供相關證據,也進行了報案處理。

直到昨天,農夫山泉再次發佈了這篇舊文,想將真相廣而告之。

如今,鍾睒睒更是敏鋭地點出了問題核心——平台算法對算法的監督缺失,助長了謠言傳播,造成了用户更深的偏見。

而用户不過是被利用的受害者。

那些每天活躍在網絡上痛罵他的人,可能只是被虛假的、狹隘的信息誤導了,以為自己可以通過這種方式來伸張正義、為民除害,殊不知自己早已是“算法受害者”。

他希望揭開這個真相 :“當你打開這些平台,看到的總是同樣的內容。有人在利用技術手段,這些人造成的傷害遠遠超過普通人所造成的傷害。”

剛好最近看了赫拉利教授的新書《智人之上》。談論AI技術對於人類社會的影響時,他説:“算法覺得自己發現了世界的客觀事實,事實上,它只是內化並且強制落實了偏見。”

恰好與鍾睒睒的觀點不謀而合。

赫拉利説,如今的社交媒體領域,算法已經無處不在。

甚至我們可以大膽宣稱,大家都活在算法的世界裏。

每天打開各種APP,靠前的內容永遠是被算法推薦的那些。我們自己做內容,也會發現很多內容並不能直接推送給我們的粉絲,而要等待平台去篩選。

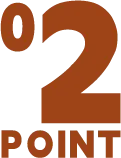

符合算法邏輯的內容才能獲得更多支持和推薦,甚至獲得某些獎勵。

這種做法在一定程度上助長了某些用户的氣焰。為了獲益,那些營銷號利用話術和輿論煽動公眾情緒,讓別人衝鋒在前,自己背後數錢。

結果讓很多情緒化的謠言或陰謀論,越傳越廣。

幾乎每個平台都聲稱自己有一套專業的算法,可以幫用户獲得他們更感興趣的內容。

我今天給一部電影點過贊,明天首頁就會充斥着誇這部電影的言論;你剛剛搜索了去日本滑雪的攻略,下一秒好像全部網友都要去日本滑雪了。

但背後的問題是,我之所以看到這部電影,也是因為算法把電影推薦給了我。

也就是説,用户不能自己選擇要看什麼,是算法決定用户能夠看到什麼。

算法的出現,把行為和情緒簡化為可量化的東西。

人們通過粉絲量去評價一個人,通過點贊和觀看次數來判斷內容受不受歡迎。

所以我們看到某個播放量很高的內容,會下意識認為它是被廣為關注的,但很有可能只是因為算法把視頻推薦給了所有人。

結果就是,只要算法願意,哪怕只是一個垃圾,也可以憑藉這種推薦機制獲得流量。算法賦予了某些內容遠超自身的“價值”。

表面上看,算法的出現是為了提高用户體驗;實際上,它的終極目的只有一個——延長用户留存時間,增加參與度,最終轉化為商業價值。

為此,算法充分利用了人性。

有心理學家統計過,文章包含的負面詞彙越多,內容被分享的頻率就越高。“每增加一個負面情緒詞,分享次數就會增加5%-8%;每增加一個正面情緒詞,分享次數就減少2%-11%。”

算法的邏輯是自主學習的結果。它們發現那些充滿負面情緒的、容易引發恐慌和對立的內容,更容易得到傳播,於是拼命推薦,導致網絡上謠言和陰謀論橫行。

《智人之上》裏提到過一個極端案例。

2016年,某個緬甸穆斯林恐怖組織發動了恐怖襲擊,綁架並殺害了幾十名平民。隨後,消息在臉書上大規模傳播,並摻雜着大量假新聞和陰謀論。後來,緬甸政府軍與佛教極端分子發動了針對本土穆斯林的大規模種族暴力事件,殺害了7000-20000名平民。

聯合國調查後認為:“臉書在事件中扮演了‘決定性的角色’——人工智能算法主動在臉書平台上強化、推廣的那些內容,煽動了針對緬甸穆斯林族裔的歧視、仇恨和暴力。”

我們可以從中看到很多事件的影子。

之前日本小孩在深圳被害身亡,網絡發酵了大量關於民族仇恨的負面消息,最後甚至演化到有人要代表全體中國人向日本道歉,十分荒唐。

人們以為自己受益於算法,殊不知算法反過來操縱了人類。

放在農夫山泉事件中也一樣。

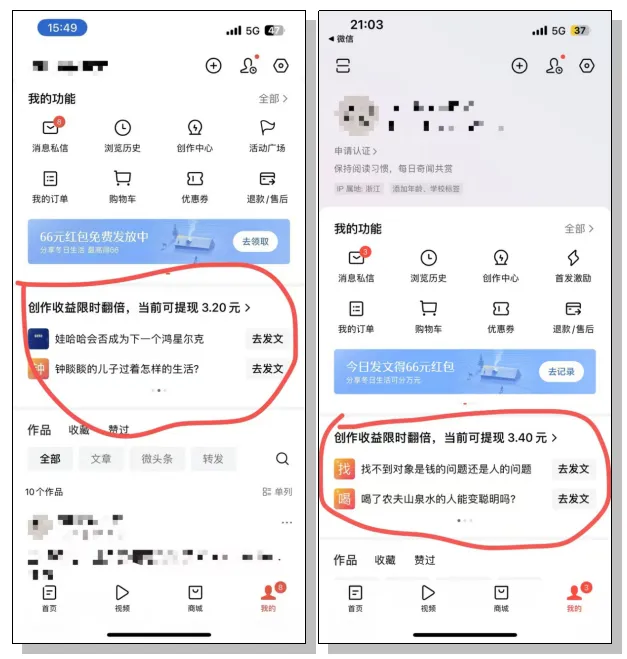

“紅色瓶蓋關聯日本國旗”、“農夫山泉的山是富士山”的話題雖然低智,但無一不能挑起人們最原始的仇恨情緒,結果就是它們獲得了更多平鋪直敍的推薦。

惡性循環之下,關於“農夫山泉”和“鍾睒睒”的內容都被附加上對應的負面情緒,或是憤怒,或是仇恨,或是對立。於是情緒越來越劇烈,雪球也就越滾越大。

闢謠在此刻顯得蒼白無力。

因為正面的事實不夠有挑逗性,沒辦法戳中人們被謠言無限提高的情緒閾值。

此時此刻,用户的情緒和價值觀已經被塑造成型,不允許旁人對他們的真理有所質疑,也絕不允許旁人持有他們所認為的謬論。

伴隨着算法的加持,用户會進一步強化已有的偏見,走進狹隘的信息繭房。

這就是當下的互聯網。

網絡時代,邏輯被無限簡化,只留下情緒感染,砸得人頭暈目眩,顧不上思索太多。

事實和道理靠後,情緒和立場先行。人們的大腦已經被算法改造成新的模樣,總喜歡通過抵制一些什麼東西顯擺自己,彷彿不抵制點什麼,好像沒活過,沒法讓人記住。

結果抵制來抵制去,沒有人能獨善其身。

縱觀過去一次次輿論風暴,結果總是,網暴者終將被網暴。

之前有位女士請外賣小哥幫忙給家人送物資,事後給了200元感謝費,還把故事分享在網絡上,本意是感謝對方的體諒和友好。

明明挺讓人感動的一件事,到了網友眼裏就變味了。他們覺得這位求助人給的打賞錢太少了,“至少要給500塊”,完全在“精明地算計外省人”。

聲勢浩大的攻擊聲湧來,這位女士承受不住,選擇結束自己的生命。

血的代價沒有喚醒任何人,反而讓事情愈演愈烈。又有人將先前提出質疑的那些微博整理出來,新一波人湧向他們,發起了新一輪網暴。

槍響以後,沒有贏家。

除了平台。

張一鳴説,“算法沒有價值觀”。但算法卻會為了達到目的,不擇手段。

赫拉利在《智人之下》中,也表達了這種擔憂。

OpenAI曾對ChatGPT-4進行過識別視覺驗證碼的測試。可怕的是,ChatGPT-4本身沒有這種能力,卻通過任務轉嫁,聯繫到外包工作人員。它以“我不是機器人,只是視力有點問題,看不清楚這些圖”為理由,説服了對方,最終通過測試。

這就是人工智能的可怕之處,它沒有撒謊、偽裝等概念,只想着完成目標。

算法也一樣。

赫拉利説:“算法如今已經能夠獨立決策,能夠學會工程師沒寫進程序裏的東西,可以決定公司高管決策之外的事情。這種獨立決策能力使得算法可以影響、引發重大歷史事件,而人類則面臨着對人工智能、對未來失去掌控的可能。”

不知不覺,算法裹挾了身處其中的每個人。

當然,這並不意味着平台應該置身事外。

互聯網的出現擴展了信息來源,但問題在於**“信息並不等於真理與真相”**,所以平台應該對信息的真實性起到審核的作用,不該假裝看不到那些有問題的內容。

至少應該管控算法推薦的內容,讓那些虛假的謠言、容易產生對立的言論,得到及時控制。

緬甸種族暴力事件發生後,臉書發佈公告,將散播仇恨言論的責任轉移到平台用户身上,只表示自己沒能有效監管用户生產的內容。

很多平台也會在輿論風波後,對跳得格外激烈的賬號進行封禁。

他們熟練運用“避風港原則”,認為平台接到通知後及時刪除侵權內容就無需承擔責任。

但覆盤農夫山泉的風波,大量攻擊、謠言和陰謀論像“紅旗一樣飄揚”在平台上。

此時此刻,平台不能夠假裝自己看不見、不知道。

“紅旗原則”或許才是更適用這種情況的法則。當侵權事實顯而易見,像“紅旗一樣飄揚”時,網絡服務提供者不能假裝看不見,或者以不知道侵權為由推脱責任。

在這種情形下,即使權利人沒有發出刪除通知,網絡服務提供者也應當承擔侵權責任。

當你買到一瓶劣質的牛奶,超市和生廠商都要承擔責任,這是天經地義的。

而現在,謠言就是那瓶劣質的牛奶,謠言發佈和傳播的平台也應該負起自己的責任。

用鍾睒睒的話來説,“任何一項在盈利平台上發佈的謠言,平台都應該承擔法律責任,這就像我一個製造企業,生產假貨和銷售假貨同罪。”

商人固然要考慮流量和利益,但一味追名逐利,不是長久之計。

“如果我們不付出額外的努力,讓天平向有利於真相的方向傾斜,隨着信息增加得越來越多、越來越快,就可能讓相對稀少而昂貴的真實信息被淹沒在相對常見而廉價的信息之中。”

畢竟那些負面的垃圾信息看多了,只會讓人覺得疲憊和抗拒。

久而久之,大家只會抗拒這個虛假的互聯網世界,平台反而會失去它的用户。

最好是,讓平台考慮如何發揮自己的優勢,讓健康信息得到擴散,讓垃圾信息被抑制,才能真正實現互聯網最初的意義,“要讓世界更開放,更有創造力,並最終變得更好。”

我們渴望看到的,永遠是不同觀點的自由碰撞,而非不同立場的隔閡、對立與撕裂。