人工智能,潛力很大,但是卡住了我猜是需要動態神經網絡結構_風聞

陈经-亚洲视觉科技研发总监-38分钟前

1. 現在人工智能其實已經熱度下去了一些,蘋果市值超過英偉達。原因是大模型這條路,在“往大里做”這個方向,應該到頭了。Scaling law總會到頭,這不奇怪,GPT-5出不來,就是最大的跡象。就好像人類腦容量,上古時期有一個不斷擴大的階段,但是很久以前就不再擴大了,不是越大越好。

2. 從樂觀的方面説,人類腦容量穩定後,還是越來越聰明。所以,AI還會有大發展,內部結構精細化,訓練方法改進,走向AGI通用人工智能,超過人類很有希望的。許多AI大佬是這個態度了,奧特曼説2025年就幹出來,有的大佬説要5年算悲觀。

3. 還有一個普遍的觀點,爆火的Transfomer架構,應該幹不出AGI,需要想別的絕妙的神經網絡結構。所以,現在人工智能大趨勢,已經從“堆積算力”轉向了“神奇結構”。很多學者在積極想各種結構,算力也很厲害了,得益於過去幾年的瘋狂突擊,人工智能基礎研究的條件是好多了。有什麼新想法,算力足夠就能很快實驗出結果。

4. 不過感覺美國那邊還是有點瘋,氣氛就是突擊AGI,似乎聖盃近在眼前。我感覺不是換個神奇神經網絡結構的事,而是整個神經網絡研究的框架,都還是“模擬”人類智能,這一點不變,應該搞不出來。

5. 什麼叫模擬智能?就是説,海量樣本輸入在大的神經網絡裏跑,看輸出不對,就回頭調整海量係數。最後,樣本輸出讓人類研發者滿意了,模擬結果就很像回事了。這出來的都是模擬智能,AI不知道為什麼對,逼的。所有的神經網絡架構創新,都還是這個方向的,最大招就是“back propagation”,BP算法,反向傳輸,修改係數。

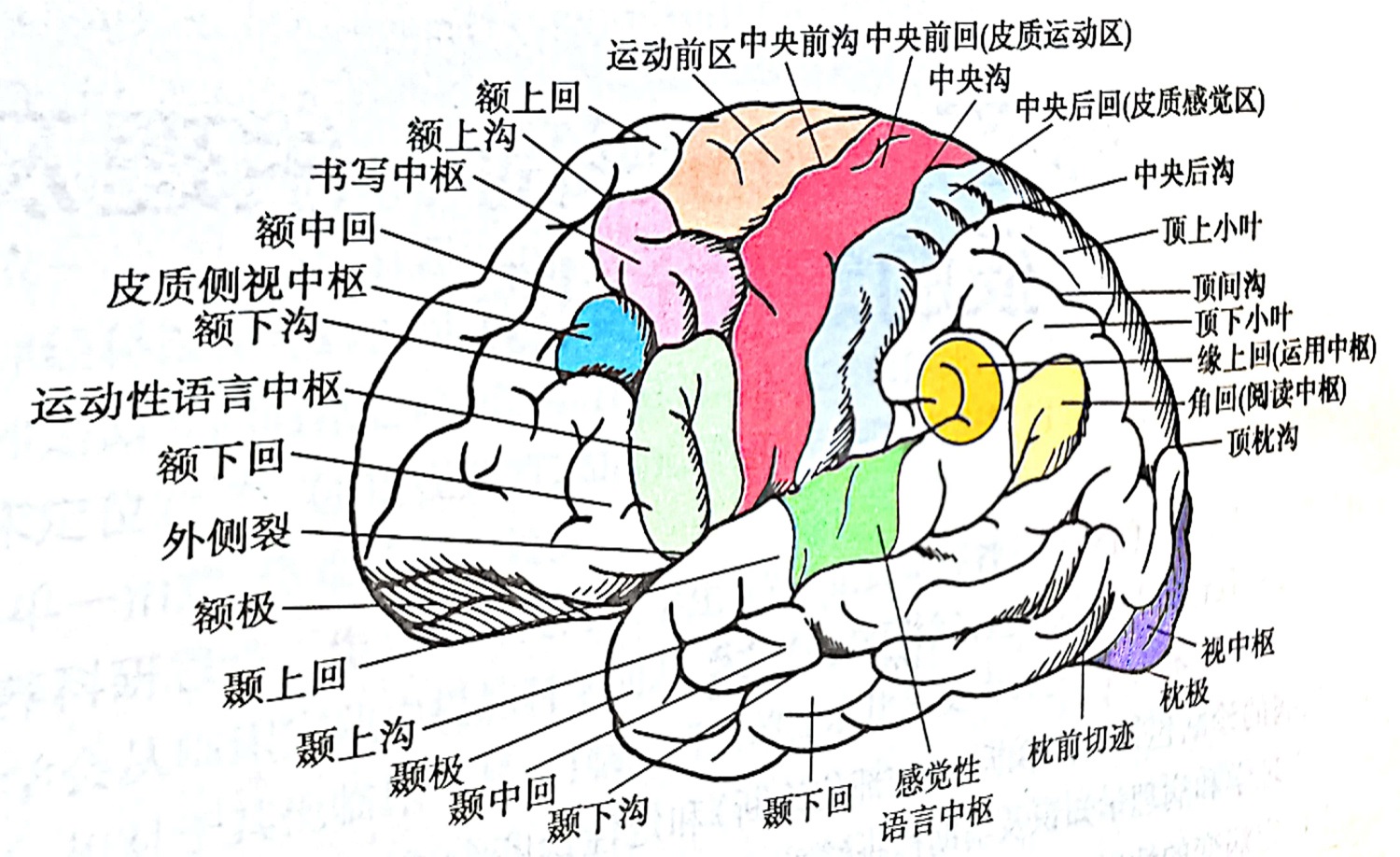

6. 有點類似於小孩被迫背誦古文、九九乘法表,背不出來就打板子繼續重複,最後就會了。小孩吟詩、做乘法,都挺像回事。但是,小孩的學習機制可不是什麼BP算法,而是修改了腦子裏的突觸連接狀態!也就是連神經網絡的微細結構都變了!

7. 一個很有意思的細節,能説明小孩的學習辦法。我們都把小時候的事忘了!為什麼?這有物理背景,2-3歲的時候其實記得不少事,但是之後腦子神經網絡連接先是極大豐富,又進入了一個減少連接優化結構的過程。等腦子連接結構大調整穩下來,小孩子基本什麼事都不記得了,倖存下來的記憶很少。之後才能穩定記住一些事,但是腦子神經元連接也還是動態的,會遺忘,會頓悟式學習生成新連接。8. 所以,突破應該需要動態的神經網絡結構。很複雜,機理研究還很早期。現在是靜態的神經網絡結構,係數在變,結構不變。這個靜態結構模擬智能很像回事,但其實“基礎能力”很差,沒有成長性。把整個互聯網的數據去先訓練,還是不會推理,都是假裝會,原理不懂。