“算力為王”被狠狠重擊,開源勝閉源,背後的原理是什麼?_風聞

陈经-亚洲视觉科技研发总监-1小时前

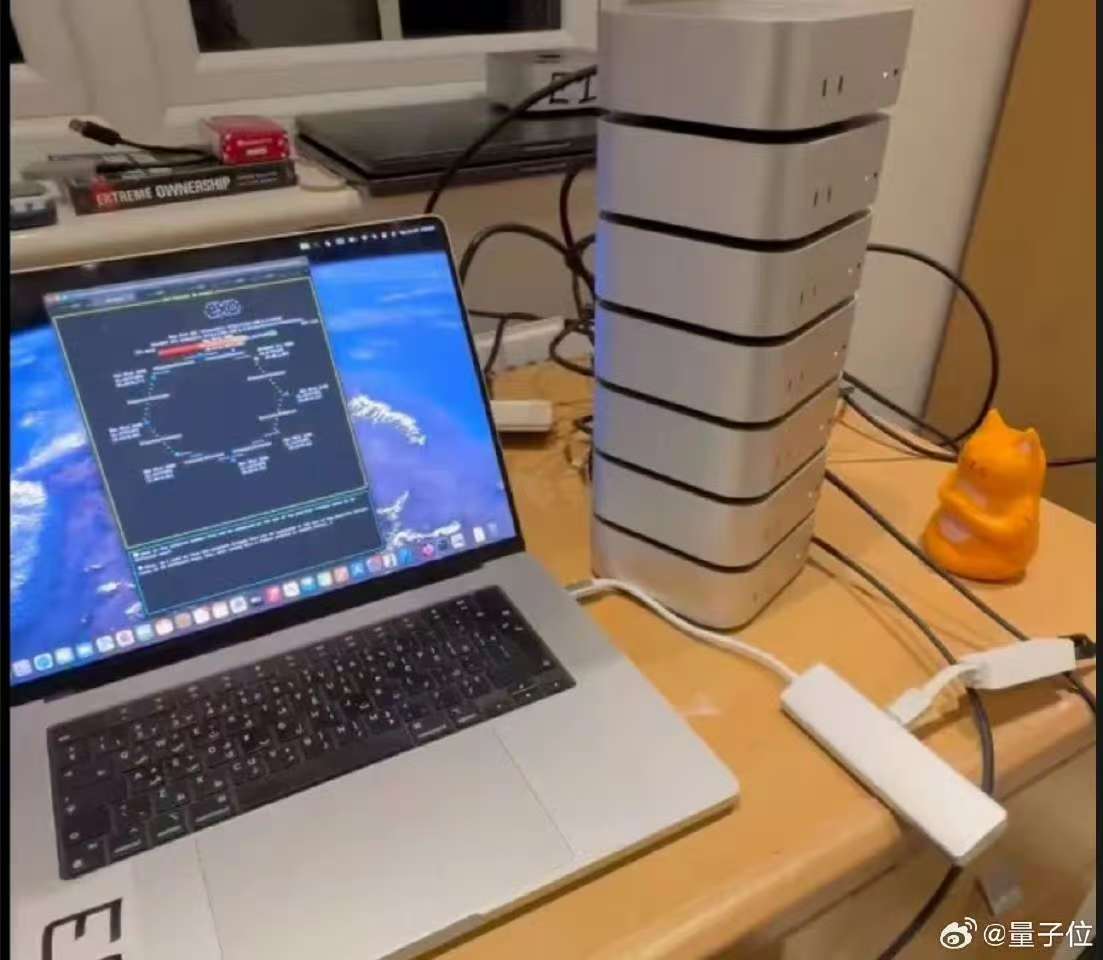

1. 最近deepseek r1震驚業內,用OpenAI幾十分之一的開發代價,和幾十分之一的使用成本,性能趕超了。外國一個土豪甚至自己買點機器,就搭建跑起了deepseek開源大模型。

2. deepseek能羞辱OpenAI,靠的是想辦法優化基礎模型、訓練方法,而不是堆積算力。這是一個業界幾乎所有人都希望看到的進展,除了不開源想搞壟斷的幾個美國巨頭。

3. 原理是,大模型訓練的“數據”,文本意義上大約幾萬G的數據,就這麼多“原始數據”了,這是公開的,沒法壟斷的。幾乎所有的人類知識都在裏面,全球聰明的研發者都在想辦法,訓練出表現優秀的大模型。而評估的測試集也是公開的,各類測試集,分數如何一清二楚。也就是説,有一個公平公正公開的研發平台,各國企業在展示自己的能力。

4. OpenAI説有絕活,能做到什麼,但是不告訴別人細節,違背了業界的分享傳統。而deepseek直接開源,把細節説的非常清楚,大家就明白了,原來沒什麼絕活,都是可以理解的。而且中國公司的辦法還更漂亮、更經濟、更可信,更易應用推廣。

5. 從根本上來説,這是一個計算機算法問題,怎麼組織數據結構、怎麼搭建訓練平台,怎麼分階段訓練。由於數據非常多,步驟也很多,以Transformer為基礎的上萬億個係數,在做無數卷積、矩陣等向量張量運算,很多都是重複的。如原始的大模型,一個token就可能引發所有GPU在算矩陣乘法。這裏有巨大的優化空間。

6. 如混合專家模型,就是幾個通用專家,帶很多領域小專家,而不是原來的一個大專家。領域問題來了,就通用專家與合適的小專家去跑,只需要幾十分之一的GPU跑就行了。這類優化方法還有很多,如8個比特表示一個浮點數,不需要16個比特,加快計算。效果就是,大算力並不是必須的。“笨辦法+大算力”,還不如“好辦法+小算力”,這是deepseek已經證明的。不少美國公司閉源的還不如中國開源的,等於研發失敗了。

7. 那“好辦法+大算力”是不是就最好?錯!研發問題還需要考慮成本,能用低成本幹出來的,非要用代價極高的大算力去做,也是研發失敗。例如市場競爭,Open的大模型使用費是100萬個token要50美元,deepseek同樣效果只要2美元,怎麼玩?

8. 除非大算力實現了ASI,做出中國公司做不到的東西。美國就是在賭這個,卡算力。但是中國算力也不是很少,幾十分之一算力規模總有。這種海量數據、海量時間的運算問題,想一些優化效率的辦法,算力差距就沒有問題了。不太可能正好是20萬個GPU做得出來,1萬個GPU做不出。實際很可能是,20萬個GPU做出來了,1萬個GPU的看看輸出,想點優化辦法,很快也做出來了。如果優化做的好,也許1萬個GPU的還先做出來,因為ASI最終肯定是需要算法突破,而不是堆算力。