AI換臉,已經不要臉了_風聞

视觉志-视觉志官方账号-你陪着我的时候,我没羡慕过任何人22分钟前

作者 | 小魚

來源 | 視覺志

鑽AI漏洞的人,很可能已經把手伸向了你身邊的人。

AI短視頻,比想象中來得還要更猛烈。

造假的AI視頻越來越多,這些視頻在互聯網的浪潮中隨着算法被推送到眼前,它們就像餐飲行業的“科技與狠活”,看上去色香味俱全,與餐廳老闆的手作大餐無異。

吃多了,才發現對健康有害。

曾經,年輕一代的父母們剛剛接受信息時代的洗禮,被各類假新聞騙得團團轉,而這一次,輪到年輕人了。

他們,陷入謠言裏

一張照片、一段視頻,你的“數字分身”就可能在AI的加持下,活在互聯網的某個角落,你卻渾然不知。

自帶光環的明星,是第一批受害者。

以上“楊冪熱舞”的視頻,就是通過AI換臉製成。近些年,楊冪深陷無數謠言,被篡改的視頻不計其數……

只因明星曝光度高,素材遍地都是,他們的形象被惡意利用,往往連澄清都來不及。

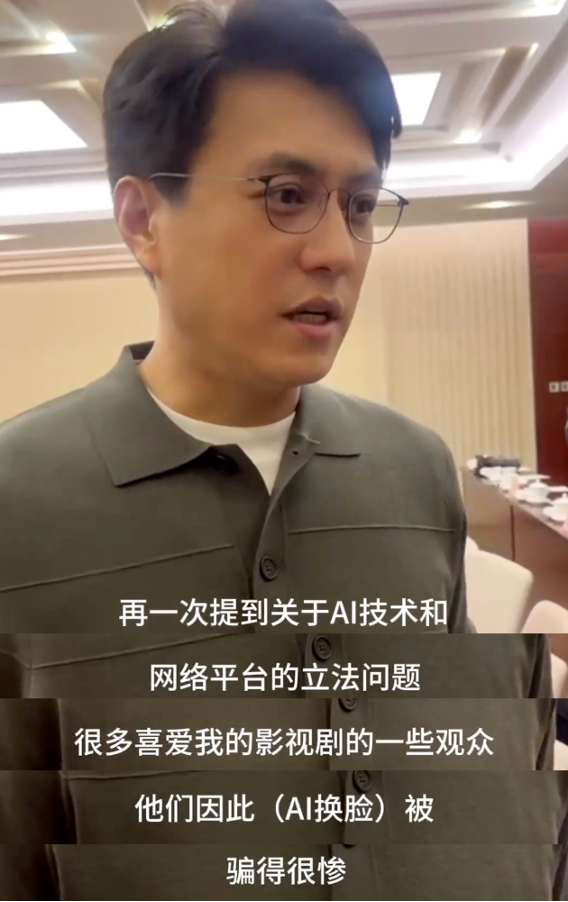

靳東這張臉,就被拿來欺騙了太多中老年人。

前幾年,“假靳東”的視頻在網上沸沸揚揚,那時的AI技術尚未成熟,多半是正臉視頻和聲音合成,隔着屏幕互動時,能讓人隱約感到違和感。

圖源:視頻截圖

但就是這樣簡單的互動,成了攻陷老年用户的糖衣炮彈,顆顆打在了老年人的心坎裏。

視頻裏,“假靳東”一口一個“姐姐”“想你”,讓老年人相信屏幕前的人就是聞名全國的明星靳東。熟悉後,騙子會要求老年人進行轉賬、線下見面等,從中獲利。

某位68歲的老人,受到視頻的蠱惑後,把自己每天清理街道、撿垃圾的錢,全部用於視頻打榜,在家人發現後仍沉迷其中,不敢相信自己深陷騙局。

圖源:視頻截圖

某位61歲的老人,在接到騙子的私信後,以自己要拍戲籌款為由,要求老人向自己轉賬200萬,老人在辦理貸款時及時被發現,才阻止了悲劇的發生。

圖源:江南都市報

如今,隨着AI技術的迭代,“假靳東”也跟着“進化”了。

他的動作更流暢,聲音模擬更生動,視頻看上去也更加真實。

受眾也從老年人,擴大到更多人羣。

發佈一個“撞臉明星”的互動視頻,就能收穫上萬點贊,殊不知,所謂的撞臉不過是拿着明星的視頻一鍵換臉。

前幾日,明星靳東再次發聲:“一些喜歡我影視劇的觀眾,被AI換臉視頻騙得很慘,這個性質非常惡劣。”

噱頭和流量事小,但有人利用明星的口碑,給某些三無藥品、保健品打廣告,就不再是小事了。

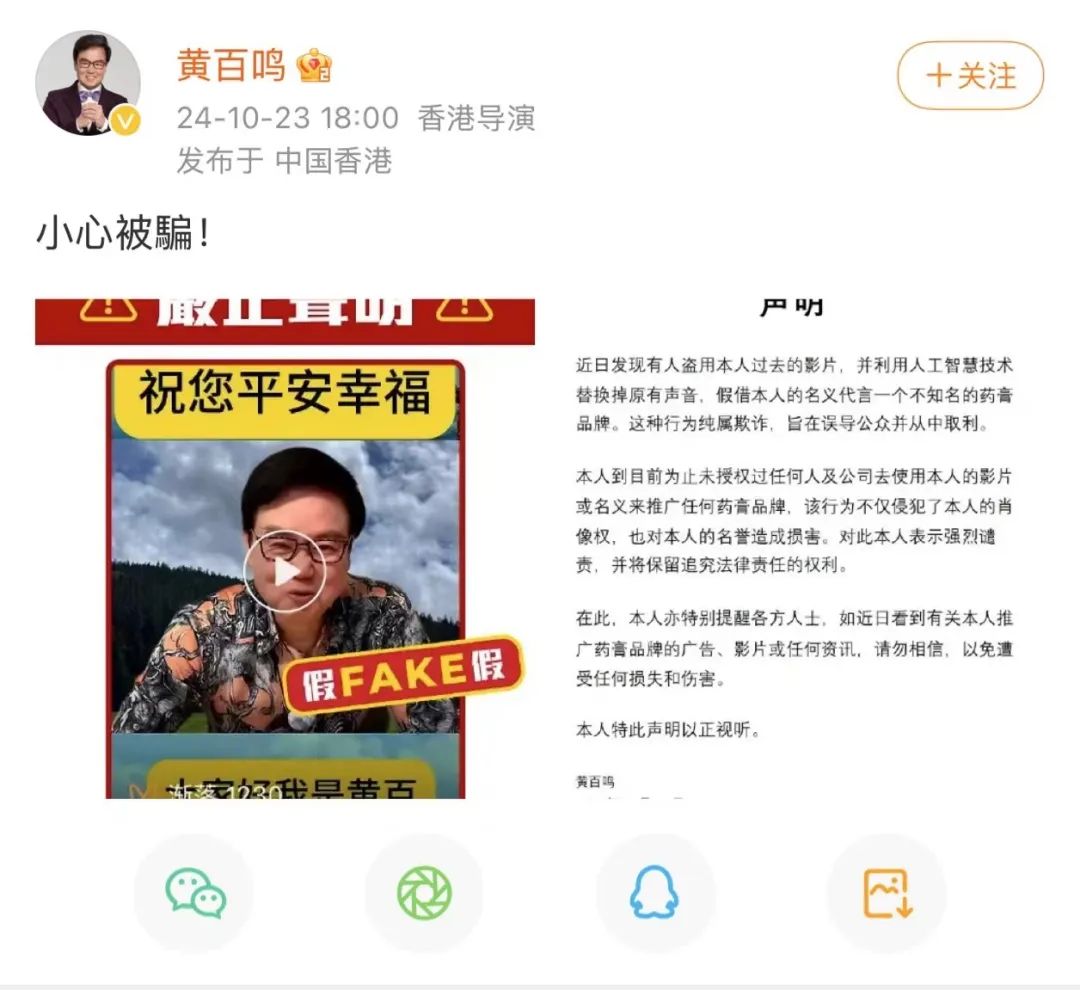

香港明星黃百鳴,前段時間緊急發佈聲明,稱自己從未代言某藥膏產品。

有人將他在電影中的某段對白,替換成了一款藥膏的廣告詞,黃百鳴對着視頻前大誇藥膏的效果,從未看過原版電影的人,輕易就能信以為真。

圖源:黃百鳴微博

因為信任明星的口碑,通過“假視頻”購買到山寨、低質商品,類似事件層出不窮。

劉曉慶曾經參加了《一路繁華》的綜藝節目,有人將她在飯桌上吃魚的片段,植入了一款減肥產品,並模擬劉曉慶的聲音加入幾句話,如“提高代謝水平”“年輕人可以試試”,因為相信“慶姐”的推薦,不少人買回家嘗試該減肥產品。

試用後,才發現不僅毫無效果,退貨也難上加難。但沒效果已經是最好的結果了,畢竟,誰也不能保證這些來路不明的藥品,會不會對身體產生副作用。

還有人通過AI換臉,打着劉曉慶的名義,發佈了大量視頻。劉曉慶發現後當即發微博提示粉絲:“我在各個平台都叫劉曉慶!”

圖源:劉曉慶微博

除了保健品,遊戲等娛樂產品的廣告,也被大量作假。

古天樂發現自己“被代言”了某款遊戲,然而宣傳視頻用古天樂的面部合成,讓人真假難辨。

不明真相的人下載遊戲、充值氪金,部分遊戲可能還涉及“病毒”“詐騙”等危險手段,到最後才發現偶像古天樂從未代言該遊戲。

直播帶貨,更是“假明星主播”的重災區。

有粉絲刷到自己的偶像飛輪海成員辰亦儒在直播間帶貨,他面前擺滿滷味食品,他本人則戴着塑料手套大快朵頤,時不時豎起大拇指比出點讚的姿勢。

仔細觀察就能發現,“辰亦儒”頭頂上方還有一行小字:僅效果展示,非真人。他的小臂也被桌子穿過,更重要的是,“辰亦儒”每天坐在桌子前,一吃就是15個小時。

這樣的帶貨直播間,通過會利用AI製作一段視頻並循環播放,一勞永逸,既不用花錢請明星帶貨,還能讓明星老老實實坐在直播間超長待機。

許多服飾品牌,也是如此。

著名女星楊冪、迪麗熱巴,都被使用換臉技術在直播間帶貨,更有甚至,利用楊冪的明星效應,去帶貨“減肥茶”等產品,極有可能危害身體健康。

這下,山寨明星遍地,明星律師函滿天飛。

叫苦的只有網上的吃瓜羣眾,難辨真假,在“冒牌貨”光環的加持下,買到一堆“冒牌貨”。

這個時代,只要動動手指,就能讓一個陷入謠言裏。

哪怕,這些人是明星。

AI,正在降維打擊老年人

明星擁有大量資源,能輕易拿起法律武器保護自己,但不法分子的魔爪一旦伸向老年人,就是精準的降維打擊。

盯上的,往往是老人攢了一生的“錢袋子”。

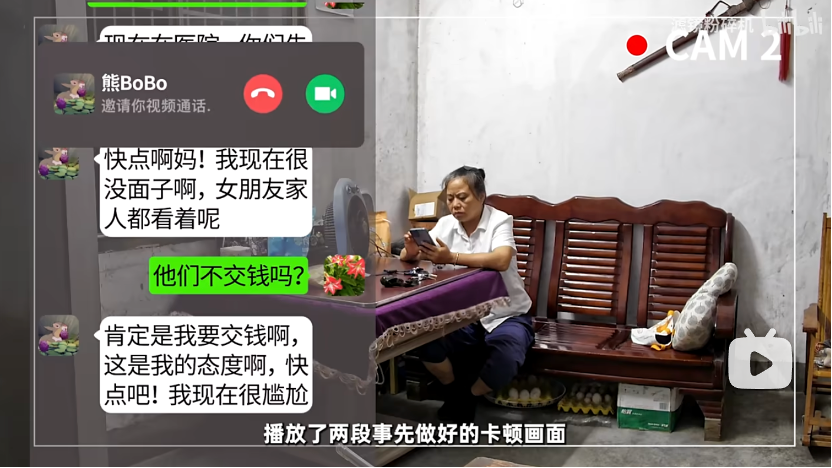

自媒體博主 @濾鏡粉碎機,利用AI視頻合成技術,測試了自己53歲的母親會不會因為騙術“中招”。

他給母親發微信,稱女朋友懷孕,現在需要2萬元進行檢查和治療。隨後給母親撥打視頻電話,並播放提前製作好的視頻——通過人像和聲音後期製作而成。

圖源:@濾鏡粉碎機

母親先是高興,發消息説“婚事借錢也辦”,隨後陷入懷疑:對方會不會是騙子?

這時,博主向母親發了第二段錄製的視頻,視頻畫面卡頓、信號差,他順勢打字告訴母親:“網絡很卡,現在很着急,女朋友全家都在,我很尷尬沒面子”,“情況不太好,快點啊媽!”。

圖源:@濾鏡粉碎機

母親糾結再三,聯繫不上兒子,開始腦補兒子是不是“出事了”,疑心兒子是不是欠錢或者被人控制了。

僅僅三小時,焦慮就戰勝了母親。

母親面色蒼白地給陌生賬户打款2萬元——這將近是她一年的收入。

測試到這裏,就該“真相大白”了,算是給母親上了一課,從此敲響警鐘。

但如果對方真的是不法分子,一旦開始轉賬,僅僅是噩夢的開始。

對方會因為老人的防範意識差,從而不斷上演各種意外,反覆加碼,甚至哄騙老人高額貸款。

他們精準拿捏老人的弱點,在模仿他們子女的過程中,要求他們“不能撥打其他電話”“沒時間了,現在就需要錢”“一旦掛斷電話我就會出事”,在如此步步緊逼之下,有些老人被驚嚇得慌了神,也就失去了判斷能力,任人擺佈。

因為愛子心切,這樣的騙術可能發生在任何防範意識差,且憂心子女的老人身上。

這樣的新聞,還有很多。

老人遭遇換臉騙局

尤其對一些老人來説,他們接觸互聯網時間短,先進的AI技術,對他們簡直是降維打擊。

一些不法分子,還會通過利誘的形式,引誘老人投入全部家產買理財產品。

在美國,一個詐騙犯通過AI技術模擬馬斯克,生成了一段視頻,視頻裏的馬斯克,孜孜不倦地講述着投資的好處。

大名鼎鼎的馬斯克對自己親自推薦,如此金錢利誘之下,被哄騙的82歲老人拿出了全部的資產69萬美元(約合490萬人民幣)投資。

事後發現對方是騙子,可一切為時已晚。

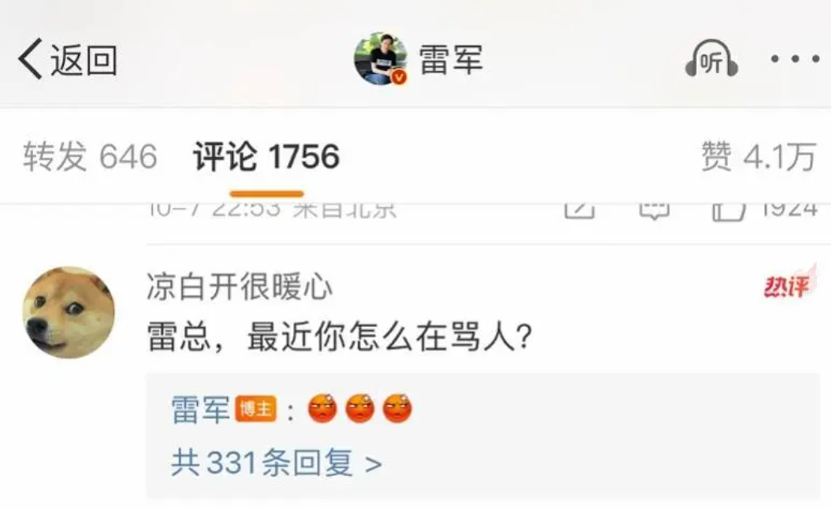

在中國,有人通過AI技術,用雷軍的聲音合成了各類音頻,在去年國慶節期間大肆出圈。雖然是娛樂視頻,但這類視頻也讓人真假難辨。

雷軍在評論回覆,對此行為表示憤怒。

在部分網站上,你只需要支付9.9元,就能定製任意一款換臉、或者模擬某人聲音的視頻。

低成本,高收益,尤其在AI相關法規尚不完善的當下,老年人成了最容易被鑽空子的人羣。

老年人請一定記得,騙術千變萬化,捂緊錢包最大!

假新聞,被瘋傳

隨着AI圖片、視頻生成技術越來越先進,假新聞的傳播速度和影響力,也達到了前所未有的高度。

你可能會覺得,假新聞離自己很遠,但事實上,它早已滲透到我們生活的方方面面。

還記得2011年的“搶鹽風波”嗎?

當時,一條“碘鹽可以防輻射”的假新聞在全國瘋傳,導致超市裏的鹽被搶購一空。雖然事後證明這完全是無稽之談,但這場鬧劇不僅讓許多人囤積了大量無用的鹽,還讓一些商家趁機漲價,賺得盆滿缽滿。

2011年,貨架上的鹽被瘋搶

到了AI時代,假新聞的套路更加高級,它們通過圖片和視頻傳播,讓人“眼見為實”。

今年1月,西藏日喀則市定日縣發生6.8級地震,災情牽動人心,各界幫助救援,就在這時,許多“災情現場視頻”流出。

AI合成視頻

這些視頻利用煽情效果,聲情並茂地呈現出災情的悲慘畫面,讓人憂心忡忡,然而這些視頻都是合成製作。

騙了一大波眼淚和流量後,不僅加大了救援難度,還加重了人們的恐慌。

AI合成視頻

國外的假新聞,同樣魔幻。

前段時間,一張“特朗普被捕”的AI生成圖片,在海外社交媒體上瘋傳。

圖片中,特朗普被一大羣警察追捕,場面十分逼真。雖然這張圖片很快被證實是假的,但已經引發了廣泛討論。

另一個經典的案例,是“教皇代言羽絨服”。

一張AI生成的圖片裏,教皇身穿一件時尚的羽絨服,笑容滿面。

這張圖片不僅讓許多人信以為真,還讓一些商家趁機推出了同款羽絨服,銷量暴漲。雖然教皇本人從未代言過任何品牌,但這張假新聞圖片已經成功帶貨。

假新聞的危害不僅僅是讓人上當受騙那麼簡單,它像一張多米諾骨牌,一旦倒下,就會引發一系列連鎖反應。

對個人來説,假新聞可能導致財產損失、心理恐慌,甚至影響健康。就像一些老年人因為相信了“某某保健品能治癒糖尿病”的假新聞,放棄了正規治療,結果病情加重。

放任不管地傳播下去,還可能引發羣體性恐慌,被別有用心的人利用,製造社會對立、破壞社會的信任。

總之,對於遍地的假新聞,我們更需要時刻警醒。

假新聞再真,也真不過你的判斷力。

詩和遠方?和實物不符

AI視頻,已經侵入了生活的方方面面。

很多時候,人們放鬆地瀏覽着一個個視頻,全然沒注意有些視頻是假的,無形之中被植入了不少“印象錨點”。

去年冬天,有人打着哈爾濱冰雪大世界的標籤,發佈着超乎現實的美好場景,冰雕晶瑩剔透,場景夢幻如《阿凡達》裏的鏡頭。

這裏不僅有孩子喜聞樂見的賽亞人、皮卡丘,還有各種熱門卡通人物。

信以為真的遊客買了車票前往景點才發現,自己被騙了,心情瞬間低落,從而忽略了眼前真實的風景。

內蒙古的草原風光,也常被合成視頻,高飽和度的色彩讓畫面更加豔麗,牛羊成羣讓草原更有生機。

但只有真的身處草原,才能感受到真實的草地和風聲,或許不如合成視頻“出片”,卻能感受真正的廣袤和遼闊帶來的震撼。

而不像現在的AI技術,即便坐在村頭的石磚上,也能一鍵穿越進馬爾代夫的高級酒店裏。

AI效果製造出的“假景點”,騙慘了不少遊客。

有人利用珍貴的假期去打卡“網紅花海”,景點號稱萬畝花田,一年四季美如畫,到了現場才發現“花海”只有小小一片,還有塑料花。

還有人為了打卡這些網紅景點,不僅花費了大量的時間和金錢,還可能被誘導購買高價門票、住宿和旅遊套餐,到了現場才發現,自己完全被“照騙”坑了。

數字AI下的風景

更可怕的是,假景點還可能對人身安全造成威脅。

比如,一些“未開發的秘境”實際上是人跡罕至的荒山野嶺,缺乏基本的安全設施。遊客一旦前往,可能會面臨迷路、受傷甚至更嚴重的風險。

看了太多超現實美景,人們對於旅遊景點的期待閾值,也在被一點點拉高,從而忘記一棵樹、一朵雲真實的模樣,甚至開始因為AI場景開始“嫌棄”簡陋的現實。

AI合成的夢幻場景

但忽略了,正是真實的大地,土壤裏破土的蚯蚓、一朵並不嬌豔的野花,才將我們文明的火種延續至今……

如何與AI共處?

AI的技術,正在全面重塑人們的生活,它帶來了先進和便利,讓生活更美好。

可也有一些人,利用AI,將黑手伸向了老人,伸向了明星,伸向了不明真相的我們……

如果放任不管,可能將進入一種無底線的境地,去騙錢、騙流量。

作為普通人,是時候與時俱進,學會和AI共處了。

面對這些“真假難辨”的AI視頻,我們除了加強防備心,也可以提高甄別技巧。

AI生成的視頻雖然逼真,但在細節上往往會有漏洞。比如,人物的面部表情可能不自然,眼神呆滯,或者嘴唇動作與語音不完全同步。此外,AI在處理頭髮、手指等複雜部位時,常常會出現模糊或扭曲的情況。

如果你發現視頻中的人或動物動作僵硬、背景虛化過度,或者毛髮、光影效果不自然,那就要提高警惕了。

動作僵硬、毛髮不自然的AI視頻效果

AI生成的語音,也可以識別。雖然可以模仿人的聲音,但在語調、情感和停頓上往往不夠自然。

如果你聽到的視頻中,語音節奏過於機械,或者情感表達不連貫,那很可能是AI合成的。此外,AI生成的語音有時會出現奇怪的雜音或斷句錯誤,這也是辨別的重要線索。

當然,還有明顯不符合現實邏輯的視頻。

萌寵區大量AI合成趣味視頻

我們不能預判這項技術的未來會走向何方,在AI技術的加持下,網絡信息變得更加豐富多彩,讓人足不出户就能進入一個絢爛的美好世界。

但在法規尚不全面的今天,讓更多人瞭解AI,可以加強一份警惕心,在面對別有用心的人時,就能快速甄別,無法阻止技術的狂奔,至少,可以選擇不被它牽着走。

曾經,那個眼見為實的慢時代、那個純粹的年代,一去不復返了。

真與假,只隔着一個點擊的距離,照片可以是假的、視頻可以是演的、連記憶都可能被篡改。

這個世界,還有什麼是真的?

你的答案呢?

監製:視覺志

編輯:小魚

視頻號:視覺志