陳小平 | 人工智能三原則——探索機器智能與人類福祉的和諧共生之道_風聞

探索与争鸣-《探索与争鸣》杂志官方账号-14分钟前

陳小平|中國科學技術大學機器人實驗室主任、計算機科學與技術學院教授

本文原載《探索與爭鳴》2025年第3期

具體內容以正刊為準

非經註明,文中圖片均來自網絡

陳小平

人工智能是研究和應用機器智能的人類活動,其應遵守一些基本原則。**本文提出人工智能三原則,即堅持機器智能的另類性、堅持人類福祉的優先性、堅持人工智能的可控性。**其中,機器智能的另類性是人工智能的科學基礎,不堅持機器智能的另類性就無法保證人工智能的可控性,沒有人工智能的可控性就無法保證人類福祉的優先性。

機器智能的另類性

流行觀點認為,人工智能就是用人工方法模擬人類智能的工作原理,這隱含着如下“單智”假設:世界上只有一種智能,即人類智能,而人工智能不過是機器載體上的人類智能。但此假設在科學上並不成立,正如歷史上普遍流行的地心説在天文學中不成立一樣。

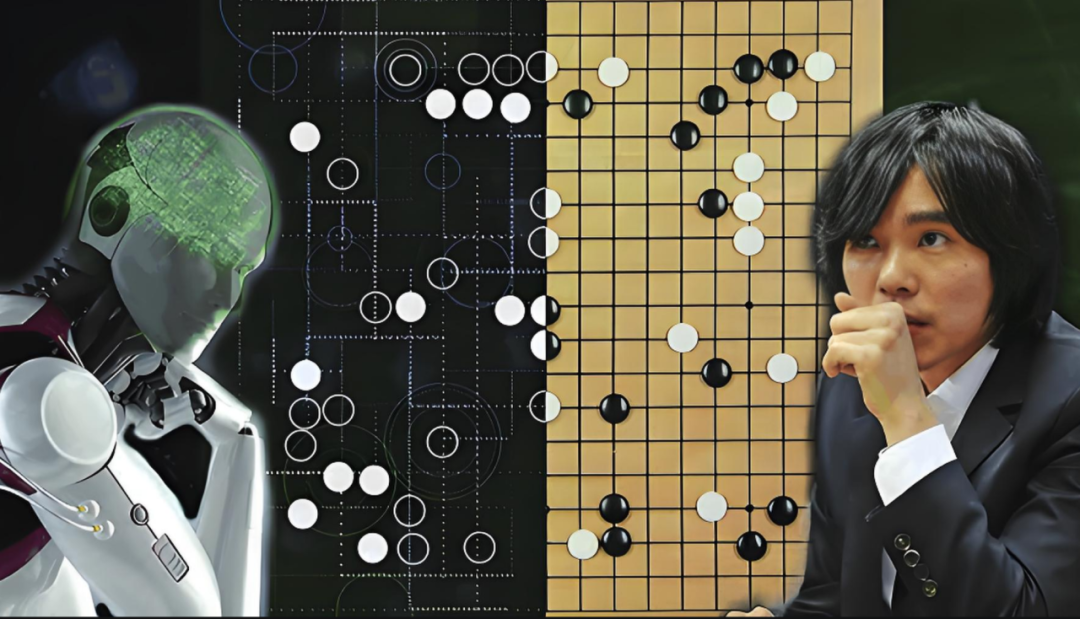

筆者基於圖靈思想提出的“機器智能的另類性”,是基於如下“雙智”假設:**世界上有兩種智能,即人類智能與機器智能,兩種智能工作原理有相同的部分,也有不同的部分,這使得兩種智能的表現有時難以區分,有時明顯不同。**這種情形可以形象地描繪為兩個部分重疊的圓,重疊部分代表兩種智能相同(或難以區分)的表現和原理,不重疊部分代表不相同的表現或原理。比如,圍棋AI程序AlphaGo下棋的表現明顯與人不同,下棋的原理(基於平均勝率估計的決策)也與人明顯不同,可是幾乎所有人都承認AlphaGo在下圍棋這一功能上具備了智能。這種智能是人類智能嗎?顯然不是。

流行觀點以麥卡錫1955年提出的術語“Artificial Intelligence”(AI)作為人工智能的起點,並認為這個術語指的就是用人工方法模擬人類智能的工作原理。麥卡錫在個人主頁通過一系列問答闡述了他對AI的解讀,其中第四個問題是:AI不就是模擬人類智能嗎?他的回答為:有時候是,但並不總是,甚至通常不是。他進一步解釋道:一方面我們有時通過模擬人類的方法讓機器表現出智能;另一方面,大多數AI研究是探討、解決世界對智能提出的問題,而不是研究人或動物。可見麥卡錫完全認同圖靈的思想,明確否定AI就是模擬人類智能。

根據我對人工智能歷史上的所有里程碑式進展的分析,這些成果無一例外都遵守另類性。一個最近的例子是其開發者獲2024年諾貝爾化學獎的AlphaFold2,這個AI程序通過數據增強和強化學習,而不是模擬化學家的思維方式,來預測蛋白質的三維結構。近七十多年來,人工智能科學實踐反覆驗證了AI奠基者和早期開拓者的思想中所隱含的機器智能的另類性,現在到了大眾拋棄人工智能地心説的歷史時刻。

**大模型是機器智能另類性的一個典型代表。**大模型隱含機器智能的兩項原理性突破,同時也是兩項原理性侷限,即實例性和弱共識性,這兩個性質充分展示了大模型的另類性。筆者2023年7月曾撰文提出了大模型底層機制關聯度預測的一種形式化理論——類LC系統,該系統包含三套公理模板,用一個指定的數據集進行訓練,產生符合模板格式的、數目不定的公理。

類LC的實例性表現為:它的任何一條公理都不含變量,而是由兩類常量構成:一類是語元(token),即字詞和標點符號;另一類是語元之間的關聯度的值(即0到1之間的一個數值,代表語元之間關聯的強弱)。因此,一條類LC公理並非嚴格意義上的一條數學公式,而是數學公式的一個實例,即公式中的所有變量被分別替換為常量的結果。

類LC的弱共識性表現為:它的形式語義以語元和語元之間的關聯度為表示基元(primitives),僅限於基元上的統計信息,此外,類LC不帶實質語義,而是接受外界(如大模型用户)賦予它的實質語義,且可同時接受任意多種不同的實質語義,只要這些實質語義不與類LC的形式語義矛盾。

自古以來,科學始終是用包含變量的數學公式(或包含變元的邏輯公式)來描述研究對象的,並藉助少數幾條公式表達對象的基本性質,這些公式被稱為公理(或公設)。從公理出發,通過數學和邏輯推理可以得出定理,描述對象的派生性質。

一般而言,科學在每一個領域的基礎研究就是要找到少數幾條公理,從而完全描述該領域的基本規律,達到理論上的封閉化。然而數百年來,用這種方法研究自然語言卻始終難以奏效。同樣,人工智能的自然語言處理研究也是如此。究其根源,在於自然語言理論上不是封閉的。

**類LC系統為非封閉的自然語言提供了非封閉性表達方式,包括語法和語義兩個方面。**語法方面依靠實例性,即用類LC系統的一條公理描述自然語言現象的一個具體實例,使得訓練數據中出現的每一個語言實例,在類LC系統中都有一條對應的公理,表達對應的實例化規律。只要訓練數據不窮盡自然語言現象的所有實例,類LC系統就不會窮盡自然語言的所有實例化規律。當訓練數據包含的自然語言現象實例更多,對應的類LC系統所包含的自然語言實例化規律也更多。

語義方面則依靠弱共識性,其機制為:人會不自覺地將語元解釋為對應的概念,於是概念承載的實質語義不知不覺中填補了類LC系統實質語義的空白,使得“有概念”的人類難以意識到大模型的“無概念”,從而產生大模型有概念、人與大模型有完全共識的幻覺。

其實人類思維中的概念至少包含三層關聯:第一層是概念表示之間的關聯,即一個概念的表示與其他概念的表示之間的關聯,包括統計關聯;第二層是概念表示與其所指的現實世界中的對象之間的關聯;第三層是概念表示與對應的生命體驗之間的關聯。顯然,類LC系統只擁有第一層關聯,沒有第二、第三層關聯,導致大模型與人之間的共識只能是弱共識。然而以往的科學理論、數學、計算機科學和人工智能強力法都是基於概括性和強共識性。現在這兩個基本性質都徹底反轉,讓人一時難以適應。

我相信,科學上可能的所有機器智能都具有另類性。但與人類智能相同種類的機器智能是邏輯上可能的,因此有必要置於人工智能三原則的考慮範圍之內。在單智假設下,人類智能遲早被機器智能取代,人類文明被機器文明取代,甚至人類也被機器取代。在雙智假設下,人類智能與機器智能可以長期共存,人類的命運非但不會被機器終止,反而可以因“禍”得福,開創人類未來的新紀元。

人類福祉的優先性

首先需要明確,**優先性原則中的人類福祉指的是符合人類根本利益的福祉,而人類根本利益指的是對人類整體生存和發展具有決定性影響的利益,包含經濟、政治、文化等各個方面。**優先性原則普遍適用於邏輯可能的假想情況和現實可能的實際情況。一種極端的假想情況是:人工智能的發展最終產生了“高於”人類文明的機器文明。那麼,是否應該允許機器文明取代人類文明,即允許人類發明消滅自己的機器智能?優先性原則確立了人類優先於機器、人類文明優先於機器文明的優先級排序,所以不允許出現用機器消滅人類的可能。

導致上述假想情況得以出現的一種可能方式是,人類發明了與人類智能相同種類的機器智能,即機器載體上的人類智能,擁有與人類相同種類的思維、情感、意識和生命體驗,並達到比人類更高的水平。一旦這樣的機器智能成為現實,如果人類拒絕接納這些機器成為人類的新成員,則將陷入道德絕境;如果接納,將陷入生存絕境,難逃最終被智能機器徹底取代的命運。因此,在不違背優先性原則的前提下,必須堅持另類性原則,禁止發明與人類智能種類相同的機器智能。

在堅持另類性原則的前提下,兩種智能由於原理不完全相同,各自帶有不同的“先天侷限”,所以不會徹底相互取代。儘管如此,人工智能的發展仍然帶來顛覆性影響——人類不再是世界上唯一的智力霸主,某些方面比人類智能更加強大的機器智能正在迅速崛起,對人類智能和人類社會產生巨大、深遠的影響,人類面臨着“重新做人”、社會面臨着涅槃重生的史無前例的考驗。

如此考驗遠超科學技術的影響範圍,必然更深刻、更廣泛。讓我們首先回顧工業革命。工業革命在技術方面的最大特點是出現了能夠代替人體力功能的機器,但沒有智力,即仍需要人工操縱機器。為了提高生產效率,就要使用更多機器,於是需要更多工人,這樣就形成了工業革命的效率閉環:生產效率提升帶來就業增加,就業增加帶來收入增長,收入增長帶來消費擴大,消費擴大反過來刺激生產效率的進一步提升。因此,在工業革命時代,政府對生產效率提升採取了無條件支持的態度,即使引發了環境污染等副作用,仍然採取先發展後治理的解決辦法。經歷了幾百年的工業革命,這種思維方式已經根深蒂固,成為阻礙智能革命的思想羈絆。

**一旦AI技術得到大面積應用,社會就將進入智能革命時代。**智能革命的最大特點是機器的智力和體力功能都超過人類或超過大部分人,越來越多的機器不需要人工直接操縱。於是,生產效率的提升不但不帶來就業增長,反而導致就業減少,作為工業革命最大特點的效率閉環在智能革命時代不再成立。因此,智能革命不是第四次工業革命;恰恰相反,智能革命要革工業革命的命,要建立新閉環、取代舊閉環。

目前正在形成機器智能大規模替代人工的趨勢,典型代表是大模型替代服務業中的大量工作崗位。大模型技術體系主要包含預訓練、後訓練和激發(prompt)三個部分。大模型在預訓練中使用了所有可以獲得的“公域數據”,如互聯網文本、電子書籍等所有開放的電子數據,沒有使用“私域數據”,即個人和機構的不開放數據。當大模型被越來越多的用户使用,便可以獲得越來越多的私域數據。通過私域數據的訓練,大模型解決各種場景中實際問題的能力將得到極大提升,甚至可能實現所謂的AGI(通用人工智能)/ASI(超級人工智能)。

一些人把AGI/ASI當作技術理想,相信用AGI/ASI替代人工可以帶來生產效率的極大提升,從而造福人類。然而這種“理想”混淆了時代背景。如上所述,效率閉環只在工業革命時代成立,在智能革命時代並不成立,甚至效果可能相反。最終出現什麼結果,取決於當前的路徑選擇。

**其中一條路徑的結果是出現大資本獨佔的超級寡頭經濟。**國際上一些知名學者説“人工智能即將統治人類”,指的不是人工智能技術統治人類,而是説大資本利用人工智能技術統治人類。顯然,這種情況不符合多數人的根本利益。因此,人類有必要對優先性原則達成共識,進而對人工智能發展的路徑選擇達成共識,並排除違背優先性原則的路徑。

人工智能的可控性

**優先性原則是關於結果的,而可控性原則是關於過程的,是優先性原則始終得到遵守的保障。**可控性原則包含兩方面的基本內涵:技術方面,要始終保持人類對機器智能的駕馭能力,避免出現人類不可控的機器智能;社會方面,要建立充分的治理能力,保證人工智能應用不會導致違背優先性原則的結果。

技術方面,什麼樣的機器智能是可控的,是一個新的科學問題。通常受到最多關注的可控性問題是:與人相同種類的機器智能是否始終是人類可控的?本文依據優先性原則闡述了禁止這種機器智能的必要性。以下只考慮具有另類性的機器智能的可控性。

目前已知的是,人工智能強力法技術是可控的,訓練法(包括大模型)不是完全可控的,而是部分可控的,比如人類無法完全控制訓練結果。於是,有必要進一步考慮不完全可控AI技術的潛在風險的大小。一般情況是,通用性越強,則風險等級越高,所謂的通用大模型具有目前已知最高等級的風險,如重大公共安全風險和重大民生安全風險。

在社會層面,人工智能的可控性問題尚未受到應有的重視。當前人工智能有兩條發展路徑。**第一條路徑是高成本+閉源。**假如個別通用大模型的應用包攬了大部分私域數據,相關企業就會成長為巨角獸,即員工人均盈利超過10億美元的企業。進一步發展就會變成巨角獸經濟,即全部生產由巨角獸企業承擔的經濟體。這種經濟體中,勞動力結構由三個族羣構成:有工作族,可能最多隻有3萬人,這些人是社會的建設者和直接責任人;投資族,可能只有幾十人,那時不需要現在這麼多投資人了;無工族,全國總人口減去3萬,這些人領取全民基本收入,不參加生產,也不參與管理。所以,這條路徑的結果就是大資本獨佔的超級寡頭經濟,是違背優先性原則的。

這個例子表明,人工智能時代的數字鴻溝擴大化可以極端到何等境地。更加值得警惕的是,這條路徑只需走到一定階段,比如社會形成對個別大模型的普遍依賴,之後便將難以回頭,這時的人工智能應用就已經失控了。

**第二條路徑是低成本+開源,這是中國DeepSeek推動起來的路徑。**開源是有規則的共享,大家在遵守規則的前提下共同研發、共享成果。所以這條路徑是普惠性的,一旦走通了,第一條路徑就走不通了,不會再出現利用大模型技術的超級寡頭壟斷,所以全球多數機構不約而同地迅速響應和支持。這是中國人工智能對世界、對人類的一個重大貢獻。

但第二條路徑仍然存在着巨大風險。尤其值得警惕的是,更快的大規模推廣應用有可能導致風險更快地發生。最嚴重的是重大公共安全風險,以及相對較小規模的民生安全風險(即就業替代)。我國現階段應聚焦低風險、高效能的垂直領域的AI應用,停止不必要的機器換人。有必要的機器換人集中出現在傳統制造業、農業等領域,其他領域機器換人的必要性需要具體研判。其他挑戰包括AI生成的虛假/虛構信息、數據安全、用户隱私保護等。為了保證可控性,需要開展人工智能倫理審查。

**風險防範只是人工智能治理的一個次要方面,主要方面是創建與智能革命時代相適應的創新和經濟發展方式。**我曾提出公義創新和公義經濟的設想。“公義”的基本理念是以合理的、普遍性的個人需求的公正滿足為社會的共同義務。而熊彼特創新和熊彼特經濟則以生產效率和經濟效益為唯一決定性驅動力,與工業革命的效率閉環互為表裏。在公義創新和公義經濟中,生產效率和經濟效益不再是唯一決定性驅動力,因為智能革命不是用更強大的技術手段在舊世界裏展開更殘酷的“內卷”,而是顛覆舊世界,再造新世界。

公義創新和公義經濟不是空想,過去幾十年裏已經出現了一些早期萌芽,如時間銀行、開源軟件運動、互聯網內容創業、共享經濟。我們需要進一步研究六個方面的課題:評價體系升級、創新要素組合機制升級、社會參與模式升級、風險治理模式升級、職業道德升級、社會治理體系升級。