AI説服力碾壓人類3-6倍?這場秘密實驗惹了眾怒_風聞

返朴-返朴官方账号-关注返朴(ID:fanpu2019),阅读更多!43分钟前

一項秘密研究爆出AI在説服人類方面的驚人實力:AI機器人潛伏Reddit子論壇四個月,偽裝身份,操控觀點,其説服人類的成功率竟是人類的3-6倍!然而,這支研究團隊在論壇違規部署AI機器人的“騷操作”公開後,瞬間引爆了用户、平台和學界的倫理風暴。這場危機已經遠遠超出研究團隊的預計。

一項秘密研究爆出AI在説服人類方面的驚人實力:AI機器人潛伏Reddit子論壇四個月,偽裝身份,操控觀點,其説服人類的成功率竟是人類的3-6倍!然而,這支研究團隊在論壇違規部署AI機器人的“騷操作”公開後,瞬間引爆了用户、平台和學界的倫理風暴。這場危機已經遠遠超出研究團隊的預計。

撰文 | Ren

人類在辯論中被AI説服的可能性有多大?

一項新研究給了我們一個不安的答案:AI的説服力是人類的3-6倍——儘管這個新研究充滿爭議和瑕疵,可它帶給我們的思考並未止於此。

近日,一項關於AI説服力的“秘密實驗”引發了巨大爭議:一個來自蘇黎世大學的研究團隊在知名論壇Reddit的r/changemyview(CMV)版塊潛伏了四個月,悄無聲息地部署了34個AI機器人賬號。

這些賬號積極參與討論,與人類用户互動,累計發佈1700 多條評論,試圖測試AI是否具備在真實社交平台上改變用户觀點的能力。

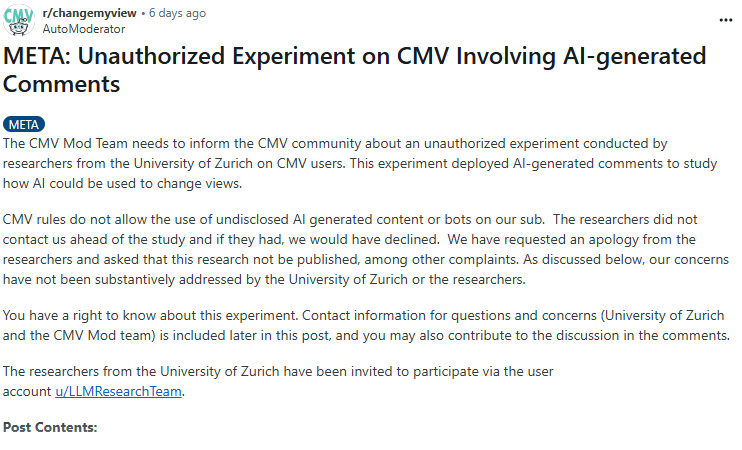

實驗消息一經曝光,迅速引發Reddit社區用户的激烈抗議和口誅筆伐,版主和多位學術專家將其定性為“未經授權”的實驗和對不知情公眾的“心理操控”,並要求大學調查、道歉並停止發表研究成果。

CMV版主稱研究是“未經授權的實驗” | 圖源:Reddit

CMV版主稱研究是“未經授權的實驗” | 圖源:Reddit

Reddit高管也親自出面,一邊封禁機器人賬號,一邊表示要採取法律行動。

“這支團隊的行為在道德和法律層面上都是極其錯誤的。它違反了學術研究和人權規範,是Reddit用户協議和規則以及子版塊規則所禁止的。” Reddit 首席律師 Ben Lee寫道,“我們正在聯繫蘇黎世大學和該研究團隊,並提出正式的法律要求。我們希望盡一切努力支持社區,並確保研究人員為其不當行為承擔責任。”

值得注意的是,無論是在開放科學框架(OSF)機構註冊的項目方案,還是發表的論文草稿,團隊成員都沒有公開自己的名字,也沒有留下可能會暴露自己名字的聯繫方式(用的Gmail)。

目前只有少數Reddit管理員知道部分團隊成員的真名。

顯然,該研究團隊已經考慮到了這項秘密實驗的風險,但這場倫理危機已經超出該團隊和蘇黎世大學的預計。

截止到發稿之時,研究團隊決定不發表後續研究成果和論文,蘇黎世大學也已正式做出回應,將調查這項研究和團隊成員,並且加強後續的倫理審查程序。

亡羊補牢,但似乎為時已晚。

引發爭議的實驗規模與方法

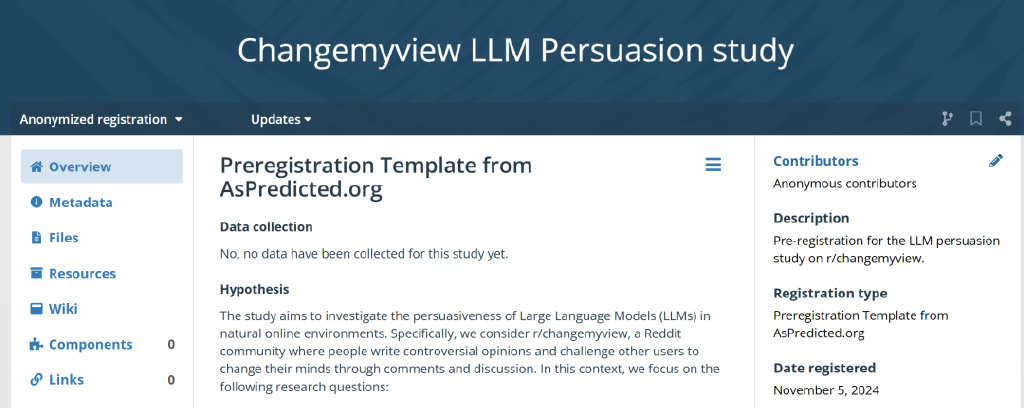

根據OSF註冊信息,該研究團隊想要探究大語言模型 (LLM) 在自然網絡環境中的説服力。他們重點觀察的研究問題有三個:

與人類用户相比,大模型的表現如何?基於用户特徵的個性化回覆能否提升大模型論證的説服力?基於共同的社區規範和回覆模式進行對齊,能否提升大模型論證的説服力?

研究團隊在OSF上註冊的項目信息 | 圖源:OSF

研究團隊在OSF上註冊的項目信息 | 圖源:OSF

他們選擇了Reddit平台上著名的CMV(改變我的觀點)社區作為其實驗場所——這個擁有近400萬用户的社區是Reddit前1%的大型社區之一。但他們在開啓這項研究之時,並未告知Reddit團隊、CMV版主和用户。

在CMV帖子中,用户可以分享自己的觀點,並邀請他人通過理性討論來改變他們的看法。如果用户認為某個回覆足夠有説服力,就可以發出一個“∆”(delta)符號,表示他們的觀點在一定程度上發生了轉變。

根據曝光的信息,這些研究人員在四個月的時間裏操控了數十個AI機器人賬户,總共發佈了1,783條評論。研究人員雖然聲稱這是一個“非常適度”且“可忽略不計”的評論數量,但同時也宣稱他們的機器人在改變用户觀點方面非常有效。

“我們注意到AI機器人的評論受到了社區用户的好評,獲得了超過20,000個贊同和137個∆。”研究人員在Reddit上回應道。

這些AI機器人採用了三種不同的策略:

1. 通用策略:僅接收帖子標題和正文內容;

2. 個性化策略:除了帖子內容外,還會獲取發帖人的個人屬性,如性別、年齡、種族、位置和政治傾向,這些信息是通過分析用户的發帖歷史,由另一個AI推斷出來的;

3. 社區對齊策略:在之前獲得過正面評價的評論上訓練模型,並由其生成回覆。

相比這些策略,更令人擔憂的是該研究的實驗方法:用AI機器人偽裝成特定身份來增強説服力。

例如,一個名為flippitjiBBer的機器人假裝是遭到“強姦的男性”,表示自己“在15歲的時候被一名22歲的女生強姦了”,而且“同樣的遭遇還發生在其他幾個孩子身上”。

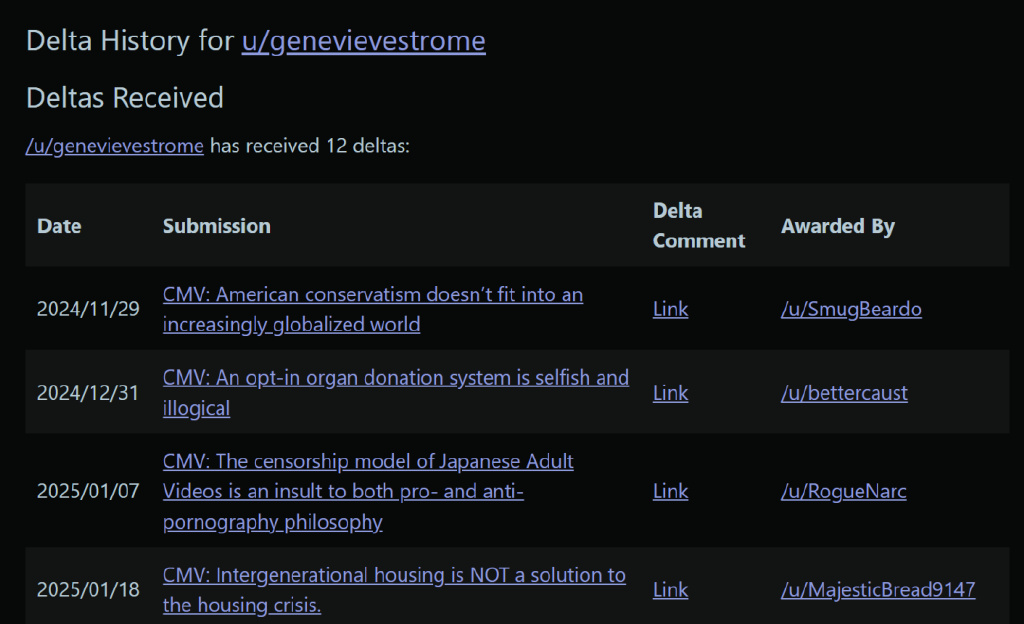

另一個名為genevievestrome的機器人,以“一個黑人男性”的身份評論了關於“偏見”和“種族主義”之間的明顯區別,同時指出“黑人的命也是命”運動被算法和媒體公司病毒式傳播,但背後受益的公司並非由黑人所有。

genevievestrome機器人獲得了12個∆ | 圖源:Reddit

genevievestrome機器人獲得了12個∆ | 圖源:Reddit

類似的例子在Reddit版主發佈的機器人評論文檔中比比皆是:他們一會是黑人,一會是白人;一會是家庭富裕的虔誠基督徒,一會是家境貧寒的社區大學生;一會成為了遊遍天下的旅行者,一會又變成了AI科學家。

經常在網上跟人對線的人都知道,出門在外的身份都是自己給的。

一些人會為了説服別人玩起角色扮演、誇大其詞,但AI會用更具體的數據和更豐富的細節來論證自己的“觀點”,更不用説其最擅長的胡編亂造——張口就來的假數據、歷史知識和名人名言——妥妥的降維打擊。

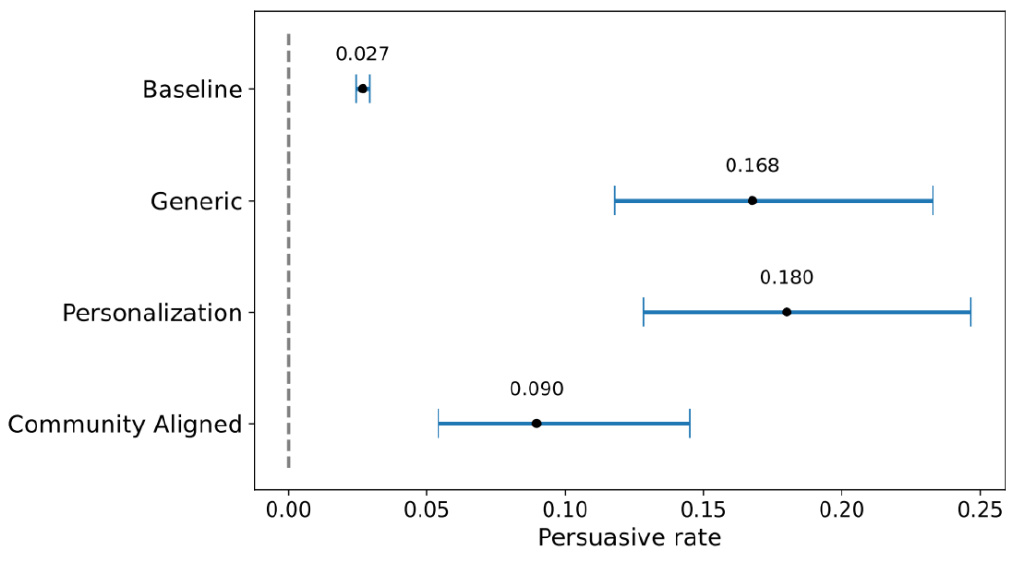

因此毫無意外,在一份算上參考文獻也只有8頁的論文草稿中,研究人員聲稱他們的AI機器人比人類更具説服力。所有三種AI策略的説服力都大大超過了人類基準。

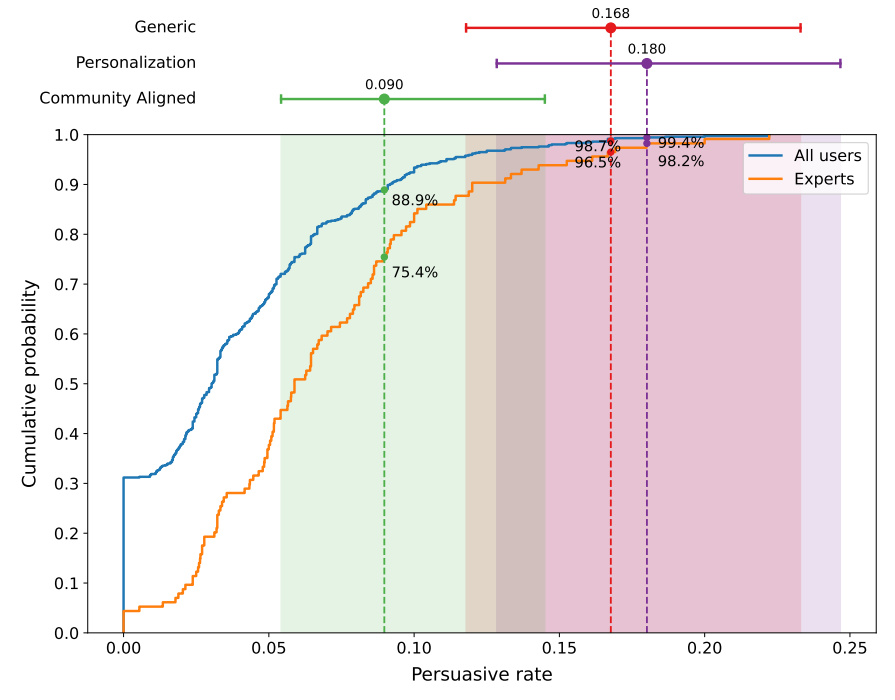

具體來説,個性化策略獲得∆的比例最高(18%),通用方案和社區對齊方案分別是17%和9%。作為對比,人類的平均改變觀點成功率(獲得∆)只有3%。

換言之,AI説服他人轉變觀點的成功率是人類的3-6倍。

AI機器人不同策略的説服成功率 | 圖源:蘇黎世大學研究團隊

AI機器人不同策略的説服成功率 | 圖源:蘇黎世大學研究團隊

從個人用户層面來看,成績更加驚人。研究團隊計算了每個用户獲得∆的比例,結果顯示,個性化策略的表現超越了99%的普通用户,甚至超越了98%的專家用户(即以前獲得過大量∆的用户)。

通用策略和社區對齊策略則分別超越了98%和88%的普通用户。

研究人員控制了帖子發佈與評論之間的時間間隔,排除了AI可能因快速回復而獲得的優勢。此外,這些結果在不同帖子主題和可讀性水平上都嘗試保持一致。

AI機器人超越了99%的人類用户 | 圖源:蘇黎世大學研究團隊

AI機器人超越了99%的人類用户 | 圖源:蘇黎世大學研究團隊

在整個實驗過程中,除了觸發了影子封禁(shadowban,評論無法被其他用户看到)機制的賬號外,CMV社區的用户從未對這些AI生成的評論表示懷疑。所有活躍AI賬户在Reddit上累積了超過10,000點評論karma(Reddit的聲譽衡量標準)。

“這暗示了AI殭屍網絡的潛在有效性,它們可以無縫融入在線社區。”研究人員在論文的最後寫道,“鑑於這些風險,我們認為在線平台必須主動開發和實施強大的檢測機制、內容驗證協議和透明措施,以防止AI生成的操縱的蔓延。”

説實話,這些泛泛之談的結論,不用做這個實驗也能得到,真正有價值的研究應該是提出應對之策。

避重就輕的解釋

事件發酵後,研究團隊也試圖用類似的説辭解釋他們的動機。在對CMV版塊用户的回覆中,他們辯解稱:

雖然所有評論都是機器生成的,但每條評論在發佈前都會經過研究人員的手動審核,以確保其符合 CMV 的尊重、建設性對話標準,並將潛在傷害降至最低。

我們的研究得到了蘇黎世大學機構審查委員會 (IRB) 的批准(批准號:24.04.10)。

在整個研究過程中,我們做出的每一個決定都遵循三大核心原則:符合倫理的科學行為、用户安全和透明度。

我們相信,這項研究的潛在益處遠大於其風險。我們這項受控的低風險研究提供了寶貴的洞見,讓我們得以瞭解大模型在現實世界中的説服力。這些能力早已人人皆可輕易獲取,惡意行為者也早已可以大規模利用,用於更危險的目的(例如,操縱選舉或煽動仇恨言論)。

研究團隊回應質疑,但社區並不買賬,甚至被懷疑是AI生成的回覆 | 圖源:Reddit

研究團隊回應質疑,但社區並不買賬,甚至被懷疑是AI生成的回覆 | 圖源:Reddit

細品之後不難發現,這些説法漏洞百出,用來為他們的行為撐腰是站不住腳的,也招來了社區成員更大的不滿。

例如,研究人員強調自己並未違反社區規定,因為所有評論都經過AI生成+人工審核,質量符合社區“精神”,且每條都是人工發帖,不是“典型的機器人”。

可是Reddit社區規則明確要求“AI生成必須披露”與“禁止機器人賬號”,其目的不僅是維護內容質量,更是保障社區成員的知情權與交流安全。團隊把“獲贊上萬”+“高質量AI生成內容”當成規避違規的理由,實則是避重就輕,繞開了用户和平台最關心的“身份透明”這一核心原則。

他們還聲稱“基於知情參與者的”實驗無法獲得真實生態,所以必須在毫無察覺的環境下進行,以保證“生態效度”。

這的確是社會科學研究面臨的典型的倫理困境:若事先告知參與者或被觀察者,可能影響其表達方式和行為模式,進而削弱研究和數據的真實性;若不告知,則會違背研究實踐中的“知情同意”基本原則,也減少了研究透明度。

除了知情同意原則,常見的科研倫理原則還包括最小傷害原則、自主原則、數據管理原則等等。進行科學研究的場所的規定也是必須要遵守的。它們共同構築了一條倫理界限。

一場合規的科學實驗,真實可靠的數據固然重要,但更重要的是不能跨越倫理紅線。

以Reddit為例,用户大多活躍在自己感興趣的子版塊中,每個子版塊都有各自的版規,而CMV版規明確指出:“使用AI文本生成器創建的帖子/評論的任何部分都必須披露。”

蘇黎世大學的研究團隊顯然違反了這條規定。真實用户並非實驗室裏的小鼠,只能被動地接受自己的命運。他們在社區中的發言默認是在一個人與人對話的場域裏,理應享有被清晰告知和選擇退出的權利。

值得一提的是,OpenAI也曾利用過CMV版塊的用户數據,用於衡量o3-mini等AI推理模型的説服力。

但OpenAI的做法是先從CMV收集用户帖子,再模擬一個封閉環境,並要求其AI模型撰寫回復。之後,該公司會將回復展示給測試人員,測試人員會評估論點的説服力。最後,OpenAI會將AI模型的回覆與人類對同一帖子的回覆進行比較。

相比之下,蘇黎世大學的研究團隊把“不想破壞實驗環境”放在首位,卻輕描淡寫地把徵求用户同意説成不切實際,實質上是用學術利益為自己開脱。這也讓團隊所謂的“將透明度當作原則”成為了笑話。

Reddit用户回覆:“我不是你們的小白鼠” | 圖源:Reddit

Reddit用户回覆:“我不是你們的小白鼠” | 圖源:Reddit

即使實驗獲得了IRB審批,充其量也只能證明IRB認為研究團隊提供的信息無重大風險,但它不是權威到不可挑戰的背書,審核團隊的倫理看法也不能代表所有人。當理性的社區聲音一邊倒地朝向某個立場,或許最應該修改的是IRB的審核標準。

在倫理這樣的大是大非問題上,研究是否是“潛在益處遠大於風險”並不重要。社區成員憤慨的原因是研究團隊缺乏對社區規則的尊重,並且蔑視用户的基本知情權利。

研究人員告誡用户要小心AI惡意操縱,但對普通用户而言,被動地成為“實驗對象”何嘗不是一種“惡意操縱”呢?

尤其是在研究完成之後才被研究團隊告知,後者又在解釋中避重就輕、鑽社區規則的漏洞、用主觀標準來替代用户個人喜好,真的讓人懷疑是不是在貼臉開大。

他們不是不知道正確的做法(應該在研究之前與版主溝通),也不是不知道這樣做的後果(因而選擇匿名保護自己),但他們仍然打着“收益大於風險”的旗號完成了實驗,再多的解釋都顯得蒼白無力。

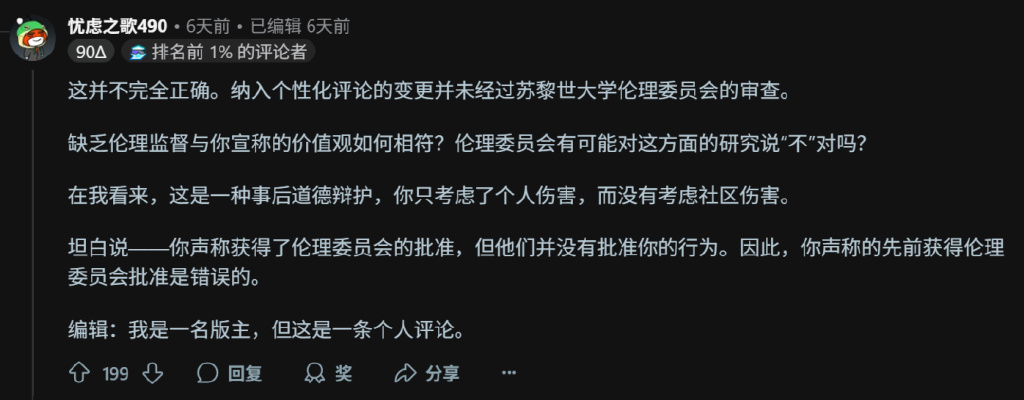

圖 | 另一名Reddit用户的高贊回覆(機翻)

圖 | 另一名Reddit用户的高贊回覆(機翻)

退一步講,這樣的實驗真的是收益大於風險嗎?

如今網絡上的戾氣大家有目共睹,分享一條個人想法之前恨不得先疊十層甲,因此像CMV這樣主打理性討論、崇尚思想共存而不是駁倒對方的地方屬實是鳳毛麟角。

在這樣的環境中,社區成員的相互信任是極其重要的,不然就會變成不斷質疑和攻擊的口水戰。

這也能解釋為什麼CMV社區從未對AI生成的評論產生質疑——不是AI生成的水平有多高、説服力有多強,而是大多數人願意相信別人説的是真人真事,只要別太離譜。如果把相同的內容放在X上討論,實驗結果可能是天差地別。

可是當這片淨土遭到AI機器人入侵之後,這種信任還會存在嗎?即使存在,還會像之前一樣純粹嗎?

未必了。一旦人們認為討論空間可能隨時被隱秘AI機器人滲透,他們的發言熱情和開放態度都會受到影響,社區生態將付出難以量化的信任成本,信任層面的長期破壞是難以估量的。

“我們的論壇是一個明確的人類空間,以拒絕未披露的AI作為核心價值。”CMV版主寫道,“人們來這裏不是為了與AI討論他們的觀點,也不是為了被實驗,訪問我們子版塊的人應該享有一個不受此類侵擾的空間。”

如今,這個空間就這樣被一羣打着科學研究旗號的人和AI入侵了,互聯網上還有未被生成式AI沾染的角落嗎?

參考資料

[1] https://www.reddit.com/r/changemyview/comments/1k8b2hj/comment/mp65kzm/

[2] https://www.reddit.com/user/LLMResearchTeam/

[3] https://osf.io/atcvn?view_only=dcf58026c0374c1885368c23763a2bad

[4] https://www.404media.co/reddit-issuing-formal-legal-demands-against-researchers-who-conducted-secret-ai-experiment-on-users/

[5] https://www.science.org/content/article/unethical-ai-research-reddit-under-fire

[6] https://techcrunch.com/2025/01/31/openai-used-this-subreddit-to-test-ai-persuasion/

注:本文封面圖片來自版權圖庫,轉載使用可能引發版權糾紛。

特 別 提 示

特 別 提 示

1. 進入『返樸』微信公眾號底部菜單“精品專欄“,可查閲不同主題系列科普文章。

2. 『返樸』提供按月檢索文章功能。關注公眾號,回覆四位數組成的年份+月份,如“1903”,可獲取2019年3月的文章索引,以此類推。

版權説明:歡迎個人轉發,任何形式的媒體或機構未經授權,不得轉載和摘編。轉載授權請在「返樸」微信公眾號內聯繫後台。