這一領域芯片,重度依賴台積電_風聞

半导体产业纵横-半导体产业纵横官方账号-赋能中国半导体产业,我们一直在路上。53分钟前

本文由半導體產業縱橫(ID:ICVIEWS)編譯自semiengineering

英特爾和三星正在研發先進的製程節點和先進的封裝技術,但目前所有大型廠商都已100%依賴台積電。

大型語言模型(例如 ChatGPT 等 LLM)正在推動數據中心 AI 容量和性能的快速擴展。更強大的 LLM 模型推動了需求,並需要更多的計算能力。

AI 數據中心需要 GPU/AI 加速器、交換機、CPU、存儲和 DRAM。目前,大約一半的半導體用於 AI 數據中心。到 2030 年,這一比例將會更高。

台積電在AI數據中心邏輯半導體領域幾乎佔據100%的市場份額。台積電生產:

Nvidia GPU、NVLink 和 CPU。

AMD CPU 和 GPU。

英特爾 CPU。

適用於 Microsoft、Amazon、Google 和 Open AI 的 AI 加速器(與 Broadcom、Marvell、Alchip 和 Mediatek 共同設計)。

Broadcom 和 Astera 交換機。

ASpeed 底板管理芯片。

台積電唯一沒有生產的必需 AI 數據中心芯片是存儲器:HBM、DDR、閃存。

AI數據中心芯片代工,為何青睞台積電?

台積電擁有AI數據中心必須具備的四大要素:

最先進的工藝技術和產量。

最先進的封裝技術和產量。

能夠快速將複雜的新產品提升至每月大批量生產。

擁有提前數年開發並批量交付的財務實力。

先進製程技術:AI 數據中心芯片,尤其是 AI 加速器,需要最先進的製程技術才能在芯片上集成最多的晶體管。像格芯這樣的代工廠,目前無力承擔先進 FinFET 節點的開發資金。目前只有英特爾、三星和台積電擁有 2 納米及以下製程技術和路線圖。

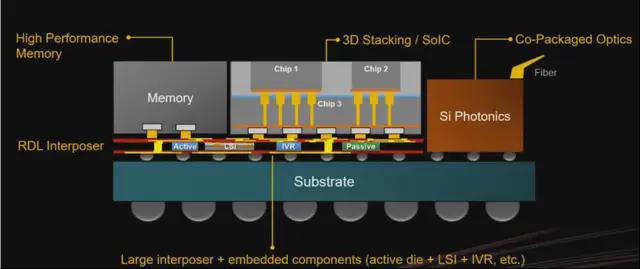

先進的封裝技術:LLM 模型的規模呈指數級增長,即使採用最先進的工藝節點和最大的光罩尺寸,單個 GPU 芯片也無法處理該模型。運行 LLM 模型需要多個 GPU/AI 加速器。對於多芯片系統,瓶頸在於芯片間的數據速率。使用 200 Gb/s 銅互連的芯片間數據速率與片上數據速率相比非常非常慢。

解決方案是採用先進的封裝技術,將多個 GPU 芯片和 HBM 內存集成在多光罩基板上,並通過極快的芯片間數據傳輸,打造 GPU 計算組件。台積電始終領先於客户需求,持續研發。未來 AI 加速器將採用共封裝光通信技術,取代銅連接。台積電於 2024 年宣佈推出 COUPE 工藝,用於將光學引擎集成到先進的封裝中。英偉達今年早些時候宣佈推出首款採用該技術的橫向擴展交換機。

圖 2:HBM、多個 AI 芯片、電壓調節器和 CPO 集成在一個封裝中。

圖 2:HBM、多個 AI 芯片、電壓調節器和 CPO 集成在一個封裝中。

為了確保良率和產能提升,先進封裝中的所有芯片都必須由台積電代工。唯一非台積電代工的芯片是DRAM內存和無源芯片。

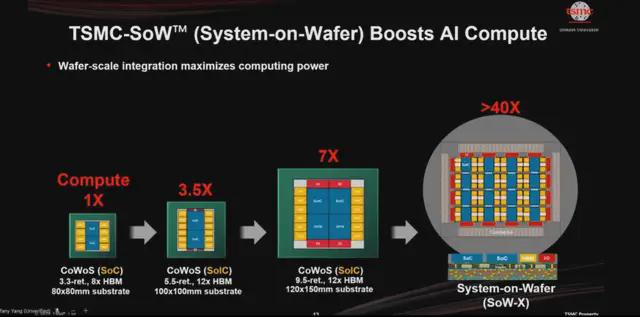

台積電早在幾年前就開始開發多芯片基板封裝,當時HBM開始被GPU採用,並且不斷提升其產品的尺寸和複雜性。他們最近宣佈了一種晶圓尺寸的基板:

圖 3:更大的基板通過更快的芯片間數據傳輸速率提高了計算速度。

圖 3:更大的基板通過更快的芯片間數據傳輸速率提高了計算速度。

產能上,台積電擁有全球最先進的製程和封裝技術產能,其中美國佔有相當大且不斷增長的份額。

2024年第四季度,台積電在全球晶圓代工市場的份額達到67%,較2023年初增長約10%。三星的份額為11%。英特爾則被歸類為“其他”。台積電在先進製程晶圓代工領域的份額要高得多。

台積電正在增加其在美國最先進節點的產能比例。該公司計劃在亞利桑那州生產N2和A16節點,目標是使這些節點總產量的約三分之一來自美國。該公司將繼續先在中國台灣開發最先進節點。

摩根士丹利估計,到2026年,台積電將佔據全球90%的CoWoS(先進封裝)產能,其餘產能將由安靠(Amkor)、聯華電子(UMC)和日月光(ASE)佔據,英特爾和三星的數據未提及。台積電在美國也擁有大量且不斷增長的先進封裝產能。

當 Nvidia、亞馬遜或谷歌需要 AI 加速器時,它們不僅需要先進的工藝和先進的封裝,還需要台積電的產能和可預測性,以確保它們能夠快速提升產能並填滿其數據中心。台積電已經向蘋果證明了,它們能夠快速可靠地大規模生產多個複雜芯片。

財務實力上,台積電的市值接近1萬億美元,資產負債表非常強勁。他們的最終客户是開發和提供前沿LLM的公司:微軟、亞馬遜、谷歌、OpenAI,這些公司都是市值達到萬億美元的公司(或有望達到萬億美元)。他們希望選擇規模龐大、可靠且財力雄厚的供應商。

歸根結底,台積電最大的競爭優勢在於其管理實力與深度,以及其運營公司的系統/流程。台積電能夠處理分佈在多個國家的數十家晶圓廠的極其複雜的技術問題。他們的連續性是關鍵因素。

到 2030 年,GPU/LLM/HyperScalers 可能會成為台積電的主要客户。

如今,數據中心的絕大部分 AI 計算都基於 Nvidia,而 Nvidia 是台積電最大的客户之一。

AMD 目前的市場份額較小,但其 GPU 產品正在追趕 Nvidia;AMD 在擴展網絡和軟件方面仍有待改進,但看來他們的市場份額有望提升。客户希望擁有更多選擇,因此他們願意給 AMD 一個機會。6 月 12 日舉行的 Advancing AI AMD 活動展示了多家主要廠商使用 AMD AI 來支持其模型,並取得了良好的效果。

AMD 首席執行官蘇姿豐 (Lisa Su) 預測,數據中心 AI 加速器的潛在市場規模 (TAM) 將以每年 60% 以上的速度增長,到 2028 年將超過 5000 億美元!推理和訓練的配置比例正在快速變化。2025 年,兩者的比例約為 50/50,但到 2028 年,推理將佔 TAM 的 70%。預計到 2030 年,整個半導體市場將達到 1 萬億美元,因此 AI 數據中心正在成為市場的主力。

GPU 非常靈活。它們可以進行訓練和推理。但它們價格昂貴。

四大雲服務提供商(CSP)購買了英偉達約一半的產出,每家每年約合 200 億美元。如果市場增長速度達到 Lisa 和 Jensen 的預測,那麼四大雲服務提供商每年將購買近 1000 億美元的 GPU。

這意味着最大的超大規模計算公司和LLM公司擁有設計自有芯片的規模。他們設計自己的模型,因此他們確切地知道需要什麼硬件,並且可以構建更便宜的加速器,部分原因是他們可以省去不需要的硬件,部分原因是他們可以與利潤率更低的供應商合作,甚至直接與台積電合作。(他們仍然需要為那些為Nvidia/AMD設計模型的雲客户提供GPU)。

近十年來,亞馬遜和谷歌一直在設計各自的AI加速器。谷歌的第一篇TPU論文發表於2017年。亞馬遜於2015年收購了Annapurna Labs:該團隊設計了多代Inferentia和Trainium AI加速器。亞馬遜是台積電十大客户之一。

現在,所有主要的超大規模計算公司/LLM 都在構建自己的 AI 加速器,包括微軟 Maia、Meta MTIA,以及廣為傳聞的 OpenAI 和 xAI 的 AI 加速器項目。(唯一的例外是 Anthropic,它正在使用亞馬遜的芯片。)如今,這些公司正在與博通、Marvell、Alchip 以及其他能夠設計 2nm 或更低工藝、採用先進封裝和高速 PHY 芯片的公司合作。與亞馬遜一樣,一些超大規模計算公司/LLM 可能會決定收購現有廠商,進行整合,然後直接與台積電進行流片。

未來難以預測,但2030年最有可能的情況是,英偉達仍將是市場領導者,AMD的份額將遠超現在,而大型超大規模計算廠商/LLM廠商的定製AI加速器佔據了相當大的市場份額,亞馬遜、微軟、谷歌、Meta以及為其生產芯片的ASIC公司可能各佔10%的份額。這意味着到2030年,台積電的六大客户將是數據中心AI提供商。

台積電將在 2030 年代繼續保持 AI 代工廠的主導地位

超大規模/LLM 公司希望降低成本,但首先他們必須確保以高可靠性獲得所需的大量 AI 加速器。

英特爾和三星正在研發先進的製程節點和先進的封裝技術,但目前所有大型廠商都已100%依賴台積電。芯片公司將積極評估和考慮英特爾和三星,因為每個人都希望擁有更多選擇,但台積電的多重優勢將難以在短期內被英特爾和三星超越。

*聲明:本文系原作者創作。文章內容系其個人觀點,我方轉載僅為分享與討論,不代表我方贊成或認同,如有異議,請聯繫後台。