讓AI芯片設計像“樂高積木”一樣靈活-芯原AI戰略全揭秘_風聞

张国斌的芯时空-电子创新网CEO -一枚科技老炮儿,专注半导体25年!-1小时前

在AI技術爆發的當下,從智能手機、AR眼鏡、智能家電到邊緣服務器,AI算力已經成為新一代終端設備的核心競爭力,傳統CPU的通用計算能力正在讓位於更具效率和靈活性的專用計算單元。面對這一趨勢,芯原股份(VeriSilicon)基於自身豐富的處理器IP技術儲備,正在以一種“解耦+重組”的算力計算新範式,讓AI芯片像“樂高積木”一樣靈活,重新定義了AI處理器的設計。

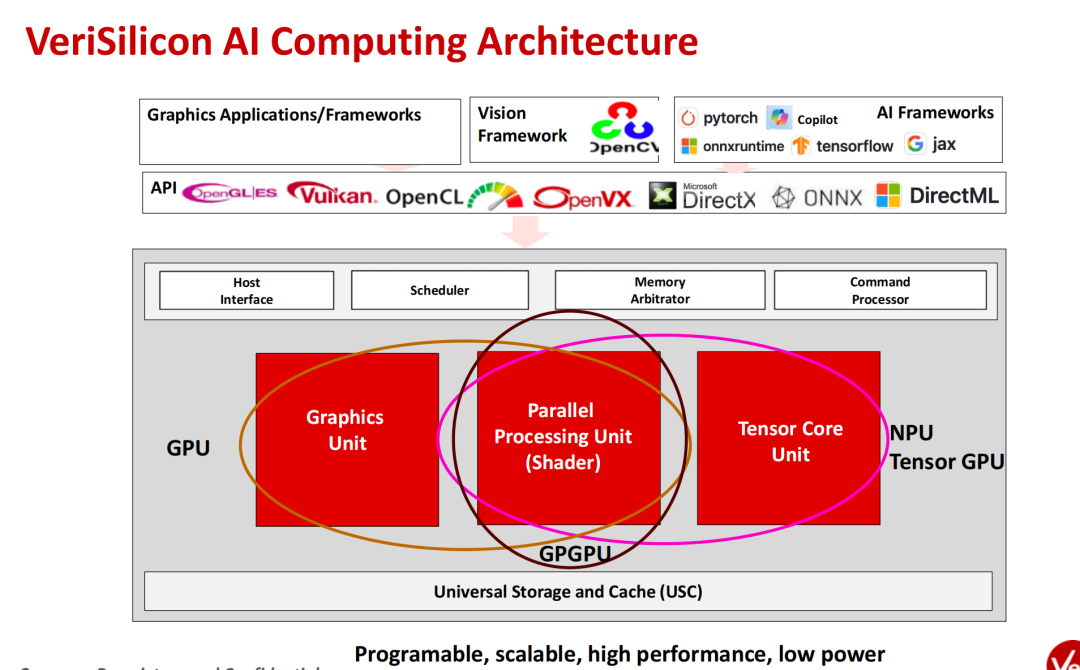

“AI 計算正在從CPU-centric轉向更加多元的架構,GPGPU、GPU、NPU三者共同構成了新的AI基礎設施。”芯原股份首席戰略官、執行副總裁、IP事業部總經理戴偉進在接受我的專訪時指出,“芯原擁有20多年GPU技術積累,在AI計算領域持續深耕,具備堅實的架構基礎。”

圖:芯原股份首席戰略官、執行副總裁、IP事業部總經理戴偉進大概是在2016年左右,一個採用我們GPU的歐洲客户問他們可否在圖形處理的時候加入一些圖像識別的處理能力,這就是較早期的AI計算需求。當時人工智能還沒有火起來,但我們認為這種需求未來有很大的發展空間,因為它激活了另一類計算需求。”他回憶説。

也就是從那時起,芯原開始佈局AI計算,以此構建自己的產品基石。

戴偉進表示芯原將AI算力架構劃分為三大類核心技術:

GPGPU(通用圖形處理器)

GPGPU主要承擔大部分通用AI計算任務。芯原基於20多年的GPU技術積累,已打造出具備高併發浮點運算能力的可編程架構GPGPU,適合各類AI通用計算場景。

NPU(神經網絡處理器)

芯原的NPU架構基於GPU的並行計算能力而延伸,支持深度學習推理和部分訓練任務,具備高效能與低功耗兼顧的能力。根據應用需求,還可通過不同的配置模式支持定製化AI計算。

GPU(圖形處理器)

芯原的GPU IP擁有20年的發展歷史,已在全球出貨超過20億顆。芯原的GPU架構還可以集成可配置的AI加速器,能夠加速AI和深度學習任務。此外支持多核擴展、單核內多簇擴展和單核內多處理單元擴展,能夠根據不同的算力需求靈活配置。

戴偉進表示這三種技術在芯原的產品矩陣中不是孤立存在,而是通過可靈活解耦的架構設計來進一步實現按需組合,形成一個“模塊化AI算力平台,如下圖所示。

實際上,芯原的AI計算芯片設計平台不拘泥於單一核結構,而是可以按需由多個功能IP模塊組合而成,這就是模塊化設計的真諦。每一個模塊都可以獨立裁剪、靈活替換或增強配置,以適配不同場景和客户需求。

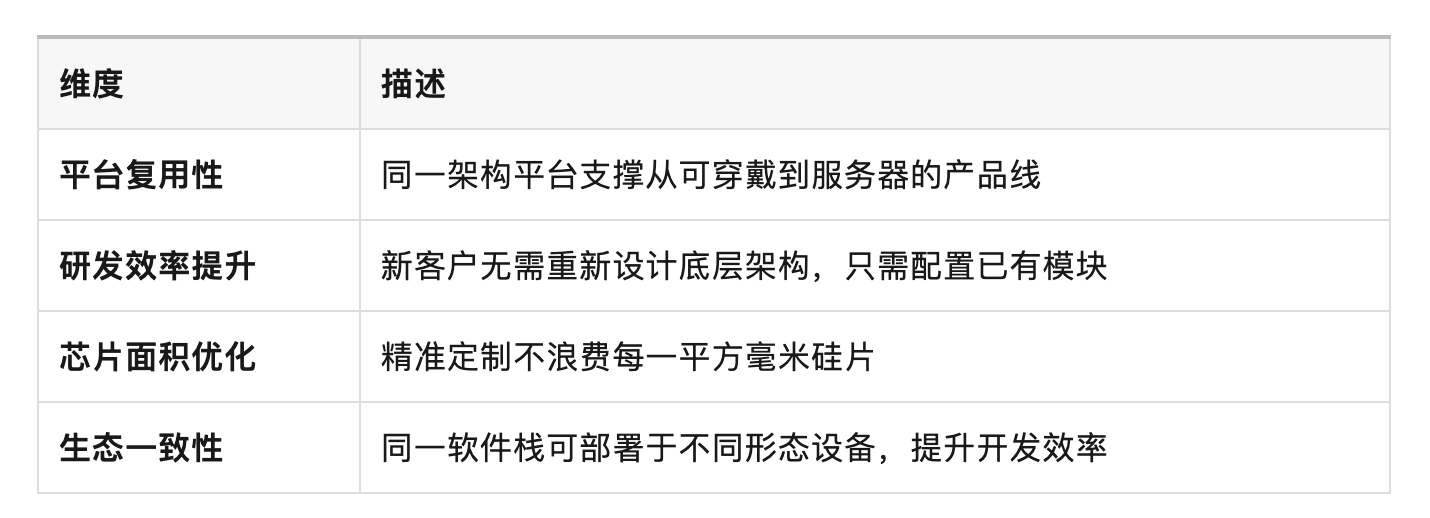

為什麼要模塊化?戴偉進表示模塊化是應對AI多樣化和碎片化應用的最優解,當今AI應用日趨碎片化:有的追求高算力(如大模型訓練),有的要求極低功耗(如語音喚醒),有的則重視低延遲和本地即時性(如AR眼鏡),如果用一個“通用大核”去覆蓋所有場景,會出現能效浪費、硅面積冗餘、功耗過高等問題,因此靈活的模塊化才是最優解。芯原可以按場景需要實現靈活配置與組合的方式。

例如,從超低功耗的AIoT設備到支持大模型推理的邊緣服務器,芯原均可基於統一架構平台提供定製化的“標準版/輕量版/增強版”解決方案。

芯原支持將多個IP模塊橫向拼接,實現從1 TOPS到上千TOPS的擴展。

多核集羣共享總線、統一調度;

典型用於:數據中心訓練/推理卡、邊緣訓練/推理設備、AI PC等;

還可使用Chiplet方式組合多個處理集羣;

芯原可根據客户的功耗預算、面積預算、模型類型、帶寬需求,對IP進行硬件級定製裁剪,實現量身定製的AI引擎。

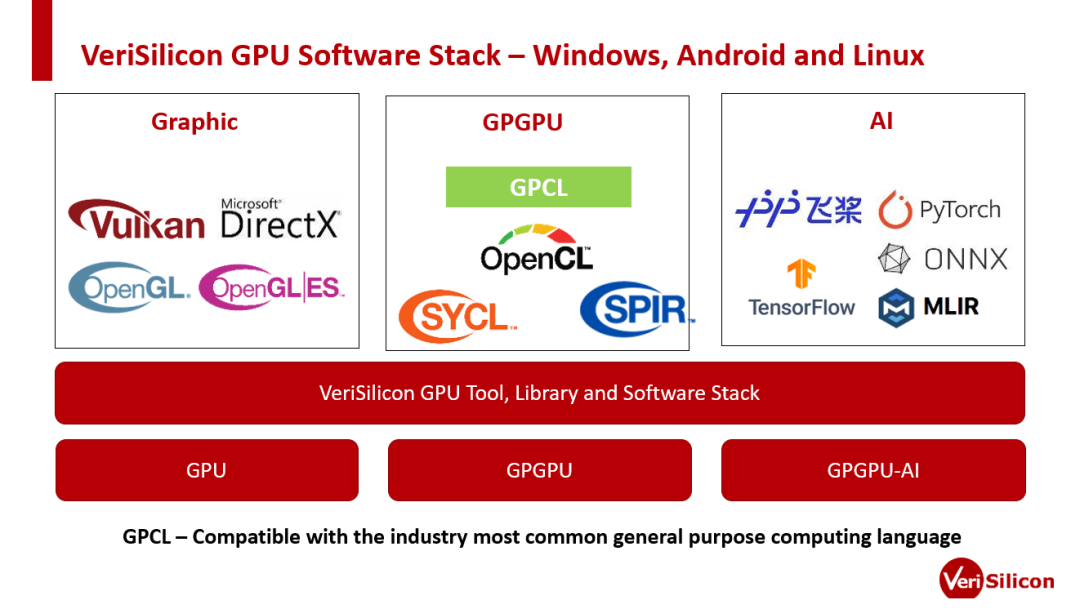

AI計算離不開軟件生態,戴偉進表示芯原構建了Acuity開發工具包,實現從模型編譯、優化到推理部署的全流程覆蓋,併兼容TensorFlow / PyTorch / ONNX / MLIR / Baidu Paddle,CUDA-like 接口用於GPU/GPGPU調度;支持 DirectML、XLA、ONNX Runtime的輕量訓練等。

這一軟件棧能在同一平台上高效運行圖像處理、視頻增強、Transformer、大語言模型等多種AI模型,支撐應用場景的快速迭代。

從“通用芯片”走向“定製平台”

戴偉進表示芯原的模塊化設計帶來四大優勢:

這就是為什麼芯原能夠在AR眼鏡、智能音箱、掃地機器人、AI PC甚至大模型訓練/推理服務器中,使用同一代NPU平台做“低配-中配-高配”的延展組合。

無論是4K智能攝像頭還是Always-on的家電控制器,客户均可通過模塊自由組合方式,構建最適配的AI引擎,這正是“像樂高一樣”的靈活性所在。

總結:模塊化讓AI芯片像“樂高積木”一樣靈活

戴偉進表示芯原的模塊化AI計算架構就像一個“樂高積木”平台:每一個IP模塊是標準化的“磚塊”,可以根據AI場景需要,自由“拼出”最佳組合,既兼顧效率,也不犧牲靈活性。

這種設計思路不僅是技術選擇,更是商業策略,它使得芯原能服務於眾多垂直客户、覆蓋廣泛應用場景,並快速響應AI算力不斷演進的趨勢。