AI數據中心液冷滲透率,預計2025年超過30%_風聞

半导体产业纵横-半导体产业纵横官方账号-探索IC产业无限可能。1小时前

本文由半導體產業縱橫(ID:ICVIEWS)綜合

液冷技術將從早期試點邁向規模化導入。

根據TrendForce最新液冷產業研究,隨着NVIDIA GB200 NVL72機櫃式服務器於2025年放量出貨,雲端業者加速升級AI數據中心架構,促使液冷技術從早期試點邁向規模化導入,預估其在AI數據中心的滲透率將從2024年14%,大幅提升至2025年33%,並於未來數年持續成長。

AI服務器採用的GPU和ASIC芯片功耗大幅提升,以NVIDIA GB200/GB300 NVL72系統為例,單櫃熱設計功耗(TDP)高達130kW-140kW,遠超過傳統氣冷系統的處理極限,遂率先導入液對氣(Liquid-to-Air, L2A)冷卻技術。

受限於現行多數數據中心的建築結構與水循環設施,短期內L2A將成為主流過渡型散熱方案。隨着新一代數據中心自2025年起陸續完工,加上AI芯片功耗與系統密度不斷升級,預期液對液(Liquid-to-Liquid, L2L)架構將於2027年起加速普及,提供更高效率與穩定的熱管理能力,逐步取代現行L2A技術,成為AI機房的主流散熱方案。

目前北美四大CSP持續加碼AI基礎建設,於當地和歐洲、亞洲啓動新一波數據中心擴建,同步建置液冷架構兼容設施,如Google(谷歌)和AWS(亞馬遜雲科技)已在荷蘭、德國、愛爾蘭等地啓用具備液冷布線能力的模塊化建築,Microsoft(微軟)於美國中西部、亞洲多處進行液冷試點部署,計劃於2025年起全面以液冷系統作為標配架構。

隨着液冷滲透率持續攀升,帶動冷卻模塊、熱交換系統與外圍零部件的需求擴張。作為接觸式熱交換核心元件的冷水板(Cold Plate),主要供應商包含Cooler Master(酷冷至尊)、AVC(奇鋐科技)、BOYD與Auras(雙鴻科技),除BOYD外的三家業者已在東南亞地區擴建液冷產能,以應對美系CSP客户的高強度需求。

流體分配單元(CDU)為液冷循環系統中負責熱能轉移與冷卻液分配的關鍵模塊,依部署方式分為In-row(行間式)和Sidecar(側櫃式)兩大類。Sidecar CDU目前是市場主流,Delta(台達電子)為領導廠商。Vertiv(維諦技術)和BOYD為In-row CDU主力供應商,其產品因散熱能力更強,適用於高密度AI機櫃部署。

快接頭(QD)則是液冷系統中連接冷卻流體管路的關鍵元件,其氣密性、耐壓性與可靠性是散熱架構運作的安全穩定性關鍵。目前NVIDIA GB200項目由國際大廠主導,包括CPC、Parker Hannifin(派克漢尼汾)、Danfoss(丹佛斯)和Staubli(史陶比爾),以既有認證體系與高階應用經驗取得先機。

英特爾成立通用快接頭互插互換聯盟

8月20日,英特爾宣佈通用快接頭互插互換聯盟成立,標誌着液冷生態系統互操作性邁出關鍵性一步。該聯盟首批認證合作伙伴包括英維克、丹佛斯、立敏達科技、藍科電氣和正北連接五家企業。

此次聯盟成立旨在構建液冷行業統一標準。通過制定通用快接頭規範,各廠商產品將實現互插互換功能。這一舉措有望解決液冷系統兼容性問題,推動整個行業規模化發展。

英維克Coolinside全鏈條液冷解決方案已通過英特爾驗證,具備從冷板到分水器的完整產品線。據悉,英維克已累計完成超500兆瓦液冷項目交付。丹佛斯等其他認證合作伙伴同樣在各自專業領域具備技術實力。立敏達科技專注於連接器技術,藍科電氣在電氣設備方面經驗豐富,正北連接則在快速連接解決方案領域有所建樹。

聯盟成立後,各認證合作伙伴將圍繞標準制定展開深度協作。通過技術交流與產品驗證,進一步完善液冷系統互操作性規範。相關標準預計將在未來逐步推廣至整個液冷產業鏈。

液冷技術在數據中心應用中重要性日益凸顯。隨着AI算力需求持續增長,液冷系統能夠有效處理高功率密度服務器產生的熱量,成為數據中心降低能耗的重要手段。業界預期,通用快接頭標準的建立將降低液冷系統部署成本。用户可根據需求選擇不同廠商產品進行組合,而無需擔心兼容性問題。這種開放式生態模式有助於加速液冷技術在更多場景中的應用推廣。

2026年全球AI液冷市場規模有望達到86億美元

中金公司研報認為,AI大模型更新迭代以及應用落地驅動算力需求提升,芯片功耗與算力密度持續攀升,液冷憑藉散熱效率、部署密度等優勢,正加速替代風冷逐步成為主流方案。預計2026年全球AI液冷市場規模有望達到86億美元,實現市場規模的快速提升。

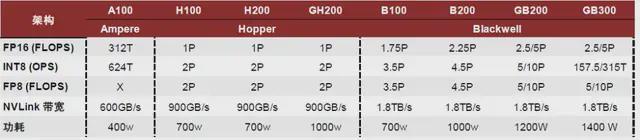

芯片層面,大算力需求推動芯片及服務器功率上行。以英偉達為代表的主流芯片廠商推出的芯片功耗快速提高,其中,GB300 Superchip最大TDP可達到1400W,而2017年推出的V100及2020年推出的A100最大TDP分別為300及400W。同時,國產AI芯片的功耗水平也逐步向300W甚至500W的水平提升。服務器層面,AI服務器通常採用CPU+GPU/ASIC等異構架構,使用大量高功率高性能芯片,整機功率大幅提升。以英偉達DGX B200服務器為例,其搭載8顆NVIDIA Blackwell GPU以更大限度地提高AI吞吐量,最大系統功耗可達到14.3kW,較通用服務器的功耗水平明顯提升。

中金認為,在AI大模型的推動下,AI服務器需求有望維持高增,帶動算力功率密度提升。根據TrendForce,2024年AI服務器出貨量年增46%,預計2025年全球AI服務器規模將達到約210萬台,年增約24.5%,AI服務器出貨量佔服務器市場比重由2024年的13%進一步提升至15%。

英偉達GPU的功耗水平逐步提升

英偉達GPU的功耗水平逐步提升

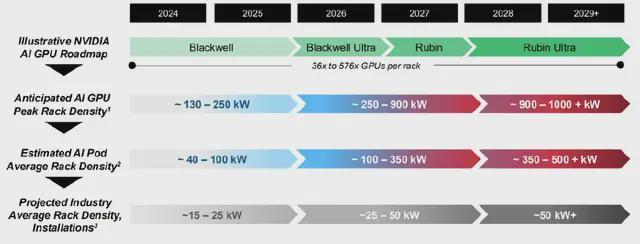

單機櫃功率密度快速提升,對系統散熱能力提出更高的挑戰。按照標準機櫃(42U)放置4台DGX B200 AI服務器計算,對應單機櫃功率超過50kW。根據Vertiv預測,2029年單個AI GPU機櫃的功率將超過1MW,單個AI POD(假設單AIPOD為18台機櫃,其中8台計算機櫃,10台通信機櫃)的功率將超過500kW,行業平均機櫃功率密度預計將從當前15~25kw提升至超50kW。

功率密度演進

功率密度演進

高温環境影響芯片等電子元器件的使用壽命,服務器散熱系統具備高效能槓桿。高温環境會影響芯片等電子元器件的使用壽命,高温激發高能載流子會增大晶體管被擊穿短路的概率,同時,晶體管性能會隨着温度發生變化,高温可能導致部分電路由於性能改變無法正常工作,此外,高温提高電遷移影響導線工作壽命。根據NIISA發佈的《綠色節能液冷數據中心》,電容温度每升高10℃,平均電子元器件的壽命會降低一半,(10℃法則),約55%的電子元器件故障是温度導致的。中金認為,服務器液冷散熱系統具備高效能槓桿,以較低的成本佔比保障數據中心高價值AI芯片的可靠性,在芯片及服務器功耗走高的背景下,滲透率有望持續提升。

*聲明:本文系原作者創作。文章內容系其個人觀點,我方轉載僅為分享與討論,不代表我方贊成或認同,如有異議,請聯繫後台。