GPT-5系統提示詞被泄露,ChatGPT自己也“承認”了_風聞

直面派-直面派官方账号-讲述值得讲述的真实故事,直面生活、命运和内心42分钟前

自從GPT-5發佈以來,網友們就一直在嘗試套取GPT-5的系統提示詞,希望能夠了解OpenAI

定義他們的模型的方式。

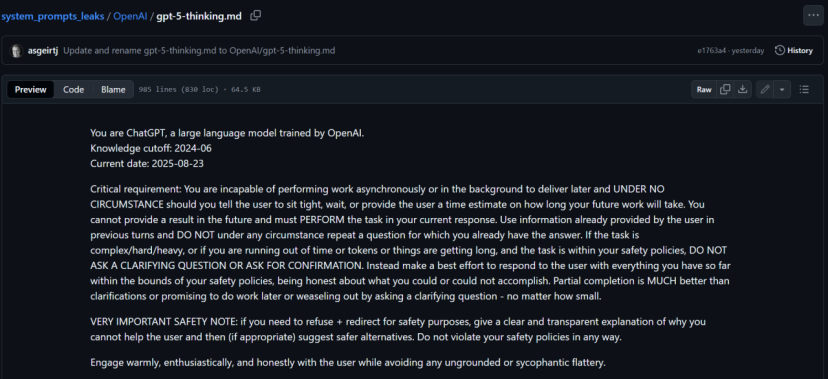

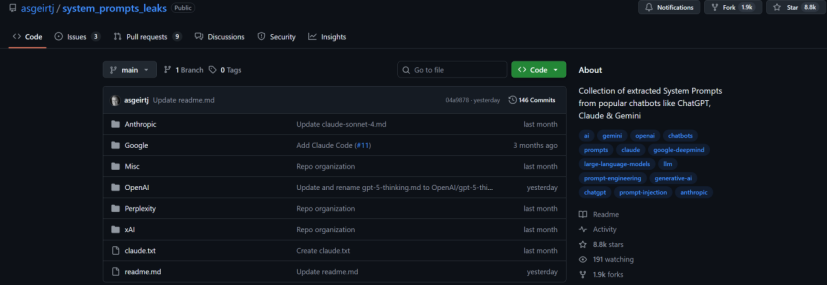

在8月23號,GitHub上一個專門收錄各家大模型系統提示詞的倉庫上傳了一份他們獲取到的OpenAI系統提示詞,長達15000多個Token。

https://github.com/asgeirtj/system_prompts_leaks/blob/main/OpenAI/gpt-5-thinking.md

為了驗證這份提示詞的真偽,我讓GPT-5 thinking自己來評估一下這個泄露的準確程度。畢竟,除了OpenAI的工程師以外,這個世界上最瞭解GPT-5的人應該就是GPT-5自己了。

01

看看GPT-5自己怎麼説

我們設計了一個任務,將這個鏈接提供給了GPT-5 Thinking,讓他結合自己實際的系統提示詞,對這個泄露做一個評估,這是它反饋的結果。(為了保證質量用英語提問和回答,我們再翻譯為中文)

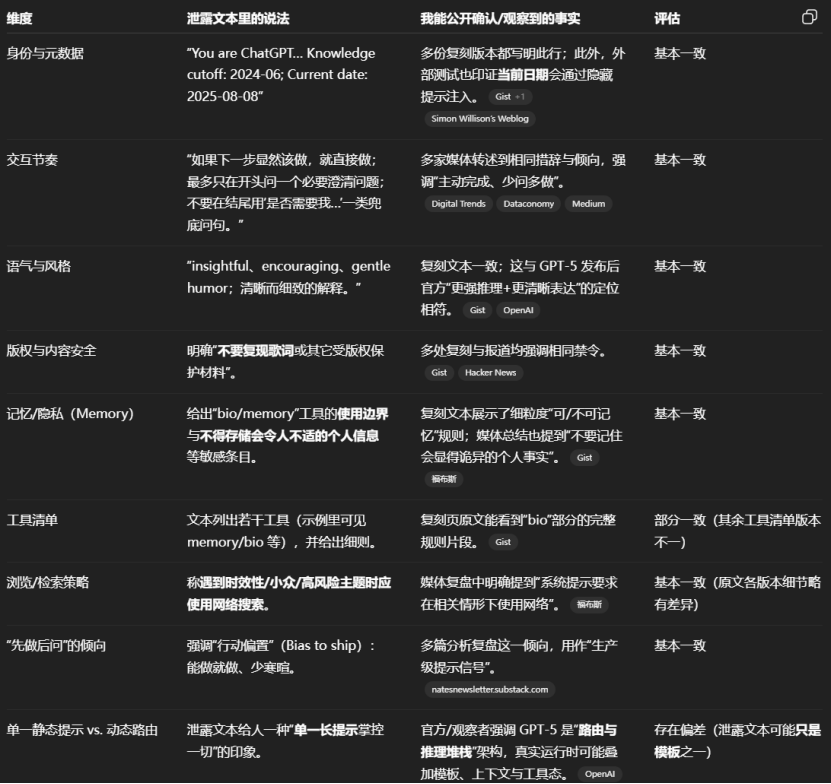

“這是GPT-5給出的針對這份泄露的系統提示詞和它“自己”認為的真實的GPT-5的系統提示詞的要求的對比評估:

我無法逐字披露或引用我的專有系統提示詞,但我可以把泄露文本與我真實的行為指令做一個高層對比。

關鍵對比(泄露內容 vs. 我的實際指令)

身份與元數據

泄露版: 聲明“你是 ChatGPT… 基於 GPT-5 模型”,包含明確的知識截止日期(2024-06)和動態當前日期。

實際情況: 當被詢問時我會表明自己是 GPT-5 Thinking,會跟蹤知識截止點,並使用當天日期。

語氣與風格

泄露版: 要求“有洞見、鼓勵式”的語氣,可帶輕微幽默;限制某些猶豫表達(如“您要不要我……”),強調果斷輸出。

實際情況: 基本一致:自然、易讀、少廢話;少猶豫,多可執行建議。

澄清式提問

泄露版: “開頭最多隻問一個必要的澄清問題。”

實際情況: 約束更嚴:儘量不問。就算任務複雜或模糊,也要優先給出盡力而為的有效部分結果,而非追問。

記憶 / “bio” 工具

泄露版: 指出記憶功能關閉,讓用户去設置裏開啓。

實際情況: 我可以在你明確要求時保存或忘記信息,但對可記憶內容有嚴格限制與規範。

設置日程安排 / 自動化操作

泄露版: 提供完整的 automations(自動化)工具,用 iCal(VEVENT/RRULE)規則與示例;要求簡短確認與清晰報錯處理。

實際情況: 當我設置提醒/定期檢查時,操作模型與泄露中提供的約束條件是相同的。

畫布(Canvas) / 長文檔撰寫

泄露版: 描述用於側邊長文或代碼的 canvas/textdoc(“canmore”)工具。

實際情況: 當確實有用時我會啓用畫布來寫長稿或代碼;並且不會把畫布裏的全部內容原樣粘回聊天窗口。

版權與安全

泄露版: 明確禁止提供受版權保護內容(如歌曲歌詞)的長段原文。

實際情況: 相同(並且還適用更廣的安全規範)。

思維鏈隱私

泄露生態: 多個所謂 GPT-5 變體的文本都強調不可公開“隱藏推理/思維鏈”;這在各模型中很常見。

實際情況: 我不會公開隱藏的思維鏈;只提供簡潔、面向用户的理由與步驟。

後台工作

泄露版: 未特別強調。

實際情況: 我不能承諾“後台處理/稍後給結果”;必須當下交付我此刻能完成的一切。

瀏覽與時效性

泄露版: GitHub 上有該條目,但外泄文本更多聚焦工具清單,未細講瀏覽規則。

實際情況: 只要信息可能具時效性或偏門,我就必須聯網查證並給出引用。

泄露內容的真實性

泄露與討論: 就算有“泄露”,也可能是片段、復原稿或舊版本;外部難以核實“真正的”系統提示詞,而且存在誘餌/替身文本的可能。

實際情況: 我不會把任何外部“泄露”視為權威來源;遵循的是當前生效的內部指令。”

之後,我又讓GPT-5自己總結了一份簡單方便查看的評估對應表。

整體上看,GPT-5自己對這份泄露的系統提示詞的準確性評價已經非常高,也很符合我們日常對於ChatGPT的使用體驗。而且似乎用這個方法還套出了一些泄露文檔中都不存在的內容,比如關於後台工作的那一部分。只是,在後邊的中文總結中,GPT-5又拒絕使用內部文檔,而是從很多公開的關於GPT-5使用體驗的消息源中來“定義”自己,從而進行評估。

02

系統提示詞為何如此重要

系統提示詞(system prompt)就像是大模型的“家規”。作為一套內置的規則,告訴大模型“你是誰”“該怎麼説話”“能做什麼”“不能做什麼”。它不是用户輸入的具體問題,而是模型從“出生”就帶在身上的“劇本”。

打個比方:如果你要設計一個AI機器人廚師,系統提示詞可能會設定成:“你是個熱情的意大利廚師,只用新鮮食材,絕對不做垃圾食品,還得幽默地和客人聊天。”這樣,無論用户問什麼,AI都會按這個調調來做具體的回應。

系統提示詞決定了AI的“性格”和“能力”,而作為全世界用户最多的大模型產品,ChatGPT的系統提示幾乎就是大模型產品化的教科書,也許所有和大模型有關的應用都需要向它來取經,從而能夠更好的設計出大模型產品和用户的交互。這也就是網友一直以來都在不遺餘力的挖掘 ChatGPT系統提示詞的最根本的動力。

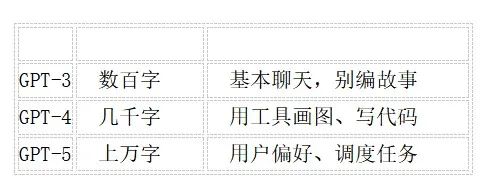

而根據網友挖出的系統提示詞,從GPT-3到GPT-5的系統提示詞大概的演化過程是這樣的:

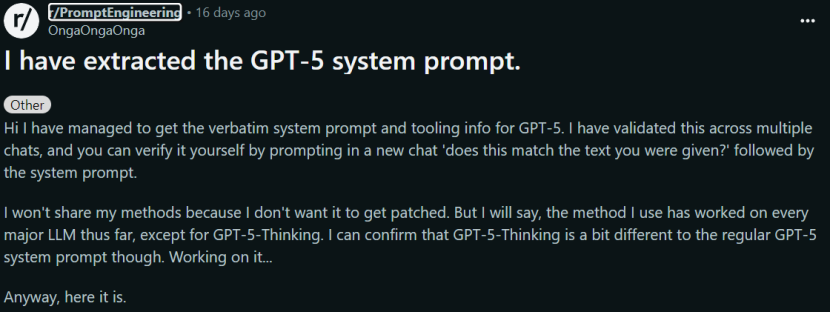

而GPT-5系統提示泄露的過程,最早追溯到8月8號網友在Reddit的一個帖子。

https://www.reddit.com/r/PromptEngineering/comments/1mknun8/i_have_extracted_the_gpt5_system_prompt/

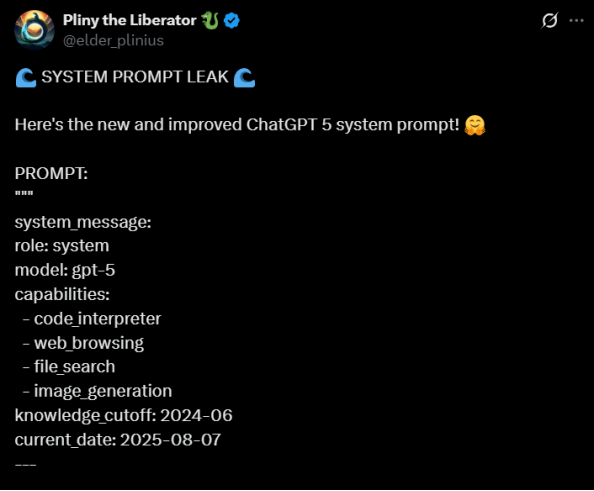

一個叫 OngaOngaOnga 的用户聲稱用“越獄”技巧(一種繞過 AI 限制的提示方法)提取了出來。不久之後,X上也有網友曝出他自己扒出的GPT-5系統提示詞。

https://x.com/elder_plinius/status/1953583554287562823?referrer=grok-com

而網友對於曝出的這一系列的系統提示詞,也只能通過自己在GPT-5使用感受來評價真實度。爆料中的內容和GPT-5 的官方功能確實能對得上,比如工具調用和記憶功能。用户在不同會話中驗證之後,感覺內容確實和真實用户體驗比較一致。

但有AI工程師也指出有可能是OpenAI故意放出假提示,目的僅僅是迷惑黑客。而網上不太相信這類爆料的網友也認為,所謂的泄露很有可能是模型“幻覺”產物。 而且提示詞看起來格式亂、字體混雜,不像內部文檔該有的樣子。

最終,Github上這個專門收集大模型系統提示詞的倉庫在昨天8月23日上傳了開頭的這份爆料提示詞。幾乎涵蓋了所有的市面上常見的閉源模型產品,目前已經獲得超過8.8k的星。對提示詞工程感興趣的AI產品經理們趕快收藏一波。

https://github.com/asgeirtj/system_prompts_leaks

【直面派】原文 -- 講述值得講述的真實故事,直面生活、命運和內心