AI都有“代餐”和“預製菜”了!後果嚴重!_風聞

秦朔朋友圈-秦朔朋友圈官方账号-9小时前

10月30日,英偉達成為人類第一個市值跨過5萬億美元門檻的公司,人工智能的發展被繼續提速。

但在這場舉世矚目的繁榮背後,很少有人真正關注到一個更深層次的危機正在悄然醖釀:AI的野蠻生長已經到了臨界點,合成數據正以驚人速度碾壓真實數據。

各類語言大模型對數據的胃口普遍到了令人恐怖的程度——ChatGPT的訓練數據達到45TB,包含近萬億詞的文本,GPT-5的數據需求更加驚人。

然而互聯網並不是無限糧倉,研究預測顯示高質量文本數據最早將在2026年至2032年間被耗盡。

面對“數據荒”,AI產業正在進行一場看似完美的自救——用AI生成的“合成數據”來填補黑洞。

但這場自救隱藏着一個深刻的悖論:當AI越來越多地以AI生成的數據為食時,錯誤和偏見在封閉循環中被無限放大,模型性能逐代退化。

數據失真問題不會隨着AI的發展而自我解決,反而會越來越嚴重。最終的結果是,真假難辨、無法自拔的惡性循環正在形成,而這一切的代價,可能遠比市場看到的那5萬億美元要深遠得多。

合成數據:AI代餐預製菜

互聯網正在成為AI模型的“獵場枯竭區”。ChatGPT訓練所用的45TB文本數據,對標的是近萬億詞的語料庫,這個規模已經是互聯網歷史上最大規模的數據採集。

真實數據的供給之所以捉襟見肘,不僅因為量少,還有質劣和限制多重疊加。現實數據天然充滿噪聲、錯誤和偏見,網絡文本魚龍混雜,有研究顯示ChatGPT等大模型已經從訓練語料中繼承了胡編亂造和傾向性之類的問題。

同時,全球隱私法規日趨嚴格,大量涉及個人隱私的真實數據無法直接用於AI訓練。

歐盟《通用數據保護條例》GDPR、中國《數據安全法》等一系列規定讓用户的聊天記錄、郵件內容、醫療檔案等雖然對訓練有價值,卻受法律保護不可濫用。

在這樣的夾縫中,“數據荒”成為橫亙在AI繼續進化道路上的巨大障礙。

在這種被逼無奈的背景下,合成數據應運而生。它宣稱可以一舉化解傳統數據供給的多個難題。

理論上,只要算力充足,合成數據可以按需無限生產,不像真實數據受制於人類活動和採集週期。

人工標註一張圖像約需6美元,而用生成算法合成僅需0.06美元,成本優勢達到百倍。

合成數據的生產速度很快,利用雲端集羣幾天即可產出數十萬張圖像,傳統實地採集可能要數月甚至數年。

在隱私合規上,合成數據不直接引用具體個人信息,被視為一種隱私增強技術。使用合成患者病歷訓練AI診斷模型,可以避免觸碰真實病人的隱私。用仿真交易數據訓練金融風控模型,不會違反用户數據保護規定。

這些誘人的前景讓合成數據正快速從實驗室走向產業。諮詢公司Gartner曾預測,到2030年合成數據將成為AI主要訓練源。

市場研究機構預計全球合成數據市場規模將以每年50%以上的速度增長。科技巨頭紛紛投入開發合成數據工具鏈。微軟、亞馬遜、谷歌等在雲服務中都提供自動化合成數據平台。在自動駕駛、機器人等垂直領域,一批垂直領域的合成數據創業公司快速崛起,融資熱度不減。

數據循環中的自我毒害

當AI開始大量以自食其力生成的數據為食時,一個致命的邏輯鏈條隨之啓動。這不是新穎的理論警告,而是已經被學術界用嚴謹實驗驗證的現實風險。

最近發表於《Nature》的研究給了這一現象一個明確的定義:模型崩潰是一個退化過程,模型生成的內容會污染下一代訓練數據,新模型在被污染數據上訓練後愈發誤解現實。

這個過程類似於近親繁殖或閉門造車,AI模型只和自己的“後代”對話,不再接觸新鮮真實的信息,最終會遺忘原有的見識,變得愈發愚鈍和偏狹。

實驗數據足夠駭人。研究人員用維基百科文章訓練了初代模型,讓其續寫中世紀建築的文本。前幾代的輸出看起來尚可接受,但隨着合成數據迭代訓練,模型的回答逐漸語無倫次。到第五代時,輸出內容已經完全與輸入無關,充斥無意義的字符。到第九代時,模型已經徹底迷失自我,開始羅列兔子名字,離題萬里。

這不是孤立案例。劍橋大學和牛津大學的研究用125M參數的小模型驗證了相同的規律:只需用幾代模型生成的數據訓練數輪,模型性能便急劇滑坡。更可怕的是,這種退化一旦開始,就會呈現指數級加速。

Meta的模擬實驗揭示了更險惡的規律:僅1%的合成數據摻入都可能令大模型性能出現顯著下降。而且這個規律有一個明確的傾向——模型規模越大,崩潰現象越嚴重。參數越多的模型,對合成數據的“毒性”越敏感。這意味着那些性能最強、最受關注的大模型,反而最容易在合成數據的侵蝕中走向崩潰。

這不僅僅是技術層面的問題,更是一場關乎整個產業生態的危機。如果最先進的模型率先陷入這個泥沼,後續的研發和應用勢必受到致命打擊。

從幻覺到長尾消失

隨着合成數據的深度迭代使用,AI生成內容的質量開始出現多維度的惡化。

首先是“幻覺”加劇。模型輸出看似合理,實則荒誕,這種胡編亂造在每一輪迭代中都被強化而非糾正。

如果初代模型的輸出本身就含有錯誤,第二代模型學到的就是這種錯誤的模式,第三代則進一步強化了這種錯誤。錯誤像基因突變一樣在傳遞中累積放大。

其次是多樣性的衰減。模型往往高頻複用前代數據中常見的模式和詞句,輸出內容日趨單一和刻板,語言的豐富性逐步被侵蝕。

在圖像領域,實驗發現多代合成訓練後,生成的圖像細節盡失,風格趨同。最初幾代還像模像樣,迭代數次後畫出來的物體已經“面目全非”,失去真實世界的多樣性。

最嚴重的是長尾知識的消失。因為AI生成的數據大多基於主流模式,很少涵蓋極端或罕見情況,模型對長尾分佈愈發陌生。用合成常見路況訓練的無人車模型,可能完全沒有見過真實世界中特殊天氣或奇異交通行為的場景。

這對安全要求極高的應用領域,如醫療診斷、自動駕駛、金融風控,構成了致命威脅。一個從未見過罕見疾病的診斷模型,可能在面對真實患者時徹底失效。

危機的工程學答案

不過,模型崩潰並非完全不可避免,而是可以用適當的工程方案加以解決。Nature的實驗確實顯示了危險,但同時也揭示了臨界點:當合成數據比例保持在30%~50%以下,並與高質量真實數據混合時,模型性能的退化曲線趨於平緩。

這意味着“崩潰”不是合成數據本身的原罪,而是比例失控的後果。

已有的緩解方案正在被實踐驗證——

真實數據的“硬槓桿”設置:強制保持訓練集的50%~70%來自真實世界,可以有效阻止熵坍塌;

更精細的詞元級編輯技術,即在真實句子上做細粒度改寫而非完全生成,同等數據量下能將困惑度降低8%~12%;

分佈校正則通過重採樣和重要性加權保留低頻樣本,恢復長尾覆蓋率20%以上;

在醫療影像等高風險領域,引入人機協同驗證機制,由專家對關鍵樣本進行審計反饋,誤報率從9%降至3%;

物理仿真加真實閉環的方案:用仿真生成邊緣場景,再用真實路測校準,讓英偉達的自動駕駛路測事故率下降了18%。

這些都不是理論設想,而是已經寫入TensorFlow、NVIDIA Omniverse和微軟Azure中的開源工具。問題的關鍵不在於AI公司們能不能做到,而在於有沒有意願堅守。

危機解法需要新的激勵

工程學的工具箱已經備好,但為什麼企業仍在鋌而走險?答案很簡單:成本。把真實數據比例寫進代碼是容易的,困難的是在商業競爭中堅守這條底線。

監管框架本應阻止這種滑落,但現實的監管空窗讓企業有了充足的騰挪空間。GDPR和《數據安全法》確實要求“可審計”,但在AI訓練的源頭,這一要求形同虛設。

要打破這個悖論,需要改變激勵結構本身。監管部門必須讓“保留真實”成為最便宜、最安全的選項,而非最昂貴的道德選擇。

首先是建立真正有約束力的准入門檻。醫療、金融、自動駕駛等關鍵領域的訓練集必須包含50%以上的真實數據,低於這個紅線就無法獲批上線;

其次是建立可追溯的質檢機制。企業需要公開數據來源和檢驗報告,虛假標註將被視為“不合格產品”進行處罰;

第三是改變違規成本的天平。高額罰款加行業黑名單,讓“偷工減料”比“老實採購”更貴。

同時,政府應該主動降低企業獲取真實數據的成本,這是改變市場選擇的另一把鑰匙。

結語

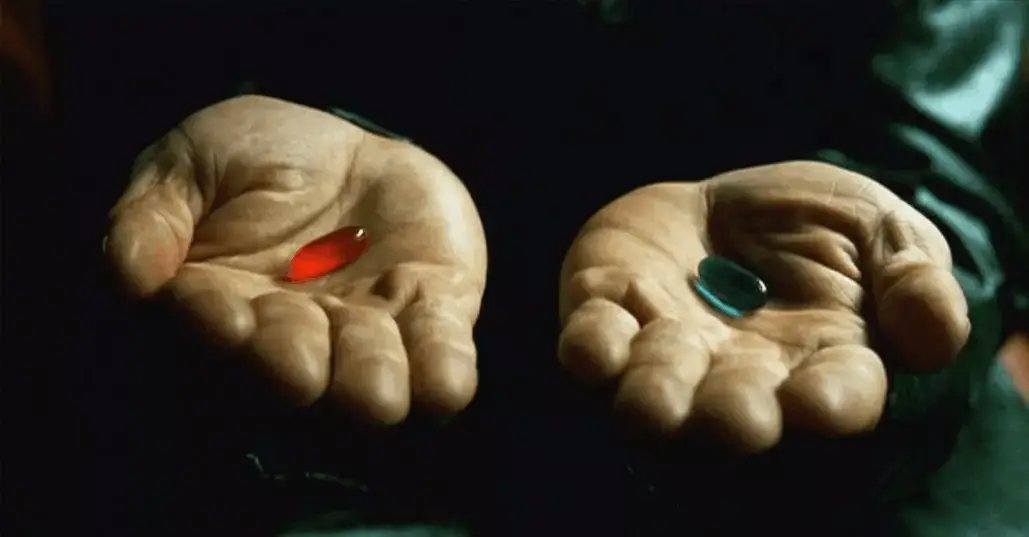

在電影《黑客帝國》中,按照建築師的説法,母體Matrix系統曾經連續6次崩潰,而原因並不是因為它使用了虛擬數據——整個系統本身就是虛擬的。

真正的致命之處在於系統徹底斷開了與真實世界的聯繫,走進了一個完全的自我循環。

但電影也留下了一條逃生之路:只要系統保留一條與真實世界對話的“後門”,崩潰就可以被識別、被重啓、被修復。

今天,我們面對的AI危機其實也有同樣的“逃生鑰匙”。問題不在於能不能使用合成數據,而在於有沒有意願保留“真實的插頭”。

當真實數據的比例被強制鎖定在30%以上、當每條合成樣本都標上溯源標籤、當困惑度指標連續下降時系統自動告警,模型崩潰就從“宿命”變成了“可控的邊界”。

這些都不是黑科技,而是工程學已經提供的、成熟的解決方案。

英偉達、微軟、谷歌已經在雲服務中提供了質檢和溯源的功能,但沒有強制性的要求,企業就會選擇忽視。歐盟的《AI法案》、中國的《數據安全法》提出了可審計的要求,但如果只在部署階段補救而不在訓練源頭把關,監管就形同虛設。

所以,沉重的現實擺在面前!要麼現在就設定清晰的工程紅線,讓合成數據永遠被真實世界的“抗體”錨定;要麼繼續在短期效益的誘惑中滑行,直到有一天發現AI系統已經徹底迷失在自己的幻覺裏,如同Matrix那樣無法逆轉。

—— · END · ——

No.6617 原創首發文章|作者 朱兆一