全球首個端到端抓取大模型發佈,國產機器人攻克大瓶頸?

连政gczhewanxgun

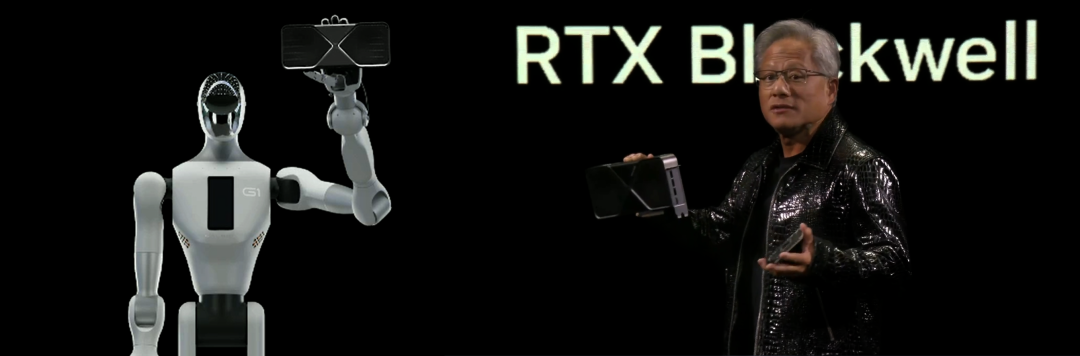

在剛剛結束的 NVIDIA CES 2025 發佈會上,全場唯一的輪式人形機器人託舉起了英偉達新一代顯卡產品 RTX5090 引發關注。而該機器人正是來自北京銀河通用機器人有限公司的Galbot。

與此同時,在英偉達位於美國拉斯維加斯 Fountainebleu 展台上,Galbot 機器人還首次進行了真機演示。觀眾在現場24小時無人值守的便利店場景中,通過iPad模擬下單,即可體驗機器人在便利店中取貨、送貨的便捷服務。

Galbot 憑藉高效、流暢的工作展示,也讓其背後的銀河通用具身大模型技術和創新成果走向台前。1月9日,銀河通用對外正式發佈GraspVLA,號稱全球首個端到端具身抓取基礎大模型(Foundation Model)。

據銀河通用介紹,GraspVLA 的訓練包含預訓練和後訓練兩部分,其中預訓練完全基於合成大數據。即無需大規模真實數據、僅通過合成數據達到基礎模型的預訓練過程,和進一步通過小樣本微調使基礎“通才”快速成長為指定場景“專家”的能力,解決了世界範圍內具身通用機器人當前發展的兩大瓶頸—— 數據瓶頸和泛化瓶頸。

此外,針對特別需求,GraspVLA 的後訓練則僅需小樣本學習即可遷移基礎能力到特定場景,維持高泛化性的同時,還能形成符合產品需求的專業技能。

僅通過合成大數據的預訓練

就可以實現充分泛化

具體而言,銀河通用提出了 VLA(視覺-語言-動作模型) 達到基礎模型,所需滿足的七大泛化情況,並以GraspVLA進行展示。

**光照泛化。**咖啡廳、便利店、生產車間、KTV 等不同光照條件下,光線的冷暖、強弱變化,包括漸變和驟變,以及在極端黑暗環境下移動目標物體時,模型都應該具備準確找到並正常抓取物體的能力。

文內圖片展示包括2倍、3倍或5倍速。“銀河通用”公眾號

**背景泛化。**實際環境中,機器人工作場景不盡相同,模型需要面對不同材質、不同紋理的桌面和操作枱,甚至動態變化的背景畫面。

**平面位置泛化。**模型還需要面對將物體在桌面上隨意平移、旋轉的情況。

**空間高度泛化。**即使面對物體擺放高低錯落的工作台,模型也應該可以從容抓取。

****動作策略泛化。****模型應即時進行推理決策,不僅會移動跟隨目標,對於物體豎放、倒放等不同擺放方式,還可根據物體和夾爪的位姿自動調整策略,選擇最安全合理的抓取方式,處理複雜情況。

**動態干擾泛化。**真實工作場景複雜多變,機器人在執行任務時常常會受到干擾。在工作過程中,即使往工作空間中隨意添加干擾物體,甚至發生撞擊並使目標物體隨機移位,模型也需要可以穩定地完成任務。

**物體類別泛化。**銀河通用稱,在上述測試中,所有物體、場景、擺放方式均未進行任何訓練,GraspVLA 僅通過仿真合成數據學習到的語義和動作能力,就實現了在真實世界中零樣本泛化測試。

此外,通過把仿真合成的動作數據和海量互聯網語義數據巧妙地聯合訓練,對於沒有學習過動作數據的物體類別,GraspVLA 也能把已掌握的動作能力泛化遷移:

通過少量真實數據的後訓練

即可滿足特定場景特殊需求

另一方面,經過合成大數據的預訓練,GraspVLA 已經天然滿足大多數應用需求,但是在產品和特定場景中常常有一些特殊需求,因此模型需要擁有對新需求的快速適應及遷移能力。

銀河通用介紹,以商超場景為例,用户希望模型按照順序取出同類商品。為滿足用户需求,針對一箱怡寶礦泉水,僅需採集少量(少於一個人遙操一天)的真實數據,就能讓 GraspVLA 理解並滿足按序抓取的需求。

GraspVLA在經過怡寶一人/天採集數據的後訓練,就可以舉一反三,將這種少樣本習得的行為自動遷移到其他品牌的飲品(農夫山泉、東方樹葉),按擺放順序分別抓取了瓶身顏色不同,瓶蓋大小不一的同類商品。這展現了天量合成大數據預訓練達成的基礎模型。

工業場景中,往往有大量行業專用的特殊零件。雖然模型僅需預訓練就可以抓起任意零件,但難以直接根據語言指令抓起對應物體,比如指定“抓取車窗控制器”,但模型抓起了接線座。

為了提升模型識別罕見零件的能力,僅需採集少量軌跡進行快速後訓練。GraspVLA 就可以迅速掌握諸如接線座(Wiring Base)、三角板(Triangular Panel)、黑色軟管(Black Hose)等特殊工業名詞,能從任意擺放的密集場景中精準找出對應零件。

在家庭場景中,人們對機器人的行為會有特定的偏好,例如抓取杯子時不要碰到杯子內壁。同樣通過採集少量帶偏好的抓取軌跡,GraspVLA 即可學會按照自然語義抓取。

對此,銀河通用表示,這種預訓練全合成大數據方案在人力和資金投入上成本更低,時間效率更高,可持續發展性更好,也是 VLA 模型商業化應用中必備的能力。

本文系觀察者網獨家稿件,未經授權,不得轉載。