騰訊混元又更新,可讓高達跳舞的圖生視頻功能上線

胡祥熙

3月6日,騰訊混元保持此前的高強度更新,又正式推出了開源的圖生視頻模型,同步開放視頻生成、對口型及動作驅動等趣味功能,並支持2K高清視頻與智能背景音效生成。用户現可通過官網或API接口快速體驗這一創新技術。

本次更新的核心功能亮點是靜態圖轉動態視頻。在上傳任意圖片後,通過簡單文字描述畫面運動方式(如物體移動軌跡或鏡頭運鏡),模型即可生成5秒動態短視頻,並自動匹配契合場景的背景音效。智能口型同步。

上傳人物肖像後,輸入文字內容或音頻文件,AI將精準驅動人物口型,實現説話或歌唱效果。結合預設舞蹈模板,靜態圖片人物還能一鍵生成流暢的舞蹈視頻。開發者生態支持:

本次開源的130億參數模型覆蓋寫實、動漫及CGI角色生成場景,提供完整模型權重、推理代碼及LoRA訓練代碼。開發者可通過騰訊雲API接入服務,或在GitHub、HuggingFace社區下載資源,基於基礎模型訓練定製化衍生模型(如專屬LoRA),拓展多元視頻創作可能性。

目前,個人用户可訪問混元AI視頻官網直接體驗,企業級用户可通過騰訊雲申請API集成服務。

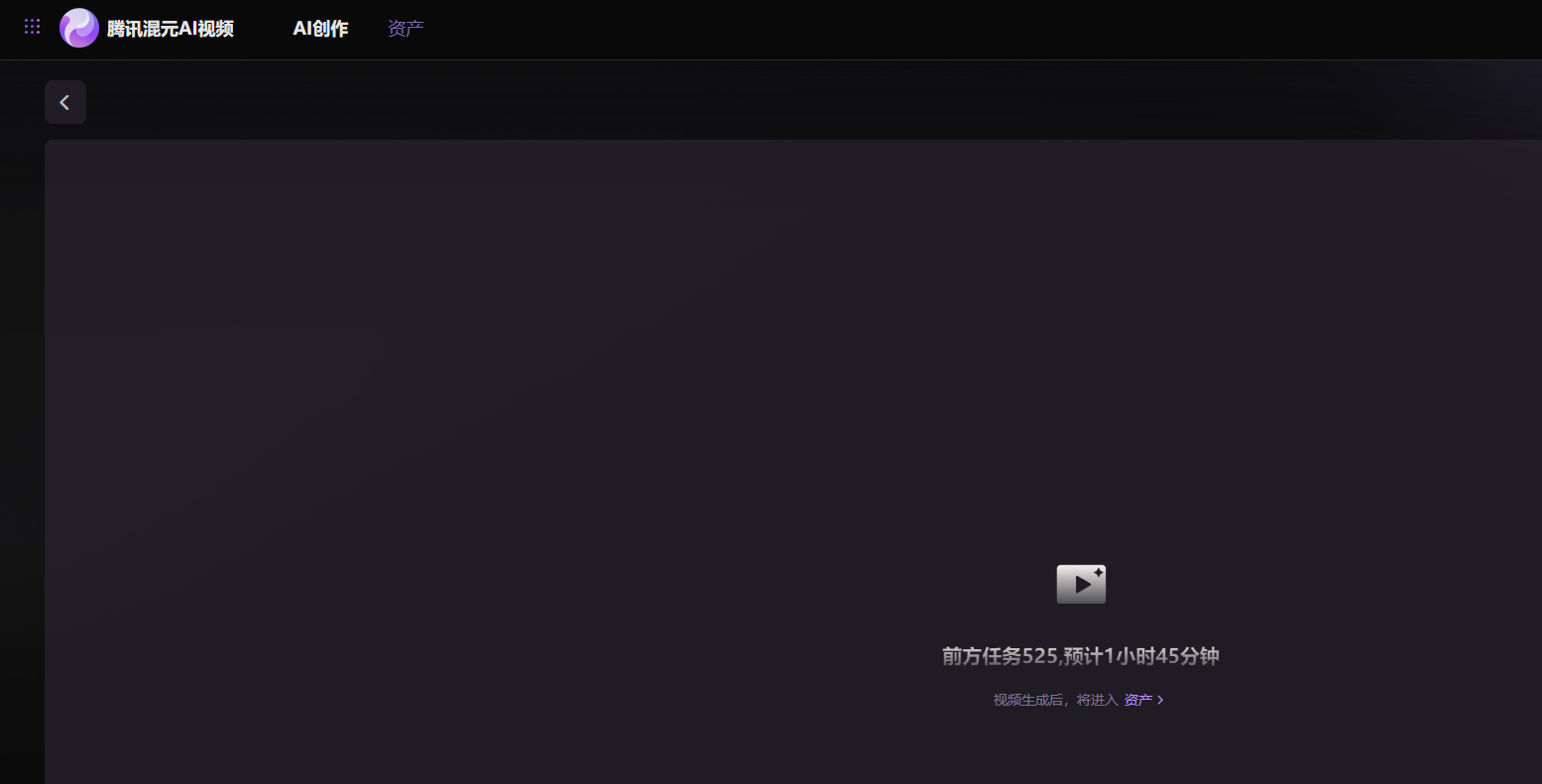

在觀察者網體驗中,發現混元圖生視頻模型的人氣火爆,實測中圖生視頻功能的任務已經“排起長隊”,需要等待接近兩個小時才能進行使用。

混元圖生視頻功能排起長隊 混元官網

具體的實際操作中,可以通過上傳高達的靜態圖片,讓高達跳起“魔性”的舞步。

也可以通過上傳一輛汽車的圖片,看到汽車高速行駛起來的視頻。

混元開源技術報告顯示,混元視頻生成模型具備靈活的擴展性,圖生視頻和文生視頻在相同的數據集上開展預訓練工作。在保持超寫實畫質、流暢演繹大幅度動作、原生鏡頭切換等特性的基礎上,讓模型能夠捕捉到豐富的視覺和語義信息,並結合圖像、文本、音頻和姿態等多種輸入條件,實現對生成視頻的多維度控制。

混元視頻生成模型開源以來,一直保持較高的熱度,去年12月登頂huggingface(知名AI社區)全站趨榜第一,目前Github(知名程序平台)平台上Star數超過8.9K。多位開發者自發製作基於社區Hunyuanvideo的插件與衍生模型,積累超過900個衍生版本。更早開源的混元DiT文生圖模型,在國內外衍生模型數量多達1600多個。

目前,混元開源系列模型已經完整覆蓋文本、圖像、視頻和3D生成等多個模態,在Github累計獲得超2.3萬開發者關注和star。

本文系觀察者網獨家稿件,未經授權,不得轉載。