具身智能訓練利器!谷歌斯坦福論文感謝了一家杭州六小龍

张睿佳

(文/張睿佳 編輯/張廣凱)

2025年3月6日,在谷歌DeepMind與斯坦福聯合發表的一篇論文中,讓AI學會像人類一樣佈置房間:沙發不懸空、枱燈必放桌面、書架與牆保持合理間距。而在論文的背後,團隊專門感謝了羣核科技SpatialVerse團隊提供的物理級真實3D場景數據。

羣核科技正是前段時間出圈的“杭州六小龍”之一,其業務聚焦空間智能探索,而論文中提到的SpatialVerse是羣核面向具身智能等行業開放的虛擬數字道場。

上述論文主要構建了一個名為FirePlace的框架,旨在讓多模態大語言模型更好地理解3D空間中的幾何關係。通過這個框架,大語言模型能夠更好地將對象放置在具有複雜幾何形狀的複雜場景中。

論文指出,現有的3D圖形基礎模型往往使用邊界框表示每個對象,因此無法表達對象各部分之間的細粒度約束,導致約束只能解釋盒狀對象的位置(而不是將書籍放在書架上,或將毛絨玩具放在帶有靠背和扶手的椅子上)。

FirePlace不僅希望克服上面的問題,還希望讓AI能夠選擇最符合美學、功能和常識性的對象放置方式。

顯然,想要實現這個目的,首先要有足夠的真實3D場景數據供AI學習。但是3D空間數據的成本比語言數據要高得多,數據來源成為困擾空間理解大模型和具身智能發展的最大難題之一。

而羣核科技擁有着國內用户量最大的室內裝修設計工具酷家樂,無疑在數據層面擁有天然優勢。

酷家樂能夠擁有如今的市場份額,背後是對計算機渲染能力的深耕。通過對GPU並行算力的充分開發,酷家樂渲染出圖的成本大幅降低,速度大幅提升,因此受到設計師的廣泛歡迎。

面向大模型的爆發,羣核科技也順勢推出了“羣核空間智能平台 SpatialVerse”,通過精準模擬真實世界的多樣化場景,彙集了海量的3D模型與場景數據資源,為 AIGC、具身智能、AR/VR 等前沿科技領域提供了強大且高效的空間數據支撐與定製化服務。

SpatialVerse可以基於3D場景的數據生成更多的物理真實場景,並在這些虛擬的場景中,訓練機器人避障、抓取、緊急制動,可以有效地提升訓練成本和效率。

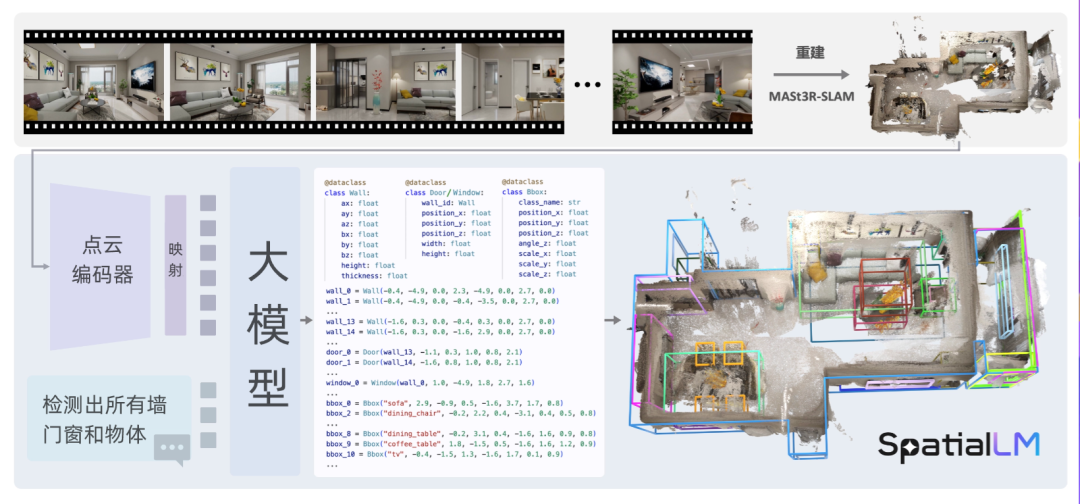

除了SpatialVerse,在GTC 2025大會上,羣核科技開源了他們的最新模型SpatialLM。

目前,SpatialLM已在HuggingFace、GitHub、魔搭社區等平台面向全球開發者開源。

SpatialLM是一個空間理解模型,僅憑一部手機拍攝的視頻,即可生成帶物理規則的的3D場景佈局。

例如,在整理房間這個命題中:利用傳統的2D視頻數據標註,機器人無法自動匹配物體的名字與具體的位置、大小、移動方向。如果使用專業的的激光雷達掃描形成3D點雲,又會帶來高昂的成本和較長的製作週期。SpatialLM的出現,有效地克服了這兩個問題。

當SpatialLM幫助機器人跨過“空間理解”後,SpatialVerse這個“數字道場”,讓機器人實現在海量仿真環境中完成技能學習。將SpatialLM和SpatialVerse組合起來使用,能夠推動具身智能訓練完成從認知到行動的鏈路閉環。

同時,羣核的這套方案將空間智能訓練徹底平民化,只要有手機和電腦,任何開發者都能接入這套系統,為機器人創建物理正確的訓練環境,有利於推動具身智能實現降本增效。

本文系觀察者網獨家稿件,未經授權,不得轉載。